Oracle库采用的是ascii编码,也就是英文字符集库。java通过jdbc查询出来如何转码?

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Oracle库采用的是ascii编码,也就是英文字符集库。java通过jdbc查询出来如何转码?相关的知识,希望对你有一定的参考价值。

new String(str.getBytes("ISO-8859-1"), "GBK")此方法已试过,转码失败。。。

参考技术AASCII 码不支持多字节的字符嘛,保存的过程可能已经失真了而无法还原。

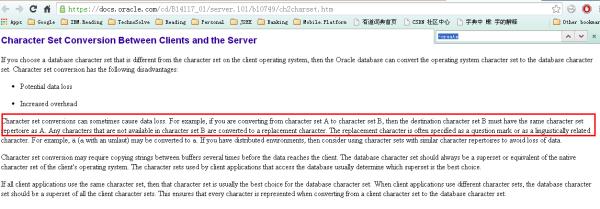

Oracle 文档上是说它会自动转换字符,但:

有额外时间开销,可能有些数据丢失。

数据丢失的情况出现在:当原来的 GBK 中文 Windows 中的字符(一个汉字)在 US7ASCII 字符集中不存在时会被替换成一个点位符(一般是问号或与目标语言相关的字符),也就是我们说的乱码。

从这句话看,Oracle 在保存我们的数据时就已经错了,再去读取时是无法还原的。

因此为了让我们的数据正常地保存和还原,需要自己来编码数据。

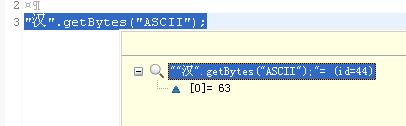

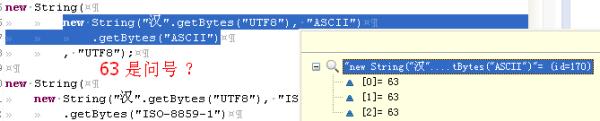

直接用 "汉".getBytes("ASCII") 只拿到了一个字节,很明显,这是错误的结果 63 是指问号?这个测试是说如果我们给一个”汉“字,Oracle 当成 ASCII 去解码的话它把一个问号保存在数据库中。

使用 ASCII 7bit 当中间缓存字符集,我们无法保存汉字编码的 8bit 数据,最终显示成问号,这步已经失真了。这里面我们要想到我们的 GB2312 或 UTF8 这样的字符集本身都是假设一个字节的最高位 (8bit 中的第1个 bit)是有特殊意义的,当我们用 US7ASCII 是它忽略掉这个位只处理后面7-bit 的。

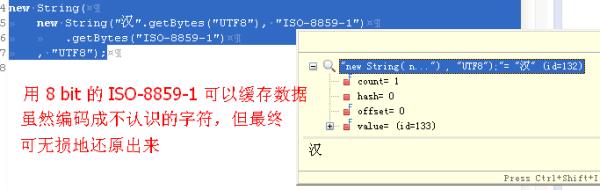

再试下用 ISO-8859-1 8-bit 做中间缓存字符集,我们看到它能保证数据依然是8bit 未失真,我们能准确地还原出来。

从上面的测试看出来,如果数据库是 ISO-8859-1 这种 8 bit 字符集的话,它是能通过代码:

stmt.setString(1, new String(name.getBytes(), "ISO-8859-1"));来保存,最后在读取的时候:

来还原的。但是很不幸的是 US7ASCII 字符集是没办法无损地保存汉字的,因此我们需要自己来编码那些像名字地址这样的有中文的数据,这里假设我们是用 GB2312 这种双字节的 16-bit,换成 US7-ASCII(每字节只有7-bit 有意义),需要3个字节,如果是 GBK 的话,你需要把它改一改,如果你想让程序保存所有出现在 Unicode 中的字符的话,那就用5字节 (int 32位的,32 = 7bit * 5 把一个 int 表示的 Unicode code point 整数保存下来就好了,保证它能处理全地球上所有已经编码成 unicode 的字符:

String us7ascii = null;

int codePoint = name.codePointAt(0);

int decoded = 0;

PreparedStatement stmt = null;

byte[] encoded = new byte[3];

encoded[2] = (byte) (codePoint & 0x7F);

encoded[1] = (byte) ((codePoint >> 7) & 0x7F);

encoded[0] = (byte) ((codePoint >> 14) & 0x7F);

us7ascii = new String(encoded);

stmt.setString(1, us7ascii);

ResultSet rs = null;

// for single byte, us7ascii is same as utf8, encoding is optional

byte[] encoded = rs.getString(1).getBytes("US-ASCII");

decoded |= encoded[0] << 14;

decoded |= encoded[1] << 7;

decoded |= encoded[2];

String read = new String(new int[] decoded , 0, 1);

System.out.println("汉字:" + name + " => code point(" + codePoint + ") => US7-ASCII (" + us7ascii + ") => "

+ read);

输出如下,注意,在数据库它已经不是原来的样子,像是加密一样,所以我们直接用 SQL 查看数据库时是不正确的:

你可以考虑把你的列改成 nvarchar2 试下,看它是否正常。

这样做看起来很奇怪对吧,不如我们直接把包括汉字的列当成 blob 算之类的二进制类型来保存算了,这样反正更简单,只是这些办法都没办法再通过 SQL 客户端来查数据确认你的程序正确,只能通过程序来编解码。

追问AMERICAN_AMERICA.US7ASCII这个是我所用库的编码

追答看上去 7-bit 的字符集没办法保存 8-bit 的字符集中的字符。汉字在 GB2312 和 UTF8 这种字符集中都是把每个字节的最高位设定为特殊用途来识别“哪几个字节凑在一起是一个汉字”。但 US7ASCII 这个 7-bit 的字符集的处理方法就是“只知道有后面7-bit 是有意义的” 而忽略掉那个最高位,因此无法准确的还原汉字,只有字母数字和常见英文标点符号才能正常地处理。

追问意思是没办法咯。

追答我的理解是 US7ASCII 不能用来正确地保存汉字,我们至少要求8bit 的 ISO-8859-1 (Latin - 1) 这种字符集(虽然它也是单字节的字符集,但它能完整地保持所有8个bit位上的信息而不丢失让事后可以无损地还原出来)。

在 US7ASCII 中只有字母数字和常见英文标点符号才能正常地处理。比如 ASCII 中才有的字符的最高位都是0,但当有汉字和字母混合在一起时,每个汉字对应的多个字节的高位都是1 而不是0这就让程序知道以0开头的是单字节的字母和标点数字,而以1开头的是汉字。当 ASCII 7-bit 在处理时会忽略掉这个规则,它在假设所有的都是以0开头的。

在前面你看到

new String(new String("汉".getBytes(), "US-ASCII").getBytes("US-ASCII"))得到的是全是63 (63代表问号);而当我们换成:

new String(new String("汉".getBytes(), "ISO-8859-1").getBytes("ISO-8859-1"))就正常了。

因为字符集编码规则都是一样,用 C++ 还是用 Java 结果是一样的。尝试换 OCI 驱动试试它是 native 的,但理论上说按 ANSI 8-bit ASCII 就正常的,或许这是客户端能看到汉字的原因。

另外,如果你的数据库原来本身是 US7ASCII 应该是可以无损地转换成 ISO-8859-1 的,因为这个转换是不丢失精度的,不会导致数据转换出错,因为你原来的数据只有7bit 的字符嘛,根本就没有那种 ASCII 码介于 128 到 255 之间的字符。就好像把一个 byte 能转换成 int 但反过来不成立一样的道理。或许考虑让数据库管理员把已经存在的数据库字符集转换成 ISO-8859-1,这不会导致数据库磁盘使用量增加(都是单字节的,而且是无损地转换)。

管理员可以考虑把一个数据库从 US7ASCII 导出再导入到另一个 Latin 1 的实例中:

http://itknowledgeexchange.techtarget.com/itanswers/changing-characterset-in-an-existing-oracle-instance/

本回答被提问者采纳 参考技术B 具体跟我说说怎么回事儿,你的业务流,用request 设定字符集啊,如果是 写成josn 文件,就用response 设定字符集追问AMERICAN_AMERICA.US7ASCII数据库字符集,plsql直接查询库中,是正常的汉字,通过javajdbc查询出来就是乱码的。

追答你用的是Orcale 么,那就不用考虑字符集的问题啊,你把sql 在数据库里 试试,JDBC 不涉及字符集啊,你从 DAO 到Service 到action 逐层排查

字符编码的前世今生

<字符编码变化的背景>

➤ASCII码

众所周知字符串也是一种数据类型,但是,字符串比较特殊的是还有一个编码问题。因为计算机只能处理数字,如果要处理文本,就必须先把文本转换为数字才能处理。最早的计算机在设计时采用8个比特(bit)作为一个字节(byte),所以,一个字节能表示的最大的整数就是255(二进制11111111=十进制255),如果要表示更大的数,就必须用更多的字节。比如两个字节可以表示的最大整数是65535,4个字节可以表示的最大整数是4294967295。

由于计算机是美国人发明的,因此,最早只有127个字符被编码到计算机里,也就是大小写英文字母、数字和一些符号,这个编码表被称为ASCII编码,比如大写字母A的编码是65,小写字母z的编码是122。但是要处理中文显然一个字节是不够的,至少需要两个字节,而且还不能和ASCII编码冲突,所以,中国制定了GB2312编码,用来把中文编进去。你可以想得到的是,全世界有上百种语言,日本把日文编到Shift_JIS里,韩国把韩文编到Euc-kr里,各国有各国的标准,就会不可避免地出现冲突,结果就是,在多语言混合的文本中,显示出来会有乱码。

➤Unicode

因此,Unicode应运而生。Unicode把所有语言都统一到一套编码里,这样就不会再有乱码问题了。Unicode标准也在不断发展,但最常用的是用两个字节表示一个字符(如果要用到非常偏僻的字符,就需要4个字节)。现代操作系统和大多数编程语言都直接支持Unicode。现在,捋一捋ASCII编码和Unicode编码的区别:ASCII编码是1个字节,而Unicode编码通常是2个字节。字母A用ASCII编码是十进制的65,二进制的01000001;字符0用ASCII编码是十进制的48,二进制的00110000,注意字符\'0\'和整数0是不同的;汉字中已经超出了ASCII编码的范围,用Unicode编码是十进制的20013,二进制的01001110 00101101。你可以猜测,如果把ASCII编码的A用Unicode编码,只需要在前面补0就可以,因此,A的Unicode编码是00000000 01000001。

➤UTF-8

新的问题又出现了:如果统一成Unicode编码,乱码问题从此消失了。但是,如果你写的文本基本上全部是英文的话,用Unicode编码比ASCII编码需要多一倍的存储空间,在存储和传输上就十分不划算。所以,本着节约的精神,又出现了把Unicode编码转化为“可变长编码”的UTF-8编码。UTF-8编码把一个Unicode字符根据不同的数字大小编码成1-6个字节,常用的英文字母被编码成1个字节,汉字通常是3个字节,只有很生僻的字符才会被编码成4-6个字节。如果你要传输的文本包含大量英文字符,用UTF-8编码就能节省空间:

| 字符 | ASCII | Unicode | UTF-8 |

|---|---|---|---|

| A | 01000001 | 00000000 01000001 | 01000001 |

| 中 | x | 01001110 00101101 | 11100100 10111000 10101101 |

从上面的表格还可以发现,UTF-8编码有一个额外的好处,就是ASCII编码实际上可以被看成是UTF-8编码的一部分,所以,大量只支持ASCII编码的历史遗留软件可以在UTF-8编码下继续工作。

➤计算机系统通用字符编码方式

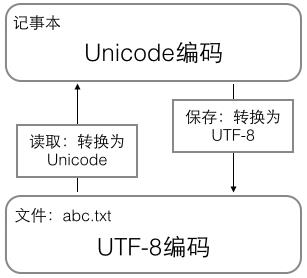

搞清楚了ASCII、Unicode和UTF-8的关系,我们就可以总结一下现在计算机系统通用的字符编码工作方式:在计算机内存中,统一使用Unicode编码,当需要保存到硬盘或者需要传输的时候,就转换为UTF-8编码。用记事本编辑的时候,从文件读取的UTF-8字符被转换为Unicode字符到内存里,编辑完成后,保存的时候再把Unicode转换为UTF-8保存到文件:

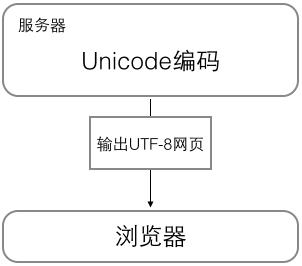

浏览网页的时候,服务器会把动态生成的Unicode内容转换为UTF-8再传输到浏览器:

所以看到很多网页的源码上会有类似<meta charset="UTF-8" />的信息,表示该网页正是用的UTF-8编码。

<Python的字符串>

搞清楚了令人头疼的字符编码问题后,我们再来研究Python的字符串。在最新的Python 3版本中,字符串是以Unicode编码的,也就是说,Python的字符串支持多语言,例如:

>>> print(\'包含中文的str\')

包含中文的str对于单个字符的编码,Python提供了ord()函数获取字符的整数表示,chr()函数把编码转换为对应的字符:

>>> ord(\'A\')

65

>>> ord(\'中\')

20013

>>> chr(66)

\'B\'

>>> chr(25991)

\'文\'如果知道字符的整数编码,还可以用十六进制这么写str:

>>> \'\\u4e2d\\u6587\'

\'中文\'两种写法完全是等价的。

由于Python的字符串类型是str,在内存中以Unicode表示,一个字符对应若干个字节。如果要在网络上传输,或者保存到磁盘上,就需要把str变为以字节为单位的bytes。Python对bytes类型的数据用带b前缀的单引号或双引号表示:

x = b\'ABC\'要注意区分\'ABC\'和b\'ABC\',前者是str,后者虽然内容显示得和前者一样,但bytes的每个字符都只占用一个字节。以Unicode表示的str通过encode()方法可以编码为指定的bytes,例如:

>>> \'ABC\'.encode(\'ascii\')

b\'ABC\'

>>> \'中文\'.encode(\'utf-8\')

b\'\\xe4\\xb8\\xad\\xe6\\x96\\x87\'

>>> \'中文\'.encode(\'ascii\')

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

UnicodeEncodeError: \'ascii\' codec can\'t encode characters in position 0-1: ordinal not in range(128)纯英文的str可以用ASCII编码为bytes,内容是一样的,含有中文的str可以用UTF-8编码为bytes。含有中文的str无法用ASCII编码,因为中文编码的范围超过了ASCII编码的范围,Python会报错。在bytes中,无法显示为ASCII字符的字节,用\\x##显示。反过来,如果我们从网络或磁盘上读取了字节流,那么读到的数据就是bytes。要把bytes变为str,就需要用decode()方法:

>>> b\'ABC\'.decode(\'ascii\')

\'ABC\'

>>> b\'\\xe4\\xb8\\xad\\xe6\\x96\\x87\'.decode(\'utf-8\')

\'中文\'要计算str包含多少个字符,可以用len()函数:

>>> len(\'ABC\')

3

>>> len(\'中文\')

2len()函数计算的是str的字符数,如果换成bytes,len()函数就计算字节数:

>>> len(b\'ABC\')

3

>>> len(b\'\\xe4\\xb8\\xad\\xe6\\x96\\x87\')

6

>>> len(\'中文\'.encode(\'utf-8\'))

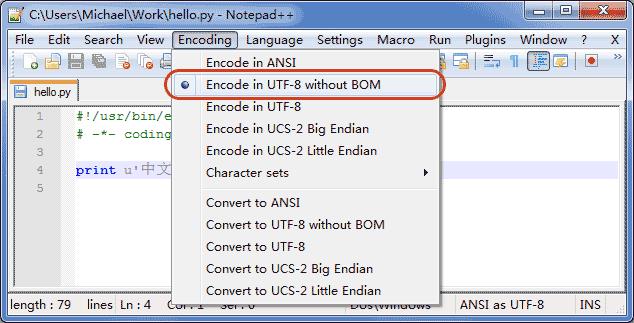

6可见,1个中文字符经过UTF-8编码后通常会占用3个字节,而1个英文字符只占用1个字节。在操作字符串时,我们经常遇到str和bytes的互相转换。为了避免乱码问题,应当始终坚持使用UTF-8编码对str和bytes进行转换。由于Python源代码也是一个文本文件,所以,当你的源代码中包含中文的时候,在保存源代码时,就需要务必指定保存为UTF-8编码。当Python解释器读取源代码时,为了让它按UTF-8编码读取,我们通常在文件开头写上这两行:

#!/usr/bin/env python3

# -*- coding: utf-8 -*-第一行注释是为了告诉Linux/OS X系统,这是一个Python可执行程序,Windows系统会忽略这个注释;第二行注释是为了告诉Python解释器,按照UTF-8编码读取源代码,否则,你在源代码中写的中文输出可能会有乱码。申明了UTF-8编码并不意味着你的.py文件就是UTF-8编码的,必须并且要确保文本编辑器正在使用UTF-8 without BOM编码:

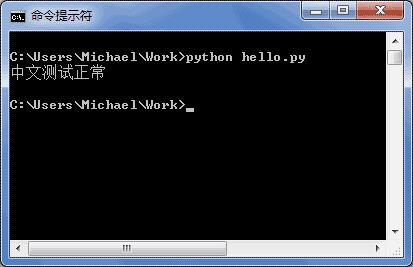

如果.py文件本身使用UTF-8编码,并且也申明了# -*- coding: utf-8 -*-,打开命令提示符测试就可以正常显示中文:

<格式化>

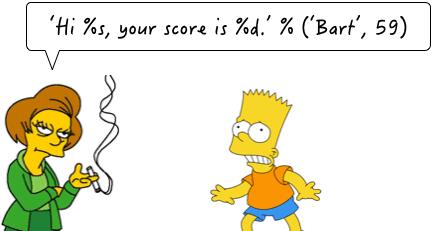

最后一个常见的问题是如何输出格式化的字符串。我们经常会输出类似\'亲爱的xxx你好!你xx月的话费是xx,余额是xx\'之类的字符串,而xxx的内容都是根据变量变化的,所以,需要一种简便的格式化字符串的方式。

在Python中,采用的格式化方式和C语言是一致的,用%实现,举例如下:

>>> \'Hello, %s\' % \'world\'

\'Hello, world\'

>>> \'Hi, %s, you have $%d.\' % (\'Michael\', 1000000)

\'Hi, Michael, you have $1000000.\'你可能猜到了,%运算符就是用来格式化字符串的。在字符串内部,%s表示用字符串替换,%d表示用整数替换,有几个%?占位符,后面就跟几个变量或者值,顺序要对应好。如果只有一个%?,括号可以省略。常见的占位符有:

| %d | 整数 |

| %f | 浮点数 |

| %s | 字符串 |

| %x | 十六进制整数 |

其中,格式化整数和浮点数还可以指定是否补0和整数与小数的位数:

>>> \'%2d-%02d\' % (3, 1)

\' 3-01\'

>>> \'%.2f\' % 3.1415926

\'3.14\'如果你不太确定应该用什么,%s永远起作用,它会把任何数据类型转换为字符串:

>>> \'Age: %s. Gender: %s\' % (25, True)

\'Age: 25. Gender: True\'有些时候,字符串里面的%是一个普通字符怎么办?这个时候就需要转义,用%%来表示一个%:

>>> \'growth rate: %d %%\' % 7

\'growth rate: 7 %\'<小结>

Python 3的字符串使用Unicode,直接支持多语言。str和bytes互相转换时,需要指定编码。最常用的编码是UTF-8。Python当然也支持其他编码方式,比如把Unicode编码成GB2312:

>>> \'中文\'.encode(\'gb2312\')

b\'\\xd6\\xd0\\xce\\xc4\'但这种方式纯属自找麻烦,如果没有特殊业务要求,请牢记仅使用UTF-8编码。格式化字符串的时候,可以用Python的交互式命令行测试,方便快捷。

<wiz_tmp_tag id="wiz-table-range-border" contenteditable="false" style="display: none;">

以上是关于Oracle库采用的是ascii编码,也就是英文字符集库。java通过jdbc查询出来如何转码?的主要内容,如果未能解决你的问题,请参考以下文章