Spark学习win10部署Hadoop+Spark

Posted 西伯尔

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark学习win10部署Hadoop+Spark相关的知识,希望对你有一定的参考价值。

1.Hadoop

(1)安装配置

基础只需要配置core-site.xml和hdfs-site.xml就行。

参考:

https://www.jianshu.com/p/aa8cfaa26790【这个教程的core-site.xml和hdfs-site.xml的内容弄反了,交换一下就行】

http://dblab.xmu.edu.cn/blog/install-hadoop/【这是Linux的】

https://blog.csdn.net/Sylarjyd/article/details/91038732【这是包括yarn的配置】

(2)开启Hadoop

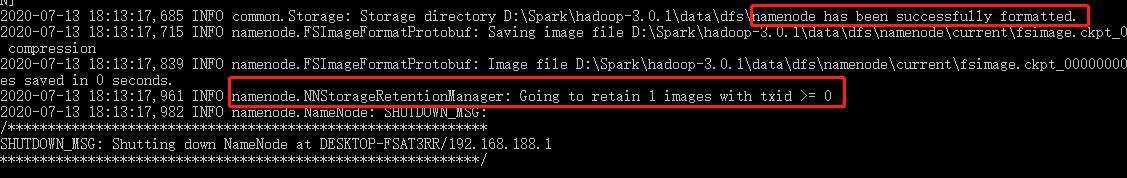

命令行:hadoop namenode -format

启动:进入sbin目录,双击start-dfs.cmd【仅启动dfs】或者start-all.cmd【启动所有,包括yarn】

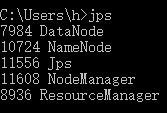

命令行:jps查看进程

(3)查看

通过http://127.0.0.1:8088/即可查看集群所有节点状态

访问http://localhost:9870/即可查看Hadoop文件管理页面。

2.Spark

(1)安装

https://blog.csdn.net/u011513853/article/details/52865076

查看:http://localhost:4040/jobs/

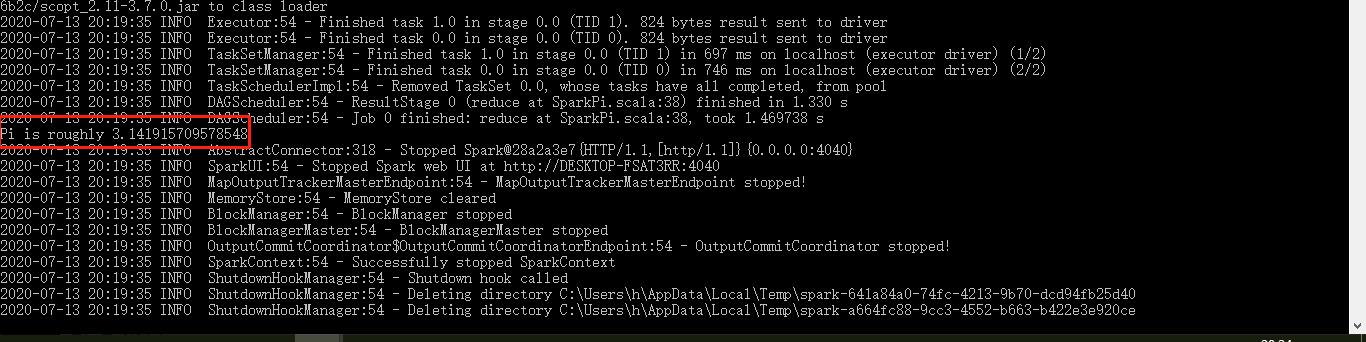

(2)运行Spark自带的例子:run-example SparkPi

(3)启动master和slave

我一个单机win10怎么弄另外一个master?!!!百度TMD两天,不如Google一下,我也是醉了!!我发誓,一定养成Google习惯,不是非要英语,而是搜索引擎不行!!

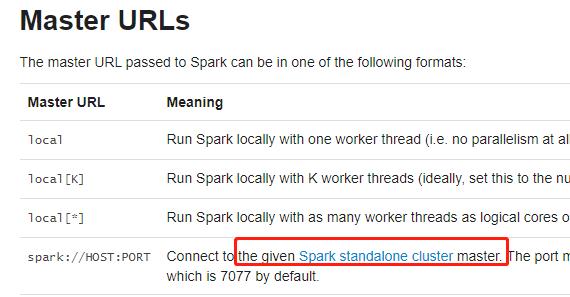

ps:spark提交作业,支持多种 cluster manage 类型:Standalone,Apache Mesos,Hadoop YARN ,Kubernetes,这里采用Standalone的伪分布式。

后来才发现,官方文档https://spark.apache.org/docs/1.6.0/submitting-applications.html也有一丢丢提示,却没给怎么设置!

原答案:http://damn.amsterdam/sparkonwindows/

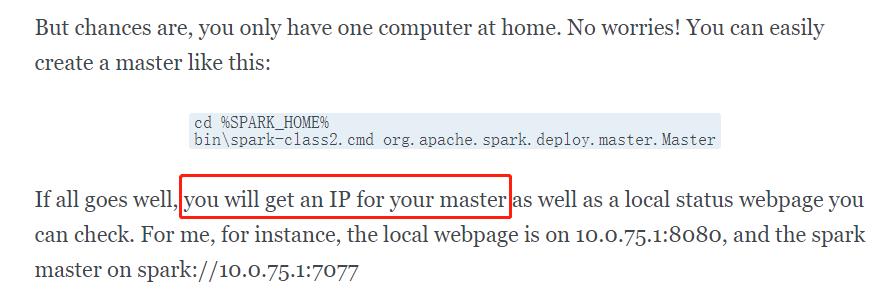

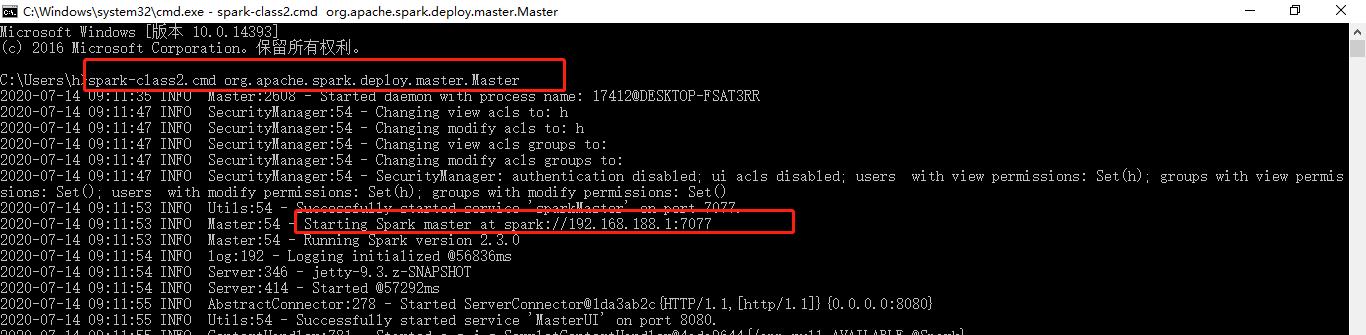

没有master,新开一个cmd窗口,造一个master,系统会给你分配一个master IP和端口

spark-class2.cmd org.apache.spark.deploy.master.Master

效果:

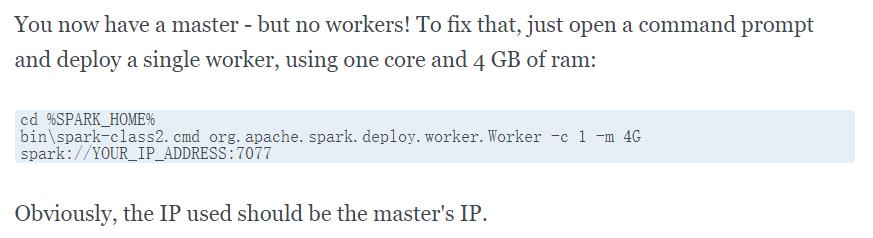

再开一个cmd窗口,造一个slave

spark-class2.cmd org.apache.spark.deploy.worker.Worker -c 1 -m 4G spark://192.168.188.1:7077

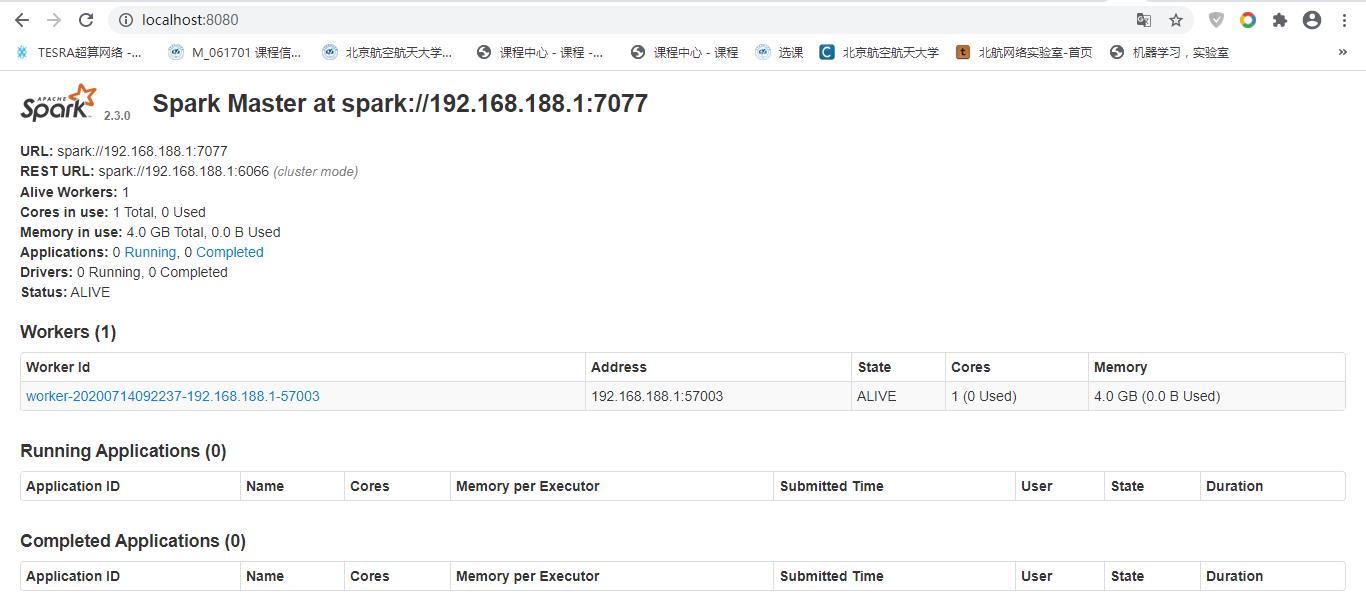

查看spark master的web ui:http://localhost:8080/

下一节:

Spark学习(三)Spark实验部分

以上是关于Spark学习win10部署Hadoop+Spark的主要内容,如果未能解决你的问题,请参考以下文章

Cloudera Developer之Spark 及 Hadoop 开发员培训(CCA-175)