matlab中PCA的人脸识别,最后得出的识别率是啥意思啊!

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了matlab中PCA的人脸识别,最后得出的识别率是啥意思啊!相关的知识,希望对你有一定的参考价值。

http://www.ilovematlab.cn/thread-235440-1-1.html

这个代码最后得出一个识别率。也没有得出识别为哪张图片了?那识别的意义在什么呢?

识别率指的是通过人脸识别技术识别正确数占识别总数的百分比。

人脸识别算法分类

基于人脸特征点的识别算法(Feature-based recognition algorithms)。

基于整幅人脸图像的识别算法(Appearance-based recognition algorithms)。

基于模板的识别算法(Template-based recognition algorithms)。

利用神经网络进行识别的算法(Recognition algorithms using neural network)。

神经网络识别

基于光照估计模型理论

提出了基于Gamma灰度矫正的光照预处理方法,并且在光照估计模型的基础上,进行相应的光照补偿和光照平衡策略。

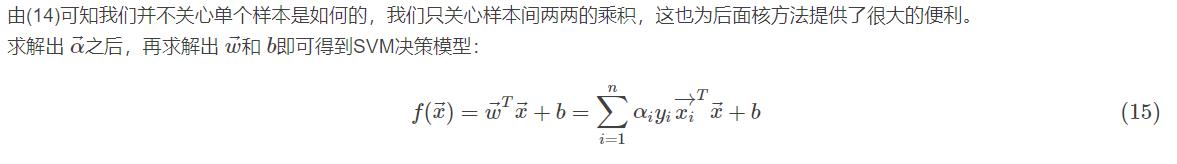

优化的形变统计校正理论

基于统计形变的校正理论,优化人脸姿态;

强化迭代理论

强化迭代理论是对DLFA人脸检测算法的有效扩展;

独创的实时特征识别理论

该理论侧重于人脸实时数据的中间值处理,从而可以在识别速率和识别效能之间,达到最佳的匹配效果

识别率就是 程序识别正确的样本数量/训练集的样本总数

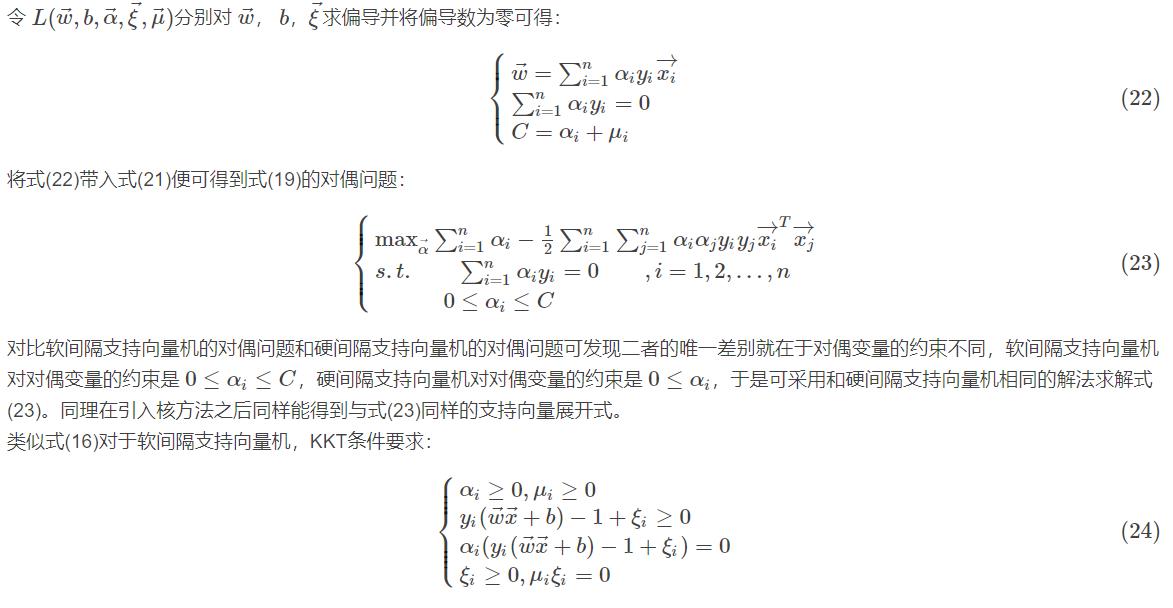

程序识别正确的样本数量包括 样本是非人脸实际检测也是费人脸和样本是人脸实际检测也是人脸两部分。

PCA人脸识别一般是做为人脸检测的第二部分,所采用的训练样本一般也都是归一好的同等尺寸的图像(如20*20,50*50,100*100等)。并不是说随便一张照片。

而对实际照片进行人脸检测的时候,一般采用一些办法(如肤色分割)从原始图像中切出部分侯选块作为下一步检测(如PCA)的数据。追问

如何做到判定分类的准确与否的呢?

追答你想问PCA是如何实现的还是什么?每太明白你像问什么

追问就是人脸识别的工作原理,及应用方向。

大哥,273042429交流一下呗。

% calc xmean,sigma and its eigen decomposition

allsamples=[];%所有训练图像

for i=1:40

for j=1:5

a=imread(strcat('D:\rawdata\ORL\s',num2str(i),'\',num2str(j),'.pgm'));

% imshow(a);

b=a(1:112*92); % b是行矢量 1×N,其中N=10304,提取顺序是先列后行,即从上到下,从左到右

b=double(b);

allsamples=[allsamples; b]; % allsamples 是一个M * N 矩阵,allsamples 中每一行数据代表一张图片,其中M=200

end

end

samplemean=mean(allsamples); % 平均图片,1 × N

for i=1:200 xmean(i,:)=allsamples(i,:)-samplemean; % xmean是一个M × N矩阵,xmean每一行保存的数据是“每个图片数据-平均图片”

end;

sigma=xmean*xmean'; % M * M 阶矩阵

[v d]=eig(sigma);

d1=diag(d);

[d2 index]=sort(d1); %以升序排序

cols=size(v,2);% 特征向量矩阵的列数

for i=1:cols

vsort(:,i) = v(:,index(cols-i+1) ); % vsort 是一个M*col(注:col一般等于M)阶矩阵,保存的是按降序排列的特征向量,每一列构成一个特征向量

dsort(i) = d1( index(cols-i+1) ); % dsort 保存的是按降序排列的特征值,是一维行向量

end %完成降序排列

%以下选择90%的能量

dsum = sum(dsort);

dsum_extract = 0;

p = 0;

while( dsum_extract/dsum < 0.9)

p = p + 1;

dsum_extract = sum(dsort(1:p));

end

i=1;

% (训练阶段)计算特征脸形成的坐标系

while (i0)

base(:,i) = dsort(i)^(-1/2) * xmean' * vsort(:,i); % base是N×p阶矩阵,除以dsort(i)^(1/2)是对人脸图像的标准化,详见《基于PCA的人脸识别算法研究》p31

i = i + 1;

end

% add by wolfsky 就是下面两行代码,将训练样本对坐标系上进行投影,得到一个 M*p 阶矩阵allcoor

allcoor = allsamples * base;

accu = 0;

%

for i=1:40

for j=6:10 %读入40 x 5 副测试图像

a=imread(strcat('D:\rawdata\ORL\s',num2str(i),'\',num2str(j),'.pgm'));

b=a(1:10304);

b=double(b);

tcoor= b * base; %计算坐标,是1×p阶矩阵

for k=1:200

mdist(k)=norm(tcoor-allcoor(k,:));

end;

%三阶近邻

[dist,index2]=sort(mdist);

class1=floor( index2(1)/5 )+1;

class2=floor(index2(2)/5)+1;

class3=floor(index2(3)/5)+1;

if class1~=class2 && class2~=class3

class=class1;

elseif class1==class2

class=class1;

elseif class2==class3

class=class2;

end;

if class==i

accu=accu+1;

end;

end;

end;

accuracy=accu/200 %输出识别率

函数调用是定义函数,然后用函数名进行调用就可以了

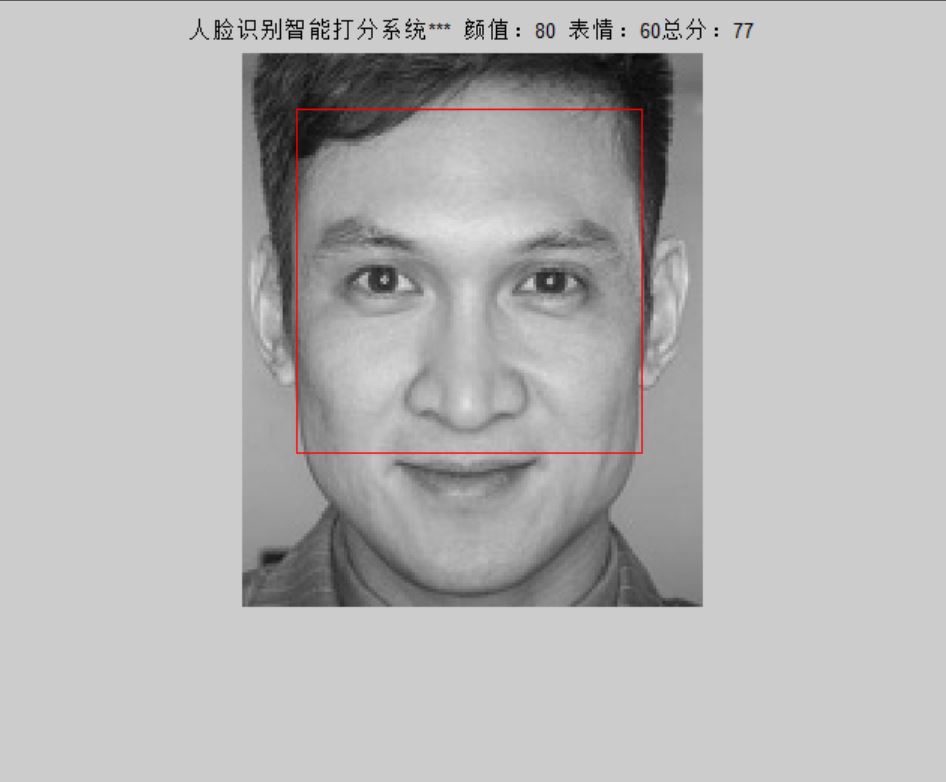

人脸表情识别基于matlab PCA+SVM人脸表情识别评分系统含Matlab源码 593期

一、简介

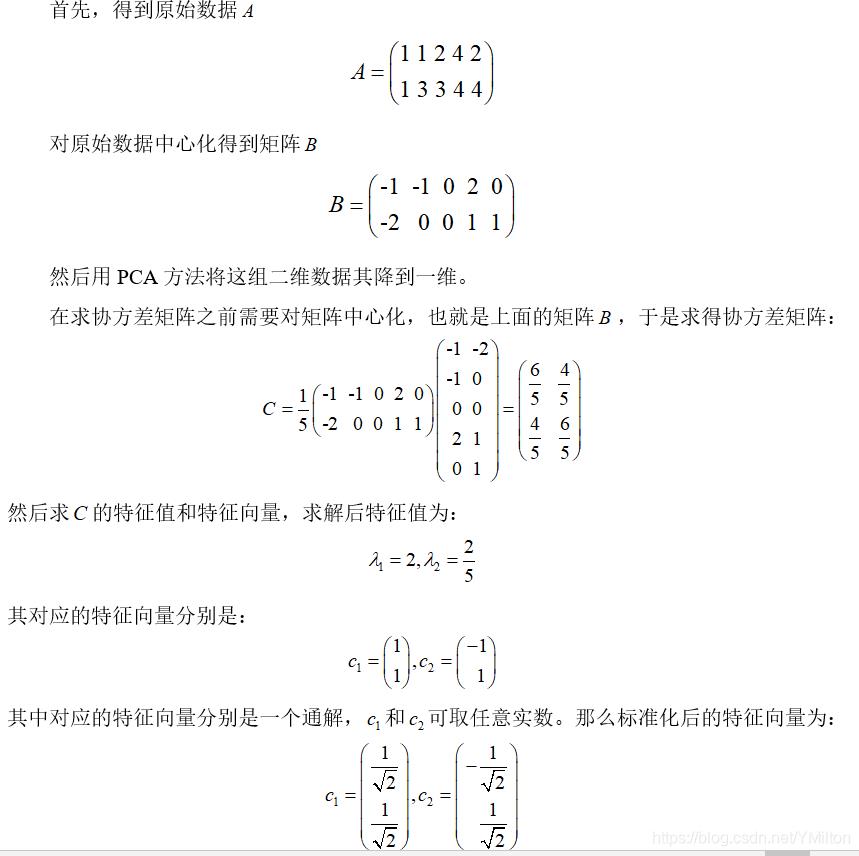

1 PCA

PCA(Principal Component Analysis)是常用的数据分析方法。PCA是通过线性变换,将原始数据变换为一组各维度线性无关的数据表示方法,可用于提取数据的主要特征分量,常用于高维数据的降维。

1.1 降维问题

数据挖掘和机器学习中,数据以向量表示。例如某个淘宝店2012年全年的流量及交易情况可以看成一组记录的集合,其中每一天的数据是一条记录,格式如下:

(日期, 浏览量, 访客数, 下单数, 成交数, 成交金额)

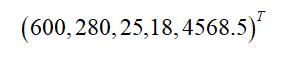

其中“日期”是一个记录标志而非度量值,而数据挖掘关心的大多是度量值,因此如果我们忽略日期这个字段后,我们得到一组记录,每条记录可以被表示为一个五维向量,其中一条样本如下所示:

一般习惯上使用列向量表示一条记录,本文后面也会遵循这个准则。

机器学习的很多算法复杂度和数据的维数有着密切关系,甚至与维数呈指数级关联。这里区区5维的数据,也许无所谓,但是实际机器学习中处理成千上万甚至几十万维的数据也并不罕见,在这种情况下,机器学习的资源消耗是不可接受的,因此就会对数据采取降维的操作。降维就意味着信息的丢失,不过鉴于实际数据本身常常存在相关性,所以在降维时想办法降低信息的损失。

例如上面淘宝店铺的数据,从经验可知,“浏览量”和“访客数”往往具有较强的相关性,而“下单数”和“成交数”也具有较强的相关性。可以直观理解为“当某一天这个店铺的浏览量较高(或较低)时,我们应该很大程度上认为这天的访客数也较高(或较低)”。因此,如果删除浏览量或访客数,最终并不会丢失太多信息,从而降低数据的维度,也就是所谓的降维操作。如果把数据降维用数学来分析讨论,用专业名词表示就是PCA,这是一种具有严格数学基础并且已被广泛采用的降维方法。

1.2 向量与基变换

1.2.1 内积与投影

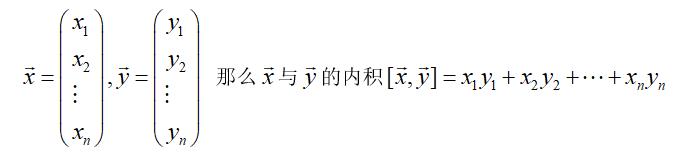

两个大小相同向量的内积被定义如下:

1.2.2 基

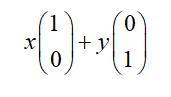

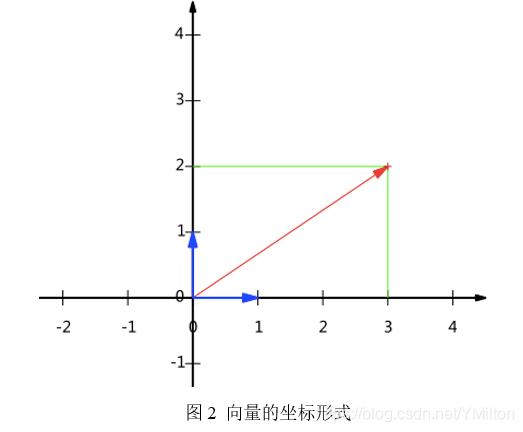

在代数中,经常用线段终点的点坐标表示向量。假设某个向量的坐标为(3,2),这里的3实际表示的是向量在x轴上的投影值是3,在y轴上的投影值是2。也就是说隐式引入了一个定义:以x轴和y轴上正方向长度为1的向量为标准。那么一个向量(3,2)实际是在x轴投影为3而y轴的投影为2。注意投影是一个矢量,可以为负。向量(x, y)实际上表示线性组合:

由上面的表示,可以得到所有二维向量都可以表示为这样的线性组合。此处(1,0)和(0,1)叫做二维空间中的一组基。

之所以默认选择(1,0)和(0,1)为基,当然是为了方便,因为它们分别是x和y轴正方向上的单位向量,因此就使得二维平面上点坐标和向量一一对应。但实际上任何两个线性无关的二维向量都可以成为一组基,所谓线性无关在二维平面内,从直观上就是两个不在一条直线的向量。

另外这里的基是正交的(即内积为0,或直观说相互垂直),可以成为一组基的唯一要求就是线性无关,非正交的基也是可以的。不过因为正交基有较好的性质,所以一般使用的基都是正交的。

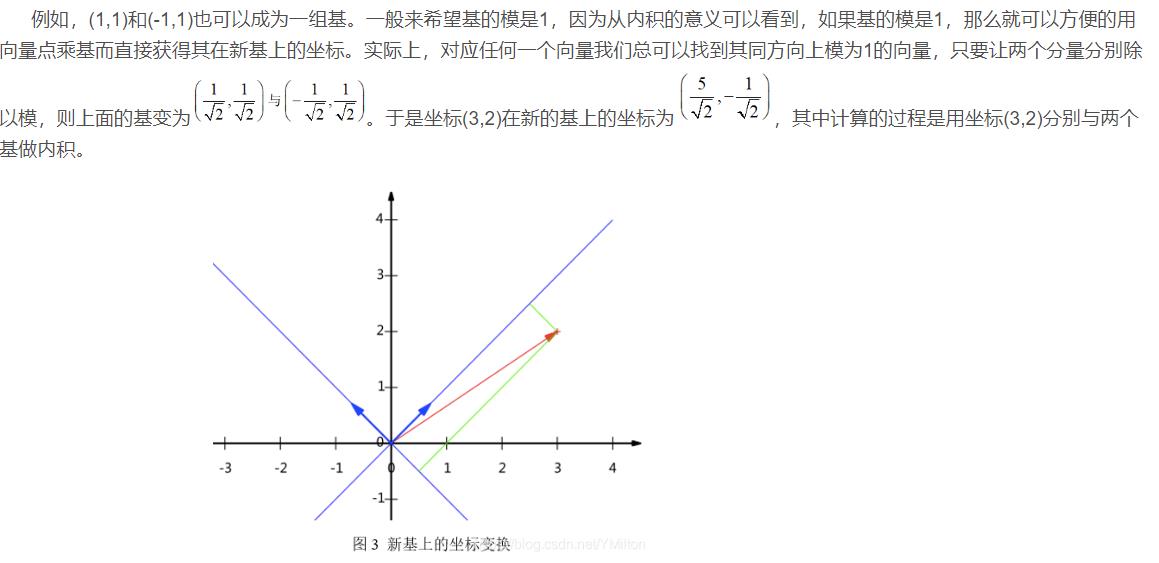

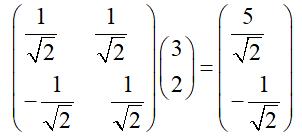

1.2.3 基变换的矩阵

上述例子中的基变换,可以采用矩阵的乘法来表示,即

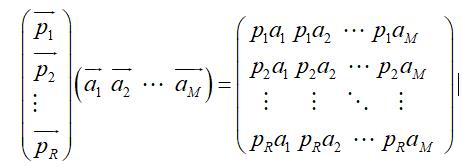

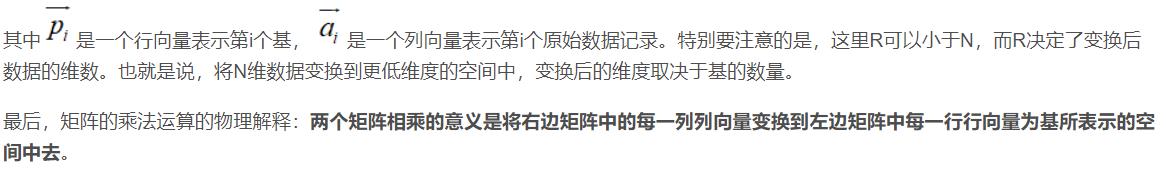

如果推广一下,假设有M个N维向量,想将其变换为由R个N维向量表示的新空间中,那么首先将R个基按行组成矩阵A,然后将向量按列组成矩阵B,那么两矩阵的乘积AB就是变换结果,其中AB的第m列为A中第m列变换后的结果,通过矩阵相乘表示为:

1.3 协方差矩阵及优化目标

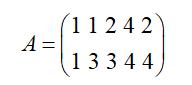

在进行数据降维的时候,关键的问题是如何判定选择的基是最优。也就是选择最优基是最大程度的保证原始数据的特征。这里假设有5条数据为

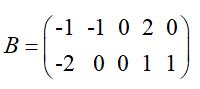

计算每一行的平均值,然后再让每一行减去得到的平均值,得到

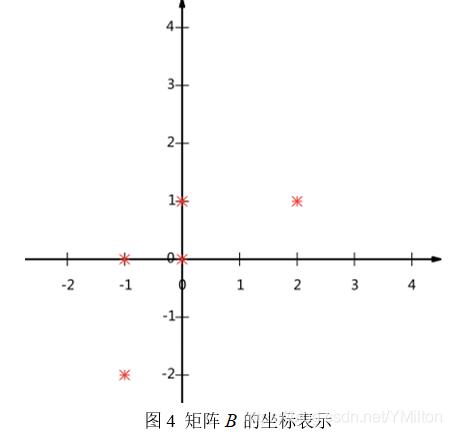

通过坐标的形式表现矩阵,得到的图如下:

那么现在的问题是:用一维向量来表示这些数据,又希望尽量保留原有的信息,该如何选择呢?这个问题实际上是要在二维平面中选择一个方向的向量,将所有数据点都投影到这条直线上,用投影的值表示原始记录,即二维降到一维的问题。那么如何选择这个方向(或者说基)才能尽量保留最多的原始信息呢?一种直观的看法是:希望投影后的投影值尽可能分散。

1.3.1 方差

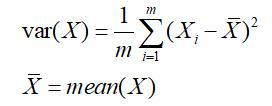

上述问题是希望投影后投影的值尽可能在一个方向上分散,而这种分散程度,可以采用数学上的方差来表述,即:

于是上面的问题被形式化表述为:寻找一个一维基,使得所有数据变换为这个基上的坐标后,方差值最大。

2.3.2 协方差

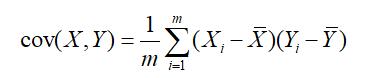

数学上可以用两个特征的协方差表示其相关性,即:

当协方差为0时,表示两个特征完全独立。为了让协方差为0,选择第二个基时只能在与第一个基正交的方向上选择。因此最终选择的两个方向一定是正交的。

至此获得降维问题的优化目标:将一组N维向量降为K维(K<N),其目标是选择K个单位(模为1)正交基,使得原始数据变换到这组基上后,各字段两两间协方差为0,而字段的方差则尽可能大(在正交的约束下,取最大的K个方差)。

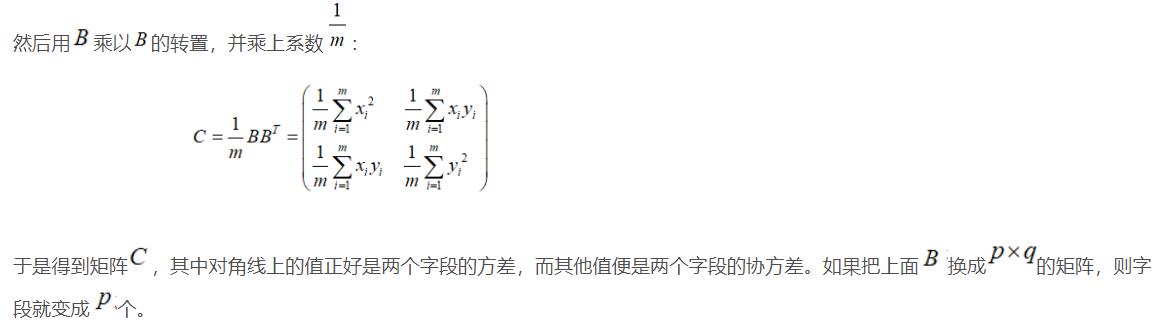

2.3.3 协方差矩阵

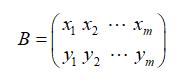

假设只有x和y两个字段,将它们按行组成矩阵,其中是通过中心化的矩阵,也就是每条字段减去每条字段的平均值得到的矩阵:

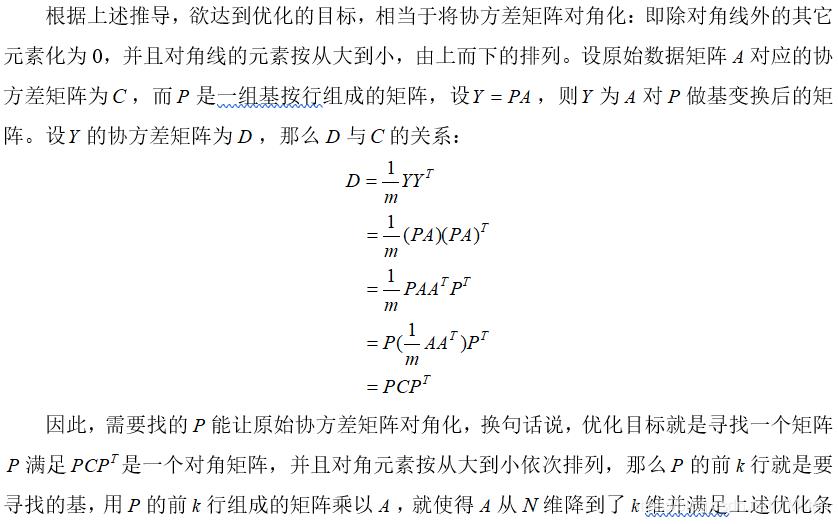

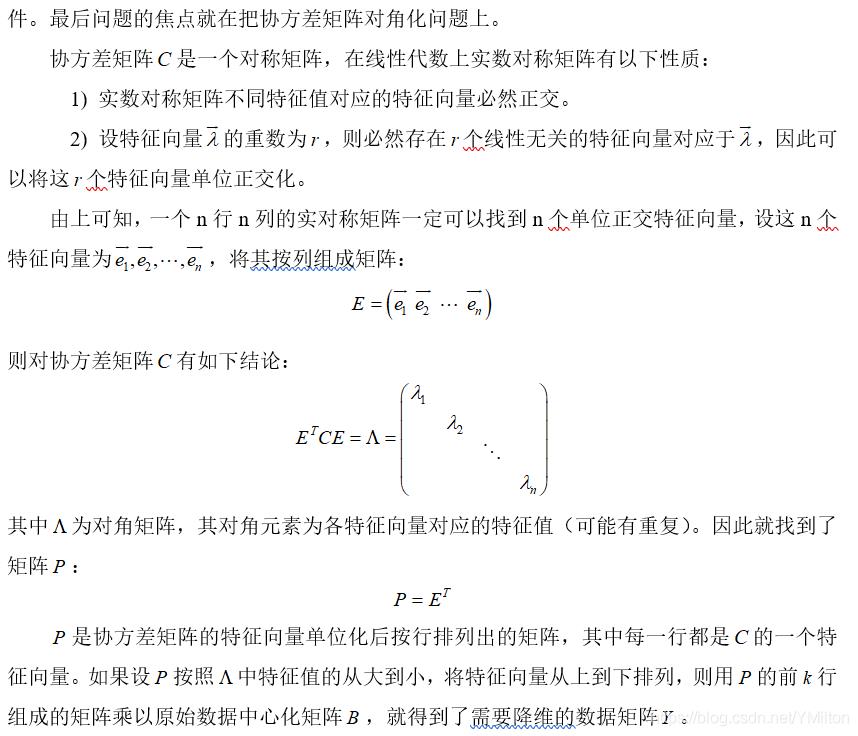

3.4 协方差矩阵对角化

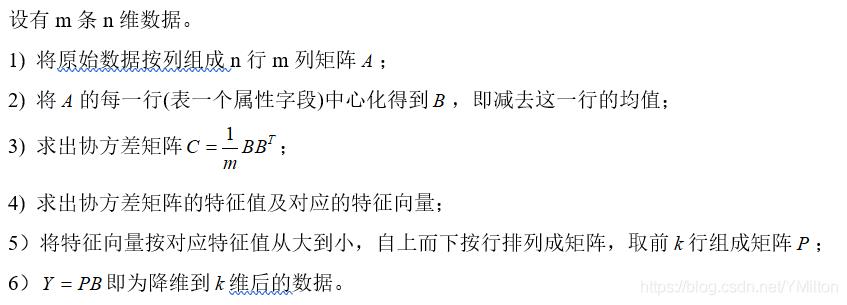

1.4 算法与实例

1.4.1 PCA算法

1.4.2 实例

1.5. 讨论

根据上面对PCA的数学原理的解释,可以了解到一些PCA的能力和限制。PCA本质上是将方差最大的方向作为主要特征,并且在各个正交方向上将数据“离相关”,也就是让它们在不同正交方向上没有相关性。

因此,PCA也存在一些限制,例如它可以很好的解除线性相关,但是对于高阶相关性就没有办法了,对于存在高阶相关性的数据,可以考虑Kernel PCA,通过Kernel函数将非线性相关转为线性相关。另外,PCA假设数据各主特征是分布在正交方向上,如果在非正交方向上存在几个方差较大的方向,PCA的效果就大打折扣了。

最后需要说明的是,PCA是一种无参数技术,也就是说面对同样的数据,如果不考虑清洗,谁来做结果都一样,没有主观参数的介入,所以PCA便于通用实现,但是本身无法个性化的优化。

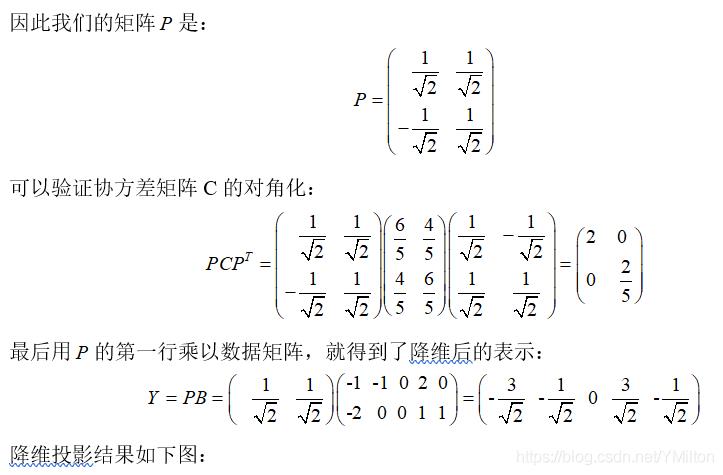

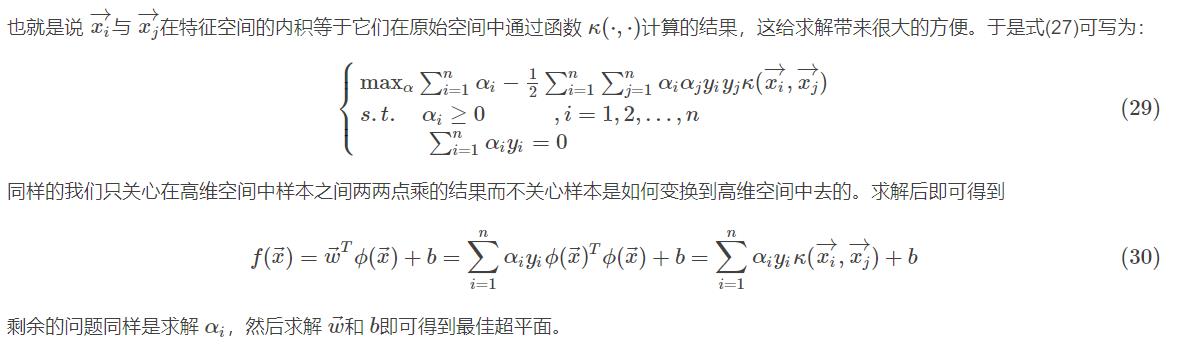

2 SVM基本概念

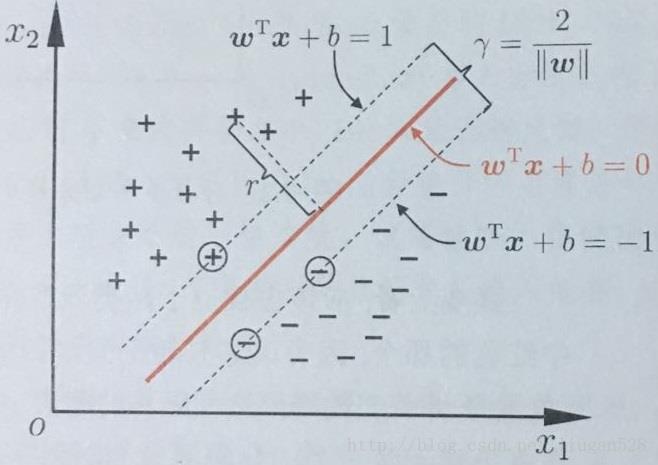

支持向量机(Support Vector Machine, SVM)的基本模型是在特征空间上找到最佳的分离超平面使得训练集上正负样本间隔最大。SVM是用来解决二分类问题的有监督学习算法,在引入了核方法之后SVM也可以用来解决非线性问题。

一般SVM有下面三种:

硬间隔支持向量机(线性可分支持向量机):当训练数据线性可分时,可通过硬间隔最大化学得一个线性可分支持向量机。

软间隔支持向量机:当训练数据近似线性可分时,可通过软间隔最大化学得一个线性支持向量机。

非线性支持向量机:当训练数据线性不可分时,可通过核方法以及软间隔最大化学得一个非线性支持向量机。

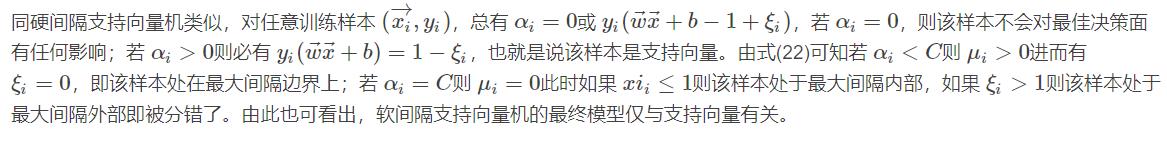

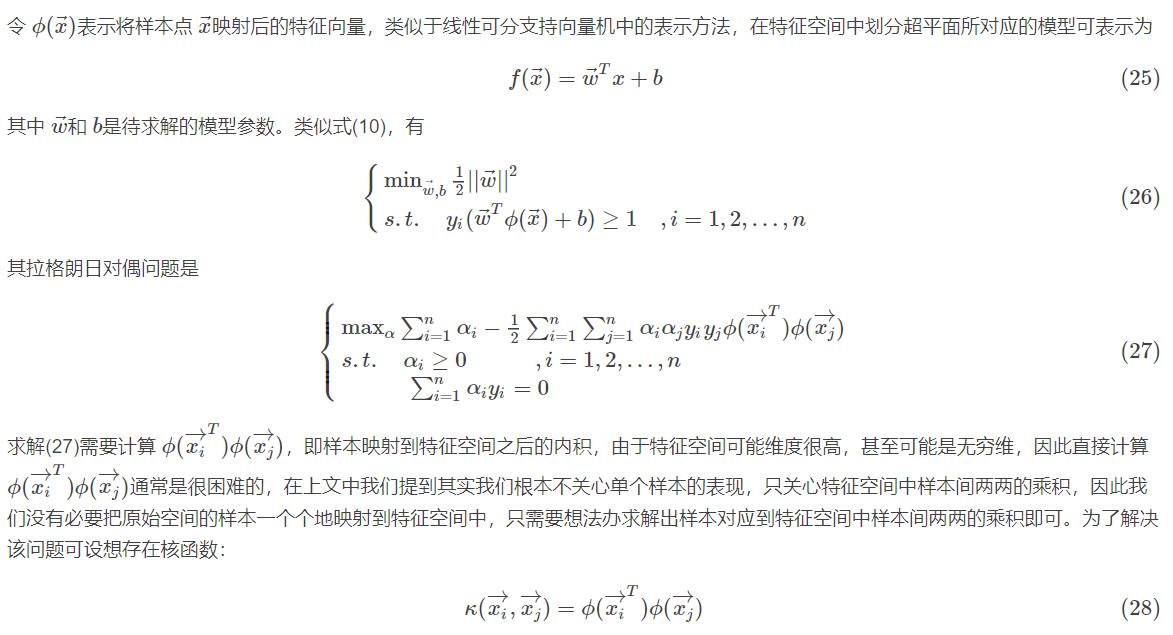

2.2 硬间隔支持向量机

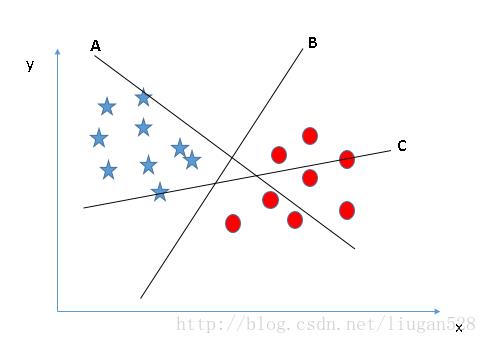

对于图2的A、B、C三个超平面,应该选择超平面C,因为使用超平面C进行划分对训练样本局部扰动的“容忍”度最好,分类的鲁棒性最强。例如,由于训练集的局限性或噪声的干扰,训练集外的样本可能比图2中的训练样本更接近两个类目前的分隔界,在分类决策的时候就会出现错误,而超平面C受影响最小,也就是说超平面C所产生的分类结果是最鲁棒性的、是最可信的,对未见样本的泛化能力最强。

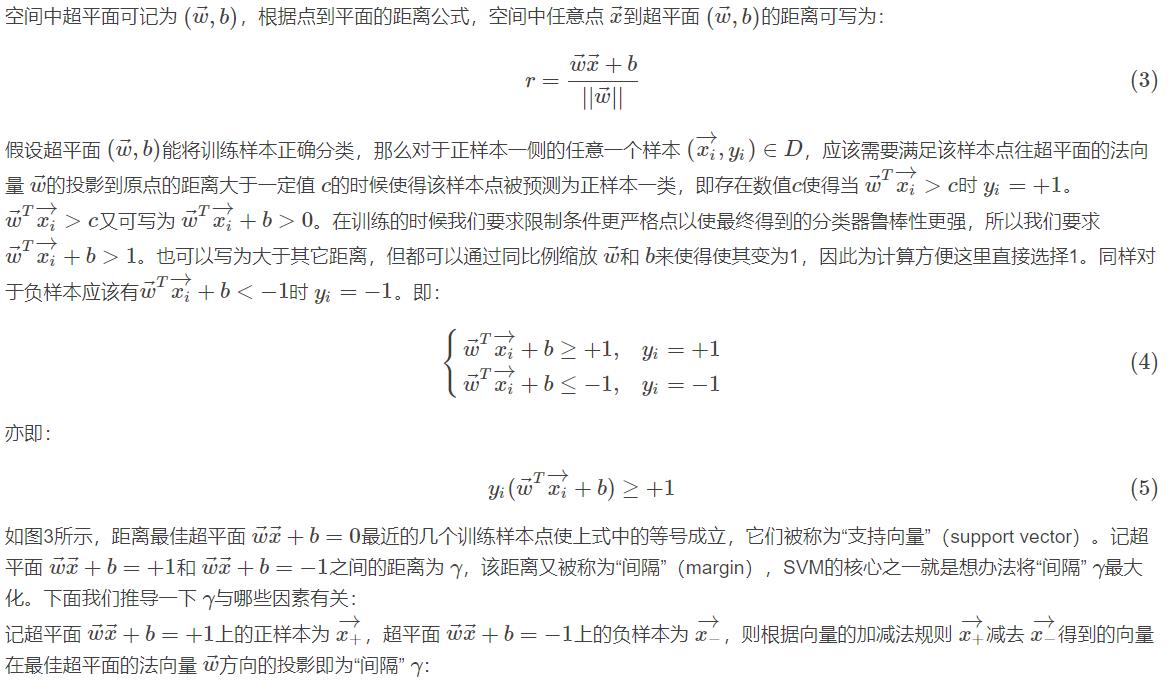

下面以下图中示例进行推导得出最佳超平面。

这就是SVM的基本型。

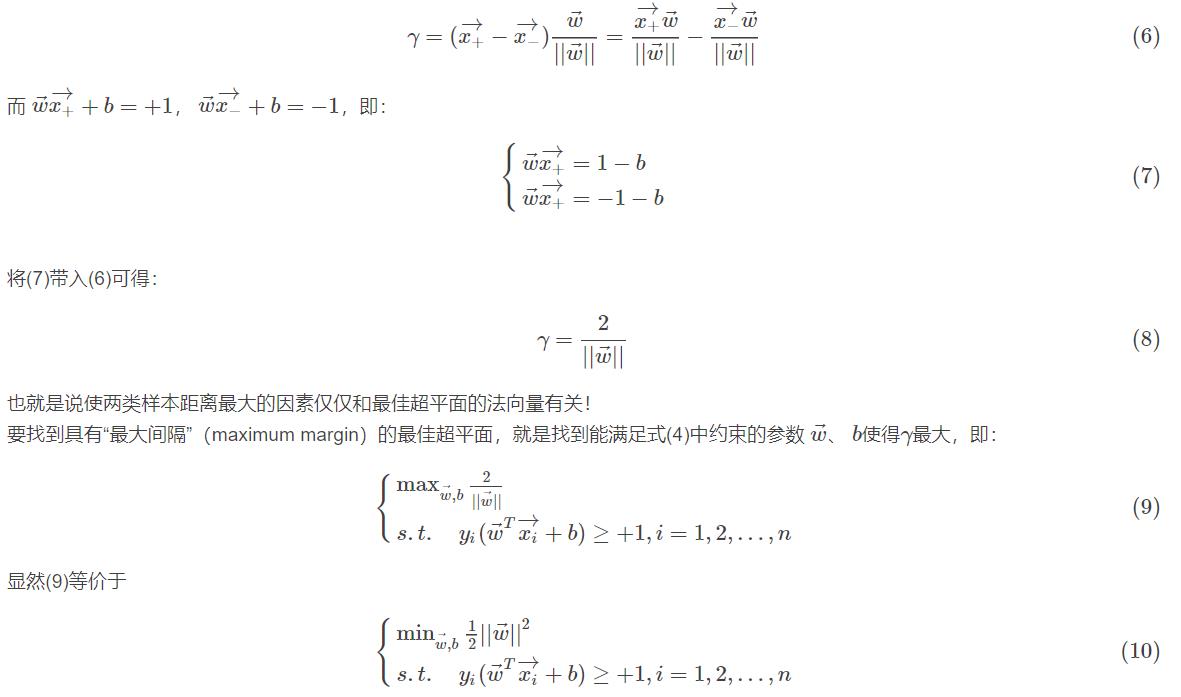

2.2.1 拉格朗日对偶问题

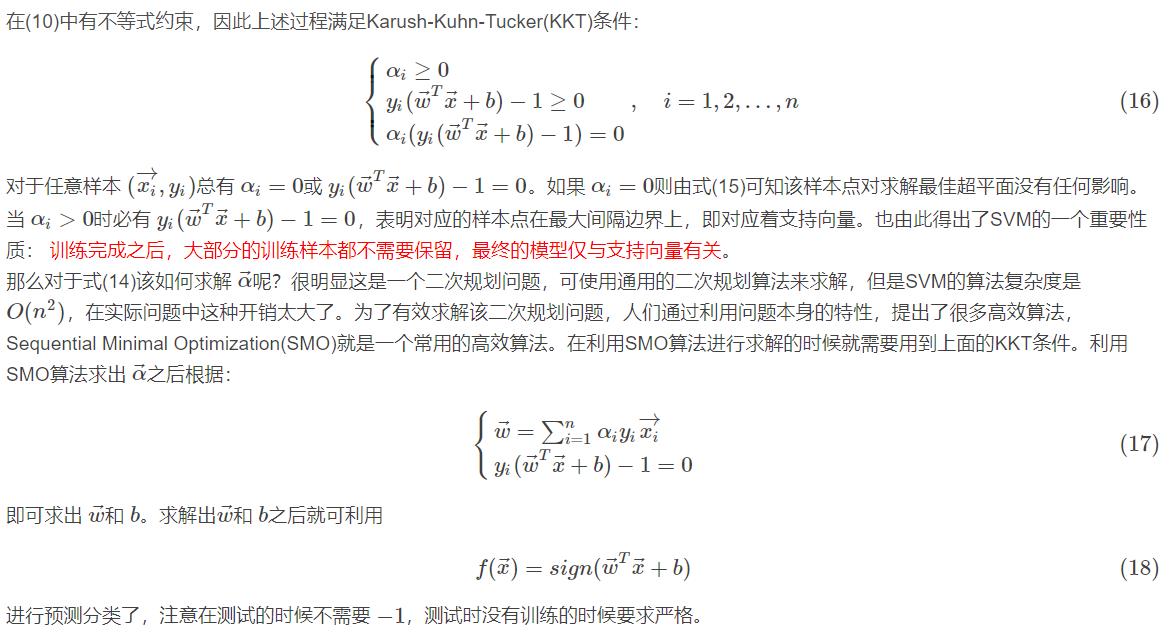

2.2.2 SVM问题的KKT条件

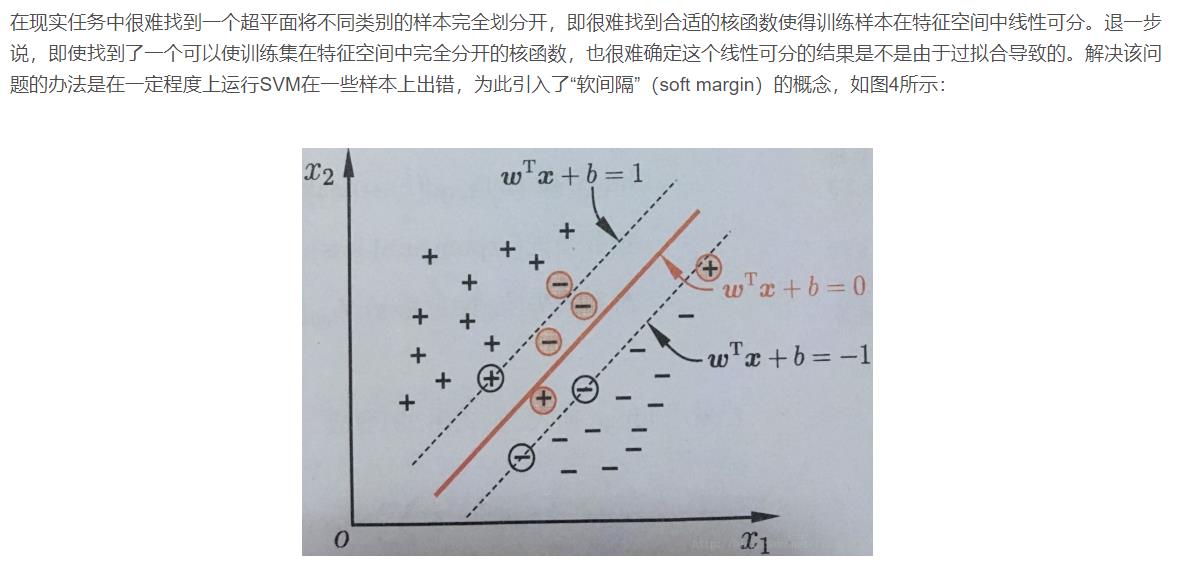

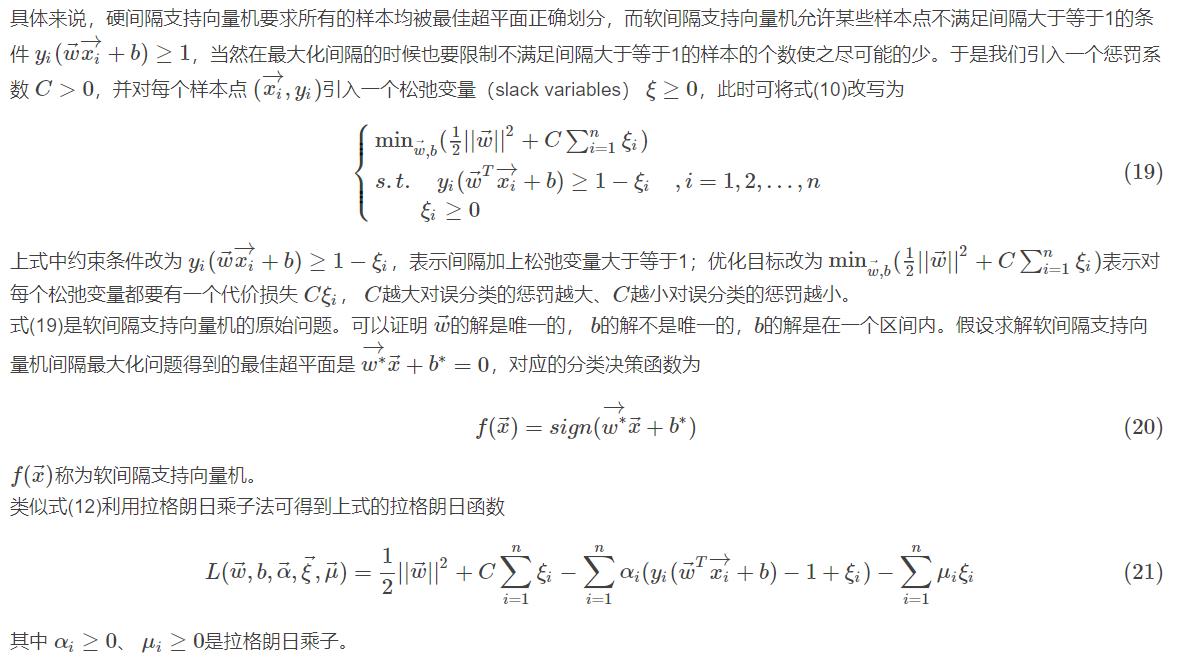

2.3 软间隔支持向量机

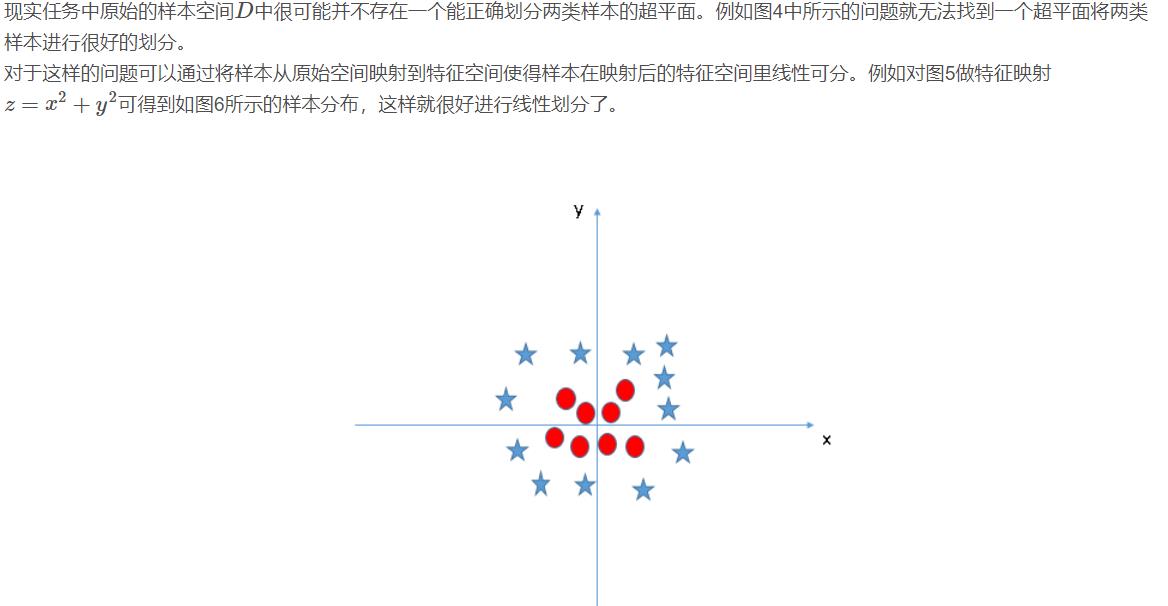

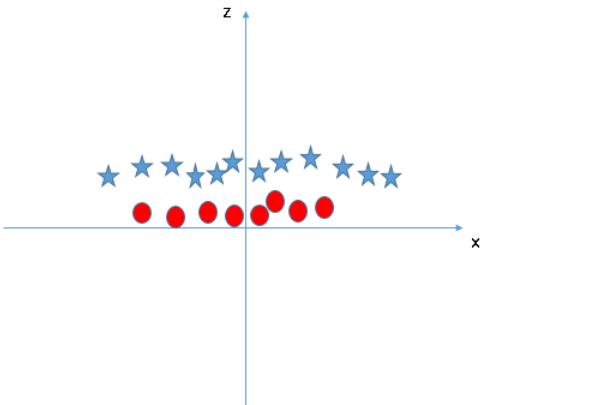

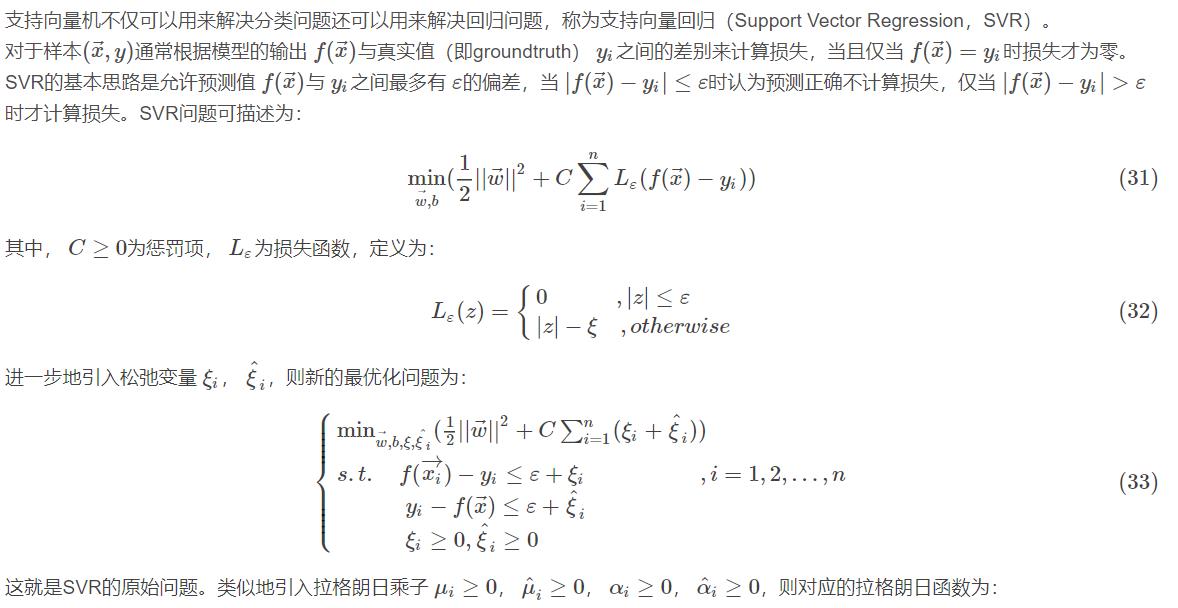

2.4 非线性支持向量机

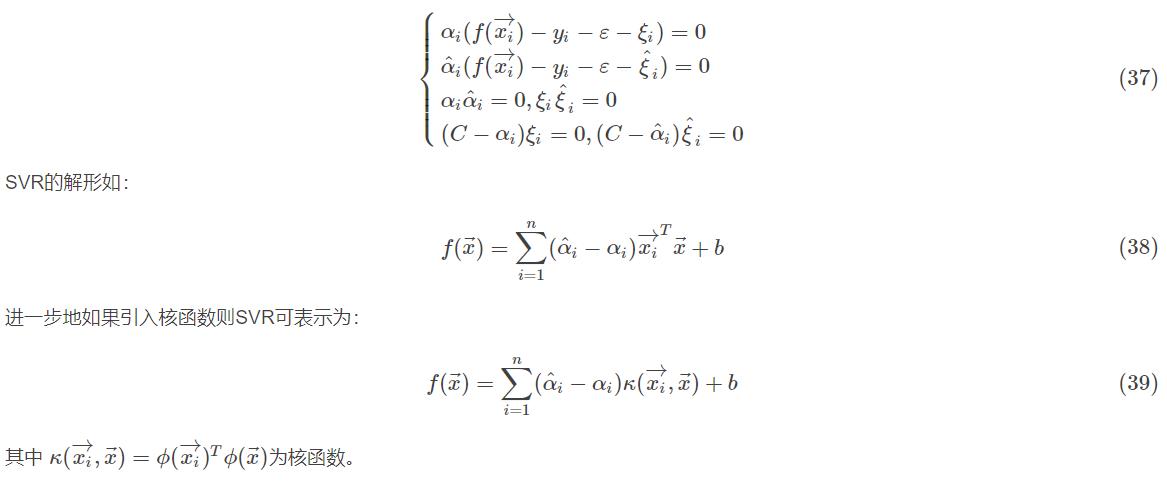

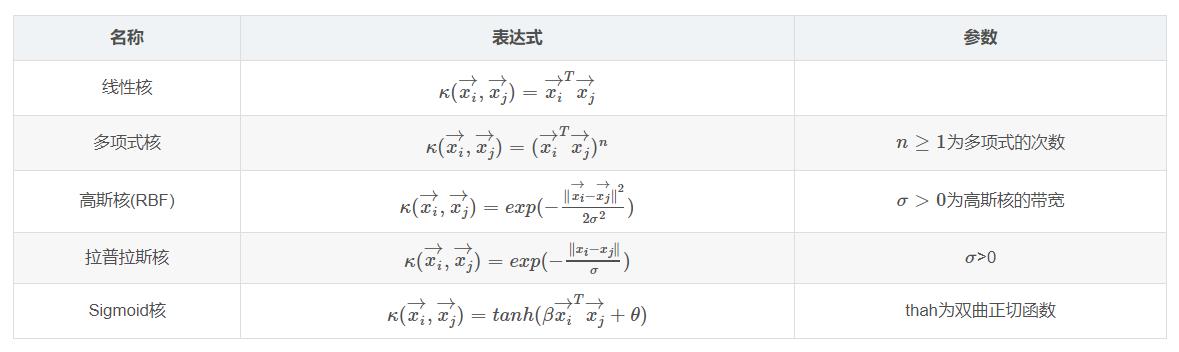

2.4.1 支持向量回归

2.4.2 常用核函数

2.5 SVM的优缺点

优点:

SVM在中小量样本规模的时候容易得到数据和特征之间的非线性关系,可以避免使用神经网络结构选择和局部极小值问题,可解释性强,可以解决高维问题。

缺点:

SVM对缺失数据敏感,对非线性问题没有通用的解决方案,核函数的正确选择不容易,计算复杂度高,主流的算法可以达到O(n2)O(n2)的复杂度,这对大规模的数据是吃不消的。

二、源代码

clear;

clc;

close all;

%获取原始图片

m=1;

%选择样本图像库里面的图片

n=num2str(m);

k=strcat(n,'.jpg');

i=imread(k);

I=rgb2gray(i);

BW=im2bw(I); %利用阈值值变换法将灰度图像转换成二进制图像

figure(1);

imshow(BW);

%最小化背景

[n1 n2]=size(BW);

r=floor(n1/10);

c=floor(n2/10);

x1=1;x2=r;

s=r*c;

switch m

case 1

yan=80; biao=60;

case 2

yan=40; biao=30;

case 3

yan=70; biao=100;

case 4

yan=60; biao=50;

case 5

yan=90; biao=60;

case 6

yan=50; biao=70;

case 7

yan=90; biao=40;

case 8

yan=70; biao=80;

case 9

yan=70; biao=50;

case 10

yan=70; biao=90;

end

zongfen=yan+biao;

zongfen=zongfen*0.55;

for i=1:10

y1=1;y2=c;

for j=1:10

if(y2<=c || y2>=9*c) || (x1==1 || x2==r*10)

loc=find(BW(x1:x2,y1:y2)==0);

[o p]=size(loc);

pr=o*100/s;

if pr<=100

BW(x1:x2,y1:y2)=0;

r1=x1;r2=x2;s1=y1;s2=y2;

pr1=0;

end

imshow(BW);

title('图像识别分析中 ... ...');

set(gcf,'unit','centimeters','position',[10 5 17 15])

end

y1=y1+c;

y2=y2+c;

end

x1=x1+r;

x2=x2+c;

end

figure(2)

imshow(BW)

title('图像识别分析完毕');

set(gcf,'unit','centimeters','position',[10 5 17 15])

%人脸识别

L=bwlabel(BW,8);

BB=regionprops(L,'BoundingBox');

BB1=struct2cell(BB);

BB2=cell2mat(BB1);

[s1 s2]=size(BB2);

mx=0;

for k=3:4:s2-1

p=BB2(1,k)*BB2(1,k+1);

if p>mx && (BB2(1,k)/BB2(1,k+1))<1.8

mx=p;

j=k;

end

end

%-----人脸匹配

%-----输入:细胞结构体数据Cell_all(包括样本集合,特征值与特征向量)

% 想要识别的人脸(彩色图像)

%-----输出:匹配的结果

%-----------------------------------

function FaceFind = facefind(Cell_all,img2find)

%细胞结构体的调用

img_all = Cell_all{1};

[m1,n1] = size(img_all);

V = Cell_all{2};

D = Cell_all{3};

namud = 0.5; %图片缩小的倍数

%对需要识别的图像进行灰度等的处理

pic = rgb2gray(img2find); %灰度处理

pic = imresize(pic,namud); %变换大小

[m2,n2] = size(pic);

pic = reshape(pic,1,m2*n2); %重新排列

pic = double(pic)/255;

pic_done = pic*V*D; %处理完的数据

%% 归一化 --》避免运算出现特别大的数据

Ma = max(max(pic_done));

Mi = min(min(pic_done));

pic_done = pic_done/(Ma - Mi);

%%

for i=1:m1

% 归一化 --》避免运算出现特别大的数据

Ma1 = max(img_all(i,:));

Mi1 = min(img_all(i,:));

img_all(i,:) = img_all(i,:)/(Ma1 - Mi1);

%求范数--》把他们之间的几何距离作为评判与哪一个人脸最近的标准

error(i) = norm(img_all(i,:)-pic_done);

end

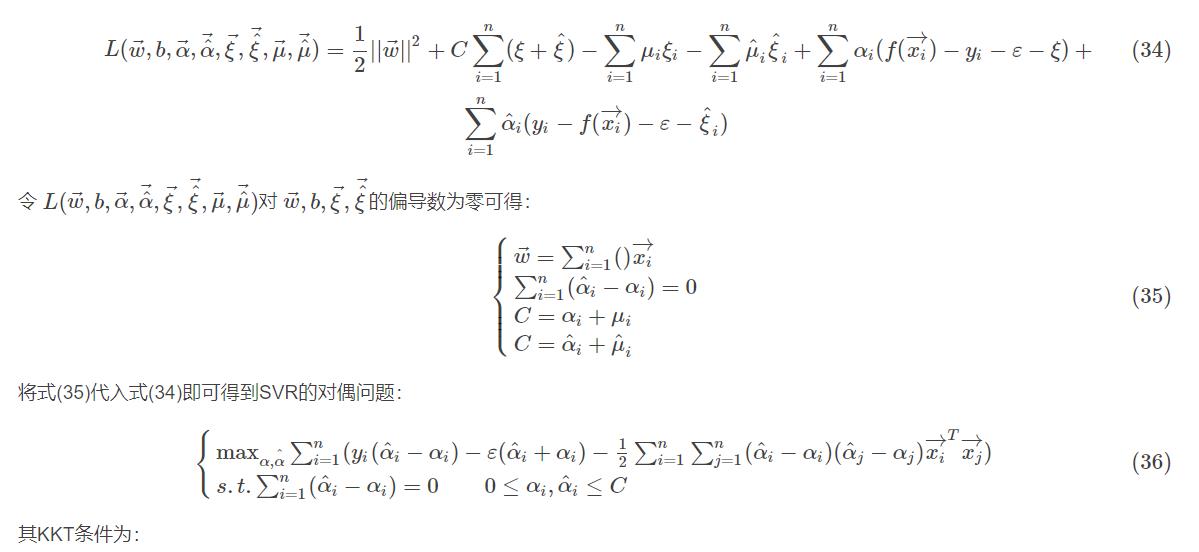

三、运行结果

四、备注

完整代码或咨询添加QQ 1564658423

以上是关于matlab中PCA的人脸识别,最后得出的识别率是啥意思啊!的主要内容,如果未能解决你的问题,请参考以下文章