回归参数的显著性检验(t检验)和回归方程的显著性检验(F检验)的区别是啥?

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了回归参数的显著性检验(t检验)和回归方程的显著性检验(F检验)的区别是啥?相关的知识,希望对你有一定的参考价值。

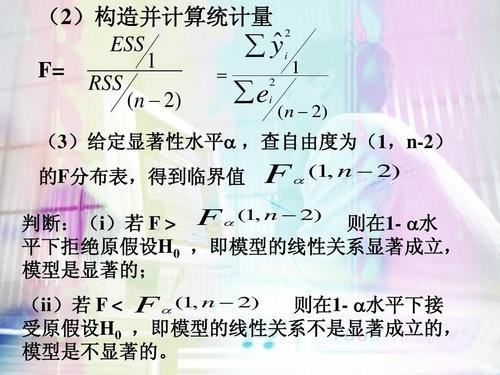

t检验常能用作检验回归方程中各个参数的显著性,而f检验则能用作检验整个回归关系的显著性。各解释变量联合起来对被解释变量有显著的线性关系,并不意味着每一个解释变量分别对被解释变量有显著的线性关系。

两者结果间的差异有5次以上是由抽样误差造成的,则“无效假设”成立,可认为两组间的差异为不显著,常记为p>0.05。

若两者结果间的差异5次以下是由抽样误差造成的,则“无效假设”不成立,可认为两组间的差异为显著,常记为p≤0.05。如果p≤0.01,则认为两组间的差异为非常显著。

扩展资料:

显著性检验的基本原理是提出“无效假设”和检验“无效假设”成立的几率(P)水平的选择。所谓“无效假设”,就是当比较实验处理组与对照组的结果时,假设两组结果间差异不显著,即实验处理对结果没有影响或无效。

经统计学分析后,如发现两组间差异是抽样引起的,则“无效假设”成立,可认为这种差异为不显著(即实验处理无效)。若两组间差异不是由抽样引起的,则“无效假设”不成立,可认为这种差异是显著的(即实验处理有效)。

参考资料来源:百度百科-显著性检验

参考技术A t检验常能用作检验回归方程中各个参数的显著性,而f检验则能用作检验整个回归关系的显著性。各解释变量联合起来对被解释变量有显著的线性关系,并不意味着每一个解释变量分别对被解释变量有显著的线性关系 参考技术B t检验是对单个变量系数的显著性检验F检验是对整个模型的拟合优度检验,即所有变量对被解释变量的显著性检验 参考技术C 应用回归方程进行预测和分析需要注意哪些问题

线性回归分析其中“β、 T 、F”分别是啥含义?

β也就是beta,代表回归系数,标准化的回归系数代表自变量也就是预测变量和因变量的相关,为什么要标准化,因为标准化的时候各个自变量以及因变量的单位才能统一,使结果更精确,减少因为单位不同而造成的误差。

T值是对回归系数的t检验的结果,绝对值越大,sig就越小,sig代表t检验的显著性,在统计学上,sig<0.05一般被认为是系数检验显著,显著的意思就是你的回归系数的绝对值显著大于0,表明自变量可以有效预测因变量的变异。

F是对回归模型整体的方差检验,所以对应下面的p就是判断F检验是否显著的标准,你的p说明回归模型显著。R方和调整的R方是对模型拟合效果的阐述,以调整后的R方更准确一些,也就是自变量对因变量的解释率为27.8%。

原理:

表征依变数Y的变异中有多少百分比,可由控制的自变数X来解释.

决定系数并不等于相关系数的平方。它与相关系数的区别在于除掉|R|=0和1情况,

由于R2<R,可以防止对相关系数所表示的相关做夸张的解释。

决定系数:在Y的总平方和中,由X引起的平方和所占的比例,记为R2

决定系数的大小决定了相关的密切程度。

当R2越接近1时,表示相关的方程式参考价值越高;相反,越接近0时,表示参考价值越低。这是在一元回归分析中的情况。但从本质上说决定系数和回归系数没有关系,就像标准差和标准误差在本质上没有关系一样。

在多元回归分析中,决定系数是通径系数的平方。

表达式:R2=SSR/SST=1-SSE/SST

其中:SST=SSR+SSE,SST (total sum of squares)为总平方和,SSR (regression sum of squares)为回归平方和,SSE (error sum of squares) 为残差平方和。

注意:以下不同名字是同一个意思,只是表述不同

回归平方和:SSR(Sum of Squares for regression) = ESS (explained sum of squares)

残差平方和:SSE(Sum of Squares for Error) = RSS (residual sum of squares) =SSR(sum of squared residuals)

总离差平方和:SST(Sum of Squares for total) = TSS(total sum of squares)

注意:两个SSR的不同

SSE+SSR=SST

RSS+ESS=TSS

意义:拟合优度越大,自变量对因变量的解释程度越高,自变量引起的变动占总变动的百分比高。观察点在回归直线附近越密集。

取值意思:

0 表示模型效果跟瞎猜差不多

1 表示模型拟合度较好(有可能会是过拟合,需要判定)

0~1 表示模型的好坏(针对同一批数据)

小于0则说明模型效果还不如瞎猜(说明数据直接就不存在线性关系)

参考技术A 首先来说明各个符号,B也就是beta,代表回归系数,标准化的回归系数代表自变量也就是预测变量和因变量的相关,为什么要标准化,因为标准化的时候各个自变量以及因变量的单位才能统一,使结果更精确,减少因为单位不同而造成的误差。T值就是对回归系数的t检验的结果,绝对值越大,sig就越小,sig代表t检验的显著性,在统计学上,sig<0.05一般被认为是系数检验显著,显著的意思就是你的回归系数的绝对值显著大于0,表明自变量可以有效预测因变量的变异,做出这个结论你有5%的可能会犯错误,即有95%的把握结论正确。回归的检验首先看anova那个表,也就是F检验,那个表代表的是对你进行回归的所有自变量的回归系数的一个总体检验,如果sig<0.05,说明至少有一个自变量能够有效预测因变量,这个在写数据分析结果时一般可以不报告

然后看系数表,看标准化的回归系数是否显著,每个自变量都有一个对应的回归系数以及显著性检验

最后看模型汇总那个表,R方叫做决定系数,他是自变量可以解释的变异量占因变量总变异量的比例,代表回归方程对因变量的解释程度,报告的时候报告调整后的R方,这个值是针对自变量的增多会不断增强预测力的一个矫正(因为即使没什么用的自变量,只要多增几个,R方也会变大,调整后的R方是对较多自变量的惩罚),R可以不用管,标准化的情况下R也是自变量和因变量的相关

标准误表示由于抽样误差所导致的实际值和回归估计值的偏差大小,标准误越小,回归线的代表性越强

希望对您有用 参考技术B β也就是beta,代表回归系数,标准化的回归系数代表自变量也就是预测变量和因变量的相关,为什么要标准化,因为标准化的时候各个自变量以及因变量的单位才能统一,使结果更精确,减少因为单位不同而造成的误差。

T值是对回归系数的t检验的结果,绝对值越大,sig就越小,sig代表t检验的显著性,在统计学上,sig<0.05一般被认为是系数检验显著,显著的意思就是你的回归系数的绝对值显著大于0,表明自变量可以有效预测因变量的变异。

F是对回归模型整体的方差检验,所以对应下面的p就是判断F检验是否显著的标准,你的p说明回归模型显著。R方和调整的R方是对模型拟合效果的阐述,以调整后的R方更准确一些,也就是自变量对因变量的解释率为27.8%。

扩展资料

线性回归的基本应用:

线性回归是回归分析中第一种经过严格研究并在实际应用中广泛使用的类型。这是因为线性依赖于其未知参数的模型比非线性依赖于其位置参数的模型更容易拟合,而且产生的估计的统计特性也更容易确定。

线性回归模型经常用最小二乘逼近来拟合,但他们也可能用别的方法来拟合,比如用最小化“拟合缺陷”在一些其他规范里(比如最小绝对误差回归),或者在桥回归中最小化最小二乘损失函数的惩罚.相反,最小二乘逼近可以用来拟合那些非线性的模型.因此,尽管“最小二乘法”和“线性模型”是紧密相连的,但他们是不能划等号的。

参考资料:搜狗百科—线性回归

以上是关于回归参数的显著性检验(t检验)和回归方程的显著性检验(F检验)的区别是啥?的主要内容,如果未能解决你的问题,请参考以下文章