Hadoop - Hadoop伪分布式搭建

Posted 随风的叶子

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop - Hadoop伪分布式搭建相关的知识,希望对你有一定的参考价值。

进行Hadoop伪分布式搭建时,需要有一定的Linux命令基础,

因为Hadoop是搭建在Linux环境上的开源框架,

Hadoop的框架最核心的设计就是:HDFS和MapReduce。

本文也主要讲述HDFS和MapReduce环境的搭建。

搭建环境:

虚拟机: VMware10 操作系统:CentOS-6.5 JDK版本:jdk-8u171-linux-x64 Hadoop版本:hadoop-2.7.3 使用工具:Xshell 6,Xftp 6,Notepad++

虚拟机ip地址:192.168.72.10

一、虚拟机网络环境配置

1.首先移动到网络配置文件的目录下:

[root@localhost ~]# cd /etc/sysconfig/network-scripts.

2.查看一下文件夹下的文件

[root@localhost network-scripts]# ls

3.修改配置文件ifcfg-eth0(网络连接采用net模式)

[root@localhost network-scripts]# vi ifcfg-eth0

ifcfg-eth0

DEVICE=eth0 HWADDR=00:0C:29:2C:8A:1C TYPE=Ethernet UUID=a3222bc4-07ad-4b2c-8168-9123758f0333 ONBOOT=yes NM_CONTROLLED=yes BOOTPROTO=static IPADDR=192.168.72.10 NETMASK=255.255.255.0 GATEWAY=192.168.72.2

根据虚拟网络编辑器 IPADDR:是虚拟机的静态 ip , GETWAY : 是虚拟机的网关

按i进入编辑模式,进行文件的编辑,Esc退出编辑模式,:wq进行保存

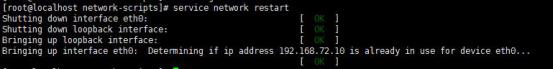

4.重启网络服务:

[root@localhost network-scripts]# service network restart

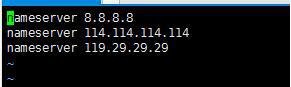

5.配置DNS服务器:

[root@localhost network-scripts]# vi /etc/resolv.conf

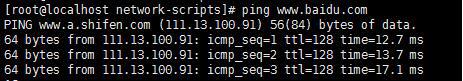

6.检测网络配置

[root@localhost network-scripts]# ping www.baidu.com

二、java的安装和配置

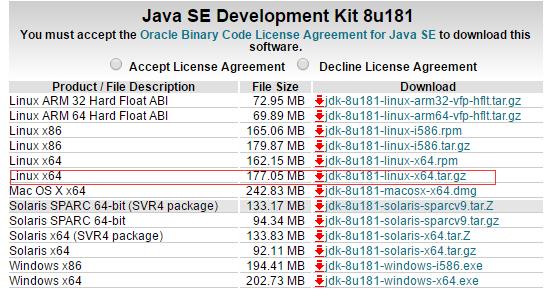

1.下载jdk

jdk1.8 http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

2.利用ftp 6上传到CentOS-6.5上的/soft文件夹下

3.解压压缩包

[root@localhost soft]# tar -zxvf jdk-8u171-linux-x64.tar.gz

4.修改文件名

[root@localhost soft]# mv jdk-1.8.0_161 jdk

5.移动到环境变量配置文件夹(隐藏文件夹)

[root@localhost soft]# cd /etc/profile.d/

5.新建环境变量文件:

[root@localhost profile.d]# vi java.sh

6.进行环境变量配置:

java.sh

JAVA_HOME=/soft/jdk PATH=$PATH:$JAVA_HOME/bin CLASSPATH=$CLASSPATH:$JAVA_HOME/lib export JAVA_HOME PATH CLASSPATH

7.启动环境变量生效:

[root@localhost profile.d]# source java.sh

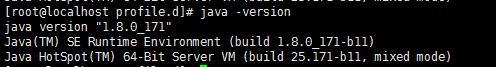

8.查看jdk安装版本

[root@localhost profile.d]# java -version

三、安装SSh配置密钥免登陆

1.安装ssh客户端

[root@localhost profile.d]# yum install -y openssh-clients openssh-server

2.切换到根目录

[root@localhost profile.d]# cd ~

3.生成密钥:

[root@localhost ~]# ssh-keygen -t rsa

(一路回车)

4.进入隐藏目录:

[root@localhost ~]# cd .ssh

5.拷贝密钥文件:

[root@localhost .ssh]# cd id_rsa.pub authorized_keys

6.检验ssh

[root@localhost .ssh]# ping 92.168.72.10

四、Hadoop的安装及配置

1.下载hadoop安装包

http://apache.claz.org/hadoop/common/

2.利用ftp 6上传到CentOS-6.5上的/soft文件夹下

3.解压压缩包

[root@localhost soft]# tar -zxvf hadoop-2.7.3.tar.gz

4.更换目录文件名

[root@localhost soft]# mv hadoop-2.7.3 hadoop

5.移动到配置文件目录

[root@localhost profile.d]# cd /etc/profile.d

6.配置环境变量

[root@localhost profile.d]# vi hadoop.sh

hadoop.sh

HADOOP_HOME=/soft/hadoop PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin export HADOOP_HOME PATH

7.启动hadoop环境变量配置文件

[root@localhost profile.d]# source hadoop.sh

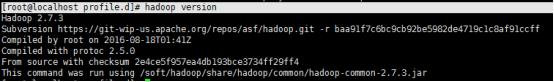

8.检验是否配置好,查看hadoop版本号

[root@localhost profile.d]# hadoop version

五、HDFS的配置管理

1.移动到配置文件目录下

[root@localhost profile.d]# cd /soft/hadoop/etc/hadoop/

2.浏览一下文件夹,会发现core-site.xml hdfs-site.xml

3.建立hdfs的namenode和datanode的文件夹

mkdir -p /hadoop/tmp mkdir -p /hadoop/dfs/name mkdir -p /hadoop/dfs/node

4.修改配置文件配置

core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.72.10:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/hadoop/tmp</value>

</property>

</configuration>

hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

</configuration>

5.格式化namenode

[root@localhost hadoop]# hadoop namenode -format

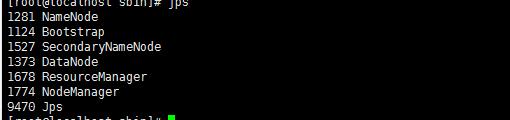

6.查看进程:

[root@localhost hadoop]# jps

多了三个进程NameNode,SecondaryNameNode,DataNode

7.检验管理hdfs

可以通过浏览器查看管理hdfs,通过windows浏览器输入网址 http://192.168.72.10:50070/

8.HDFS操作

//建立文件夹: [root@localhost hadoop]# hdfs dfs -mkdir /hadoop

//上传文件(把当前目录下abc.txt传到hdfs的hadoop上) [root@localhost hadoop]# hdfs dfs -put abc.txt /hadoop

六、MapReduce的配置管理

1.移动到配置文件夹

[root@localhost hadoop]# cd /soft/hadoop/etc/hadoop

2.生成配置文件

[root@localhost hadoop]# cp mapred-site.xml.template mapred-site.xml

此时文件夹下存在mapred-site.xml 和yarn-site.xml

3.修改配置文件

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>192.168.72.10</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

4.移动至启动的文件夹

[root@localhost hadoop]# cd /soft/hadoop/sbin/

5.启动mapreduce资源管理和调度

[root@localhost sbin]# start-yarn.sh

6.查看启动进程

[root@localhost sbin]# jps

发现多了ResourseManager,NodeManager

至此,hadoop伪分布式搭建完成,大家在搭建的过程中要有耐心,

每进行一步时要进行最后的检验,能够成功后进行下一步,

有什么问题可以在评论区留言,我会及时回复,希望能给大家带来帮助。

以上是关于Hadoop - Hadoop伪分布式搭建的主要内容,如果未能解决你的问题,请参考以下文章