spark自定义UDF为啥参数最多21个

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了spark自定义UDF为啥参数最多21个相关的知识,希望对你有一定的参考价值。

Registers a deterministic Scala closure of 22 arguments as user-defined function (UDF) case 23 => register(name, udf.asInstanceOf[UDF22[_, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _, _]] 求大神解释一下,应该和scala函数式编程有关

参考技术A 因为你用的这个版本的sparktuple类最多支持21项,最新版本的应该解决了这个问题。或者通过其他方式绕过这个限制

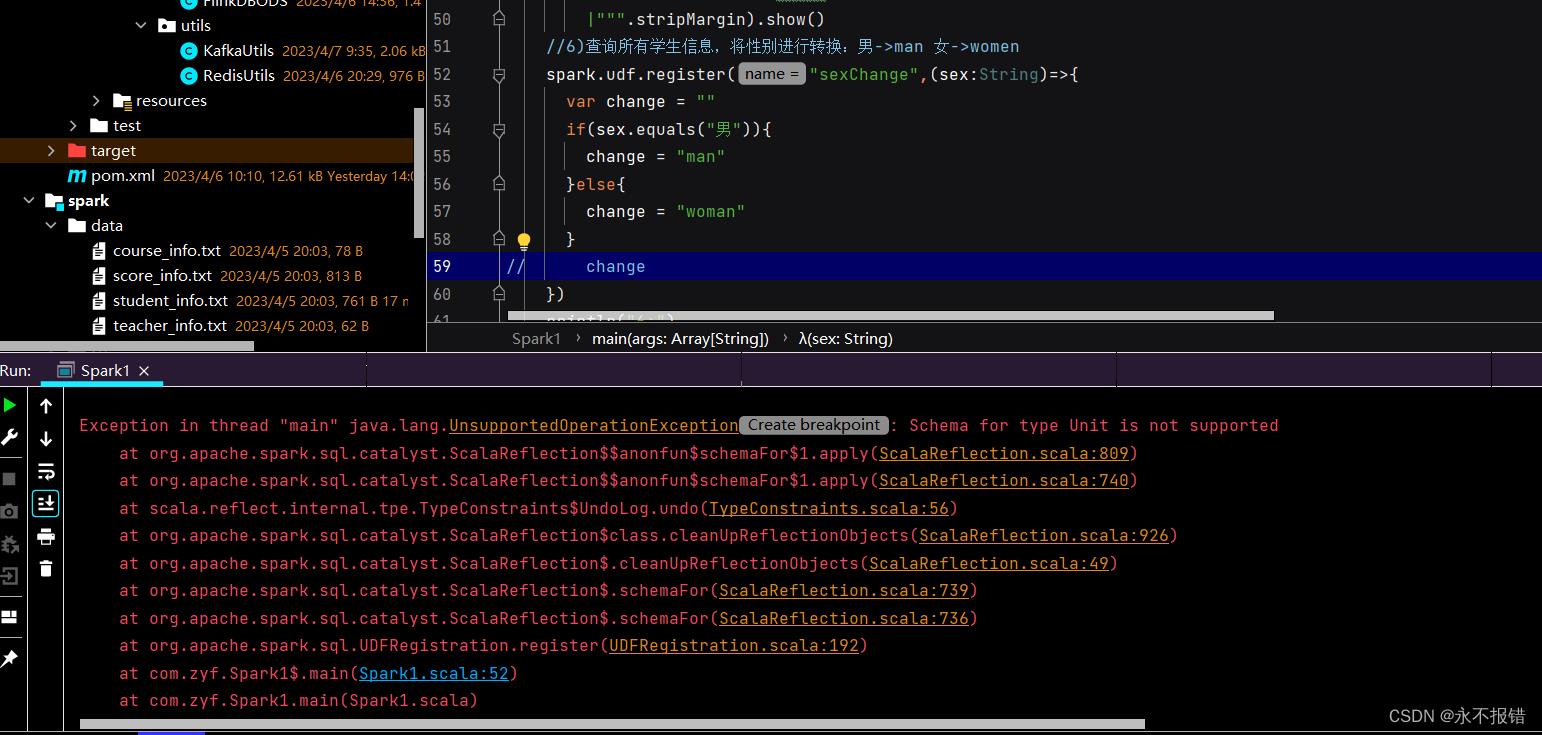

spark自定义函数udf

需要有一个变量作为返回值,否则会报错

以上是关于spark自定义UDF为啥参数最多21个的主要内容,如果未能解决你的问题,请参考以下文章