windows下jdkhadoopScalaSpark的调试环境配置(jdk路径的空格问题, /tmp/hive on HDFS should be writable问题)

Posted wuyicode

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了windows下jdkhadoopScalaSpark的调试环境配置(jdk路径的空格问题, /tmp/hive on HDFS should be writable问题)相关的知识,希望对你有一定的参考价值。

1、首先是jdk的路径问题

为了和以后出现的hadoop,spark出现 路径带有空格导致 调用失败的情况, 直接把 jdk的路径 剪切到 没有空格的目录下。

D:\\>echo %JAVA_HOME%

C:\\Java\\jdk1.8.0_202

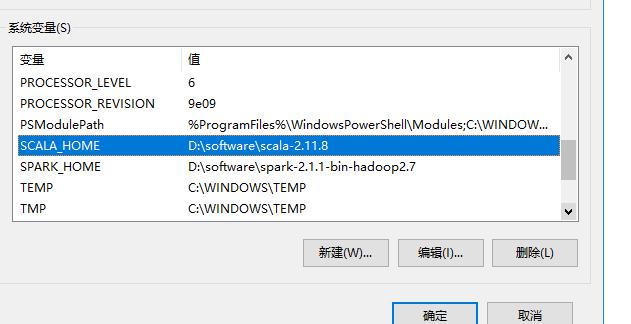

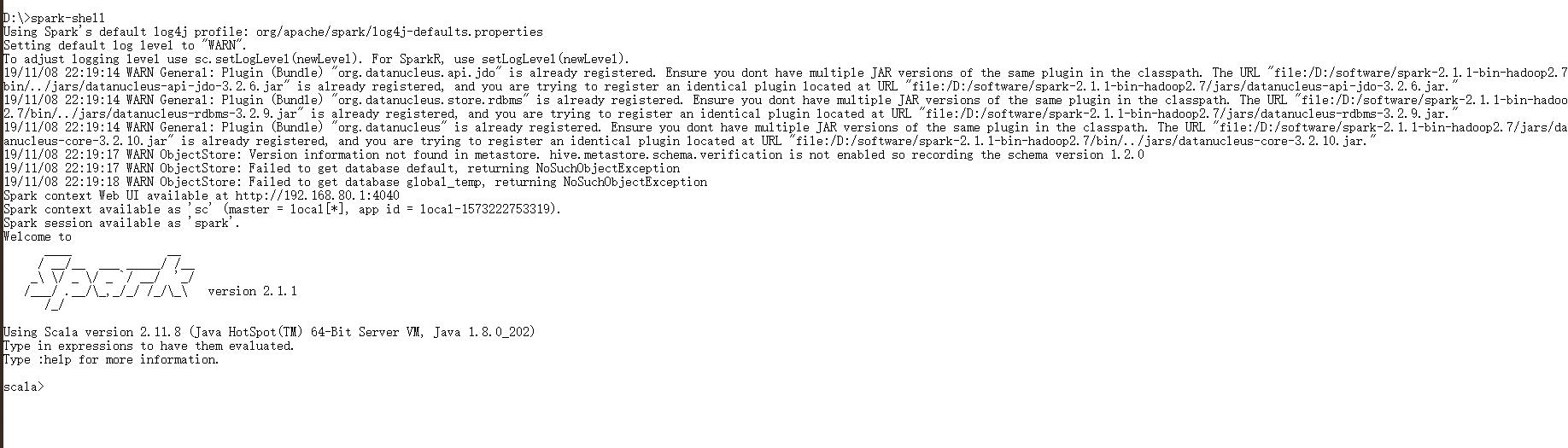

到这里,在cmd下,能 看到 scala -version和 spark-shell 。

2、spark出现The root scratch dir: /tmp/hive on HDFS should be writable

%HADOOP_HOME%\\bin\\winutils.exe ls \\tmp\\hive

%HADOOP_HOME%\\bin\\winutils.exe chmod 777 \\tmp\\hive

%HADOOP_HOME%\\bin\\winutils.exe ls \\tmp\\hive

注意:如果程序是放在 D盘, 那么要在D盘执行以上命令。

看到读写的权限都有了。

以上是关于windows下jdkhadoopScalaSpark的调试环境配置(jdk路径的空格问题, /tmp/hive on HDFS should be writable问题)的主要内容,如果未能解决你的问题,请参考以下文章