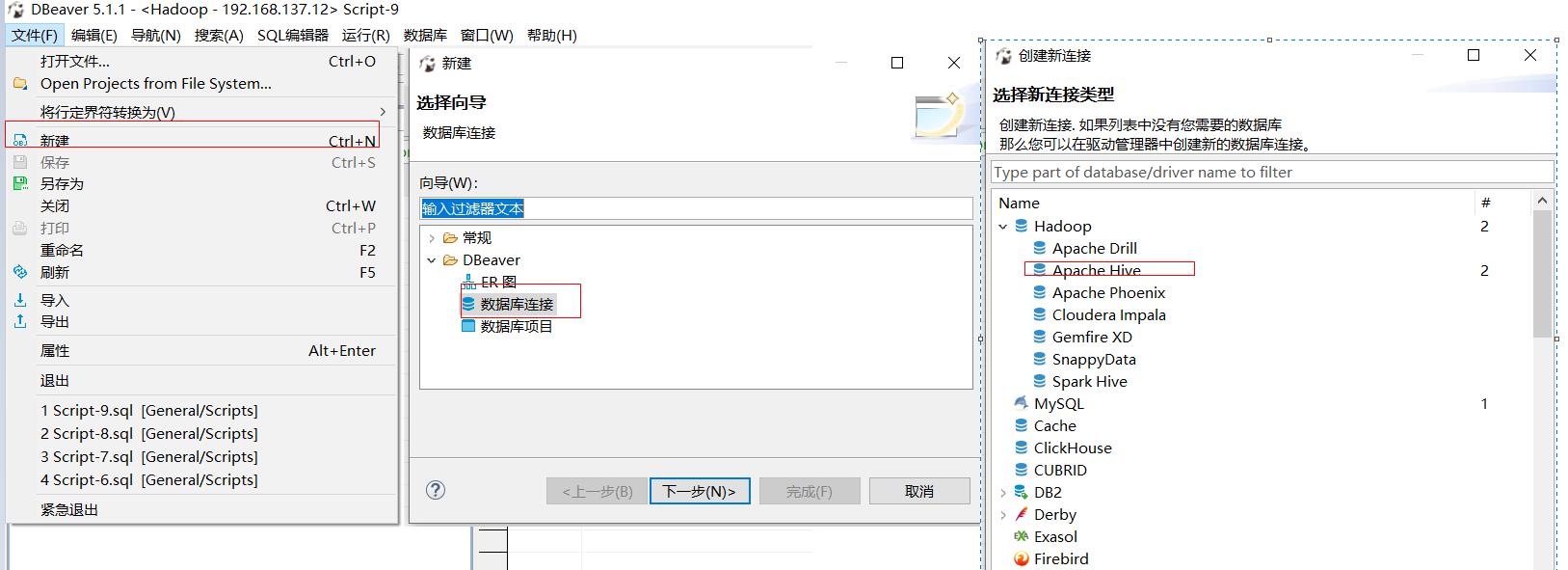

1.连接Hive

首选需要配置Hive

这里我们采用的是JDBC的连接方式

(1) 在Hive中后台启动hiveserver2

[root@hadoop-101 hive]# bin/hiveserver2 &

(2) 启动beeline

[bigdata@hadoop-101 hive]$ bin/beeline

ls: cannot access /opt/module/spark/lib/spark-assembly-*.jar: No such file or directory

Beeline version 1.2.1 by Apache Hive #注意这里的Hive版本,一会有用

beeline>

beeline> !connect jdbc:hive2://192.168.137.11:10000 # 这里的IP地址为Hive所在设备的IP,端口默认是10000

Connecting to jdbc:hive2://192.168.137.11

Enter username for jdbc:hive2://192.168.137.11: #这里可以输入用户名和密码,这里的用户名和密码是为远程连接而设置的,如果不想设置可以置空

Enter password for jdbc:hive2://192.168.137.11:

Connected to: Apache Hive (version 1.2.1)

Driver: Hive JDBC (version 1.2.1)

Transaction isolation: TRANSACTION_REPEATABLE_READ

0: jdbc:hive2://192.168.137.11:10000>

0: jdbc:hive2://192.168.137.11:10000> show databases;

+-----------------+--+

| database_name |

+-----------------+--+

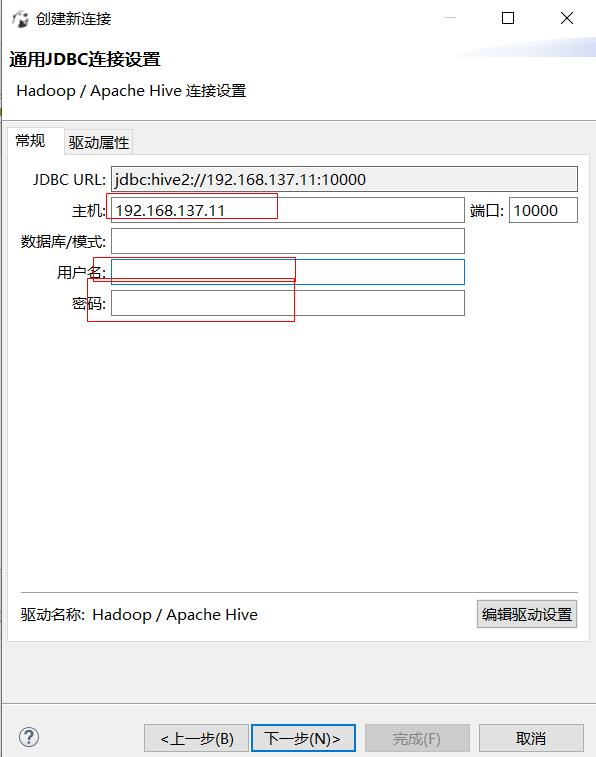

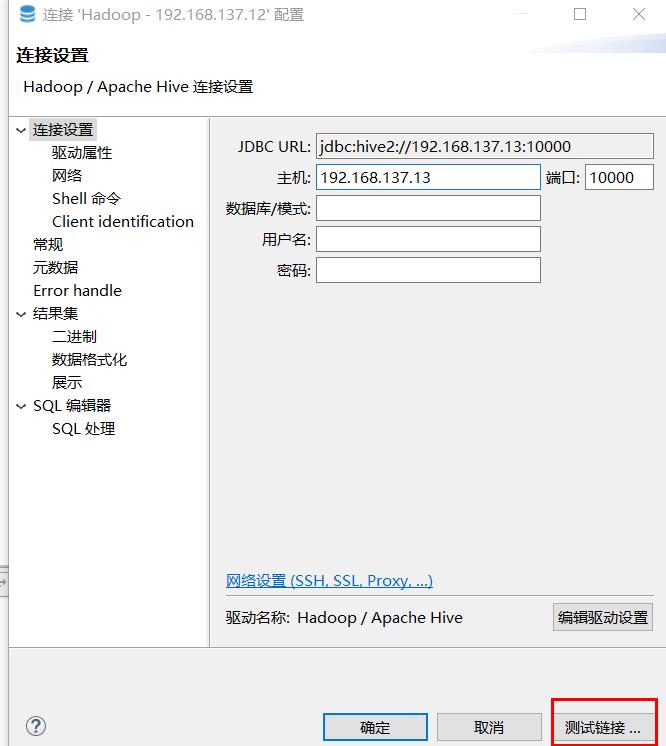

(3)配置Hive

注意:

(1)IP和端口为beeline中所设置的IP和端口

(2)这里的用户名和密码,如果在配置设置beeline的时候,没有填写,这里也可以不填写,否则就填写所配置的用户名和密码

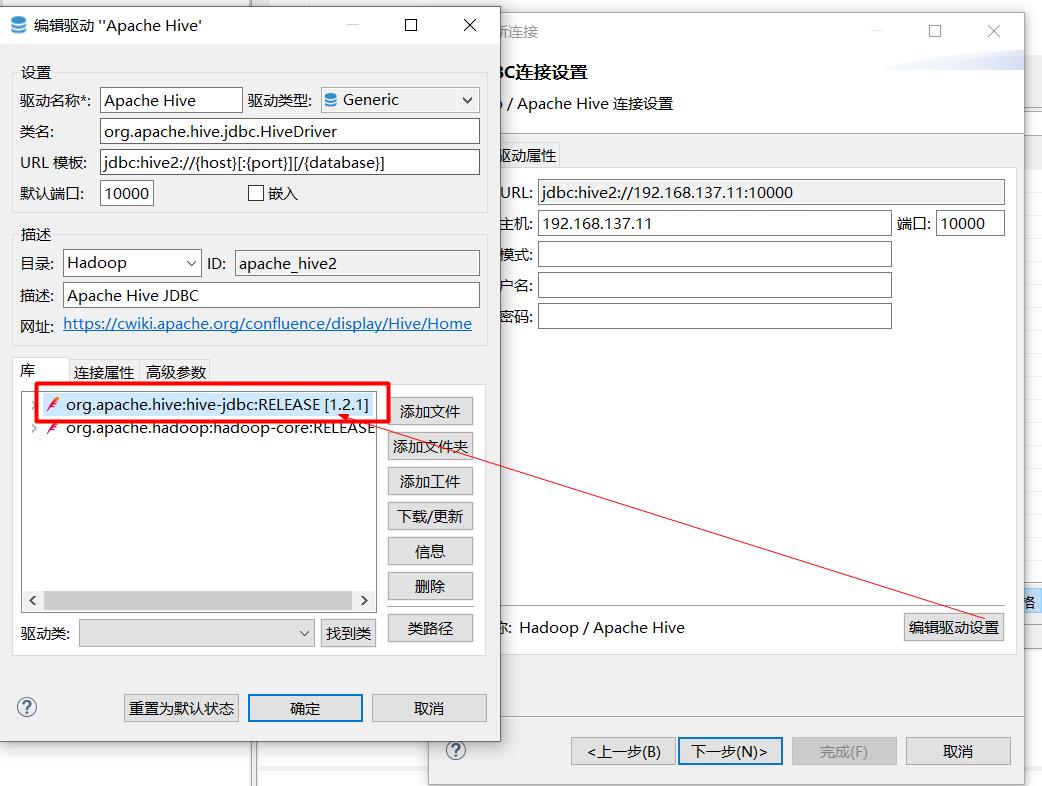

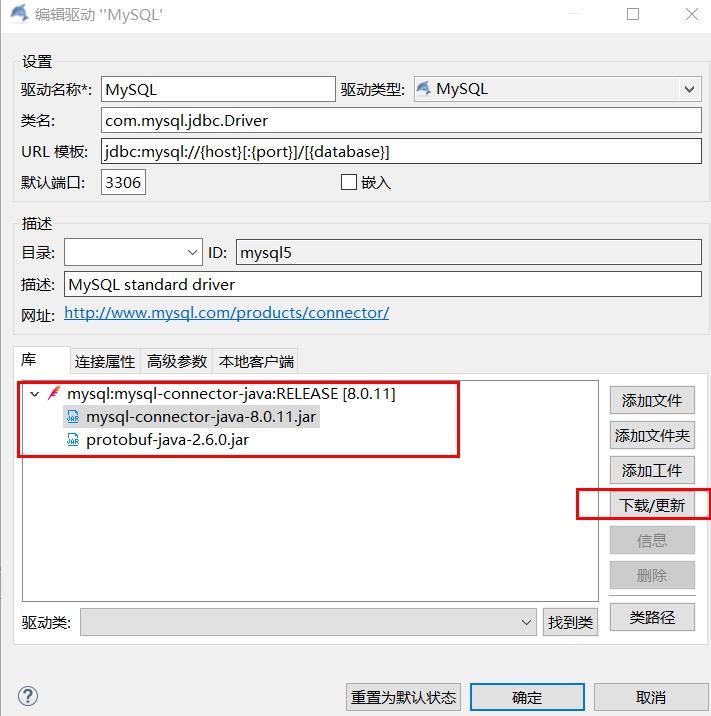

接着配置驱动程序,从beeline启动过程发现,使用的是1.2.1所以我们就下载这个版本的驱动程序,它会自动连接到Maven下载,保存网络畅通,也可也使用本地的jar包

紧接着下一步即可

可以在完成后,测试一下链接状况

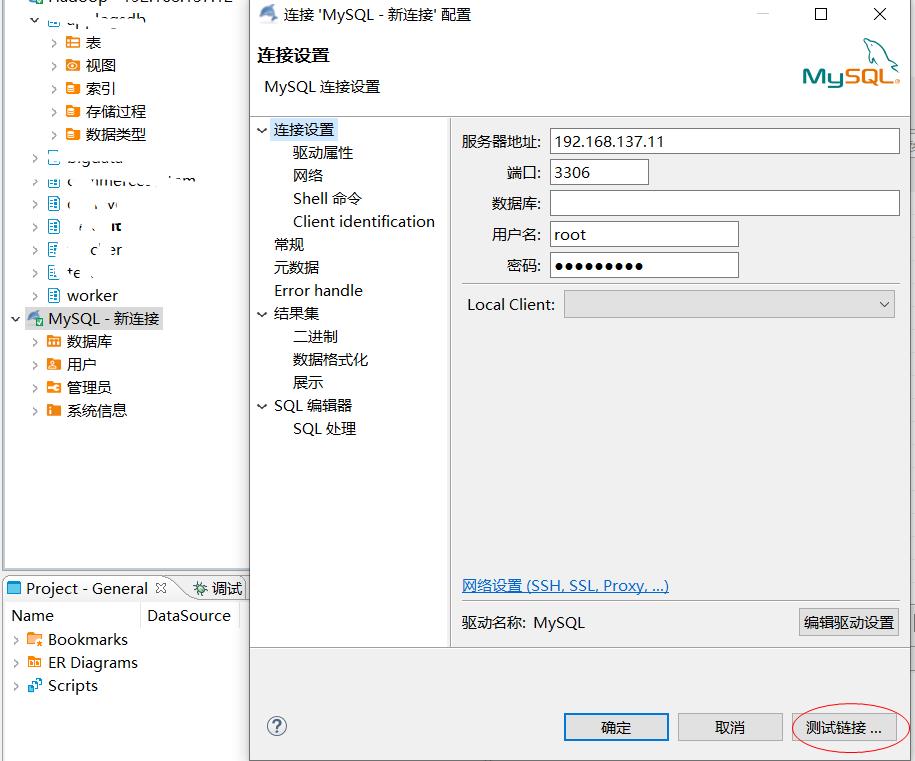

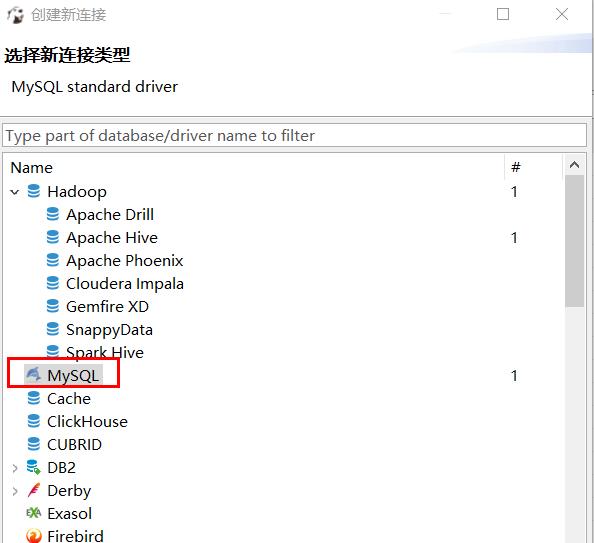

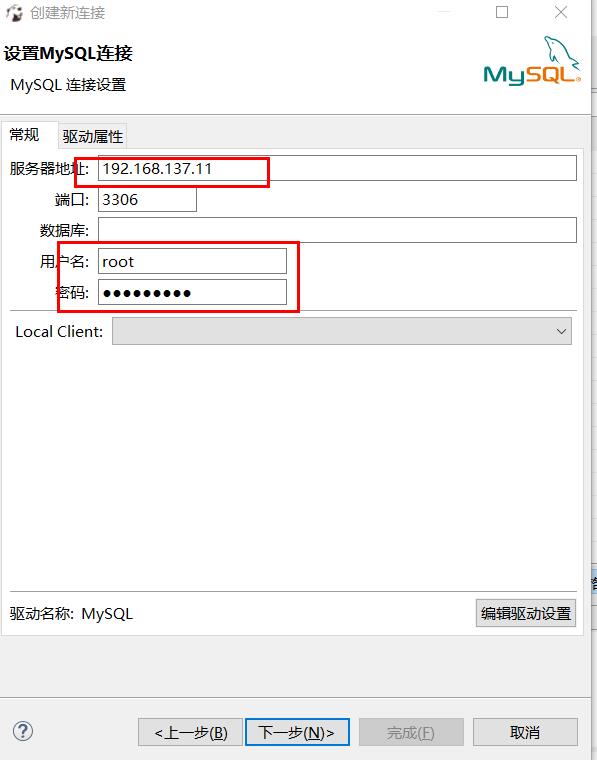

2. 连接mysql

然后再点击“完成”即可。

测试连接状况或直接连接: