Hadoop环境安装

Posted 山本夏木

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop环境安装相关的知识,希望对你有一定的参考价值。

JDK的安装与配置

本块内容的截图演示均为jdk-10.0.1,但在后续过程中发现jdk版本过高,与我下载的hadoop版本不匹配,所以回退版本至jdk-8u171-linux-x64.tar,但截图中没有体现

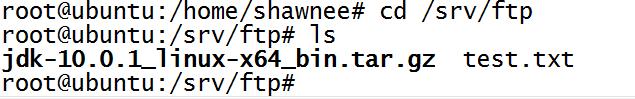

1.将JDK的安装包上传Linux系统(JDK下载地址)

如果没有开发包,可使用wget+地址下载

2.将上传后的“jdk-10.0.1_linux-x64_bin.tar.gz”进行解压缩处理

建议将此内容直接保存到“/user/local”目录中:

#tar xzvf jdk-10.0.1_linux-x64_bin.tar.gz -C /home/shawnee/local

3.进入目录查看,多了“jdk-10.0.1”目录

4.将“jdk-10.0.1/”目录名修改为jdk即可

#mv jdk-10.0.1/ jdk

5.进入到环境文件进行配置

- 利用vim打开“/etc/profile”文件:#vim /etc/profile

- 打开之后进入最下面开始配置:

6.默认情况下修改了环境变量的内容,必须重新启动系统,才可以读取新的配置,但Linux中可以使用source让我们的配置立刻生效:

#source /etc/profile

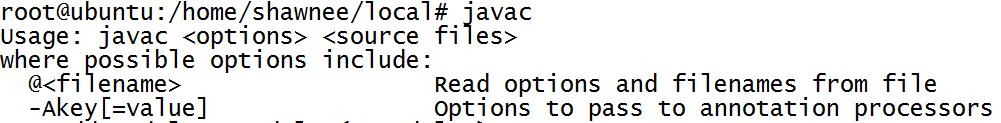

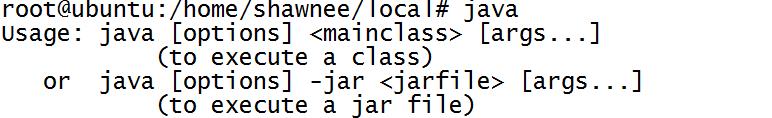

7.对jdk进行测试,输入“java”、“javac”的命令:

Hadoop安装与配置

1.将Hadoop安装包上传到Linux系统中(下载地址)

2.将压缩包进行解压缩处理

#tar xvzf hadoop-2.7.6-src.tar.gz -C /home/shawnee/local

3.为了以后方便配置,将解压后的文件名改名

#mv hadoop-2.7.6-src/ hadoop

4.进行环境变量的配置:

- 使用vim进入/etc/profile文件里进行目录的定义:export HADOOP_HOME=/home/shawnee/local/hadoop

- 可执行命令添加:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:

- 让配置立刻生效:#source /etc/profile

5.因为Hadoop依赖与JDK支持,所以需要在Hadoop一个资源文件里面定义要使用的JDK路径

文件路径:root@ubuntu:/home/shawnee/local/hadoop/etc/hadoop/hadoop-env.sh

#vim hadoop-env.sh

![]()

6.此时是最基础的Hadoop环境(不是开发环境),接下来测试自带程序(wordcount)

如果要进行单词统计信息,需要先指定一个单词的文件

在Hadoop的目录下创建一个input目录:

root@ubuntu:/home/shawnee/local/hadoop/etc/hadoop# cd ..

root@ubuntu:/home/shawnee/local/hadoop/etc# cd ..

root@ubuntu:/home/shawnee/local/hadoop# mkdir input

可以编写一个文件:

root@ubuntu:/home/shawnee/local/hadoop# echo hello yootk mldn hello yootk lixinghua > input/info.txt

root@ubuntu:/home/shawnee/local/hadoop/input# cat info.txt

hello yootk mldn hello yootk lixinghua

在input父目录中执行如下操作:

root@ubuntu:/home/shawnee/local/hadoop# hadoop jar share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.7.6-sources.jar org.apache.hadoop.examples.WordCount input output

最终的分析结果保存在output目录中:

观察output目录中的内容

#cat part-r-00000

Linux下清空回收站的终端命令

(一开始尝试的方法都不管用,直到看到了这篇博客:linux 命令行字符终端terminal下强制清空回收站)

回收站其实就是一个文件夹,存放被删掉的文件。

ubuntu 回收站的路径:

$HOME/.local/share/Trash/

强制清空回收站:

rm -fr $HOME/.local/share/Trash/files/*

以上是关于Hadoop环境安装的主要内容,如果未能解决你的问题,请参考以下文章