Ubuntu16.04下安装Hadoop

Posted whatyouknow123

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Ubuntu16.04下安装Hadoop相关的知识,希望对你有一定的参考价值。

一、记录理由

刚开始只是想要学习怎么使用Hive的。想着安装应该很简单,没想到花了整整一天的时间来安装,为了避免下次犯同样的错误,特此记录。

二、安装Hadoop

网上教你怎么安装Hadoop的文章有很多,质量参差不齐,作为一名刚刚入门的菜鸟,我就记录一个完整的菜鸟版吧。

(1)环境准备

1. Vmware

2. Ubuntu16.04

(2) 安装jdk和openssh

请执行以下命令:

$ sudo apt-get install openjdk-8-jdk

$ sudo apt-get install openssh-server

$ sudo /etc/init.d/ssh start

$ ps -e | grep ssh

$ ssh-keygen -t dsa -P \'\'

$ cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

$ ssh localhost

(3)添加Hadoop用户组合用户

$ sudo su

$ addgroup hadoop

$ adduser --ingroup hadoop hadoop

$ password hadoop //为hadoop账号设置密码

$ adduser hadoop sudo

$ su hadoop

键入hadoop的密码:

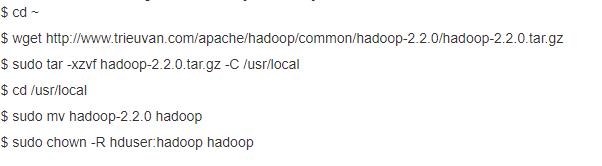

(4) 下载Hadoop

执行以上过程的时候,要先去上面的网站上看一看有没有对应的hadoop-2.2.0.tar.gz,没有的话就换成有的版本

在这个过程中如果有出现permission denieied提示的话,就在命令的最前面加上sudo

(5) 配置环境

$ sudo vim ~/.bashrc

在.bashrc这个文件的最后面加上:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

保存之后退出.bashrc文件

$ sudo cd /usr/local/hadoop/etc/hadoop

$ sudo vim hadoop-env.sh

在hadoop-env.sh文件的最末端加上以下内容

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64/

export HADOOP_COMMON_LIB_NATIVE_DIR="/usr/local/hadoop/lib/native/"

export HADOOP_OPTS="$HADOOP_OPTS -Djava.library.path=/usr/local/hadoop/lib/"

保存之后退出hadoop-env.sh文件

退出terminal再打开

(6)配置Hadoop

$ su hadoop

$ cd /usr/local/hadoop/etc/hadoop

$ sudo vim core-site.xml

<property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> </property>

$ sudo vim yarn-site.xml

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property>

$ sudo mv mapred-site.xml.template mapred-site.xml

$ sudo vim mapred-site.xml

property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

$ sudo mkdir -p ~/mydata/hdfs/namenode

$ sudo mkdir -p ~/mydata/hdfs/datanode

$ sudo vim hdfs-site.xml

<property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/home/hduser/mydata/hdfs/namenode</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/home/hduser/mydata/hdfs/datanode</value> </property>

(6) 格式化namenode, 启动服务

$ sudo cd /usr/local/hadoop/

$ ./bin/hdfs namenode -format

$ ./start-dfs.sh && start-yarn.sh

$ jps

顺利的话这里要能看到 SecondaryNameNode, NameNode, DataNode, NodeManager, ResourceManager, Jps

(7)测试

在浏览器上键入: http://localhost:50070/ 会出现hadoop页面; 键入:http://localhost:8088也会出现有一个页面

三、安装Hive

在安装了测试了Hadoop之后就可以安装Hive。为了避免篇幅过长,我把如何安装Hive移到下一篇博客。

以上是关于Ubuntu16.04下安装Hadoop的主要内容,如果未能解决你的问题,请参考以下文章