Hadoop 3.x 时代,EC 露个脸呗!

Posted DataFlow范式

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop 3.x 时代,EC 露个脸呗!相关的知识,希望对你有一定的参考价值。

在本文中,笔者将详细研究 HDFS EC(Erasure Coding,纠删码),讲解什么是 HDFS EC,引入 EC 的原因,用于 EC 的算法,以及在 Hadoop 社区中为 EC 做的架构优化,最后再结合 Hive 实战 HDFS EC。

HDFS 复制算法的问题

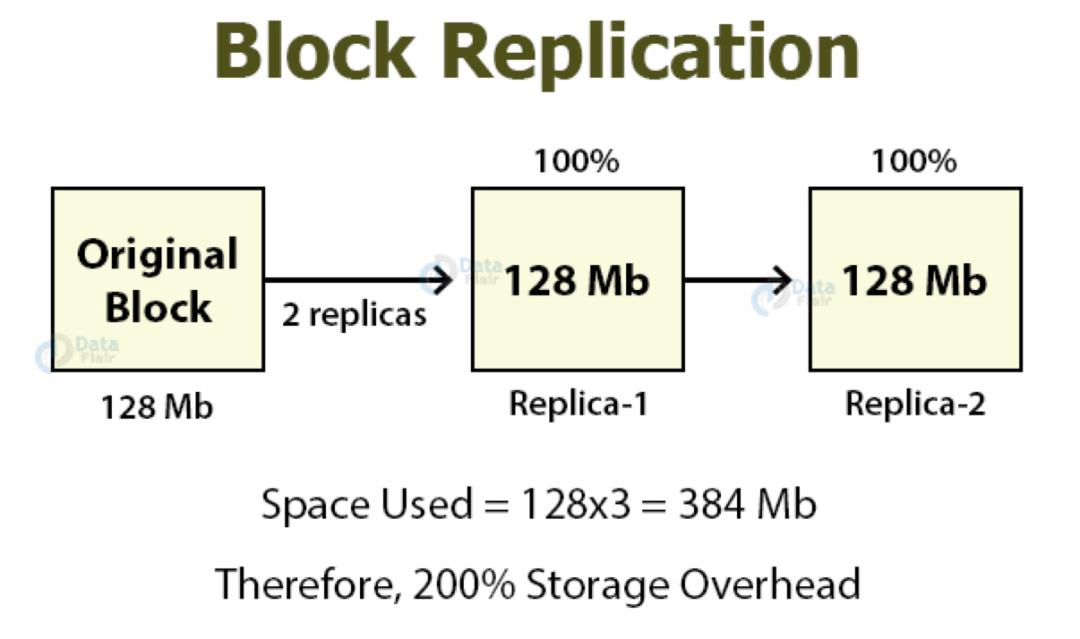

为了提供容错,HDFS 根据复制因子的大小在不同的 DataNodes 节点复制文件块数据。复制因子默认值为 3,则表明原始数据块有多余的两个副本,这些副本也消耗其他资源,例如网络带宽和存储。

在 N 个复制因子的复制中,存在 N-1 个容错能力,存储效率为 1/N。所以这种方式的复制增加了存储的开销和资源的浪费。对于 I/O 活动较低且很少访问的 cold 数据集和 warm 数据集的副本使用与原始数据集相同的资源。

为了解决这些问题,Hadoop 社区使用 HDFS Erasure Coding 代替默认的复制方式,以提供相同级别的容错能力,并且存储开销不超过 50%。

Erasure Coding 文件的复制因子始终为 1,无法对其进行更改。

HDFS Erasure Coding

在 Hadoop 3 中,Erasure Coding 是默认复制方式的解决方案。</

以上是关于Hadoop 3.x 时代,EC 露个脸呗!的主要内容,如果未能解决你的问题,请参考以下文章