Hadoop 2.0 安装配置

Posted Jesse_Li

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop 2.0 安装配置相关的知识,希望对你有一定的参考价值。

1. install jdk

2. install hadoop.

安装包hadoop-2.2.0.tar.gz存放在一个目录。并解压。

3. 修改配置文件,一般配置文件在/etc/hadoop下面。

(1) hadoop-env.sh修改配置文件:

export JAVA_HOME=/home/jdk/jdk_version

(2) mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

(3) core-site.xml

<property>

<name>fs.default.name</name>

<value>hdfs://YARN001:8020</value>

</property>

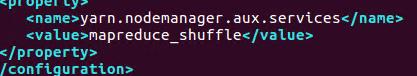

(4) yarn-site.xml:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

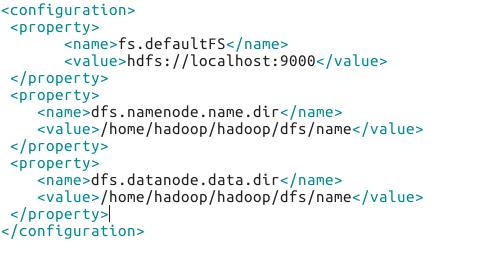

(5)hdfs-site.xml:

(6) yarn-stie.xml

4. 启动hadoop服务

a. sbin/start-all.sh 启动所有服务。

1) bin/hadoop namenode -format 这个命令是格式化整个集群。操作一定要小心。一般只建议搭建时候第一次用。命令一旦运行系统会自动创建hdfs-site.xml中的dfs文件夹

2) sbin/hadoop-daemon.sh start namenode 启动namenode

3) sbin/hadoop-daemon.sh start datanode 启动datanode

http://yarn001:50070 去访问hdfs是否创建成功

4) sbin/start-yarn.sh

http://yarn001:8088 验证yarn是否启动成功

以上是关于Hadoop 2.0 安装配置的主要内容,如果未能解决你的问题,请参考以下文章