基于激光雷达视觉和惯导的轨迹估计与在线外参标定

Posted Being_young

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于激光雷达视觉和惯导的轨迹估计与在线外参标定相关的知识,希望对你有一定的参考价值。

点云PCL免费知识星球,点云知识点分享

文章:Lidar-Visual-Inertial Odometry with Online Extrinsic Calibration

链接:https://link.springer.com/article/10.1007/s12204-023-2570-6

作者:H_K

来源:智驾全栈与3D视觉学习星球

欢迎各位加入知识星球,获取更多技术分享,欢迎转发朋友圈分享快乐。

内容介绍

本文提出了一个改进自LVI-SAM的视觉、激光、IMU紧耦合框架。一种利用激光雷达、视觉和惯导测量单元 (IMU) 进行联合定位的方法,并在线估计和校准它们之间的外部参数,以实现更准确和鲁棒的定位结果。该方法旨在适用于无人机、移动机器人和自动驾驶车辆等领域,以实现精确的定位和导航。

主要贡献:

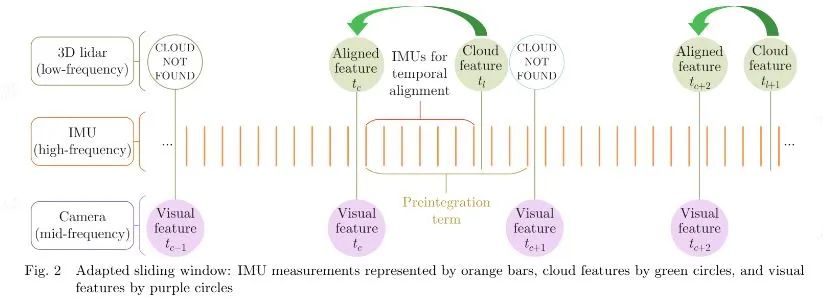

自适应滑窗处理不同频率的数据;

用视觉、点云特征和IMU做在线的外参标定。

系统的状态量包括:滑窗内body(imu)的位姿,imu和相机的外参,相机和lidar的外参,视觉特征的逆深度。自适应滑窗与VINS-MONO相似,但是频率以cloud的频率为参考。

滑窗内的空间-时间对齐(spatial-temporal alignment):

空间对齐:将点云变换到body系;

时间对齐:使用IMU观测数据,将点云变换到cloud之前最近的图像帧。

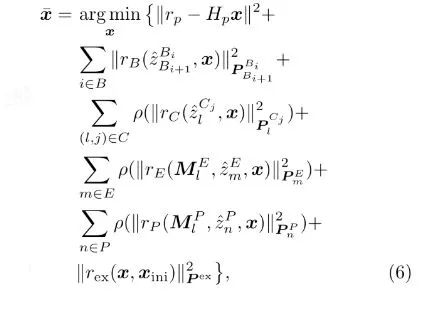

非线性优化:包含先验项、IMU预积分、视觉重投影、lidar的edge和plane、外参残差。

实验结果:鲁棒性优于LVI-SAM,加入外参标定提高定位精度。

更多详细内容或提问作者可加入知识星球

智驾全栈与3D视觉学习星球:主要针对智能驾驶全栈相关技术,3D/2D视觉技术学习分享的知识星球,将持续进行干货技术分享,知识点总结,代码解惑,最新paper分享,解疑答惑等等。星球邀请各个领域有持续分享能力的大佬加入我们,对入门者进行技术指导,对提问者知无不答。同时,星球将联合各知名企业发布自动驾驶,机器视觉等相关招聘信息和内推机会,创造一个在学习和就业上能够相互分享,互帮互助的技术人才聚集群。

以上内容如有错误请留言评论,欢迎指正交流。如有侵权,请联系删除

扫描二维码

关注我们

让我们一起分享一起学习吧!期待有想法,乐于分享的小伙伴加入知识星球注入爱分享的新鲜活力。分享的主题包含但不限于三维视觉,点云,高精地图,自动驾驶,以及机器人等相关的领域。

分享及合作方式:微信“920177957”(需要按要求备注) 联系邮箱:dianyunpcl@163.com,欢迎企业来联系公众号展开合作。

点一下“在看”你会更好看耶

以上是关于基于激光雷达视觉和惯导的轨迹估计与在线外参标定的主要内容,如果未能解决你的问题,请参考以下文章