关于DETR模型训练自定义数据集AP=0问题

Posted 彭祥.

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了关于DETR模型训练自定义数据集AP=0问题相关的知识,希望对你有一定的参考价值。

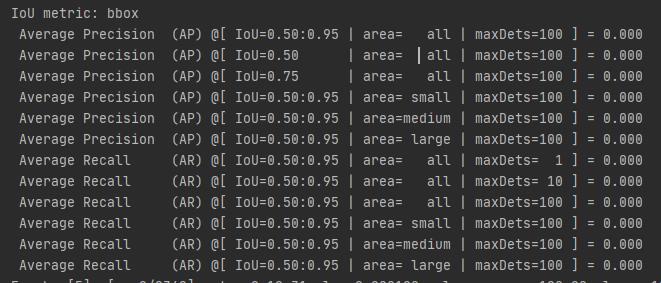

在使用DETR模型进行训练过程时,其在每次训练完成后都会进行评估,但在运行过程中,博主发现其AP值始终都为0,如下图:

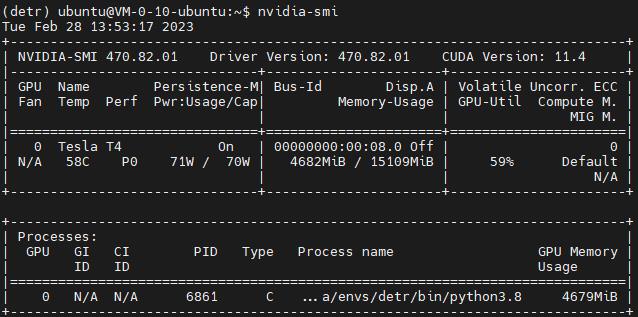

刚开始时,博主还以为是初始训练的问题,后来进行了6个轮次后结果依旧没有改变,此时以为是数据集的类别与编号没有对应造成的,但经过排查却并非是这个原因。后来在查阅资料时得知这是由于Transformer开始是无方向的,我们需要给它一个预训练权重进行迁移学习。这时博主就很奇怪了,先前不是已经给了ResNet预训练权重了吗,怎么还会要求这个呢,查看了一下服务器的源码也没有发现异常,而在查看GPU使用情况时(如下图),博主此时的batch-size=32,但GPU利用率与显存占用率并不高,这与论文中提到的很吃配置明显是不符的。

随后博主不再使用服务器,而是转回本地,此时发现运行竟然报错了。

RuntimeError: Error(s) in loading state_dict for DataParallel:

size mismatch for module.lstm_block.lstm.weight_ih_l0: copying a param with shape torch.Size([7, 500]) from checkpoint, the shape in current model is torch.Size([92, 2000]).

这一下给我搞懵了,先前可没有出现过呀。后来经过梳理先前的过程,发现是自己的类别配置出了问题。

修改后再次运行,不再报错,也可以运行了,但缺依旧没有解决AP=0的问题。很苦恼。

以上是关于关于DETR模型训练自定义数据集AP=0问题的主要内容,如果未能解决你的问题,请参考以下文章