Azure 架构师学习笔记-Azure Data Factory -触发器详解-事件触发器

Posted 發糞塗牆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Azure 架构师学习笔记-Azure Data Factory -触发器详解-事件触发器相关的知识,希望对你有一定的参考价值。

本文属于【Azure 架构师学习笔记】系列。

本文属于【Azure Data Factory】系列。

接上文【Azure 架构师学习笔记】-Azure Data Factory (3)-触发器详解-翻转窗口

前言

事件触发指的是存储事件,所以在新版的ADF 中,已经明确了是“存储事件”, 当对blob进行创建,删除时,就会触发事件。和“翻转窗口”有点不同的是,翻转窗口是一对一的触发,事件触发时多对多的关系,一个事件可以触发多个pipeline。

事件可以只选一个,也可以全选两个。本文使用【已创建Blob】来演示,简单来说就是上传一个文件(blob), 使触发器触发这个事件,并把文件从我个人storage account的“logicapp / source” 下搬到“dest / dest”。

配置步骤

新建触发器

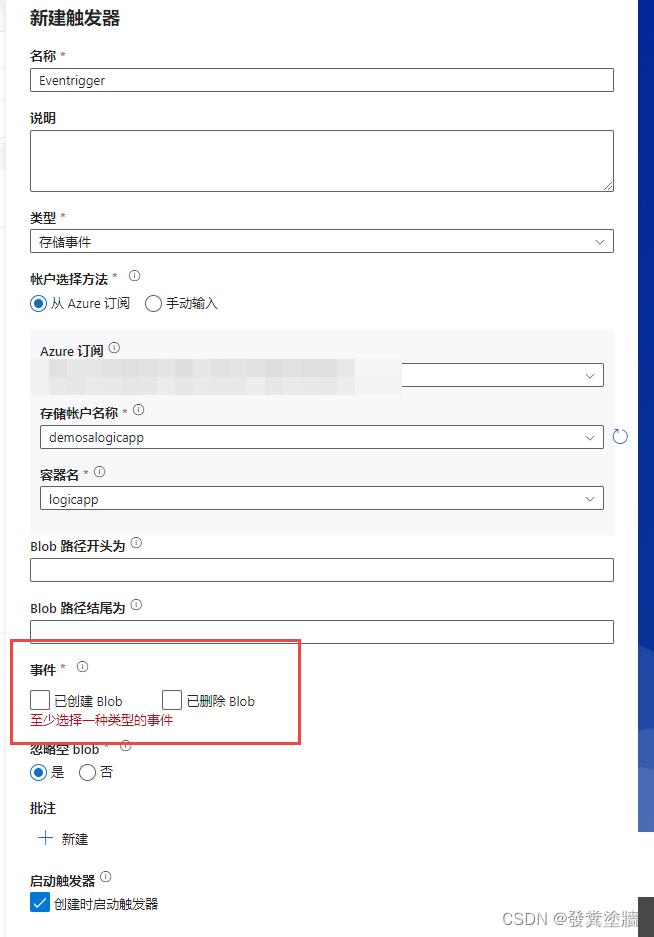

如下图所示, 可以指定Blob路径的开头或结尾,作为演示,尽量保持简单。注意选择需要监控的“容器名”, 这里为“logicapp”:

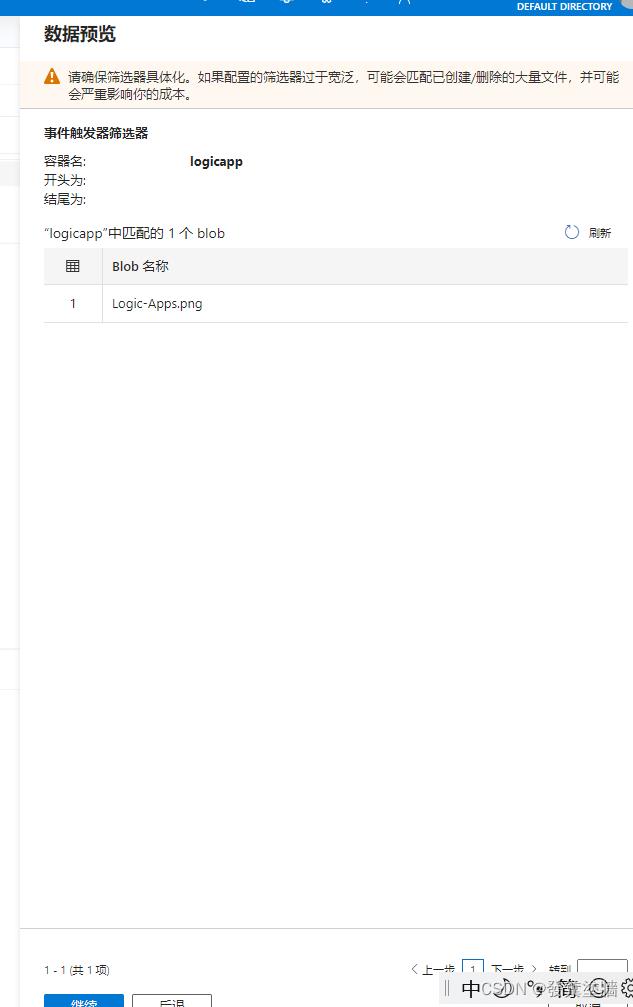

选择之后会显示下面的预览,不过接下来会清空这个容器以便更准确地演示:

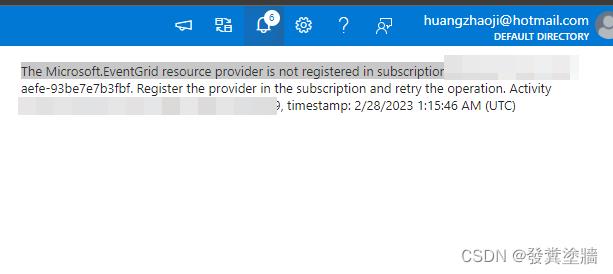

点击发布pipeline之后,我发现报了以下错误,如果首次使用,因为没有注册这个resource provider(事件触发器需要EventGrid resource provider),就要进行注册,参考这篇文字:Subscribe to events through portal

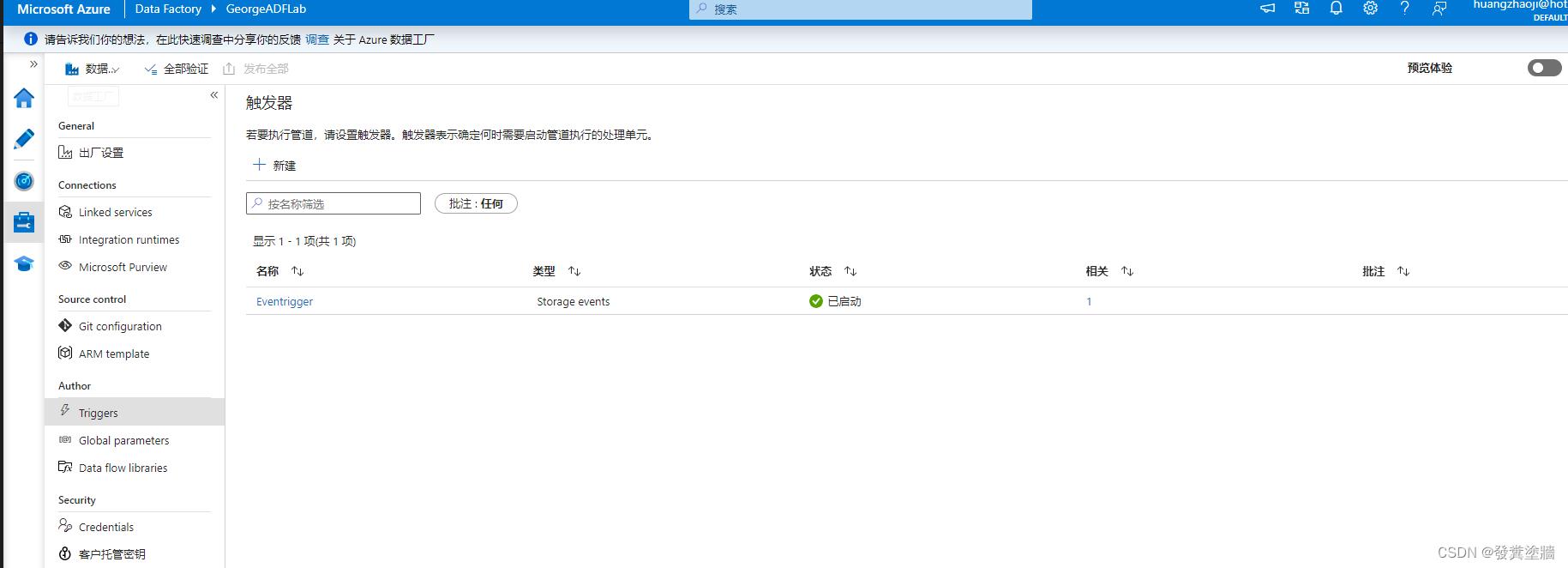

注册过后,可以正常发布。到管理页检查这个触发器是否成功创建并启用:

触发

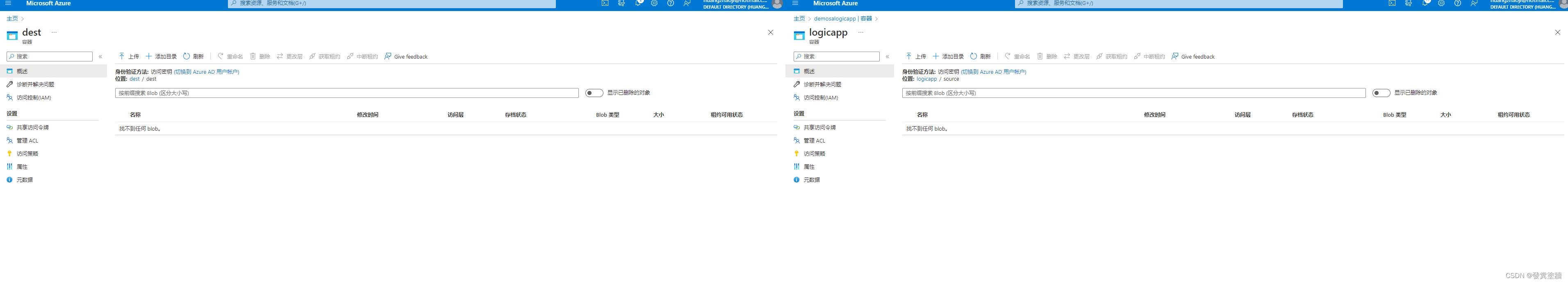

因为这里选择了对新建(上传)的blob进行触发,下面是触发前源和目标的情况:

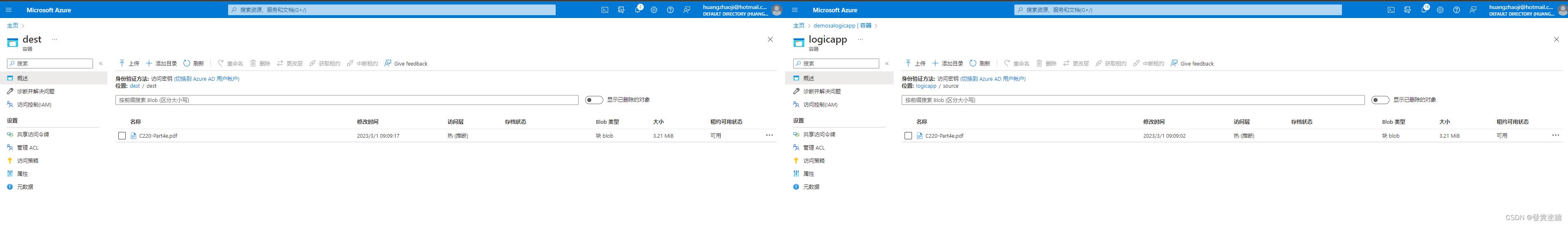

上传一个文件之后,再等十几秒刷新,可以看到文件已经自动同步到目标文件夹:

检查运行情况

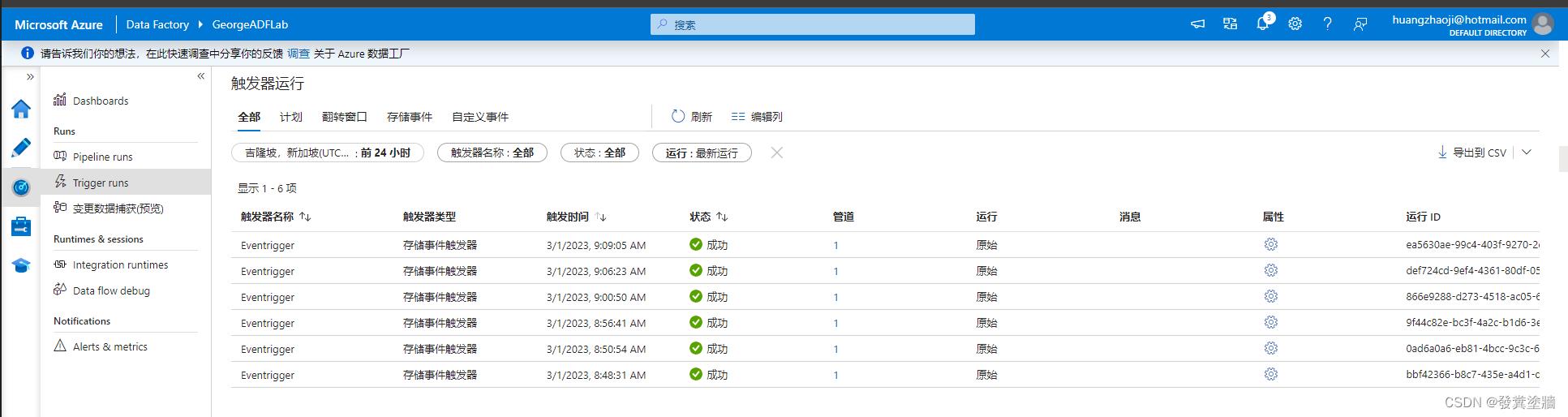

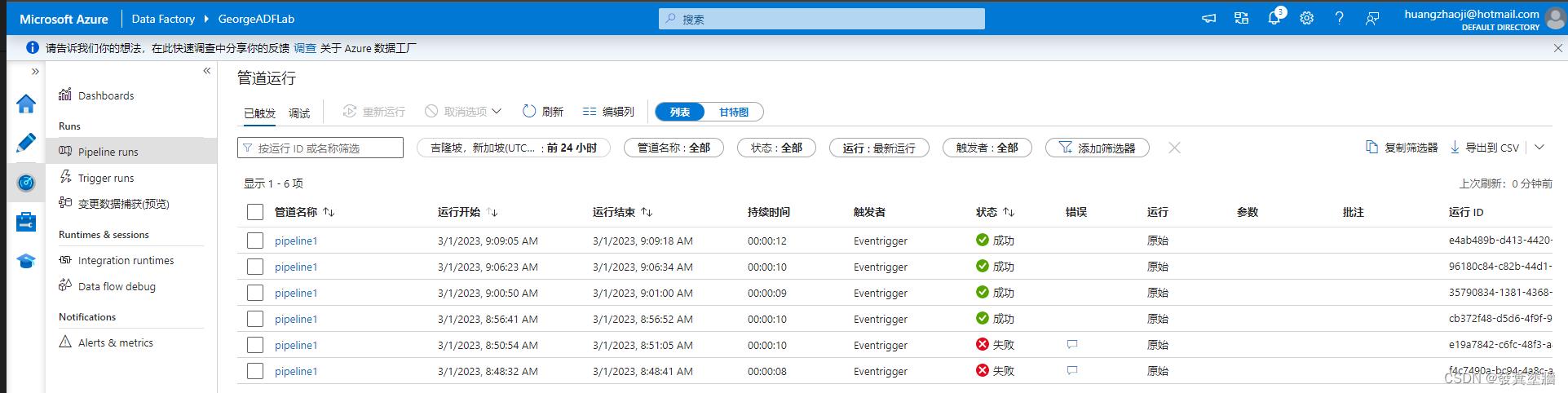

在达到我们目的之后,接下来检查运行情况:

忽略前几次调试带来的失败,可以看到触发器和pipeline都成功执行,达到了我们预期的结果。

小结

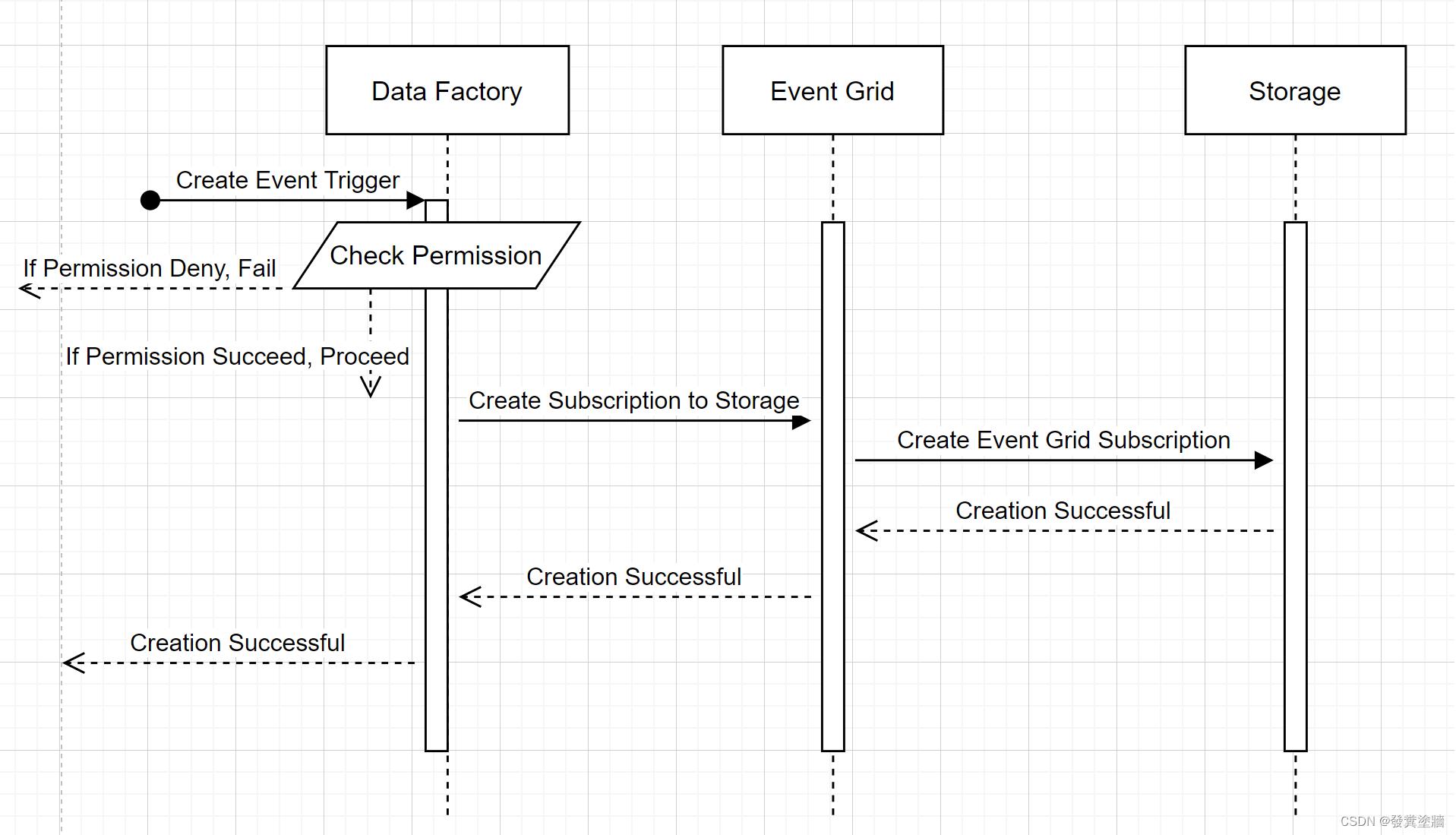

事件触发对文件的ETL 操作非常有用,可以通过对“新文件到达”或者“文件被删除、归档”等需求进行自动化处理。下面是官网中的操作流程图:

对于另外一个自定义事件触发,相对深入,暂时不过多研究,因为目前本人又有新任务需要去做研究,所以关于ADF 的触发前先到处为止。

以上是关于Azure 架构师学习笔记-Azure Data Factory -触发器详解-事件触发器的主要内容,如果未能解决你的问题,请参考以下文章