sparksql与hive整合

Posted Hello_BeautifulWorld

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了sparksql与hive整合相关的知识,希望对你有一定的参考价值。

参考文献:

http://blog.csdn.net/stark_summer/article/details/48443147

hive配置

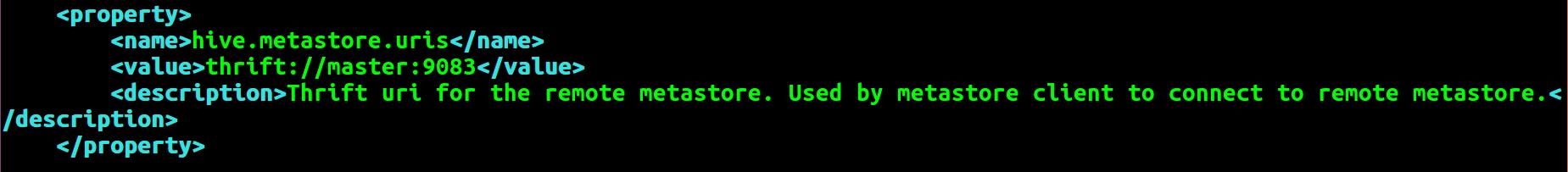

编辑 $HIVE_HOME/conf/Hive-site.xml,增加如下内容:

<property> <name>hive.metastore.uris</name> <value>thrift://master:9083</value> <description>Thrift uri for the remote metastore. Used by metastore client to connect to remote metastore.</description> </property>

启动hive metastore

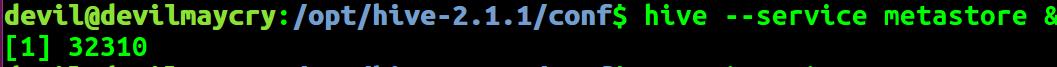

启动 metastore:

hive --service metastore &

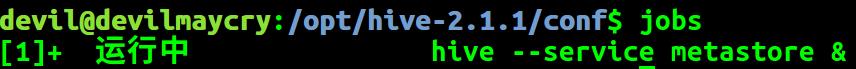

查看 metastore:

jobs

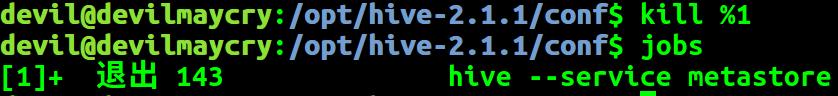

关闭 metastore:

$kill %1

kill %jobid,1代表job id

spark配置

将 $HIVE_HOME/conf/hive-site.xml copy或者软链 到 $SPARK_HOME/conf/ 将 $HIVE_HOME/lib/mysql-connector-java-5.1.12.jar copy或者软链到$SPARK_HOME/lib/

copy或者软链$SPARK_HOME/lib/ 是方便spark standalone模式使用

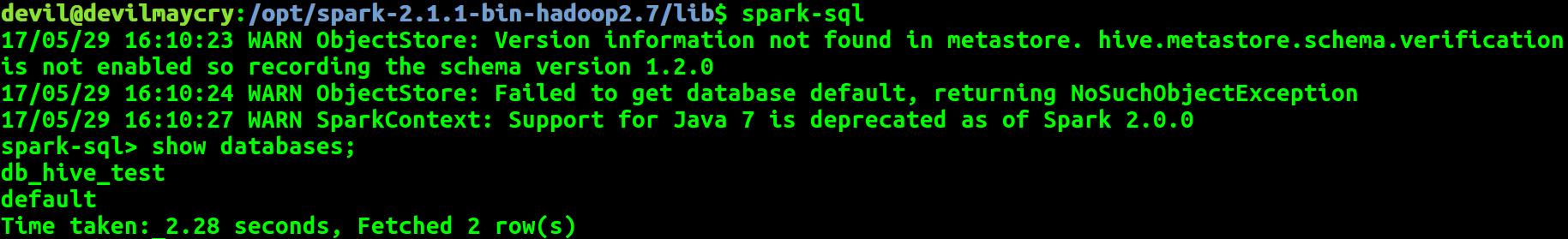

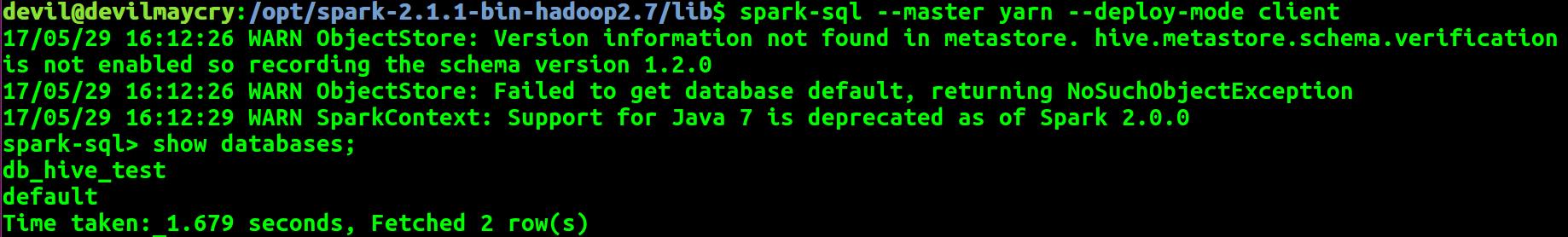

启动spark-sql

注:

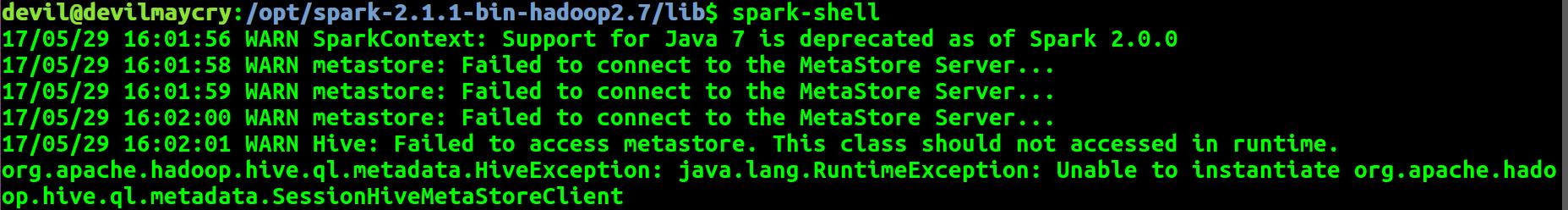

如果没有启动 hive metastore 则会:

以上是关于sparksql与hive整合的主要内容,如果未能解决你的问题,请参考以下文章