机器学习决策树(划分选择算法流程剪枝处理,连续值与缺失值处理)

Posted 夕述

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习决策树(划分选择算法流程剪枝处理,连续值与缺失值处理)相关的知识,希望对你有一定的参考价值。

决策树基于树结构来进行预测

决策树学习的目的是为了产生一棵泛化能力强,即处理未见示例能力强的决策树。

决策树学习的关键在于如何选择最优划分属性。一般而言,随着划分过程不断进行,我们希望决策树的分支结点所包含的样本尽可能属于同一类别,即结点的“纯度”(purity)越来越高。

划分选择

信息增益

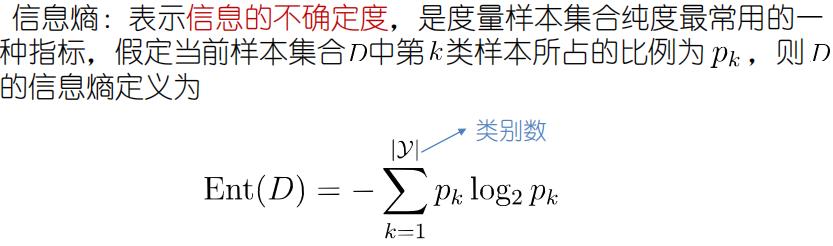

信息熵

信息熵越高,纯度越低

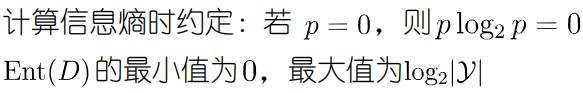

信息增益

一般而言,信息增益越大,则意味着使用属性 来进行划分所获得的“纯度提升”越大

信息增益对可取值数目较多的属性有所偏好

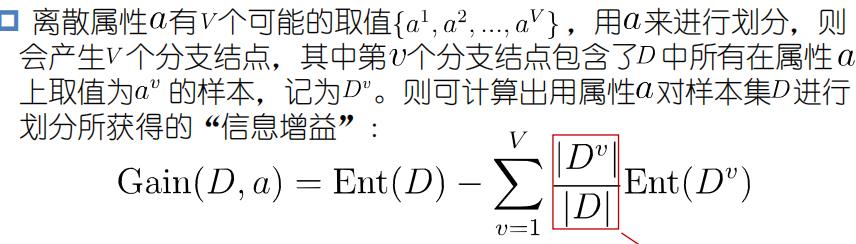

2. 增益率

增益率准则对可取值数目较少的属性有所偏好

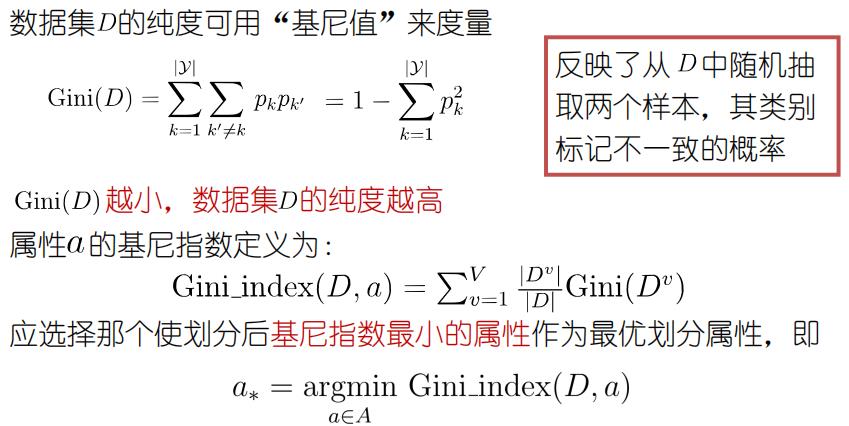

3. 基尼指数

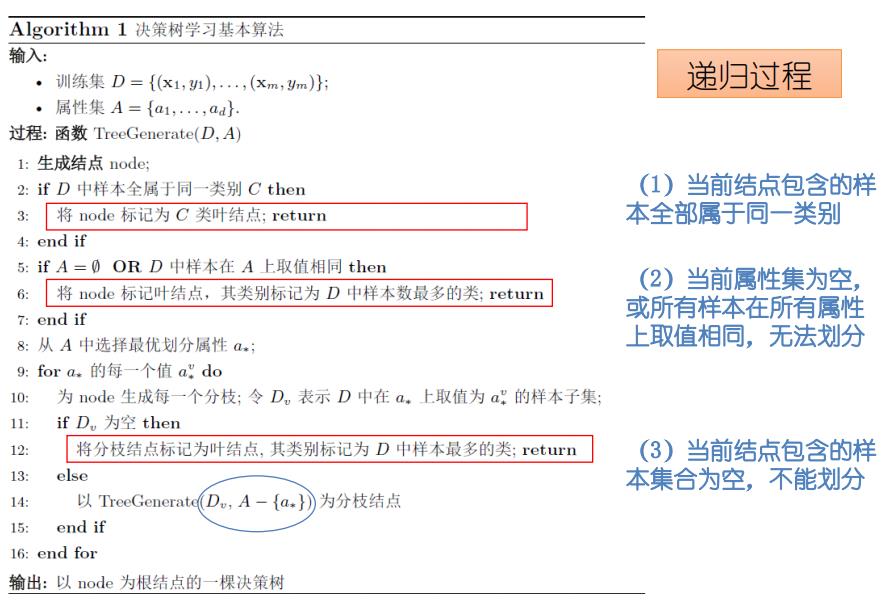

算法流程

一般的,决策树包含一个根结点、若干个内部结点和若干个叶结点。叶结点对应于决策结果,其他每个结点对应于一个属性测试;每个结点包含的样本集合根据属性测试的结果被分配到子结点中;根结点包含样本全集。从根结点到每个叶结点的路径对应了一个判定测试序列。

从根结点开始,对结点选择一个最优特征。由该特征的不同取值建立子结点,再对子结点递归地调用以上方法,直至(1)当前结点包含的样本全部属于同一类别(2)当前属性集为空,或所有样本在所有属性上取值相同,无法划分(3)当前结点包含的样本集合为空,不能划分。构建叶结点,最后每个子集都被分配到了叶结点上,即都有了明确的类,这样就生成了一棵决策树。

剪枝处理

为什么剪枝

可通过“剪枝”来一定程度避免因决策分支过多,以致于把训练集自身的一些特点当做所有数据都具有的一般性质而导致的过拟合。

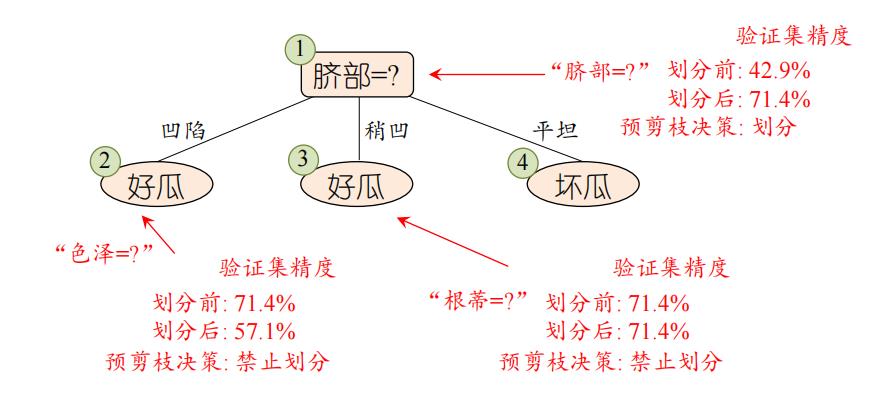

2. 预剪枝

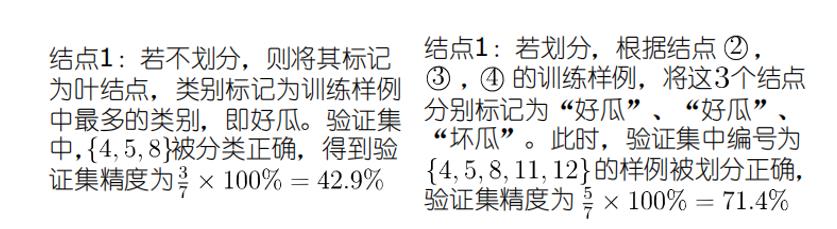

决策树生成过程中,对每个结点在划分前先进行估计,若当前结点的划分不能带来决策树泛化性能提升,则停止划分并将当前结点记为叶结点,其类别标记为训练样例数最多的类别。

优点

降低过拟合风险

显著减少训练时间和测试时间开销

缺点

欠拟合风险:有些分支的当前划分虽然不能提升泛化性能,但在其基础上进行的后续划分却有可能导致性能显著提高。预剪枝基于“贪心”本质禁止这些分支展开,带来了欠拟合风险

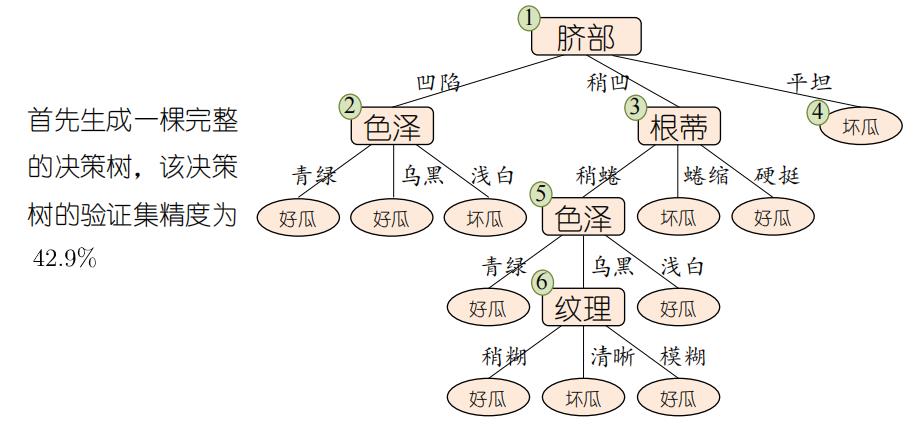

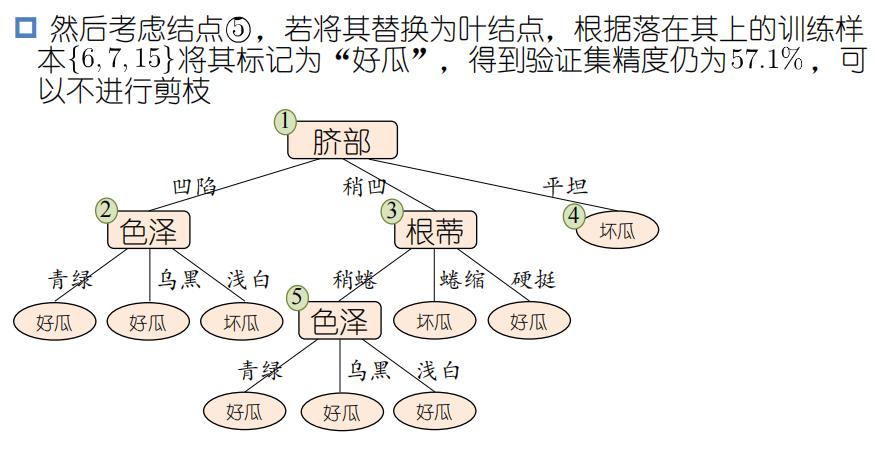

3. 后剪枝

先从训练集生成一棵完整的决策树,然后自底向上地对非叶结点进行考察,若将该结点对应的子树替换为叶结点能带来决策树泛化性能提升,则将该子树替换为叶结点。

优点

后剪枝比预剪枝保留了更多的分支,欠拟合风险小,泛化性能往往优于预剪枝决策树

缺点

训练时间开销大:后剪枝过程是在生成完全决策树之后进行的,需要自底向上对所有非叶结点逐一考察

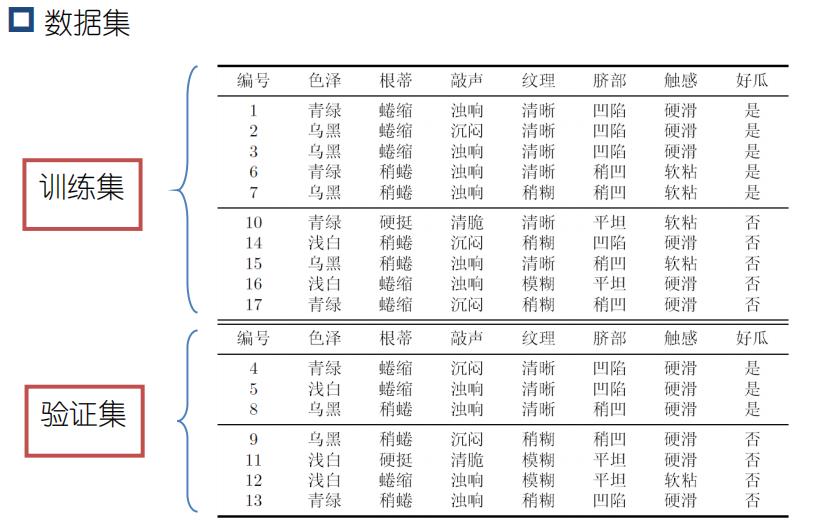

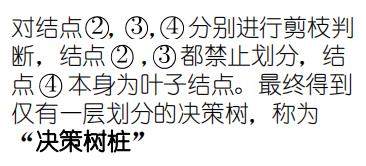

4. 例子

预剪枝

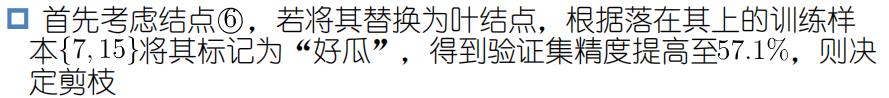

后剪枝

连续值与缺失值

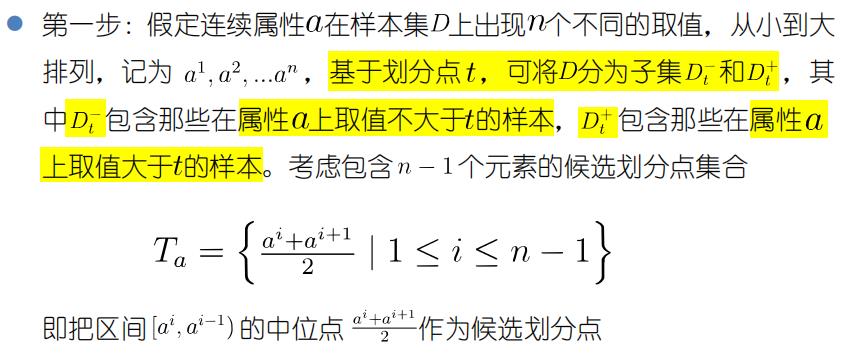

连续值处理

与离散属性不同,若当前结点划分属性为连续属性,该属性还可作为其后代结点的划分属性

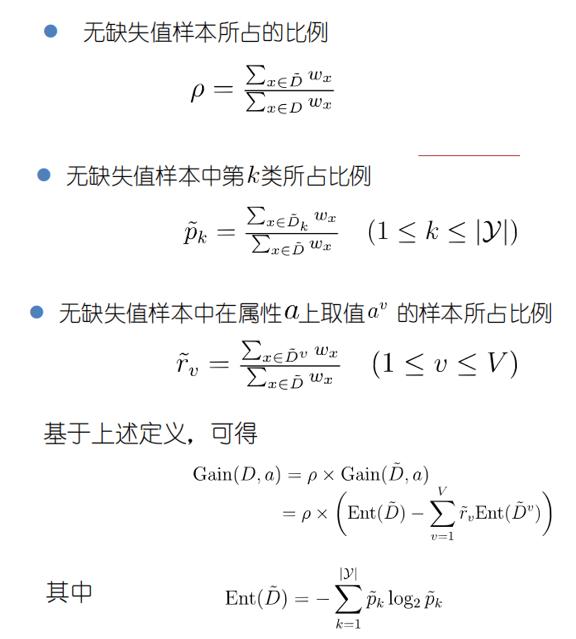

2. 缺失值处理

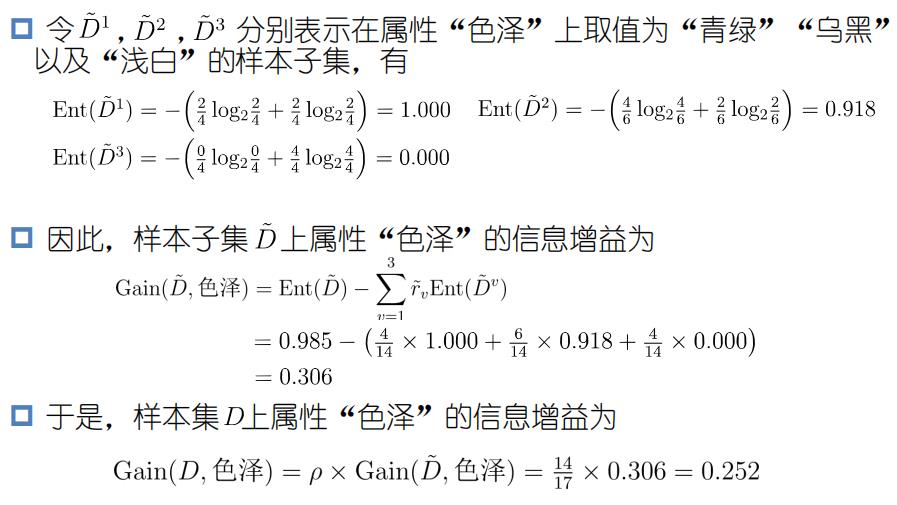

如何在属性缺失的情况下进行划分属性选择?

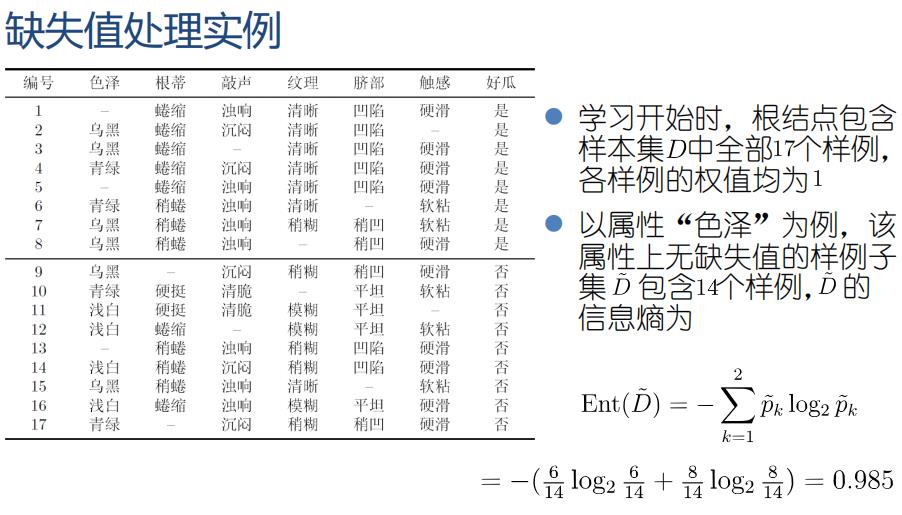

例子:

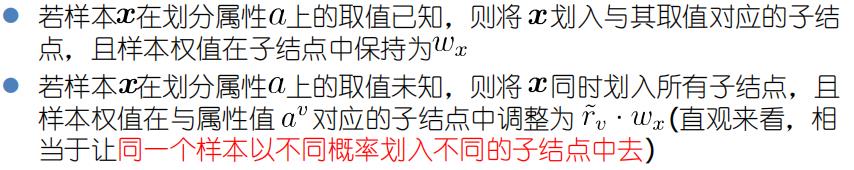

给定划分属性,若样本在该属性上的值缺失,如何对样本进行划分?

例子:

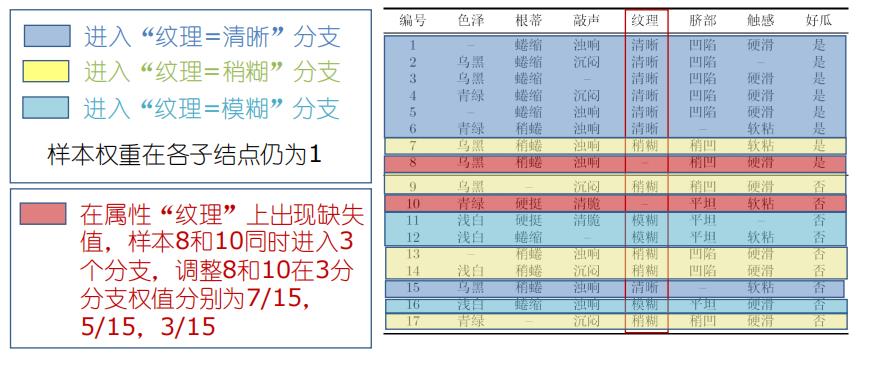

若划分属性选择为纹理:

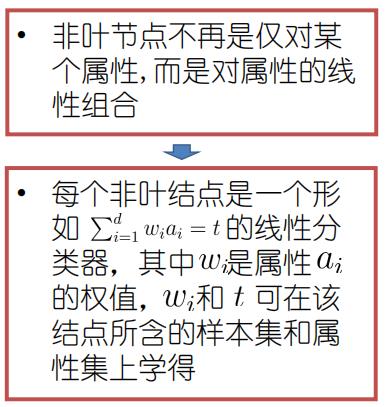

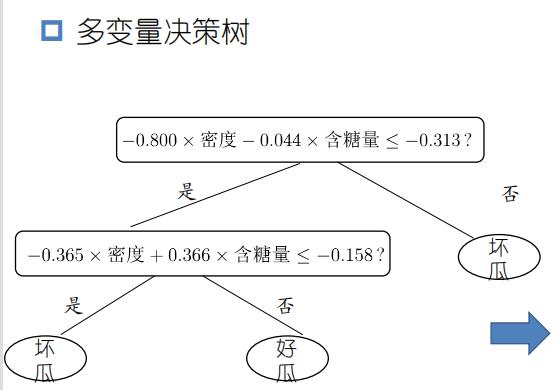

多变量决策树

以上是关于机器学习决策树(划分选择算法流程剪枝处理,连续值与缺失值处理)的主要内容,如果未能解决你的问题,请参考以下文章