论文解读:Dual Attention Networks for Multimodal Reasoning and Matching

Posted yealxxy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文解读:Dual Attention Networks for Multimodal Reasoning and Matching相关的知识,希望对你有一定的参考价值。

这是关于VQA问题的第八篇系列文章。本篇文章将介绍论文:主要思想;模型方法;主要贡献。有兴趣可以查看原文:Dual Attention Networks for Multimodal Reasoning and Matching

1,主要思想:

这篇文章依然从多模态推理上介绍,不同的是文章引入两种类型的DANs进行多模态推理,匹配以及分类。 推理模型允许可视化并在协作推理期间用文本注意机制互相关联。

2,模型架构DANs

本文提出了两种DANs结构来巩固视觉和文本注意机制:r-DAN用于多模式推理,m-DAN用于多模式匹配。先介绍这两种模型公共模块。

a.Input Representation

-

Image representation 图像特征: 提取出N个视觉特征

从19层VGGNet 或152层ResNet 中提取的。 我们首先将图像重新缩放到448×448并将它们输入到CNN中。 为了获得不同区域的特征向量,我们采用VGGNet(pool5)的最后一个池化层或ResNet最后一个池化层(res5c)的下面一层。

-

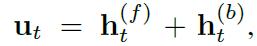

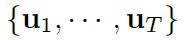

Text representation 特征: 使用双向LSTM来生成文本特征:提取出T个文本特征

b.Attention Mechanisms

- Visual Attention: 视觉注意旨在通过关注输入图像的某些部分来生成上下文向量。

第k步的attention过程如下:

解释:v(k)表示第k步,图像的某些部分来生成上下文向量,也就是attention的向量结果。m是一个直到步骤k-1之前已经参与的信息的存储器的向量编码。v_n是图像的特征。也就是V_Att代表一个函数,找到目前相关的视觉信息,用权重表示。引入了一个附加的权重矩阵P(k)图层,以便将视觉上下文向量嵌入到具有文本上下文向量的兼容空间中。具体如下:

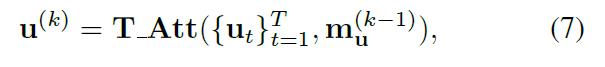

- Textual Attention: 文本注意力通过关注每个步骤中的输入句子中的特定单词来计算文本语境向量u(k)。和上面差不多,只是在最后不需要p(k)进行转换。

3,rDAN for Visual Question Answering

rDAN使用联合记忆,协作地执行视觉和文本注意机制,该联合记忆汇集先前的关注结果并引导下一个关注点。它适用于需要多模式推理的任务,例如VQA。

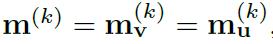

- 联合存储器向量m(k): VQA是一个代表性问题,需要对多模式数据进行联合推理。 为此目的,rDAN保持联合存储器向量m(k),其累积直到步骤k之前已经参与的视觉和文本信息。 递归更新如下:

- 初始化方法如下:

- 如上图:多步推导后预测结果

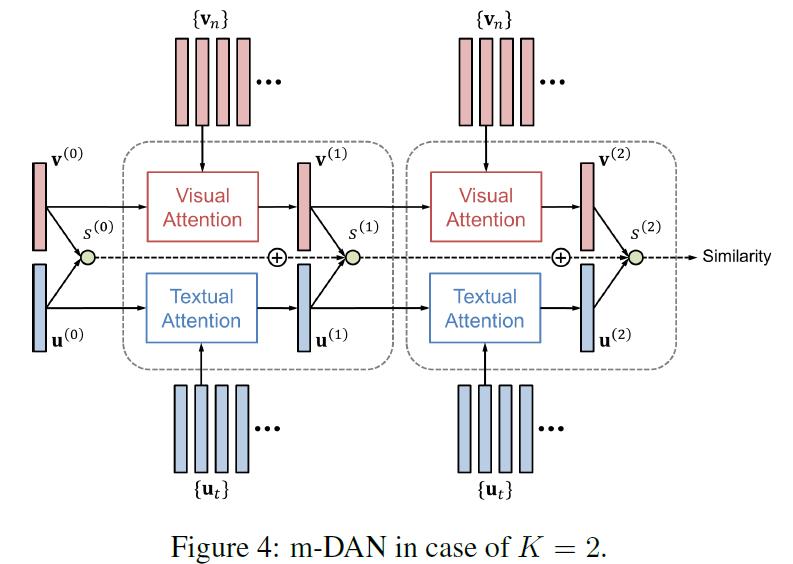

4,mDAN for ImageText Matching

m-DAN将视觉和文本注意模型与不同的记忆分开,但共同训练它们以捕捉图像和句子之间的共享语义。这种方法最终找到一个组合嵌入空间,这有助于高效的跨模式匹配和检索。

-

记忆向量: m-DAN共同学习视觉和文本注意模型,以捕捉两种模式之间的共享概念,但在推理时分离它们,以在嵌入空间中提供一般可比较的表示。 与使用联合记忆的r-DAN相反,m-DAN为视觉和文本注意保持单独的记忆向量:

-

初始化和之前一样:

-

图像与文本的相似度:

每一步的相似度:

K个步骤之后,给定图像和句子之间的最终相似度S变为:

-

损失函数:双向最大边缘排序损失,和是svm的损失函数很像。对于图像和句子(v,u)的每个正确对,我们另外采样负图像v-和负句子u-构造两个负对(v-,u)和(v,u-)。然后,损失函数变为:

-

将任意图像或句子通过连接其上下文向量嵌入到联合空间

当个对象向量化:其中 Zv和Zu分别是图像v和句子u的向量表示。 请注意,这些向量是通过视觉和文本关注的独立管道获得的,即学习到的共享概念从图像或句子本身揭示,而不是从图像 - 句子对中揭示。

联合空间中两个向量之间的相似性:通过它们的内积简单计算,例如, S(v,u)= Zv·Zu,它等于公式19中网络的输出。

5,主要贡献

- 提出了一个视觉和文字注意的组合框架,其中关键区域和单词共同地通过多个步骤定位。

- 提出的框架的两种变体被实现用于多模式推理和匹配,并被应用于VQA和图像文本匹配。

- 注意机制结果的详细可视化验证了我们的模型有效地注意给定任务的视觉和文本数据的重要部分。

以上是关于论文解读:Dual Attention Networks for Multimodal Reasoning and Matching的主要内容,如果未能解决你的问题,请参考以下文章