Atlas——数据治理工具的使用

Posted 想学习安全的小白

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Atlas——数据治理工具的使用相关的知识,希望对你有一定的参考价值。

一、启动Atlas

1、启动前置环境

- 启动Hadoop 集群

- 启动Zookeeper 集群

- 启动Kafka 集群

- 启动Hbase 集群

- 启动Solr 集群

2、启动Atlas服务

- 进入atlas的bin目录,命令:

cd /home/atlas/atlas/bin - 执行启动脚本,命令:

./atlas_start.py,等待2min

- 访问hadoop01的21000端口

- 使用默认账号登录,用户名:admin,密码:admin

二、初次使用时将Hive中元数据导入

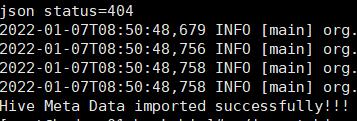

Atlas 提供了一个Hive 元数据导入的脚本,直接执行该脚本,即可完成Hive 元数据的

初次全量导入。

1、导入元数据

- 使用hadoop01机器,进入到hook-bin目录,命令:

cd /home/atlas/atlas/hook-bin - 执行里面的自动化导入脚本,命令:

./import-hive.sh - 中途需要输入密码,输入系统自带的账户:admin,密码:admin

- 等待系统提示成功

- 去Atlas网页,点击右上角的数据展示,验证导入成功

三、血缘关系功能使用

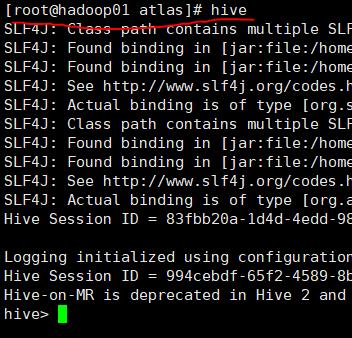

1、在hive上创建两个表

- 用hadoop01进入hive

- 创建一张订单事实表

CREATE TABLE dwd_order_info (

`id` STRING COMMENT '订单号',

`final_amount` DECIMAL(16,2) COMMENT '订单最终金额',

`order_status` STRING COMMENT '订单状态',

`user_id` STRING COMMENT '用户id',

`payment_way` STRING COMMENT '支付方式',

`delivery_address` STRING COMMENT '送货地址',

`out_trade_no` STRING COMMENT '支付流水号',

`create_time` STRING COMMENT '创建时间',

`operate_time` STRING COMMENT '操作时间',

`expire_time` STRING COMMENT '过期时间',

`tracking_no` STRING COMMENT '物流单编号',

`province_id` STRING COMMENT '省份ID',

`activity_reduce_amount` DECIMAL(16,2) COMMENT '活动减免金额',

`coupon_reduce_amount` DECIMAL(16,2) COMMENT '优惠券减免金额',

`original_amount` DECIMAL(16,2) COMMENT '订单原价金额',

`feight_fee` DECIMAL(16,2) COMMENT '运费',

`feight_fee_reduce` DECIMAL(16,2) COMMENT '运费减免'

) COMMENT '订单表'

ROW FORMAT DELIMITED FIELDS TERMINATED BY '\\t';

- 创建一张地区维度表

CREATE TABLE dim_base_province (

`id` STRING COMMENT '编号',

`name` STRING COMMENT '省份名称',

`region_id` STRING COMMENT '地区ID',

`area_code` STRING COMMENT '地区编码',

`iso_code` STRING COMMENT 'ISO-3166 编码,供可视化使用',

`iso_3166_2` STRING COMMENT 'ios-3166-2 编码,供可视化使用'

) COMMENT '省份表'

ROW FORMAT DELIMITED FIELDS TERMINATED BY '\\t';

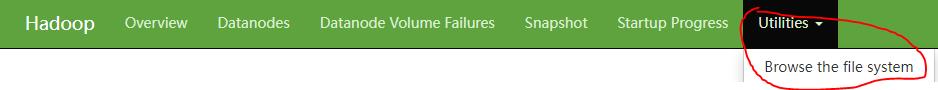

2、使用hive网页功能将数据上传进表中

- 访问hive网页,地址:

hadoop01ip:9870,点击Utilities下拉菜单的Browse the file system选项

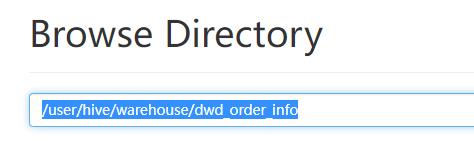

- 在搜索栏搜索

/user/hive/warehouse/dwd_order_info

- 点击右侧上传按钮将数据上传,数据下载地址.

- 或者进入hive中使用命令导入

#追加导入

load data local inpath '/home/atlas/1.txt' into table dwd_order_info;

#覆盖导入

load data local inpath '/home/atlas/1.txt' overwrite into table dwd_order_info;

3、根据订单事实表和地区维度表,求出每个省份的订单次数和订单金额

- 创建查询结果表

CREATE TABLE `ads_order_by_province` (

`dt` STRING COMMENT '统计日期',

`province_id` STRING COMMENT '省份id',

`province_name` STRING COMMENT '省份名称',

`area_code` STRING COMMENT '地区编码',

`iso_code` STRING COMMENT '国际标准地区编码',

`iso_code_3166_2` STRING COMMENT '国际标准地区编码',

`order_count` BIGINT COMMENT '订单数',

`order_amount` DECIMAL(16,2) COMMENT '订单金额'

) COMMENT '各省份订单统计'

ROW FORMAT DELIMITED FIELDS TERMINATED BY '\\t';

- 将查询结果装入结果表中

insert into table ads_order_by_province

select

'2021-08-30' dt,

bp.id,

bp.name,

bp.area_code,

bp.iso_code,

bp.iso_3166_2,

count(*) order_count,

sum(oi.final_amount) order_amount

from dwd_order_info oi

left join dim_base_province bp

on oi.province_id=bp.id

group by bp.id,bp.name,bp.area_code,bp.iso_code,bp.iso_3166_2;

4、查看结果表的血缘关系

- 查看总体关系

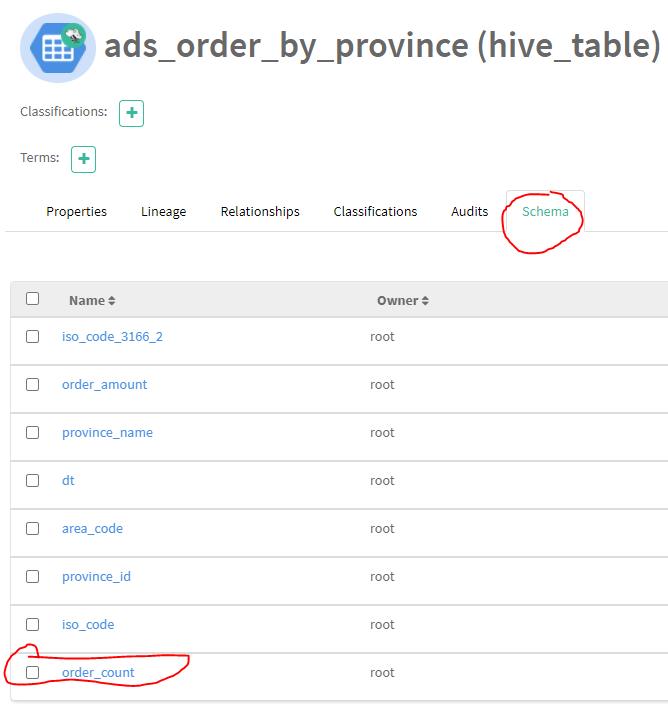

5、查看表中某一字段的血缘关系

- 点击表的Schema

- 点击某一字段

以上是关于Atlas——数据治理工具的使用的主要内容,如果未能解决你的问题,请参考以下文章