Hadoop基础学习笔记

Posted 鄙人阿彬

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop基础学习笔记相关的知识,希望对你有一定的参考价值。

告警和日志信息监控

目录

步骤一:查看内核及公共消息日志(/var/log/messages)。

步骤四:查看邮件系统日志:/var/log/maillog。

实验任务二: 在 Hadoop MapReduce Jobs 中查看日志信息

Hadoop中每一个Mapper和Reducer都有以下三种类型的日志:

stdout-System.out.println()的输出定向到这个文件。

stderr-System.err.println()的输出定向到这个文件。

注意:需先启动jobhistory进程启动: 在hadoop用户下执行

通过 Hadoop 的用户界面查看日志信息,使用浏览器访问 http://master:50070,点击Utilities-->Logs

使用hadoop用户登录,并切换到/opt/module/hadoop/logs目录,执行ll命令,查看日志列表。

Hbase提供了Web用户界面对日志文件的查看,使用浏览器访问http://master:60010,显示HBase的web主界面

Hive日志存储的位置为/tmp/hadoop,在命令行的模式下,切换到该目录,执行ll命令,查看Hive的日志列表,显示如下

Hive的日志文件存储在/tmp/hadoop目录下,切换到该目录,并执行命令ll,显示如下。

Stderr(标准错误),该标准IO流通过预定义文件指针 stderr 加以引用,且该流引用的文件与文件描述符 STDERR_FILENO 所引用的相同

实验一:查看大数据平台日志信息

- 实验任务一:查看大数据平台主机日志

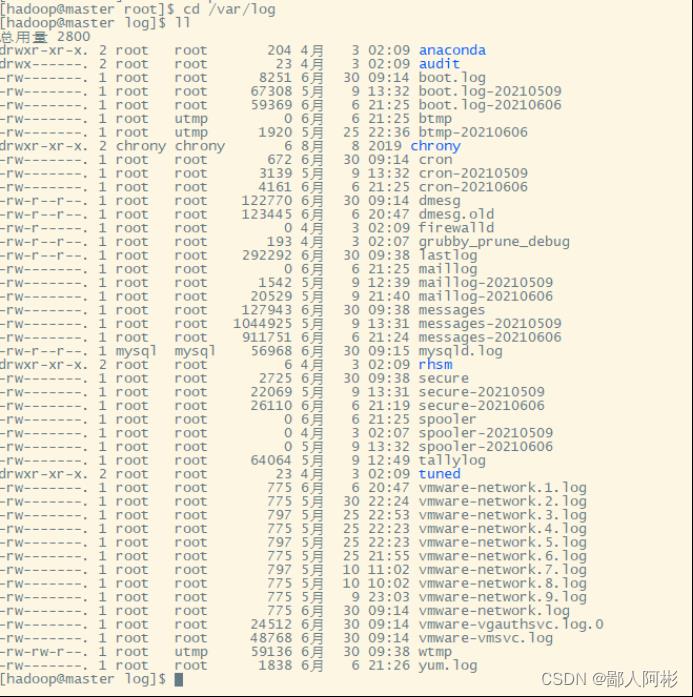

使用hadoop用户登录Linux主机,切换到/var/log目录,执行ll命令查询该录所有日志文件。

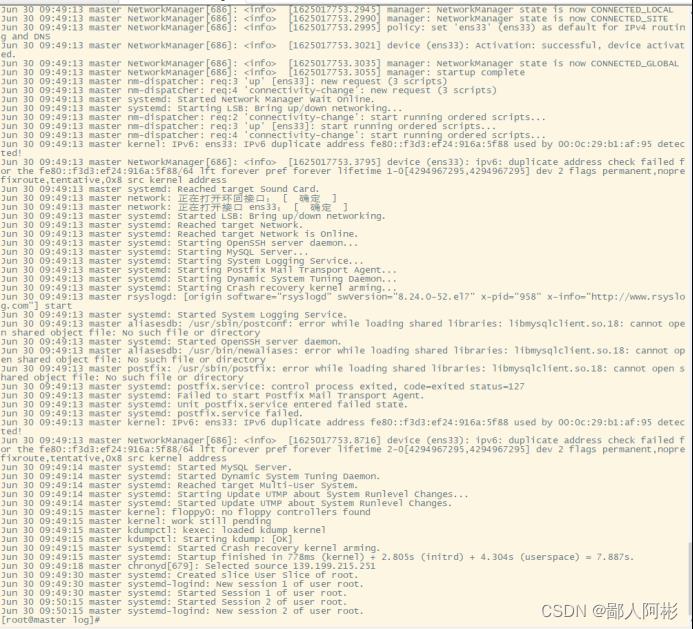

步骤一:查看内核及公共消息日志(/var/log/messages)。

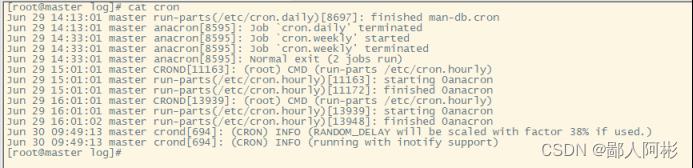

步骤二:查看计划任务日志/var/log/cron。

该文件会记录crontab计划任务的创建、执行信息。执行cat cron命令,显示如下:

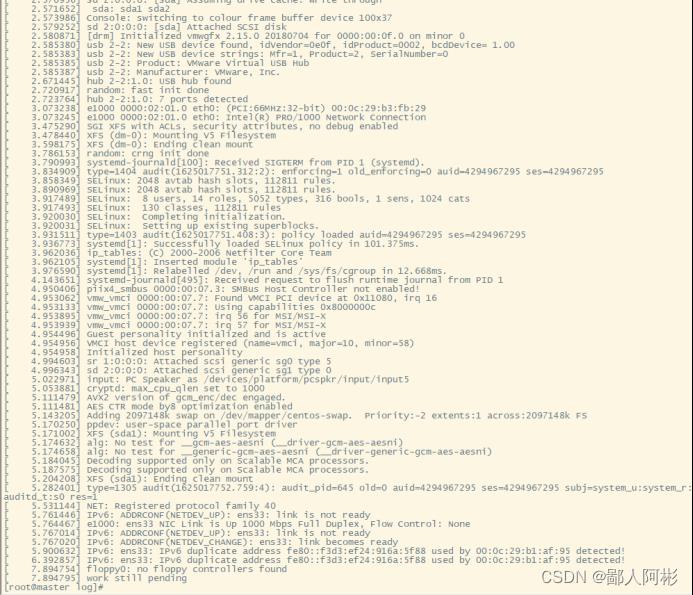

步骤三:查看系统引导日志/var/log/dmesg。

该文件记录硬件设备信息(device)属纯文本,也可以用dmesg命令查看。由于文件内容比较多,截取了一部分的内容,显示如下:

步骤四:查看邮件系统日志:/var/log/maillog。

tail -f /var/log/maillog查看电子邮件的活动

步骤五:查看用户登录日志。

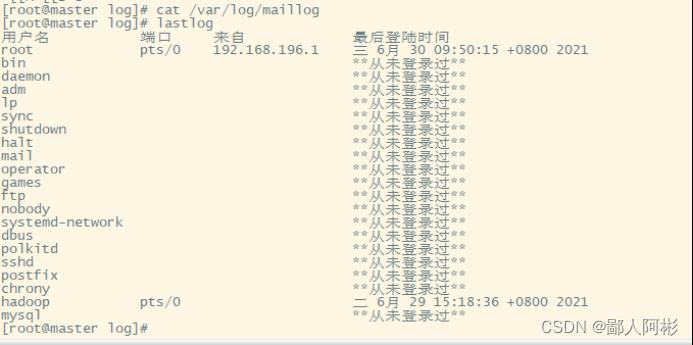

lastlog 列出所有用户最近登录的信息

lastlog引用的是/var/log/lastlog文件中的信息,包括登录名、端口、最后登录时间等。

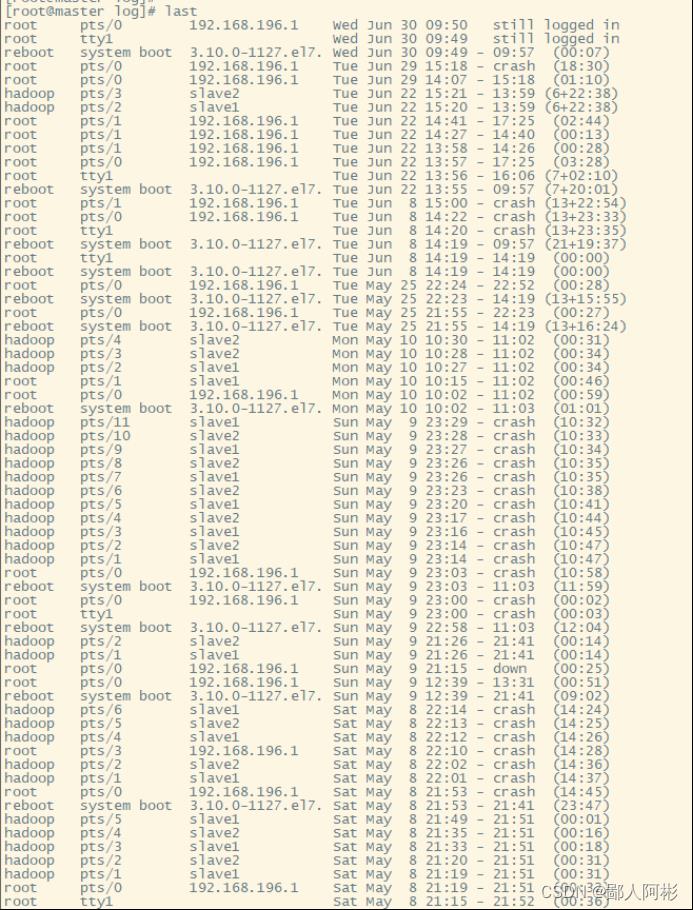

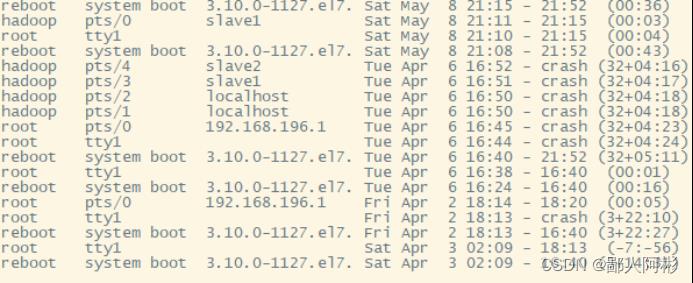

last 列出当前和曾经登入系统的用户信息

- 执行命令last

通过以上的结果显示,自4月3日以来,系统重启了17次,最近一次是root于6月 30日09:50登录,现在仍在登录状态。

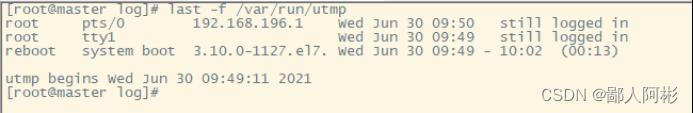

2、切换到root用户,使用命令last -f /var/run/utmp,查看utmp文件

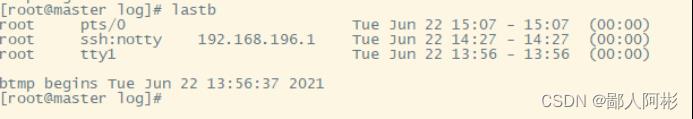

3、lastb 列出失败尝试的登录信息 lastb和last命令功能完全相同,只不过它默认读取的是/var/log/btmp文件的信息。

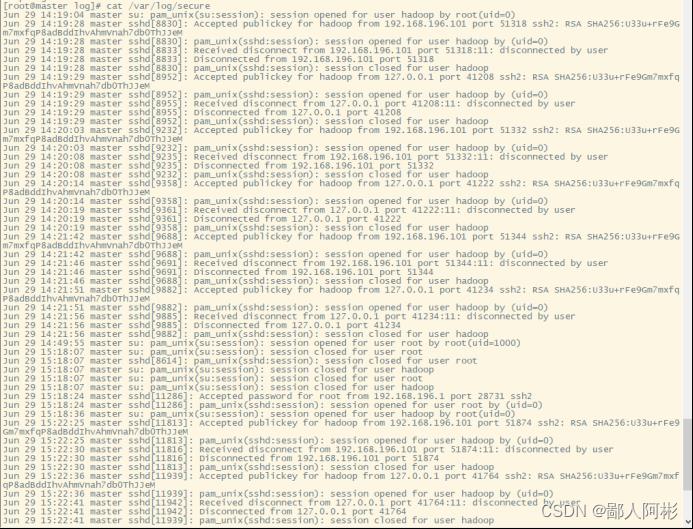

4、通过Linux 系统安全日志文件/var/log/secure 可查看SSH登录行为,该文件读取需要root权限。切换为root用户,执行cat /var/log/secure 命令查看服务器登陆行为

实验任务二: 在 Hadoop MapReduce Jobs 中查看日志信息

Hadoop中每一个Mapper和Reducer都有以下三种类型的日志:

stdout-System.out.println()的输出定向到这个文件。

stderr-System.err.println()的输出定向到这个文件。

syslog-log4j的日记输出定向到这个文件。在作业执行中出现和没有被处理的所有异常的栈跟踪信息会在syslog中显示。 在浏览器地址栏中输入 http://master:19888/jobhistory,将显示关于作业的摘要信息,如图15-1所示。

注意:需先启动jobhistory进程启动: 在hadoop用户下执行

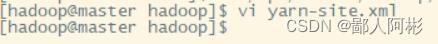

在 yarn-site.xml 中加入以下配置启动日志聚合

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

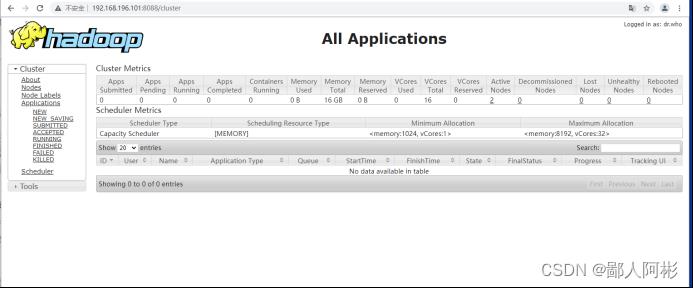

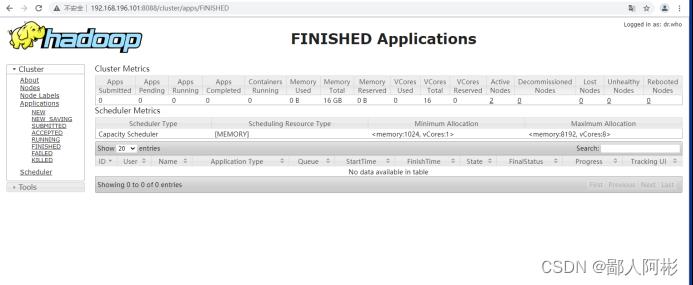

实验任务三:通过用户界面查看 Hadoop 日志

FINISHED”显示已经完成运行的作业

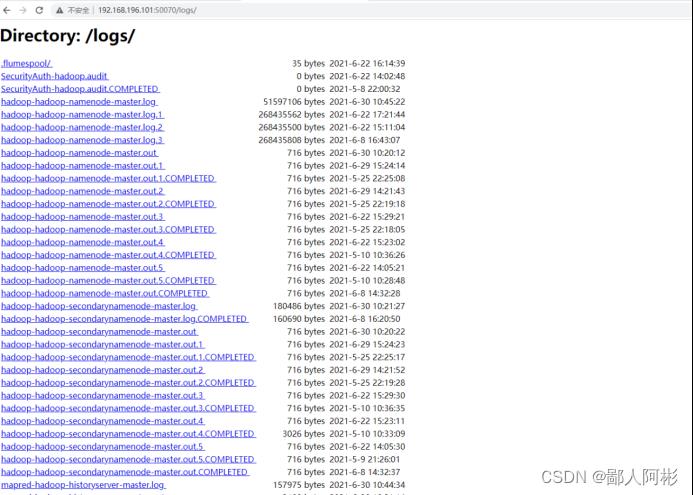

通过 Hadoop 的用户界面查看日志信息,使用浏览器访问 http://master:50070,点击Utilities-->Logs

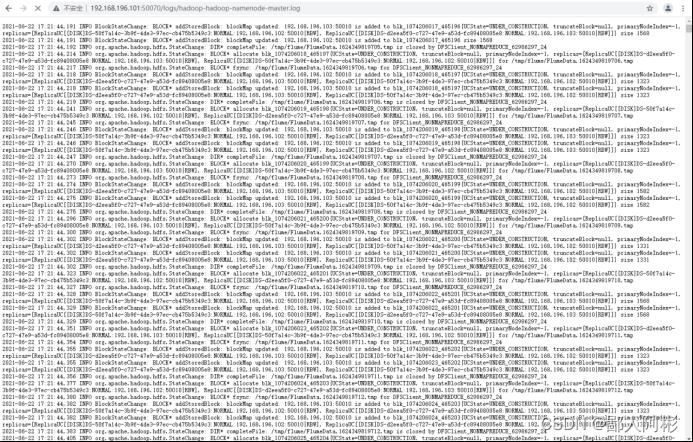

点击相应的日志文件即可查看日志的内容。如点击查看hadoop-hadoop-namenode-master.log日志文件

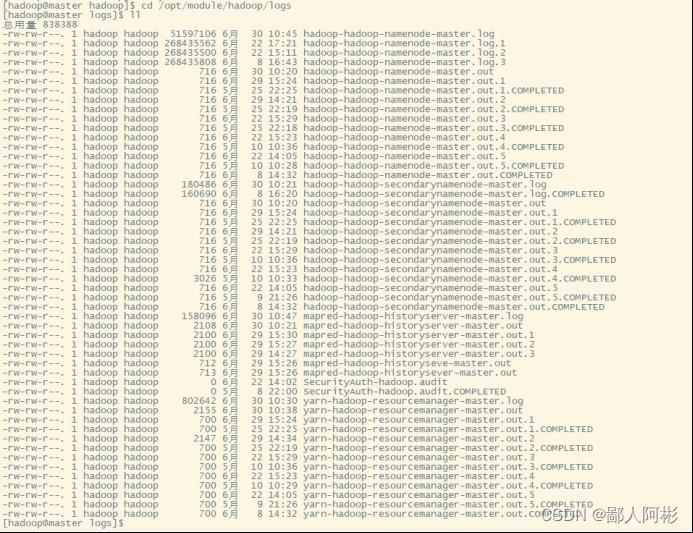

实验任务四:通过命令查看 Hadoop 日志

可以通过与命令行交互的的方式获取Hadoop的日志文件列表

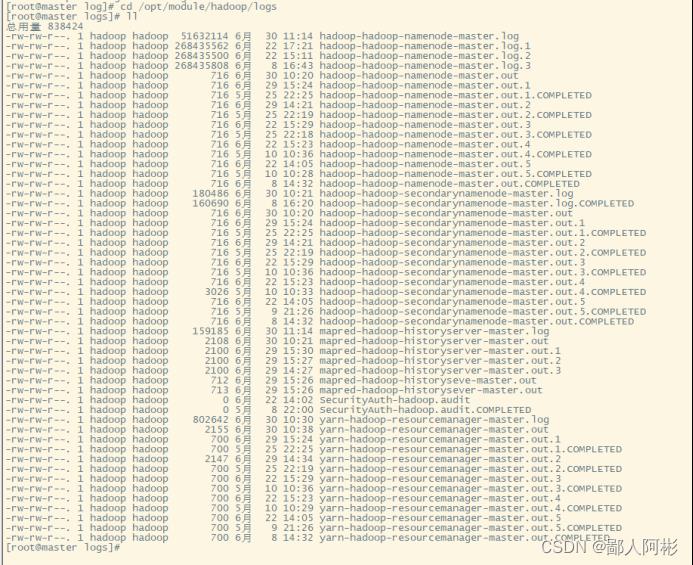

使用hadoop用户登录,并切换到/opt/module/hadoop/logs目录,执行ll命令,查看日志列表。

获知日志文件的大小和Hadoop中所属组件的日记文件;yarn-hadoop-resourcemanager-master.out文件被切割为五个文件,并且后面的数字越大,代表该文件越旧,符合Hadoop日志文件切割原则

实验任务五:查看 HBase 日志

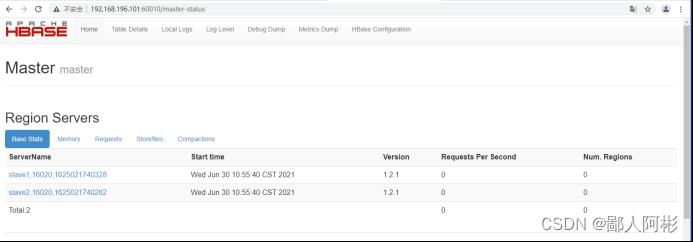

Hbase提供了Web用户界面对日志文件的查看,使用浏览器访问http://master:60010,显示HBase的web主界面

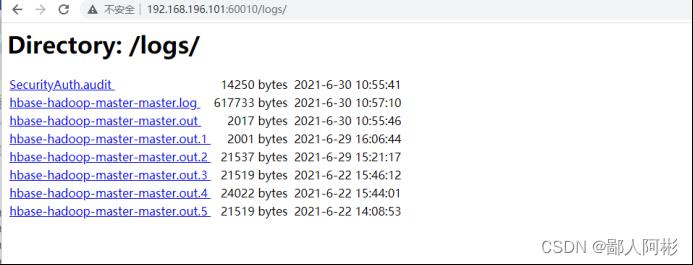

点击“Local Logs”菜单打开HBase的日志列表,如图所示。

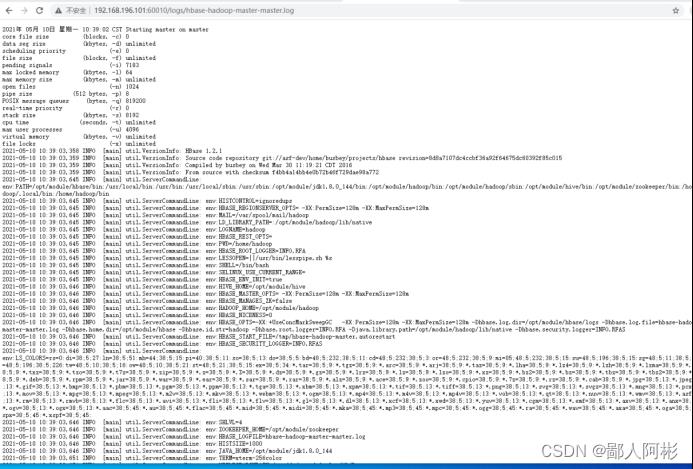

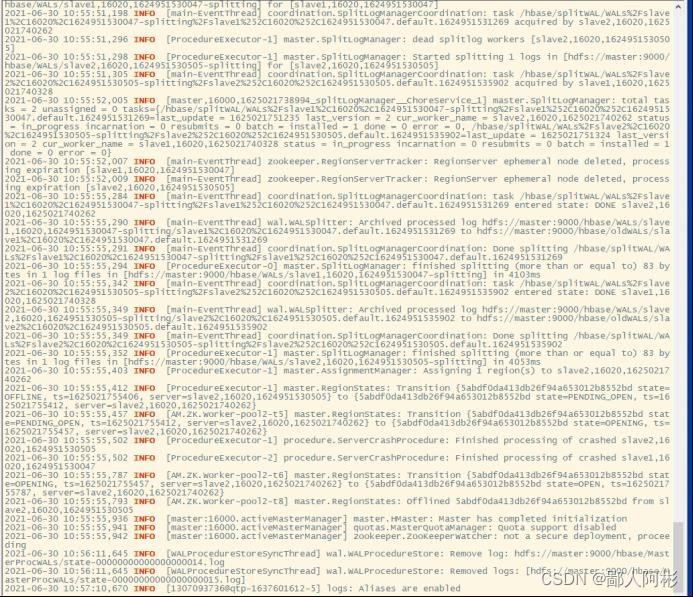

点击其中一条链接来访问相应的日志信息,如hbase-hadoop-master-master.log日志内容如图

实验任务六:查看 Hive 日志

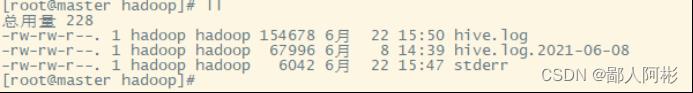

Hive日志存储的位置为/tmp/hadoop,在命令行的模式下,切换到该目录,执行ll命令,查看Hive的日志列表,显示如下

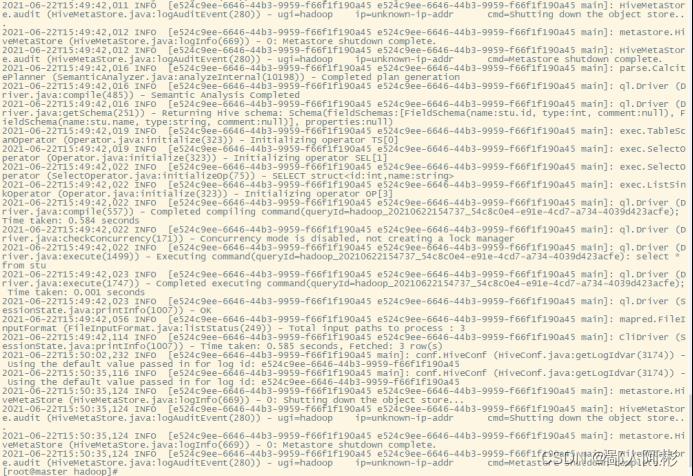

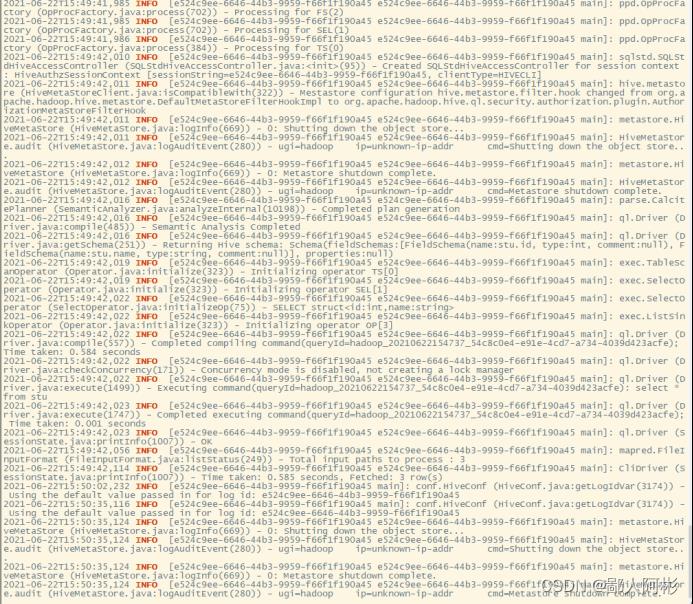

使用cat命令查看hive.log日志文件,显示如下:

实验二 查看大数据平台告警信息

实验任务一:查看大数据平台主机告警信息

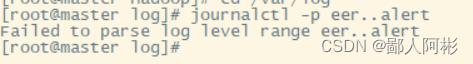

Linux 操作系统的的日志文件存储在/var/log 文件夹中。我们可以利用日志管理工具 journalctl查看Linux操作系统主机上的告警信息. 切换到/var/log文件夹,执行命令journalctl -p err..alert查询系统错误告警信息,显示如下:

实验任务二:查看 Hadoop 告警信息

Hadoop 的日志主要是存在/opt/module/hadoop/logs 文件夹中,而日志文件包含 Hadoop各组件的状态和告警信息。切换到/opt/module/hadoop/logs目录,文件列表如下:

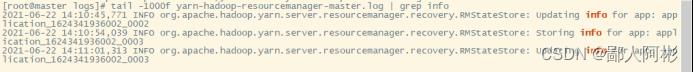

查看某个日志文件中包含告警信息的行,然后将这些行显示出来,如查询ResourceManager 日记最新 1000 行且包含“info”关键字的告警信息,执行命令 tail -1000f yarn-hadoop-resourcemanager-master.log | grep info,结果显示如下

实验任务三:查看 HBase 告警信息

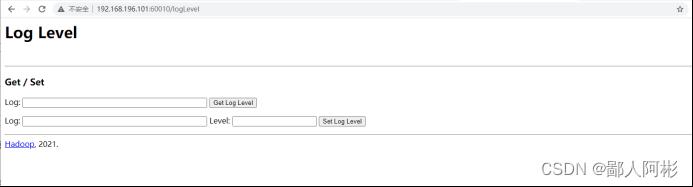

步骤一:变更日志告警级别在 HBase 的 Web 用户界面提供了日志告警级别的查询和设置功能。在浏览器中访问 http://master:60010/logLevel页面

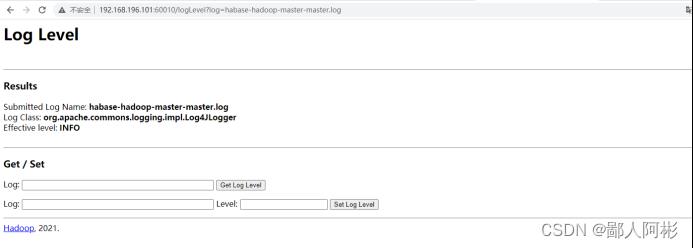

查询某个日志的告警级别,输入该日志名,点击“Get Log Level”按钮,显示该日志的告警级别。如查询日志文件 habase-hadoop-master-master.log 的告警级别,如图 所示。

结果显示,日志文件habase-hadoop-master-master.log的告警级别为INFO

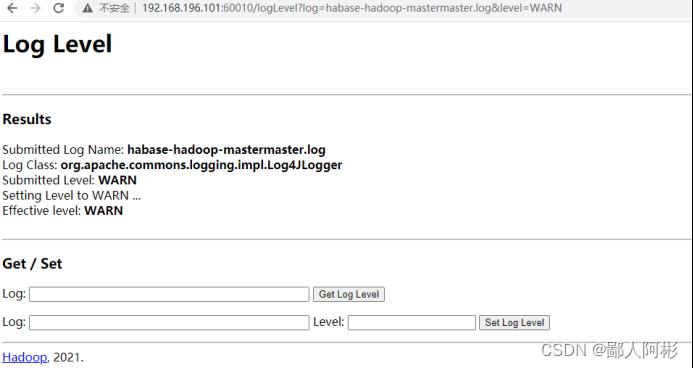

将该日志告警级别调整为 WARN,则在第二个框中输入 Log:habase-hadoop-mastermaster.log,Level:WARN,点击“Set Log Level”按钮,结果如图

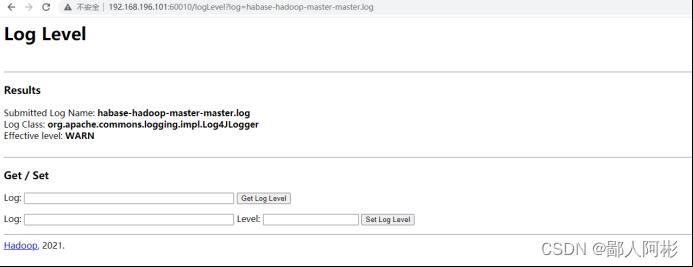

再次查询该日志文件的级别

结果显示,habase-hadoop-master-master.log日志告警级别已变更为WARN级别

步骤二:查询日志告警信息

HBase的日志文件存储在/opt/module/hbase/logs目录中,切换到该目录下,查看 hbase-hadoop-master-master.log 文件的“INFO”告警信息, 执行命令tail -100f hbasehadoop-master-master.log |grep INFO,结果显示如下

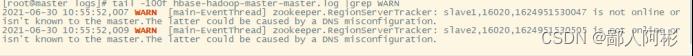

查看 hbase-hadoop-master-master.log 文件的“WARN”级别告警信息, 执行命令tail -100f hbase-hadoop-master-master.log |grep WARN,结果显示如下。

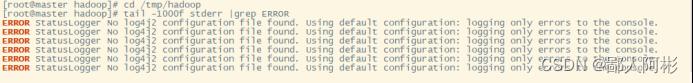

实验任务四:查看 Hive 告警信息

Hive的日志文件存储在/tmp/hadoop目录下,切换到该目录,并执行命令ll,显示如下。

Stderr(标准错误),该标准IO流通过预定义文件指针 stderr 加以引用,且该流引用的文件与文件描述符 STDERR_FILENO 所引用的相同

以上是关于Hadoop基础学习笔记的主要内容,如果未能解决你的问题,请参考以下文章