论文笔记:COST: CONTRASTIVE LEARNING OF DISENTANGLEDSEASONAL-TREND REPRESENTATIONS FORTIME SERIES FOREC

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文笔记:COST: CONTRASTIVE LEARNING OF DISENTANGLEDSEASONAL-TREND REPRESENTATIONS FORTIME SERIES FOREC相关的知识,希望对你有一定的参考价值。

ICLR 2022

1 前言介绍

- 表征学习(对比学习)+时间序列预测

- 首先学习时间序列解耦的representation

- 然后进行回归任务的精调

- 对比学习CoST包含时域和频域的contrastive loss

- ——>学习趋势和周期性representation

- 传统的时间序列预测模型将特征表示学习和预测任务放在一块

- 迭代很多非线性层来同时进行特征提取和预测回归任务

- 但这样的方式可能会导致模型过拟合,提取到数据中多余的噪声信息

- ——>这篇论文提出了利用解耦的(disentangled)周期和趋势之间结构的特征表达,来建模时间序列

2 时间序列的周期性和趋势

是一个有m个观测信号,T长度的时间序列。

是一个有m个观测信号,T长度的时间序列。

给定可视窗口h,目标是预测接下来的k步时间片

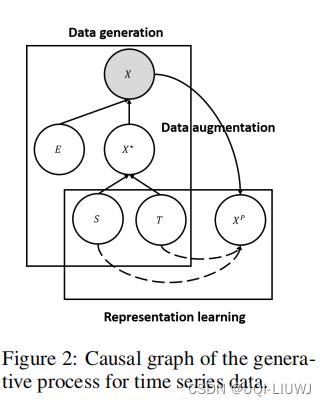

这篇论文的思路是,不把特征学习和预测任务同时在g()函数中实现。论文主要关注如何学习特征表示。也即如何学习X的非线性特征表示V=f(X),其中

之后可以将最后的Vh作为下游预测任务的输入

2.1 周期和趋势解耦的特征学习

- 复杂的数据往往是由多个源的数据共同组成的

- ——>一个好的特征表示可以解耦这多个可解释的源

- 如果不能解耦的话,可能会学到冗余的特征

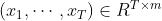

- 一个观测到的时间序列X可以看成由误差项E和无误差项X*组成

- X*由周期S和趋势T组成

- 由于E不可预测,所以最优的预测是把X*找出来(之前的工作是直接找X,这就会导致捕捉到冗余的信息,以及过拟合)

- 周期和趋势单元是相互独立的,他们不会影响到对方

- 所以即使周期和趋势中的一个发生了改变,另一个是不会受到影响的

- ——>周期和趋势可以独立地进行学习

- 误差E是不会影响无误差项的

- 即P(X*|T,S)和E无关

- 这里由于X*是未知的,所以作者使用对比学习

- 在误差项E上进行数据增强,得到不同的

- ——>学到不随误差项而变化的S和T的表示

- 在误差项E上进行数据增强,得到不同的

3 周期-趋势对比学习

目标是学习时间序列的解耦周期-趋势表征

,其中

,其中

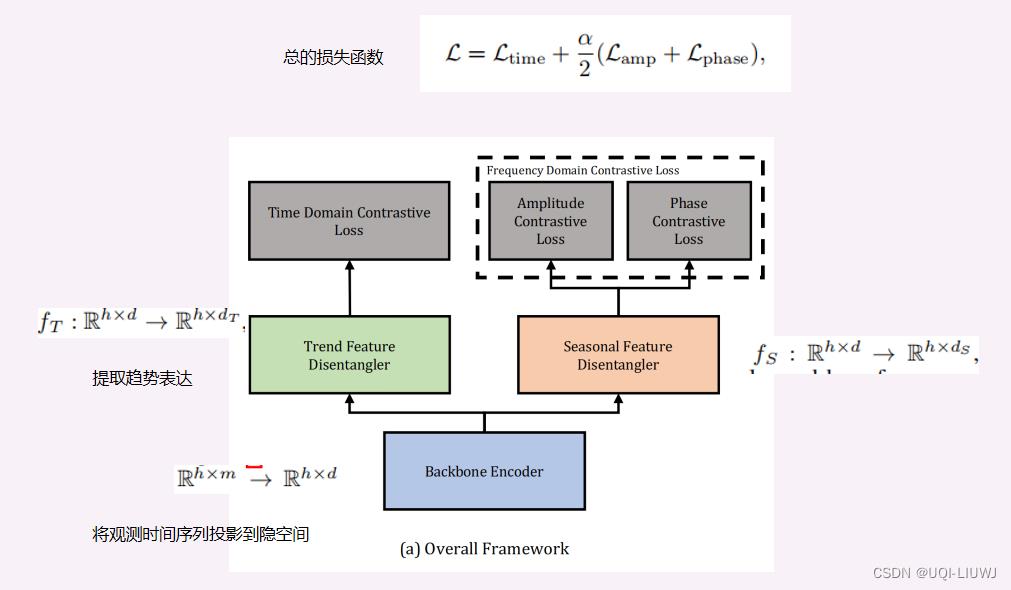

(α这里是一个平衡趋势表征和周期性表征的超参数)

3.1 趋势表征学习

- 自回归过滤是一种提取趋势的方法,但是问题在于,time-lag取多大呢?

- 太小——欠拟合

- 太大——过拟合+参数过多

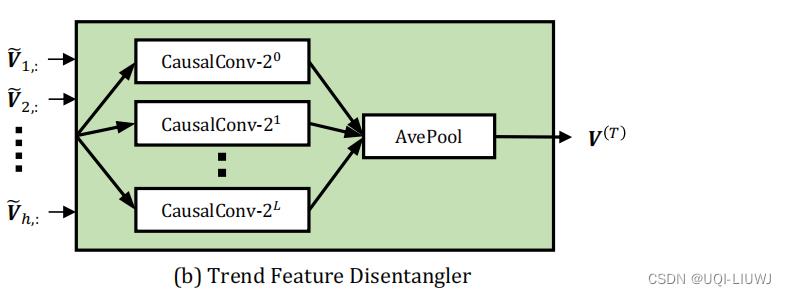

3.1.1 趋势特征提取器

- 这里使用了多个自回归过滤混合的方式,以自动学习合适的time-lag

- TFD由L+1个自回归过滤器组成

向下取整

向下取整 - 每一个CausalConv都是一个1维卷积,输入的channel数为d,输出的channal数为

- 第i个CausalConv的核大小是

-

-

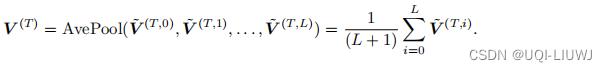

- 最后,是一个平均池化,得到最终的趋势表征

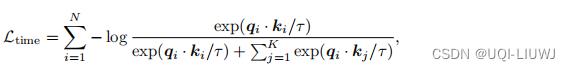

3.1.2 时域对比学习误差项

这里使用了MOCO的对比学习思路

(K=N-1)

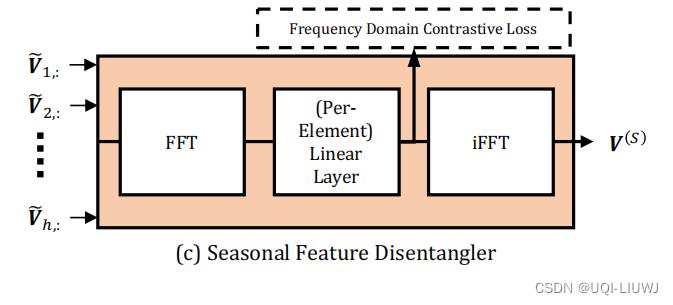

3.2 周期表征学习

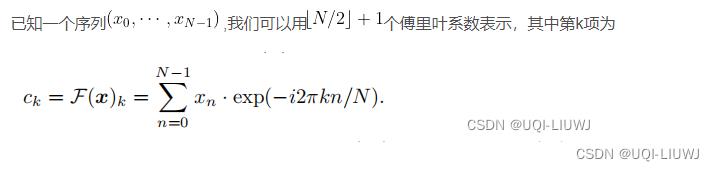

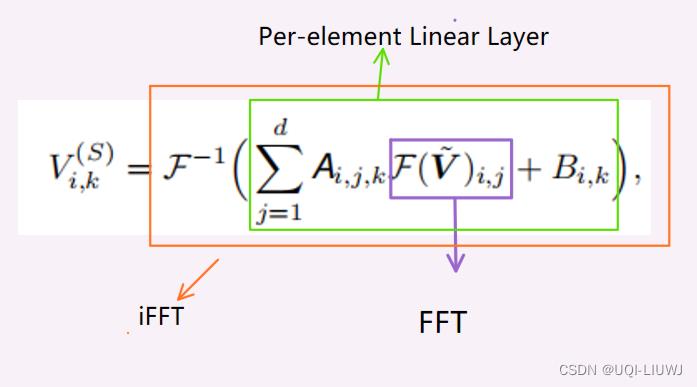

3.2.1 周期特征提取器

FFT:把时域转换至空域

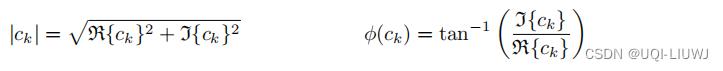

其中振幅和相位可以分别表示为:

最终得到的周期性表征为:

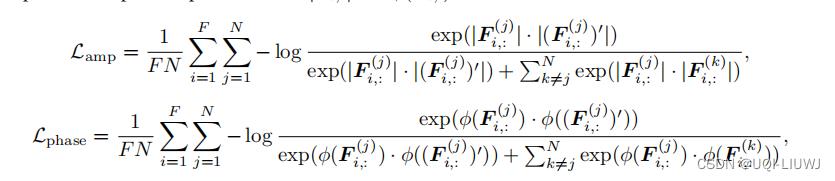

3.2.2 频域对比学习误差

振幅和相位的对比误差

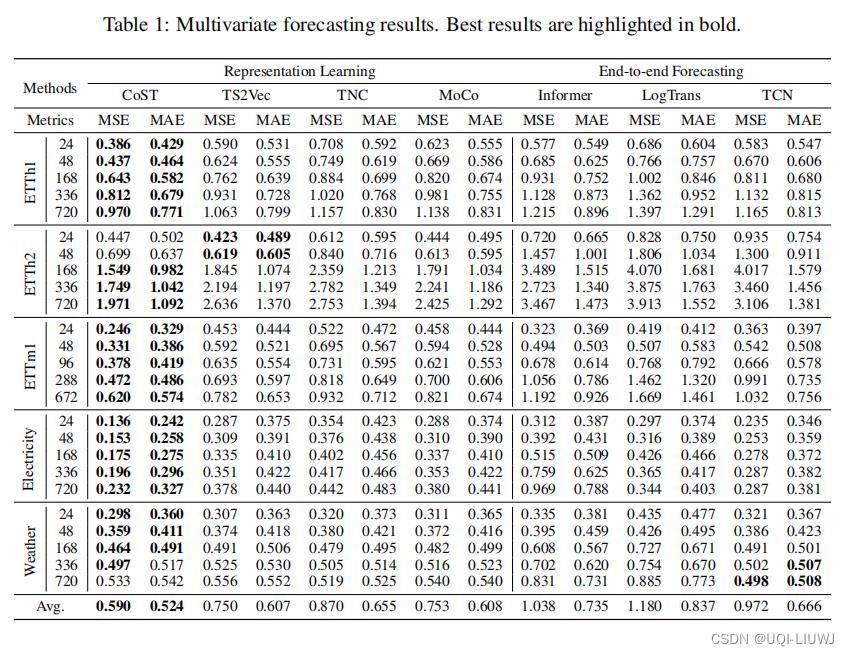

4 实验部分

4.1 预测表现

4.2 disentanglement 验证

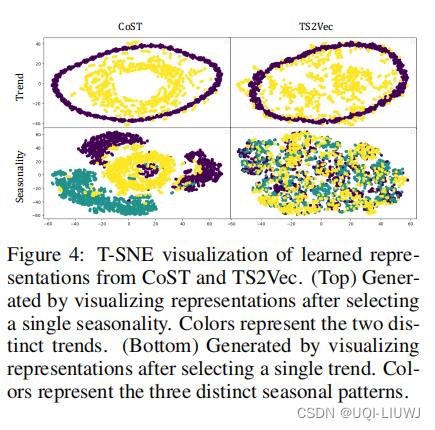

人造数据,两个trend+三个seasonality,两两组合,得到六个时间序列。

对encoder得到的趋势和周期的表征,通过T-SNE之后,进行可视化

以上是关于论文笔记:COST: CONTRASTIVE LEARNING OF DISENTANGLEDSEASONAL-TREND REPRESENTATIONS FORTIME SERIES FOREC的主要内容,如果未能解决你的问题,请参考以下文章