论文分享 | 局部海明距离优化的深度哈希算法

Posted 广东大数据重点实验室

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文分享 | 局部海明距离优化的深度哈希算法相关的知识,希望对你有一定的参考价值。

讨论班信息

论文题目:Maximum-Margin Hamming Hashing

论文来源:ICCV 2019

论文链接:

http://ise.thss.tsinghua.edu.cn/~mlong/doc/maximum-margin-hamming-hashing-iccv19.pdf

报告人:梁雨宸

报告时间:2020.3.28 星期六

报告地点:腾讯会议

摘要

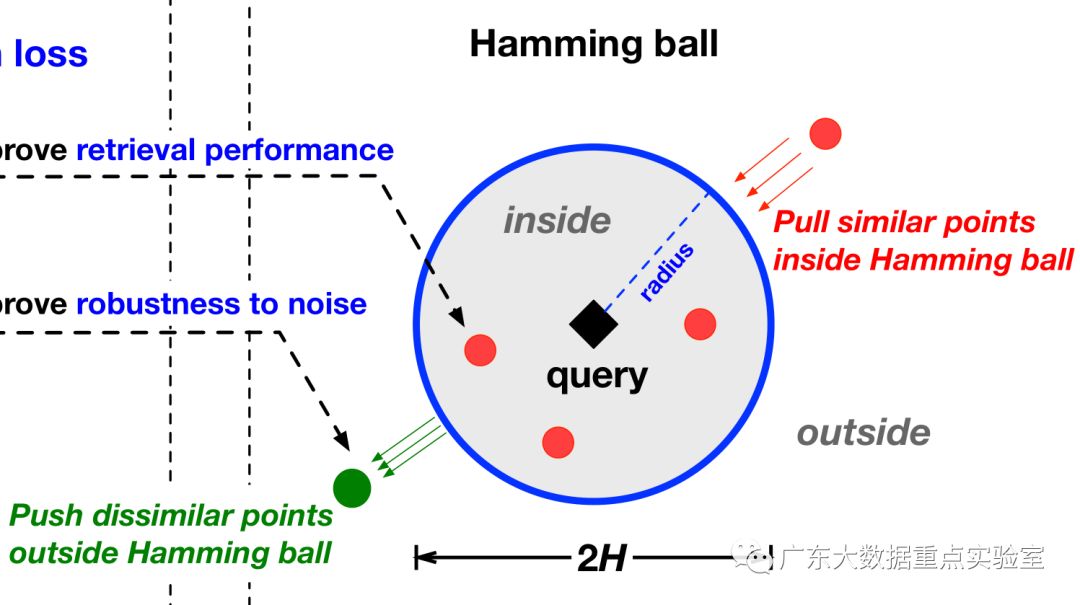

目前的深度哈希算法中,普遍使用深度学习来生成哈希码,在将神经网络取值连续的特征向量转换成离散的哈希码的问题上,存在着信息丢失、转换不准确等问题。本文提出一种将哈希距离直接引入损失函数进行约束的方法,通过设计针对海明距离半径内、外两种不同的损失,以优化连续特征向量转换成离散哈希码的质量。

(1)

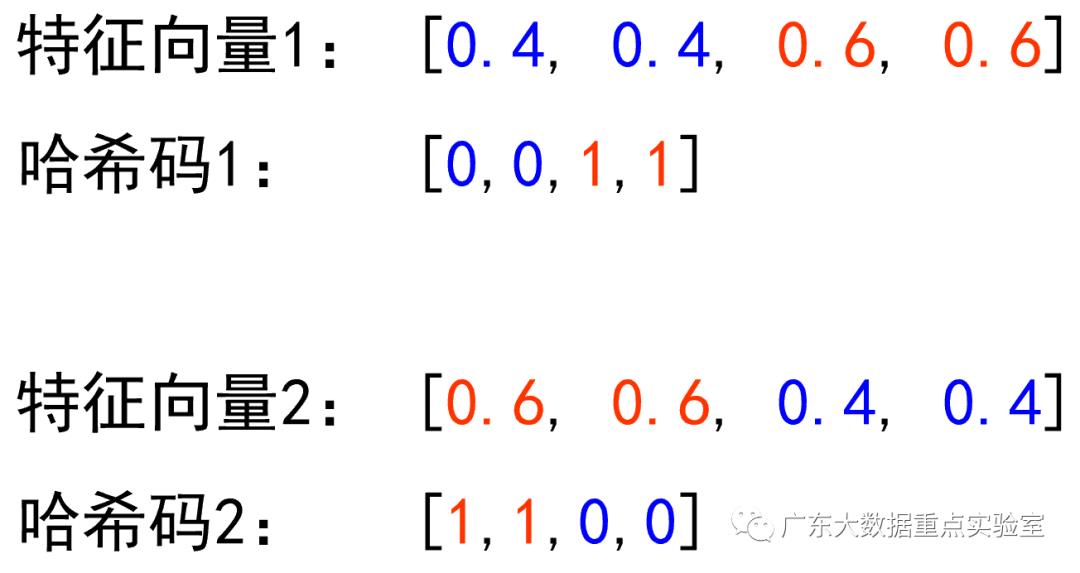

深度哈希的常见流程是,首先使用神经网络学习数据的特征,然后使用sigh( )函数将特征转换为取值{0,1}的哈希码。相比于深度学习中严谨的梯度优化,使用sigh( )非常简单粗暴,这种方式可能会大幅降低特征的质量。比如两个相似的特征,被转换为距离很远的哈希码。

(2)

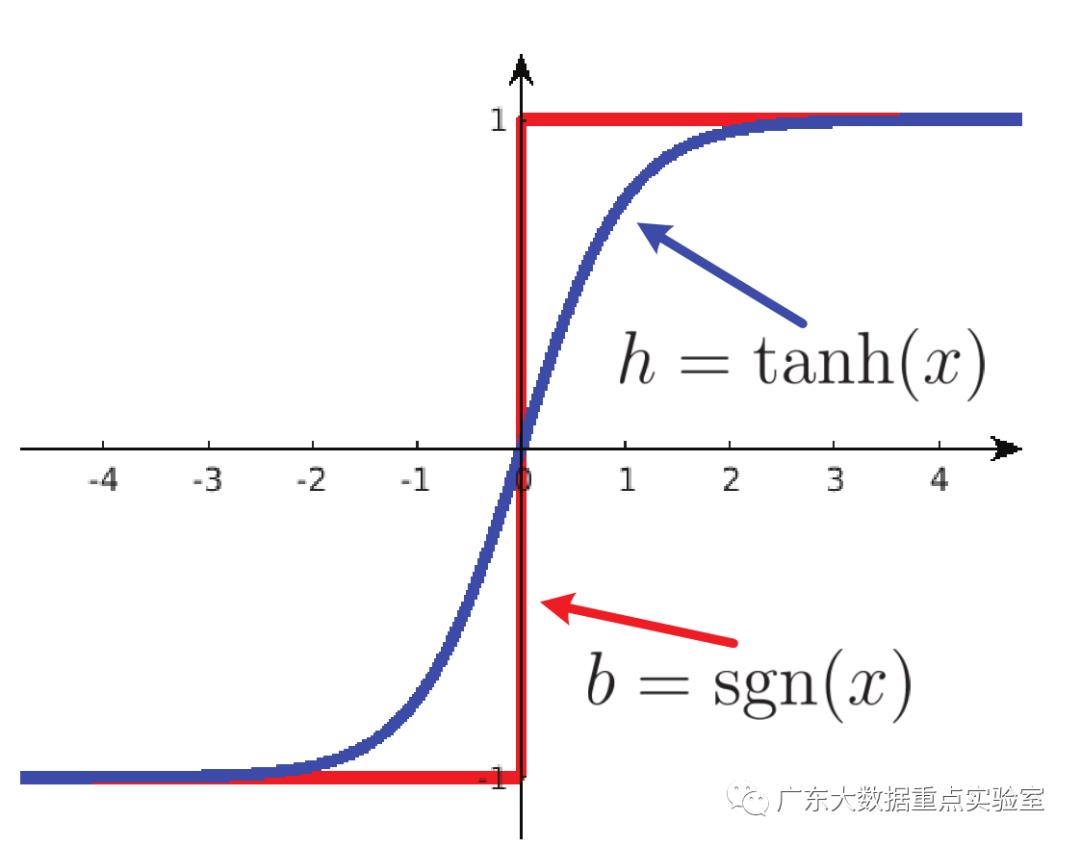

因此在学习特征的时候,大家希望网络输出的特征,取值尽可能接近{0,1}哈希码,这样可以减小转换哈希码的误差。常用的方法是在神经网络最后一个激活层,使用sigmoid或者tanh使特征的取值范围落在[0,1]或[-1,1]。比如HashNet提出一种使用渐进tanh作为激活层的方法。

(3)

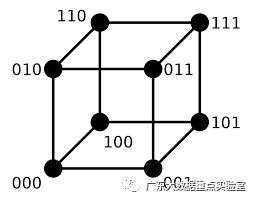

除了在网络输出的特征上考虑近似哈希码,许多研究也希望在连续值的特征距离上,也近似哈希码之间的海明距离计算。但海明距离也是离散的,无法直接参与梯度计算。如图所示,三位哈希码之间的海明距离可以用顶点路径表示。

(4)

针对以上两个问题:1、哈希码转换误差2、特征距离近似海明距离。本文在同时考虑以上两点的同时,提出一种局部海明区域损失优化的哈希方法,使海明距离能够在深度网络的特征中体现。同时提出了针对同类样本和异类样本,在数据集较大的情况下,更优的损失方案。

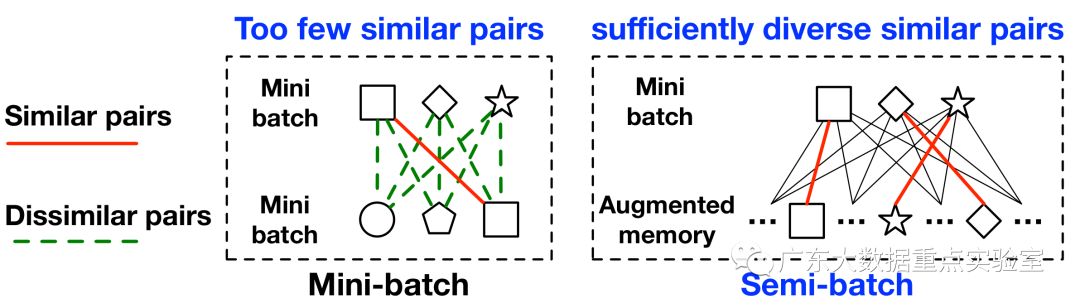

(5)

考虑到深度学习中batchSize在数据集类别数较大时,难以采集到正样本,文章也提出了一种针对性的采样方法,以保证每个batch中的正负样本相对平衡。

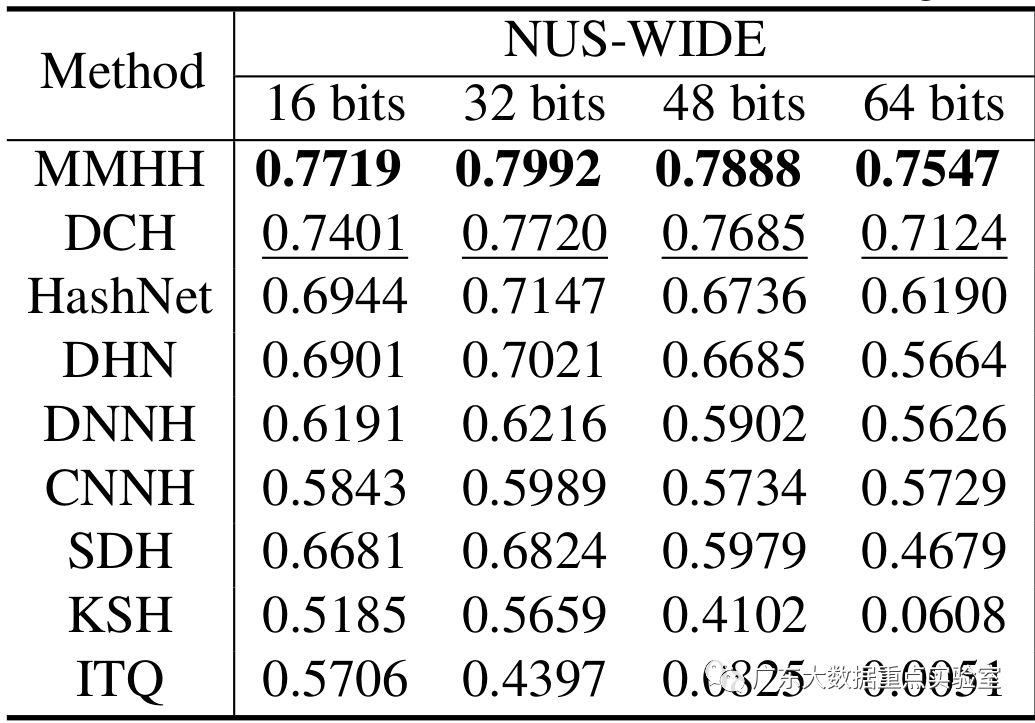

(6)实验

实验效果表明,本文的方法比相关的哈希算法有一定的性能提升。

图文 / 梁雨宸

编辑 / 梁雨宸

以上是关于论文分享 | 局部海明距离优化的深度哈希算法的主要内容,如果未能解决你的问题,请参考以下文章