斯坦福博士:个人开发者要不要开源项目模型和代码?

Posted 新智元

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了斯坦福博士:个人开发者要不要开源项目模型和代码?相关的知识,希望对你有一定的参考价值。

新智元报道

新智元报道

来源:towardsdatascience

编辑:大明

来源:towardsdatascience

编辑:大明

【新智元导读】作为个人开发者,应不应该将自己的项目或模型、数据等进行开源?公开这些数据有哪些风险?本文作者是斯坦福大学博士,长期从事开源机器学习研究,经常接触和处理敏感数据,他结合自己的经验,为这个问题提供了一些建议。

公开机器学习模型代码可能会有哪些风险?

OpenAI 最近因为创造了多项机器学习新任务的最优性能记录,但却不开放源代码而遭到越来越多的指摘。OpenAI发推表示,“由于担心这些技术可能被用做恶意目的,不会放出训练后的模型代码。“

对OpenAI这个决定的批评之声不少,比如这样会对其他团队重现研究这些研究结果造成阻碍,而研究结果的可重现性是确保研究真实的基础。而且,这样做也可能导致媒体对人工智能技术产生一种由于未知而生的恐惧。

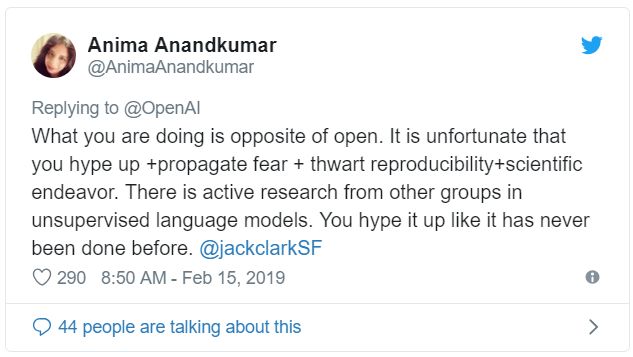

上面这段Twitter引起了我的注意。Anima Anandkumar在弥合机器学习的研究和实际应用之间的差距方面拥有丰富的经验。我们是亚马逊AWS的同事,最近还在一起讨论了如何将机器学习技术从博士实验室推向市场的问题。

Stephen Merity对社交媒体的回应进行了总结,他表示,机器学习社区在这方面的经验其实不多:

OpenAI不公开模型源代码是对是错?这事各位可以自行判断。不过在我看来,OpenAI在两个方面做得不够好,应该就是否可以检测到虚假内容进行调查,并以多种语言发布模型,以对抗对英语产生的单语种偏见。

对于个人机器学习项目而言,下面给出一些关于是否应该公开发布模型或数据集的决策时的一些常见问题:

在开源我的模型之前是否应该三思?

是的。如果你的模型是基于私有数据构建的,则可以对其进行逆向工程以提取出这些数据。

如果我的模型100%来自公共数据,那我是否还要考虑将模型开源?

是的。如果要在新的语言环境重新发布数据,已发布的数据可能会变成敏感数据,而且,聚合后的数据(包括机器学习模型)可能比分散的各个数据点更加敏感。你需要考虑:重新构建数据或数据模型会产生哪些影响,要不要由我自己或我所在的组织公开发布?

即使单个数据点并非敏感数据,聚合数据被视为敏感也是很常见的情况。这是许多军事组织的标准做法:当他们汇总来自一组来源的数据时,他们会根据其敏感程度重新评估该汇总信息。聚合通常是统计学或无监督机器学习的结果,但是基于该数据构建的监督模型同样适用。

所以,你应该经常自问:我的模型中的聚合数据是否比单个数据点更为敏感?

我应该如何评估开源风险?

在安全性方面考虑,可以将每个策略视为“可被攻破的”。风险防范的基本目标是使攻破某些安全措施的成本高于被保护数据的价值。

所以要考虑的问题是,从你的研究论文中复制模型的成本,是否值得为那些想要出于负面目的使用这些技术的人付出这样的努力?应该要明确这一点。这是决定是否将模型开源的一个重要因素。

我最近与Facebook进行了长时间的会谈,讨论的是出任一个职位,专门负责发现假新闻。从一个行内人的角度来看,我最想知道的是这样一件事:我能否以编程的方式成功检测这种模型输出,以便对抗假新闻?

我认为在Facebook上打击假新闻是任何人都可以做的最重要的事情之一,来自OpenAI的这项研究将会对此有所帮助。而且,如果能够创建一个可以识别生成内容的模型池,那么假新闻可能会更难以蒙混通过自动检测系统。

如果你能够定量地证明,对项目数据的恶意使用可以进行更容易/更难的打击,这也将是你做出是否开源的决策过程中的另一个重要因素。

这算是机器学习中的新问题吗?

其实不算是,你可以从过去的经验中学到很多东西。

如果你面临类似的困境,请寻找具有深度知识的人来讨论受影响最大的社区(最好是来自该社区内部的人士),以及过去遇到类似的机器学习问题相关问题的人。

我是否应该平衡机器学习的负面应用和正面应用?

是的。发布具有积极应用意义的模型,很容易对世界产生积极影响。而限制具有许多负面应用领域的模型的发布,很难对世界产生积极影响。

这其实是OpenAI的另一个失败之处:缺乏多样性。OpenAI比任何其他研究团队都更多地发布了仅适用于英语模型和研究成果。从全球来看,英语每天仅占全世界对话的5%。在句子中的单词顺序、标准化拼写和“单词”作为机器学习功能单元上,英语是一个异类。

OpenAI的研究依赖于以下三个方面:单词顺序,单词特征,拼写一致性。这些研究能够适用于世界上大多数语言吗?我们不知道,因为没有测试。OpenAI的研究确实表明,我们需要担心这种类型的英语生成内容,但并没有表明,今天的假新闻的流传,更有可能通过除英语之外的其他100多种语言进行。

如果你不想进入假新闻等应用程序的灰色区域,那么可以选择一个本质上更具影响力的研究领域,例如低资源语言中与健康相关的文本的语言模型。

我需要在多大程度上考虑项目应用实例的敏感性?

在任何研究项目中都要考虑这一点:是否能够隐含或明确地识别出模型中的敏感信息?

只是因为其他人都开源了自己的模型,因此我也应该开源吗?

当然不是,你应该对自己项目的影响力保持一份怀疑。无论你是否赞同OpenAI的决定,都应该做出明智的决定,而不是盲目跟随他人。

参考链接:

https://towardsdatascience.com/should-i-open-source-my-model-1c109188b164

更多阅读

【加入社群】

以上是关于斯坦福博士:个人开发者要不要开源项目模型和代码?的主要内容,如果未能解决你的问题,请参考以下文章