江湖秘笈:世上居然还有爬虫技术不能到达的区域?Robots协议规范搜索引擎技术

Posted e品江湖网络攻防

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了江湖秘笈:世上居然还有爬虫技术不能到达的区域?Robots协议规范搜索引擎技术相关的知识,希望对你有一定的参考价值。

关注蓝字 看点网络安全

一天一点

Hello,看官们,本周短暂的工作时光又过去了一天,明天就是周五了,相信各位按耐不住激动心情了吧?

说起下雪这个话题,不知各位看官的家乡是否已经下雪了呢?2 cats大侠我的老家是肯定下雪了,只可惜因为工作原因无法回去驻足观看一番了。

回看北京近年来的雪况,真是实在有些令人堪忧。记得有一次去给客户进行系统安全应急维护时,回家的路上听到两位北京本地老人聊天时,说了这样一句话,这雪是越来越难见到了,不知是不是再过些年月,就要到国外去感受下雪了。

由此可见,下一场雪对北京人来讲是多么期待的事情啊。

立规矩的robots协议

好啦,闲话打住,开始今天的技术分享。昨天我们提到了一款可以检索Web服务器中隐藏文件的工具DirBuster,可是此类工具毕竟是需要下载安装才能使用的,那有没有可以不用安装下载就使用的办法呢?

这个答案必然是存在的,那就是搜索引擎。

搜索引擎是怎么玩的?

众所周知,搜索引擎使用的方式方法为爬虫技术,又被称为搜索蜘蛛,它采用的方式是对网站进行访问时,优先检索一个名为robots.txt的文件,若是该文件不存在,爬虫们将视当前访问网站无任何限制,所有未加入口令保护的页面都会被访问到。

爬虫协议又是什么鬼?

可是robots.txt文件又是什么呢?它是基于robots协议(又称“爬虫协议、机器人协议”等),作用是规范网络爬虫对网站访问的行为管理类协议。

可是这与查看隐藏文件有什么关系呢?这就要回到问题根源了,作为一名出自搜索引擎公司而来的技术人员,必然对爬虫技术相当了解,然后在转型或开发出同类检索工具时,其特性必然充斥着爬虫的惯性思维。

因此,此类安全审计人员在对Web进行扫描时,会考虑使用同类技术进行文件检索方式方法,从而引出了robots.txt的话题。

其实,在很多Web文件中都会看到robots的存在,这是为了告诉各类搜索引擎,在所访问网站时请注意,我们这里有特定的区域是不允许被访问或打扰的。

工具演示

举例:

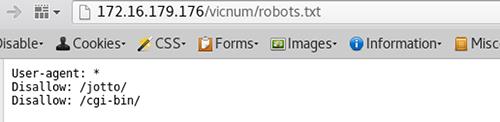

这张图中便是robots.txt文本中对网站禁区的描述,其中jotto和cgi-bin的首页是不希望被任何搜索引擎(User-Agent)进行收录的。可是这些页面中含有的是什么信息呢?不如一起来看下下面这张图显示结果。

2

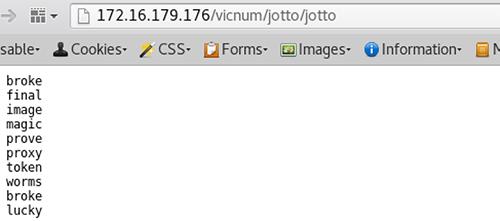

从图中显示的结果看来,两个被禁止搜索引擎所访问的页面中一个是系统文件目录清单,一个是关键词的集合页面。

因此,在使用robost协议类技术对Web服务器进行检索时,还是需要尽量注意的,不要因为盲目的访问,导致被测试目标系统相关管理人员误解。

注意

2cats 寄语

老规矩不变,

如果有任何问题依旧可以发给e品小顽童。

小顽童的邮箱是:

xiaowantong@epinjianghu.com。

期待各位的来信交流!

e品江湖

不失初心 不忘初衷

长按扫码 加关注!

以上是关于江湖秘笈:世上居然还有爬虫技术不能到达的区域?Robots协议规范搜索引擎技术的主要内容,如果未能解决你的问题,请参考以下文章

江湖秘笈: Uniscan,可以远程发现执行命令远程文件和本地文件的漏洞扫描工具

江湖秘笈:PostgreSQL数据库好用是真的,里面潜藏的漏洞风险也是真的!