大数据系列|Flume的架构和环境安装

Posted 程序媛那点事儿

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据系列|Flume的架构和环境安装相关的知识,希望对你有一定的参考价值。

一、Flume简介和基本架构

由Cloudera公司开源;

分布式、可靠、高可用的海量日志采集系统;

数据源可定制,可扩展;

数据存储系统可定制,可扩展。

中间件:屏蔽了数据源和数据存储系统的异构性

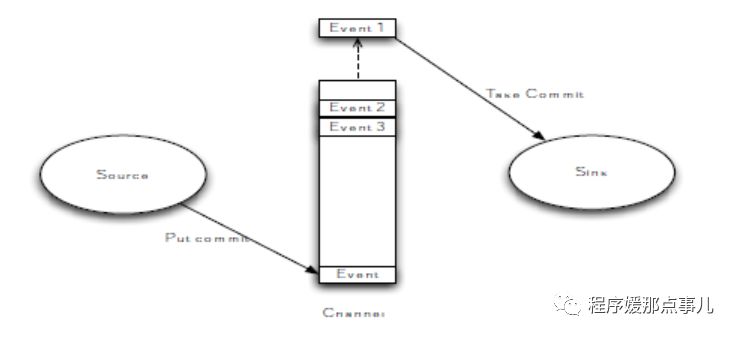

Flume的数据流由事件(Event)贯穿始终。事件是Flume的基本数据单位,它携带日志数据(字节数组形式)并且携带有头信息,这些Event由Agent外部的Source生成,当Source捕获事件后会进行特定的格式化,然后Source会把事件推入(单个或多个)Channel中。你可以把Channel看作是一个缓冲区,它将保存事件直到Sink处理完该事件。Sink负责持久化日志或者把事件推向另一个Source。

1、flume的可靠性

当节点出现故障时,日志能够被传送到其他节点上而不会丢失。Flume提供了三种级别的可靠性保障,从强到弱依次分别为:end-to-end(收到数据agent首先将event写到磁盘上,当数据传送成功后,再删除;如果数据发送失败,可以重新发送。),Store on failure(这也是scribe采用的策略,当数据接收方crash时,将数据写到本地,待恢复后,继续发送),Besteffort(数据发送到接收方后,不会进行确认)。

2、flume的可恢复性

还是靠Channel。推荐使用FileChannel,事件持久化在本地文件系统里(性能较差)。

二、Flume的一些核心概念

1、Client:Client生产数据,运行在一个独立的线程。

2、Event: 一个数据单元,消息头和消息体组成。(Events可以是日志记录、 avro 对象等。)

3、Flow: Event从源点到达目的点的迁移的抽象。

4、Agent: 一个独立的Flume进程,包含组件Source、 Channel、 Sink。(Agent使用JVM 运行Flume。每台机器运行一个agent,但是可以在一个agent中包含多个sources和sinks。)

5、Source: 数据收集组件。(source从Client收集数据,传递给Channel)

6、Channel: 中转Event的一个临时存储,保存由Source组件传递过来的Event。(Channel连接 sources 和 sinks ,这个有点像一个队列。)

7、Sink: 从Channel中读取并移除Event, 将Event传递到FlowPipeline中的下一个Agent(如果有的话)(Sink从Channel收集数据,运行在一个独立线程。)

三、 Flume核心组件

Flume 运行的核心是 Agent。Flume以agent为最小的独立运行单位。一个agent就是一个JVM。它是一个完整的数据收集工具,含有三个核心组件,分别是source、 channel、 sink。

1、source

Source负责接收event或通过特殊机制产生event,并将events批量的放到一个或多个Channel。

包含event驱动和轮询2种类型,Source必须至少和一个channel关联。

不同类型的Source:

与系统集成的Source: Syslog, Netcat

自动生成事件的Source: Exec

监听文件夹下文件变化:Spooling Directory Source,Taildir Source

用于Agent和Agent之间通信的IPC Source: Avro、Thrift

2、Channel

Channel位于Source和Sink之间,用于缓存event;当Sink成功将event发送到下一跳的channel或最终目的,event从Channel移除。Channel支持事务,提供较弱的顺序保证;可以和任何数量的Source和Sink工作。

不同的Channel提供的持久化水平也是不一样的:

Memory Channel: volatile

File Channel: 基于WAL(预写式日志Write-Ahead Logging)实现

JDBC Channel: 基于嵌入Database实现

3、Sink

Sink负责将event传输到下一跳或最终目的,成功完成后将event从channel移除。必须作用于一个确切的channel。

不同类型的Sink:

存储event到最终目的的终端Sink. 比如: HDFS, HBase,hive

自动消耗的Sink. 比如: Null Sink

用于Agent间通信的IPC sink: Avro

四、Flume常用拓扑图

这种情况应用的场景比较多,比如要收集Web网站的用户行为日志, Web网站为了可用性使用的负载集群模式,每个节点都产生用户行为日志,每个节点的日志都分发到了每台Agent节点,同时起到了高可用和负载均衡的作用,然后多个Agent将数据最终汇聚到两个节点用来存储数据存储系统,如HDFS上。存在第二层的Flume Agent的作用主要时平滑过渡,避免最终处理数据的服务器负载过重。

五、Flume的安装

Flume框架对hadoop和zookeeper的依赖只是在jar包上,并不要求flume启动时必须将hadoop和zookeeper服务也启动。

1、上传安装包

将Flume安装包apache-flume-1.7.0-bin.tar.gz上传至本地目录/home/bigdata/software/,并解压。

cd /home/bigdata/software/

tar -zxvf apache-flume-1.7.0-bin.tar.gz

2、修改配置文件

cd /home/bigdata/software/apache-flume-1.7.0-bin

cp flume-env.sh.template flume-env.sh

vim flume-env.sh

增加以下

export JAVA_HOME=/usr/local/jdk1.8.0_111

3、配置系统环境变量

vim ~/.bash_profile

#Sqoop

export FLUME_HOME=/home/bigdata/software/apache-flume-1.7.0-bin

export PATH=$PATH:$FLUME_HOME/bin

source ~/.bash_profile

4、查看版本

后记:

码完了。

目录汇总一下下:

一、Flume简介和基本架构

二、Flume的一些核心概念

三、Flume核心组件

1 Source

2 Channel

3 Sink

四、Flume常用拓扑图

五、Flume的安装

1 上传安装包

2 修改配置文件

3 配置系统环境变量

4 查看版本

以上是关于大数据系列|Flume的架构和环境安装的主要内容,如果未能解决你的问题,请参考以下文章