大数据之Hive体系的架构与基本组成(文末有彩蛋)

Posted ItStar

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据之Hive体系的架构与基本组成(文末有彩蛋)相关的知识,希望对你有一定的参考价值。

Hive的体系结构划分

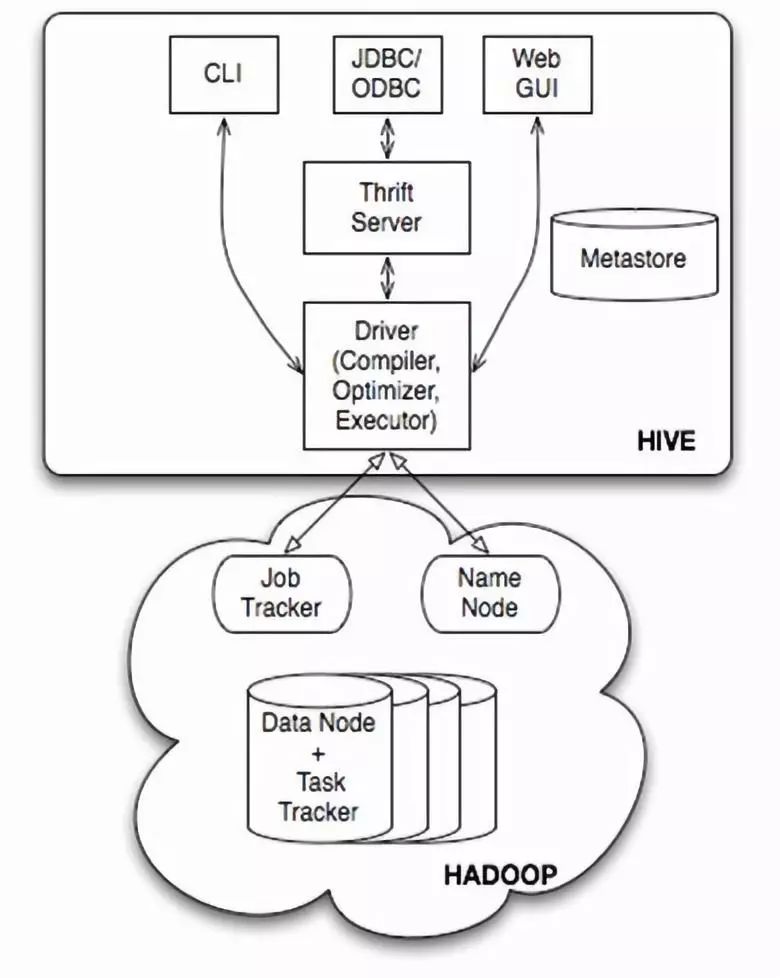

下面是Hive的架构图:

1

用户接口主要有三个:CLI,Client 和 WUI。其中最常用的是CLI,Cli启动的时候,会同时启动一个Hive副本。Client是Hive的客户端,用户连接至Hive Server。在启动 Client模式的时候,需要指出Hive Server所在节点,并且在该节点启动Hive Server。 WUI是通过浏览器访问Hive。

2

Hive将元数据存储在数据库中,如mysql、derby。Hive中的元数据包括表的名字,表的列和分区及其属性,表的属性(是否为外部表等),表的数据所在目录等。

3

解释器、编译器、优化器完成HQL查询语句从词法分析、语法分析、编译、优化以及查询计划的生成。生成的查询计划存储在HDFS中,并在随后有MapReduce调用执行。

4

Hive的数据存储在HDFS中,大部分的查询、计算由MapReduce完成(包含*的查询,比如select * from tbl不会生成MapRedcue任务)。

连接到数据库的模式

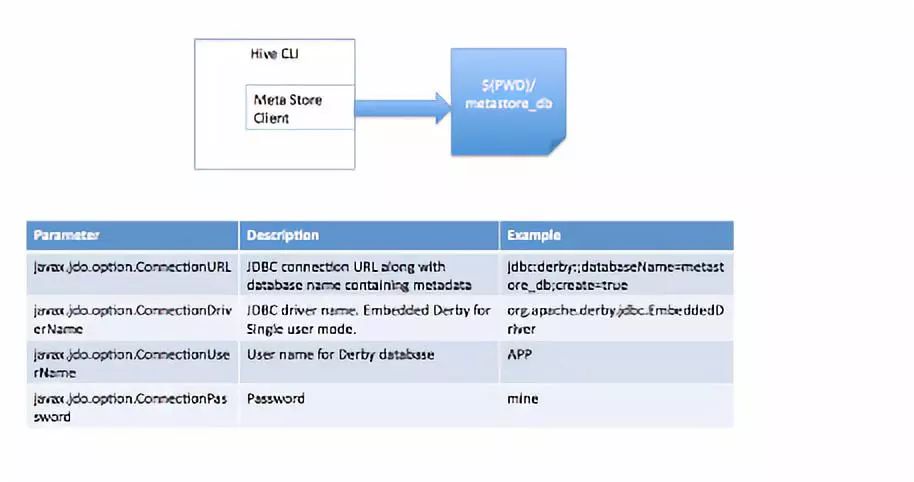

此模式连接到一个In-memory 的数据库Derby,一般用于Unit Test。

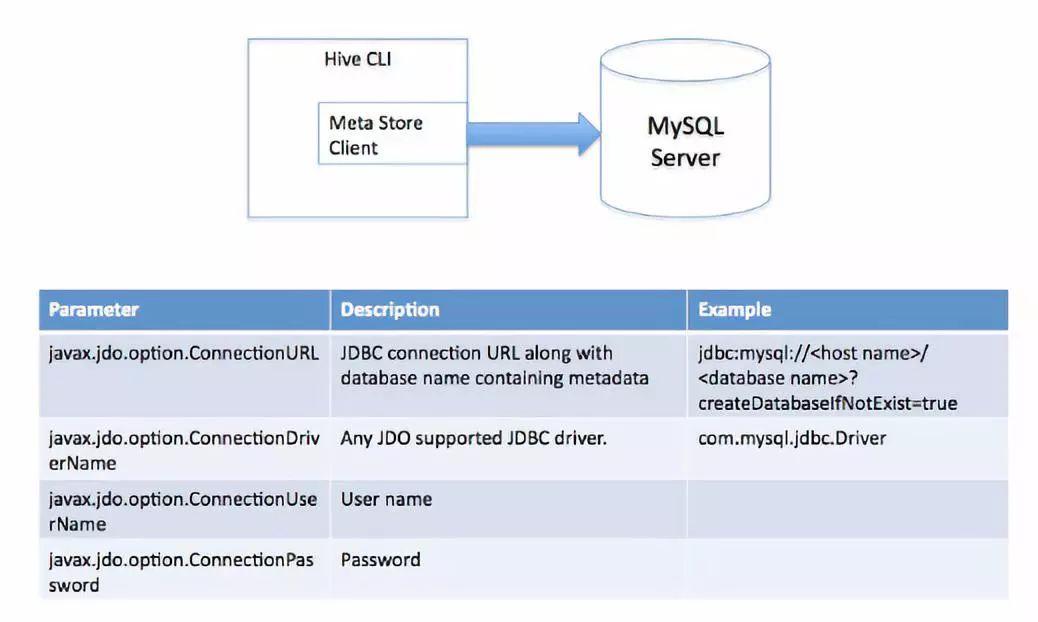

2.2 多用户模式

通过网络连接到一个数据库中,是最经常使用到的模式。

2.3 远程服务器模式

用于非Java客户端访问元数据库,在服务器端启动MetaStoreServer,客户端利用Thrift协议通过MetaStoreServer访问元数据库。

Hive的数据模型

对于数据存储,Hive没有专门的数据存储格式,也没有为数据建立索引,用户可以非常自由的组织Hive中的表,只需要在创建表的时候告诉Hive数据中的列分隔符和行分隔符,Hive就可以解析数据。

Hive中所有的数据都存储在HDFS中,存储结构主要包括数据库、文件、表和视图。

Hive中包含以下数据模型:Table内部表,External Table外部表,Partition分区,Bucket桶。Hive默认可以直接加载文本文件,还支持sequence file 、RCFile。

3.1 Hive数据库

类似传统数据库的DataBase,在第三方数据库里实际是一张表。简单示例命令行 hive > create database test_database;

3.2 内部表

Hive的内部表与数据库中的Table在概念上是类似。每一个Table在Hive中都有一个相应的目录存储数据。例如一个表pvs,它在HDFS中的路径为/wh/pvs,其中wh是在hive-site.xml中由${hive.metastore.warehouse.dir} 指定的数据仓库的目录,所有的Table数据(不包括External Table)都保存在这个目录中。删除表时,元数据与数据都会被删除。

内部表简单示例:

1、创建数据文件:test_inner_table.txt

2、创建表:create table test_inner_table (key string) 3、加载数据:LOAD DATA LOCAL INPATH 'filepath' INTO TABLE test_inner_table

4、查看数据:select * from test_inner_table; select count(*) from test_inner_table 5、删除表:drop table test_inner_table

3.3 外部表

外部表指向已经在HDFS中存在的数据,可以创建Partition。它和内部表在元数据的组织上是相同的,而实际数据的存储则有较大的差异。内部表的创建过程和数据加载过程这两个过程可以分别独立完成,也可以在同一个语句中完成,在加载数据的过程中,实际数据会被移动到数据仓库目录中;之后对数据对访问将会直接在数据仓库目录中完成。删除表时,表中的数据和元数据将会被同时删除。而外部表只有一个过程,加载数据和创建表同时完成(CREATE EXTERNAL TABLE ……LOCATION),实际数据是存储在LOCATION后面指定的 HDFS 路径中,并不会移动到数据仓库目录中。当删除一个External Table时,仅删除该链接。

外部表简单示例:

1、创建数据文件:test_external_table.txt

2、创建表:create external table test_external_table (key string) 3、加载数据:LOAD DATA INPATH ‘filepath’ INTO TABLE test_inner_table

4、查看数据:select * from test_external_table;

5、select count(*) from test_external_table

6、删除表:drop table test_external_table

3.4 分区

Partition对应于数据库中的Partition列的密集索引,但是Hive中Partition的组织方式和数据库中的很不相同。在Hive中,表中的一个Partition对应于表下的一个目录,所有的Partition的数据都存储在对应的目录中。

例如pvs表中包含ds和city两个Partition,则对应于ds = 20090801, ctry = US 的HDFS子目录为/wh/pvs/ds=20090801/ctry=US;对应于 ds = 20090801, ctry = CA 的HDFS子目录为/wh/pvs/ds=20090801/ctry=CA。

分区表简单示例:

1、创建数据文件:test_partition_table.txt

2、创建表:create table test_partition_table (key string) partitioned by (dt string) 3、加载数据:LOAD DATA INPATH 'filepath' INTO TABLE test_partition_table partition (dt='2006')

4、查看数据:select * from test_partition_table; select count(*) from test_partition_table 5、删除表:drop table test_partition_table

3.5 桶

Buckets是将表的列通过Hash算法进一步分解成不同的文件存储。它对指定列计算hash,根据hash值切分数据,目的是为了并行,每一个Bucket对应一个文件。

例如将user列分散至32个bucket,首先对user列的值计算hash,对应hash值为0的HDFS目录为/wh/pvs/ds=20090801/ctry=US/part-00000;hash值为20的HDFS目录为/wh/pvs/ds=20090801/ctry=US/part-00020。如果想应用很多的Map任务这样是不错的选择。

桶的简单示例:

1、创建数据文件:test_bucket_table.txt

2、创建表:create table test_bucket_table (key string) clustered by (key) into 20 buckets 3、加载数据:LOAD DATA INPATH 'filepath' INTO TABLE test_bucket_table

4、查看数据:select * from test_bucket_table;

5、set hive.enforce.bucketing = true;

3.6 Hive的视图

视图与传统数据库的视图类似。视图是只读的,它基于的基本表,如果改变,数据增加不会影响视图的呈现;如果删除,会出现问题。

如果不指定视图的列,会根据select语句后的生成。

示例:

create view test_view as select * from test

文 末 福 利 彩 蛋(限时领取)

领取方式:

注意:福利有效期只剩4天,错过就没有了哟。

以上是关于大数据之Hive体系的架构与基本组成(文末有彩蛋)的主要内容,如果未能解决你的问题,请参考以下文章