可靠保障MyCat集群

Posted 爱编码

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了可靠保障MyCat集群相关的知识,希望对你有一定的参考价值。

前言

上一回已写mycat基本操作,估计足以应付各位的实际需求。但是现代的社会没有集群,你自己都不敢保证自己的服务是否是高可用的。

所以本文主要包含mycat集群,mycat+ha实现负载均衡等操作。

mycat集群

1、安装zookeeper集群

mycat是阿里出品的一个数据库中间件,它可以依赖zookeeper进行集群化的,所以需要准备一套zookeeper集群,具体操作如下:

Zookeeper集群搭建

2、配置mycat连接zookeeper

将你配置好的mycat的配置文件( server.xml、schema.xml、 rule.xml、sequence_conf.properties)拷贝到mycat配置文件的中的zkconf目录中

cp schema.xml server.xml rule.xml sequence_conf.properties zkconf/

3、初始化mycat配置到zk集群

首先找到mycat提供的初始化数据到zookeeper的shell脚本:/usr/local/mycat/bin/init_zk_data.sh 执行命令

../bin/init_zk_data.sh

如果报错:-bash: ./init_zk_data.sh: /bin/bash^M: bad interpreter: No such file or directory

解决方案:

http://8rr.co/v9ms

http://8rr.co/v9mE

4、连接zookeeper并验证

连接zookeeper服务器,在zk客户端中执行

ls /mycat/mycat-cluster-1/schema

get /mycat/mycat-cluster-1/schema/dataHost

5、配置mycat支持zk启动

在所有的mycat的conf目录下找到myid.properties文件,并修改如下:

loadZk=true

zkURL=192.168.56.10:2181,192.168.56.11:2181,192.168.56.12:2181

clusterId=mycat-cluster-1

myid=mycat_01

clusterSize=2

clusterNodes=mycat_01,mycat_02

#server booster ; booster install on db same server,will reset all minCon to 2

type=server

boosterDataHosts=dataHost1

6、然后重启所有的mycat

你会发现没有配置的其他mycat会自动找到所有的server.xml,schema.xml,rule.xml等配置。

至此mycat的集群已经搭建完毕!!

mycat+HA实现高可用

以上的mycat+zk搭建的集群其实无法实现负载均衡以及高可用。还需要借助haproxy+keepalived才能真正实现高可用。

以下配置在每个mycat所在的服务器都要做一遍。

1、安装网络守护进程服务xinetd

yum -y install xinetd

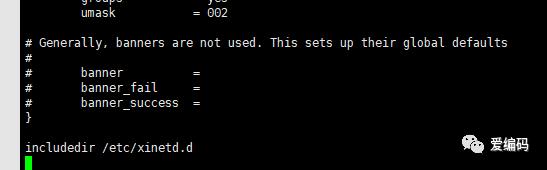

vi /etc/xinetd.conf ##确保配置中包含最后一行includedir xxxx

创建一个mycat_status的服务

vi /etc/xinetd.d/mycat_status

### 内容如下:

service mycat_status

{

flags = REUSE

socket_type = stream

port = 48700

wait = no

user = root

server = /usr/local/mycat/bin/mycat_status

log_on_failure += USERID

disable = no

}

创建一个检测mycat的状态脚本

vi /usr/local/mycat/bin/mycat_status

给脚本赋予可操作权限:

chmod a+x /usr/local/mycat/bin/mycat_status

检查mycat状态的脚本内容:

#!/bin/bash

#/usr/local/mycat/bin/mycat_status

# This script checks if a mycat server is healthy running on localhost. It will

# return:

#

# "HTTP/1.x 200 OK\r" (if mycat is running smoothly)

#

# "HTTP/1.x 503 Internal Server Error\r" (else)

mycat=`/usr/local/mycat/bin/mycat status | grep 'not running' | wc -l`

if [ "$mycat" = "0" ];

then

/bin/echo -e "HTTP/1.1 200 OK\r\n"

else

/bin/echo -e "HTTP/1.1 503 Service Unavailable\r\n"

fi

注册一个mycat_status服务

vi /etc/services

### 内容如下:

mycat_status 48700/tcp # mycat_status

最后启动xinetd:

systemctl restart xinetd

2、安装haproxy

yum -y install haproxy 即可实现下载安装

vi /etc/haproxy/haproxy.cfg 修改配置如下,修改成你对应的ip和端口即可

global

log 127.0.0.1 local0 ##记日志的功能

maxconn 4096

chroot /usr/local/haproxy

daemon

defaults

log global

option dontlognull

retries 3

option redispatch

maxconn 2000

timeout connect 5000

timeout client 50000

timeout server 50000

listen admin_status

bind :1080 ##VIP

stats uri /stats ##统计页面

stats auth admin:admin

mode http

option httplog

listen allmycat_service

bind :8096 ##转发到 mycat 的 8066 端口,即 mycat 的服务端口

mode tcp

option tcplog

option httpchk OPTIONS * HTTP/1.1\r\nHost:\ www

balance roundrobin

server mycat_10 192.168.56.10:8066 check port 48700 inter 5s rise 2 fall 3

server mycat_12 192.168.56.12:8066 check port 48700 inter 5s rise 2 fall 3

timeout server 20000

listen allmycat_admin

bind :8097 ##转发到 mycat 的 9066 端口,即 mycat 的管理控制台端口

mode tcp

option tcplog

option httpchk OPTIONS * HTTP/1.1\r\nHost:\ www

balance roundrobin

server mycat_10 192.168.56.10:9066 check port 48700 inter 5s rise 2 fall 3

server mycat_12 192.168.56.12:9066 check port 48700 inter 5s rise 2 fall 3

timeout server 20000

启动haproxy:

haproxy -f /etc/haproxy/haproxy.cfg

验证:netstat -ntlp 查看端口8096和8097是否启动成功。

浏览器访问http://192.168.56.12:1080/stats查看mycat的状态(都是UP的就ok了)如下:

3、安装Keepalived

yum -y install keepalived 下载安装

添加虚拟ip操作:http://8rr.co/v9Eb

修改配置文件

vi /etc/keepalived/keepalived.conf

### 内容如下:

####=====================================================

! Configuration File for keepalived

##global_defs {

## keepalived 自带的邮件提醒需要开启 sendmail 服务。建议用独立的监控或第三方 SMTP

## router_id liuyazhuang135 ## 标识本节点的字条串,通常为 hostname

##}

## keepalived 会定时执行脚本并对脚本执行的结果进行分析,动态调整 vrrp_instance 的优先级。

## 如果脚本执行结果为 0,并且 weight 配置的值大于 0,则优先级相应的增加。

## 如果脚本执行结果非 0,并且 weight 配置的值小于 0,则优先级相应的减少。

## 其他情况,维持原本配置的优先级,即配置文件中 priority 对应的值。

vrrp_script chk_haproxy {

script "/etc/keepalived/haproxy_check.sh" ## 检测 haproxy 状态的脚本路径

interval 2 ## 检测时间间隔

weight 2 ## 如果条件成立,权重+2

}

## 定义虚拟路由, VI_1 为虚拟路由的标示符,自己定义名称

vrrp_instance VI_1 {

state MASTER ## 默认主设备(priority 值大的)和备用设备(priority 值小的)都设置为 BACKUP,

## 由 priority 来控制同时启动情况下的默认主备,否则先启动的为主设备

interface enp0s3 ## 绑定虚拟 IP 的网络接口,与本机 IP 地址所在的网络接口相同,我的是 eth3

virtual_router_id 51 ## 虚拟路由的 ID 号,两个节点设置必须一样,可选 IP 最后一段使用,

## 相同的 VRID 为一个组,他将决定多播的 MAC 地址

priority 150 ## 节点优先级,值范围 0-254, MASTER 要比 BACKUP 高

nopreempt ## 主设备(priority 值大的)配置一定要加上 nopreempt,否则非抢占也不起作用

advert_int 1 ## 组播信息发送间隔,两个节点设置必须一样,默认 1s

## 设置验证信息,两个节点必须一致

authentication {

auth_type PASS

auth_pass 1111 ## 真实生产,按需求对应该过来

}

## 将 track_script 块加入 instance 配置块

track_script {

chk_haproxy ## 检查 HAProxy 服务是否存活

}

## 虚拟 IP 池, 两个节点设置必须一样

virtual_ipaddress {

192.168.56.88 ## 虚拟 ip,可以定义多个,每行一个

}

}

添加检测haproxy是否存活的脚本

vi /etc/keepalived/haproxy_check.sh

以下需要注意START_HAPROXY的路径要对应你自己安装的路径:

#!/bin/bash

START_HAPROXY="/usr/sbin/haproxy -f /etc/haproxy/haproxy.cfg"

STOP_KEEPALIVED="/etc/init.d/keepalived stop"

LOG_FILE="/var/log/keepalived-haproxy-state.log"

HAPS=`ps -C haproxy --no-header |wc -l`

date "+%Y-%m-%d %H:%M:%S" >> $LOG_FILE

echo "check haproxy status" >> $LOG_FILE

if [ $HAPS -eq 0 ];then

echo $START_HAPROXY >> $LOG_FILE

$START_HAPROXY >> $LOG_FILE 2>&1

sleep 3

if [ `ps -C haproxy --no-header |wc -l` -eq 0 ];then

echo "start haproxy failed, killall keepalived" >> $LOG_FILE

killall keepalived

fi

fi

给脚本赋予权限

chmod a+x /etc/keepalived/haproxy_check.sh

启动keepalived

service keepalived start

验证是否成功。

可以在一个主服务器执行service keepalived stop,观察另外一个备份服务器的ip addr是否已经是添加了虚拟ip

参考文章

Mycat之——高可用负载均衡集群的实现(HAProxy + Keepalived + Mycat)

Mycat之——Mycat集群部署(基于HAProxy + Mycat

Mycat之——Mycat集群优化

MyCat不支持的SQL语句

Mycat 分布式事务的实现

注:如果想看参考文章可以点击阅读原文。

以上是关于可靠保障MyCat集群的主要内容,如果未能解决你的问题,请参考以下文章