新闻 | 我组NLP系列开源工具在GitHub获得关注超过1万星标

Posted TsinghuaNLP

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了新闻 | 我组NLP系列开源工具在GitHub获得关注超过1万星标相关的知识,希望对你有一定的参考价值。

清华大学自然语言处理与社会人文计算实验室(THUNLP),隶属于清华大学人工智能研究院,在孙茂松教授、刘洋长聘副教授、刘知远副教授三位老师的带领下,致力于将最新研究成果开放共享,自2015年起在全球最大的开源社区陆续发布NLP开源工具和数据集。截至最近,THUNLP组共发布超过60项开源项目,获得关注超过1万星标。其中,神经网络机器翻译工具包THUMT、知识表示学习工具包OpenKE、网络表示学习工具包OpenNE、神经网络关系抽取工具包OpenNRE、中文词法分析工具包THULAC等得到了国内外学者的广泛使用和关注。

以下简单介绍若干具有代表性的NLP工具包:

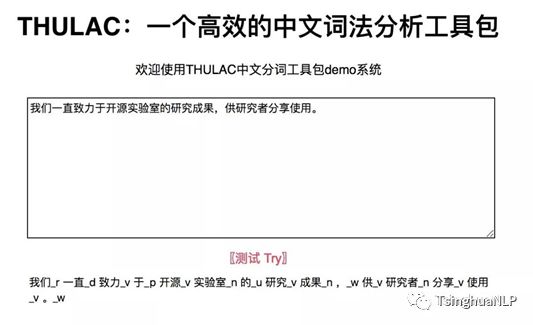

THULAC:中文词法分析工具包,具有中文分词和词性标注功能。THULAC利用我组集成的目前世界上规模最大的人工分词和词性标注中文语料库(约含5800万字)训练而成,模型性能强大,在标准数据集Chinese Treebank(CTB5)上分词F1值可达97.3%,词性标注F1值可达92.9%,与该数据集上最好方法效果相当。同时工具包处理速度快,同时进行分词和词性标注速度为300KB/s,每秒可处理约15万字;只进行分词速度可达到1.3MB/s。工具包支持多个语言实现版本:

C++版本:https://github.com/thunlp/THULAC

Java版本:https://github.com/thunlp/THULAC-Java

Python版本:https://github.com/thunlp/THULAC-Python并配套提供了中文开放词典:https://github.com/thunlp/THUOCL

THUMT:一个神经网络机器翻译工具包,包含基于TensorFlow和Theano两种实现的基于端到端、循环神经网络和自注意力的翻译模型。此外,该工具包也加入了实验室最新研究成果,包括最小风险训练、半监督训练和基于层级相关性传播的可视化。THUMT链接:https://github.com/thumt/THUMT。

OpenKE:一个知识表示学习工具包,提供了标准化的知识表示学习训练和测试框架,集中实现了诸多经典的知识表示模型(RESCAL、DistMult、Trans系列模型、HolE、ComplEx等)。在知识表示学习公开数据集上(FB15K,WN18)均稳定验证效果。OpenKE提供了TensorFlow和PyTorch两种框架接口,可以覆盖大多数开发者需求。OpenKE链接:https://github.com/thunlp/OpenKE

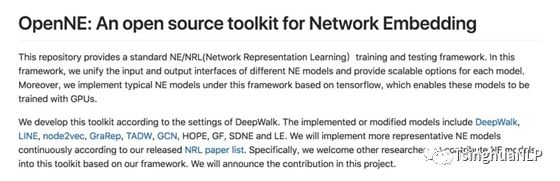

OpenNE:一个网络表示学习工具包,提供了标准化的网络表示学习训练和测试框架,基于TensorFlow实现了DeepWalk、LINE、node2vec、GraRep、TADW和GCN等代表网络表示学习模型,并可以对结果进行分类评测和可视化分析。OpenNE链接:https://github.com/thunlp/OpenNE

OpenNRE:一个神经网络关系抽取工具包,提供了标准化的神经网络关系抽取训练和测试框架,实现了覆盖神经网络编码器、多实例学习策略以及对抗训练、强化学习等降噪模块。大部分神经网络关系抽取模型均可以在该工具包框架中快速复现,并取得稳定模型效能。OpenNRE链接:https://github.com/thunlp/OpenNRE

其他代表工具包还包括:

社会标签推荐工具包THUTag:https://github.com/thunlp/THUTag

中文关键词抽取工具包THUCTC:https://github.com/thunlp/THUCKE

中文文本分类工具包THUCTC:https://github.com/thunlp/THUCTC

未来我们将继续努力,实现更多最新研究成果的开放共享,为自然语言处理技术发展和应用贡献力量!

以上是关于新闻 | 我组NLP系列开源工具在GitHub获得关注超过1万星标的主要内容,如果未能解决你的问题,请参考以下文章