简单的卷积神经网络

Posted 华少的知识宝典

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了简单的卷积神经网络相关的知识,希望对你有一定的参考价值。

写在前面的话

from keras.datasets import mnist(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

网盘链接:https://pan.baidu.com/s/1SG8KShvRzgu0jg6dMn_2HQ提取码:5vxg

import numpy as nppath='./mnist.npz'f = np.load(path)# MNIST数据集里为四个numpy集合train_images, train_labels = f['x_train'], f['y_train']test_images, test_labels = f['x_test'], f['y_test']f.close()

train_images = train_images.reshape((60000, 28, 28, 1))train_images = train_images.astype('float32') / 255test_images = test_images.reshape((10000, 28, 28, 1))test_images = test_images.astype('float32') / 255

这种数据的处理方法会经常用到

from keras.utils import to_categoricaltrain_labels = to_categorical(train_labels)test_labels = to_categorical(test_labels)

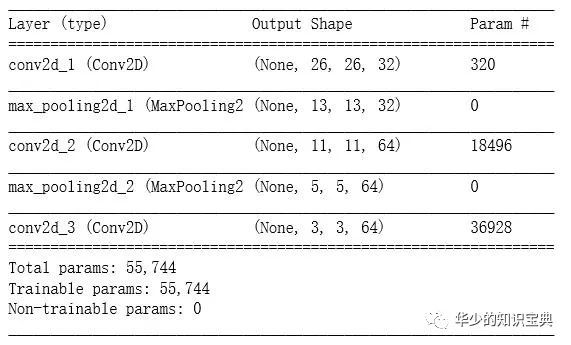

from keras import layersfrom keras import modelsmodel = models.Sequential()model.add(layers.Conv2D(32,(3,3), activation='relu', input_shape=(28,28,1)))model.add(layers.MaxPool2D(2,2))model.add(layers.Conv2D(64,(3,3), activation='relu'))model.add(layers.MaxPool2D(2,2))model.add(layers.Conv2D(64,(3,3), activation='relu'))

model.summary()

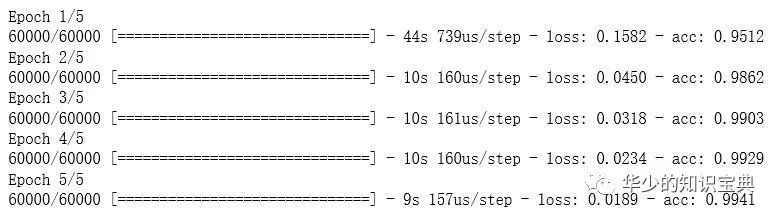

model.compile(optimizer='rmsprop', # 优化器loss='categorical_crossentropy', # 损失函数metrics=['accuracy'])history = model.fit(train_images, train_labels, epochs=5, batch_size=64)

# 可以使用如下程序查看数据,自己探索吧# 这里的第一个 history 是上面模型训练时接收返回数据的一个对象,第二个是对象的 history 属性history.history.acchistory.history.loss

关于 卷积运算 与 最大池化 等的介绍和解释,书上讲的很清楚,就不在赘述了。

以上是关于简单的卷积神经网络的主要内容,如果未能解决你的问题,请参考以下文章