神经网络的深度 vs 宽度

Posted 我AI

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了神经网络的深度 vs 宽度相关的知识,希望对你有一定的参考价值。

“ DAY 9。”

在PRML这本书中,有这么一段话:“Neural networks are therefore said to be universal approximators. For example, a two-layer network with linear outputs can uniformly approximate any continuous function on a compact input domain to arbitrary accuracy provided the network has a suffificiently large number of hidden units.”

简单来说,讲的就是万能近似定理(Universal approximation theorem):一个只有一层隐藏层的神经网络,只要有线性输出层和足够数目的神经元,就能够以任意精度近似任意的连续函数。

我们都知道神经网络本质上可以理解为——对数据进行拟合的算法。既然一个两层的神经网络就能完成对任何复杂数据的拟合,那要深度学习有何用?

打一个不是太恰当的比方:如果神经网络界举办了比美大赛,在相同重量级和同样的才艺表现下,一个高高瘦瘦的深度学习网络和一个矮矮胖胖的宽度学习网络参赛了,谁将能够取胜?

图源[1]

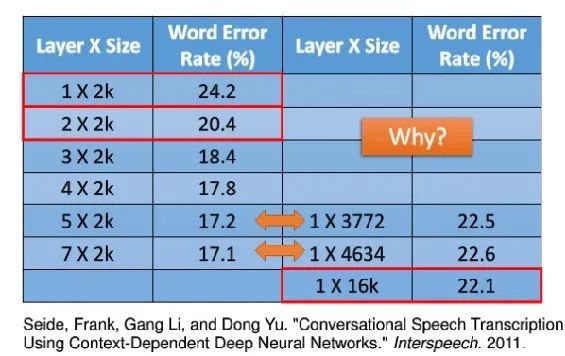

先说结论:深度学习网络的效率更高。从下图中可以看到,几乎相同的参数量下,左边的深度学习网络错误率低于右边的宽度学习网络。这意味着:

比起宽而浅的模型,深而瘦的模型结构表达能力更强、更容易被训练。

图源[1]

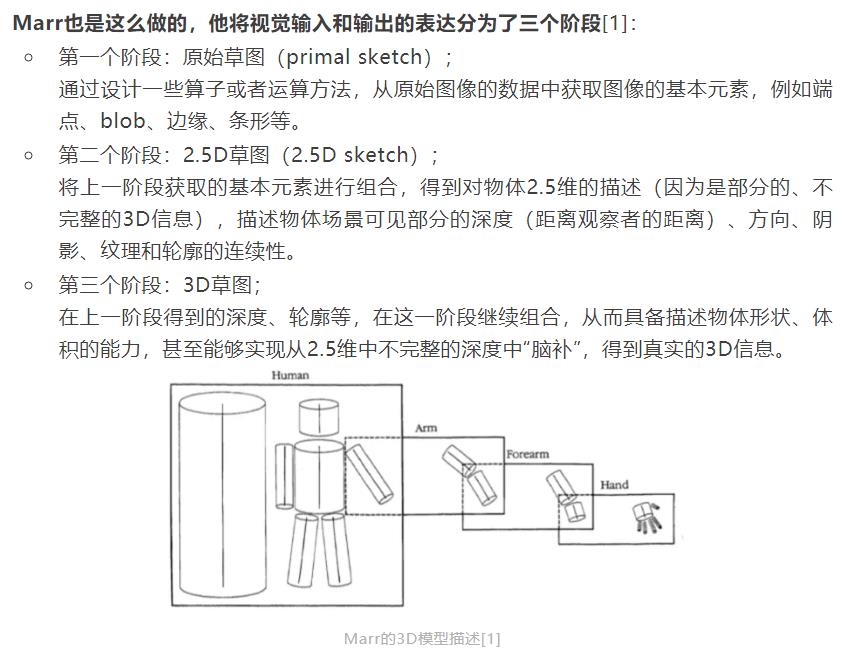

对于这一结论的直观的解释,我们可以在《》这篇文章中找到:视觉中存在着从细节到全局、从具象到抽象的处理过程。这一过程,是以层层递进的方式进行高效的信息传递和处理的。

想看数学证明的勇士,请参见参考资料[2]。

参考资料:

[1] http://speech.ee.ntu.edu.tw/~tlkagk/courses/ML_2017/Lecture/Why.pdf

[2] https://arxiv.org/pdf/1509.08101.pdf

以上是关于神经网络的深度 vs 宽度的主要内容,如果未能解决你的问题,请参考以下文章