近期必读 ICLR 2021 图神经网络相关论文

Posted RUC AI Box

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了近期必读 ICLR 2021 图神经网络相关论文相关的知识,希望对你有一定的参考价值。

导读

我们精选了ICLR 2021中【自监督学习】和【Transformer】话题的论文,为大家带来了论文解读。

本期的关注焦点是图神经网络的8篇论文。接下来我们还将精选自然语言处理、模型压缩等热点领域,为大家带来系列论文解读,敬请关注。点击文末“阅读原文”,获取正在接受盲审的论文列表。

图神经网络

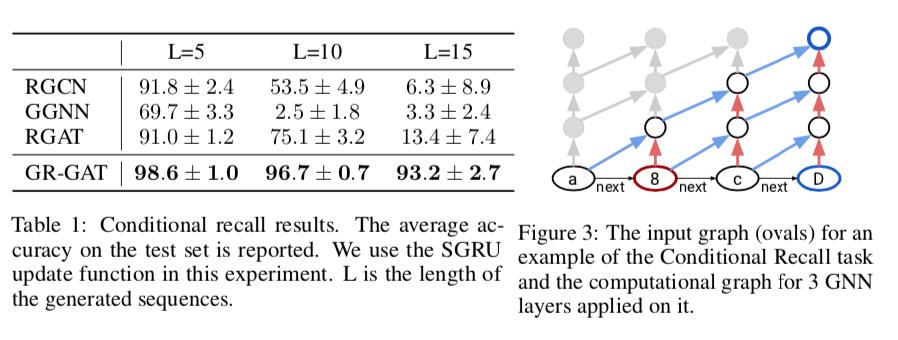

Gated Relational Graph Attention Networks

本文将门控机制引入RGAT中,利用门控信号解决关系参数过多导致的模型泛化能力差,同时为了克服GNN模型中的过平滑问题,文中将GRU结构进行改造以进行层间隐状态更新,缓解信息的丢失。另外,本文使用了一种参数更少但性能不减的attention机制。  论文链接:https://openreview.net/forum?id=v-9E8egy_i¬eId=v-9E8egy_i

论文链接:https://openreview.net/forum?id=v-9E8egy_i¬eId=v-9E8egy_i

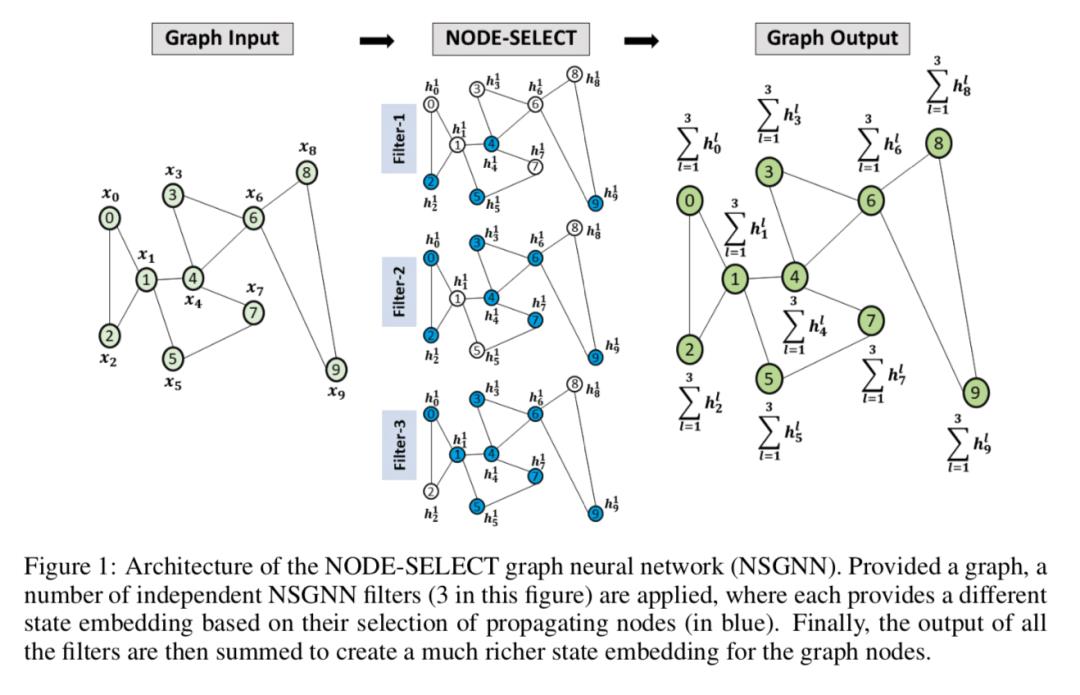

Node-Select: A Flexible Graph Neural

如何协调节点的全局信息和局部信息一直是GNN模型所改进的方向,本文提出一种节点选择算法,使用不同的参数选择出不同比例的子图来模拟节点的全局信息传递和局部信息传递,最终综合各个子图结果得到嵌入向量,成功降低了模型的过拟合。  论文链接:https://openreview.net/forum?id=KfRtxjqU-Hd¬eId=KfRtxjqU-Hd

论文链接:https://openreview.net/forum?id=KfRtxjqU-Hd¬eId=KfRtxjqU-Hd

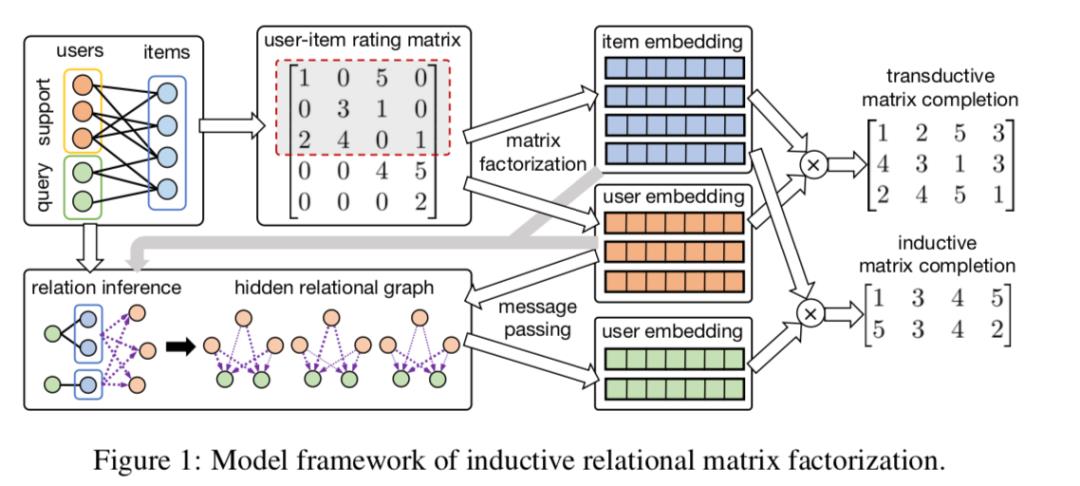

Inductive Collaborative Filtering via Relation Graph Learning

协同过滤(CF)算法往往都是直推式,不能在新用户上产生合理的嵌入向量,而一些其他研究尝试利用额外特征或连接关系建立冷启动的模型,但是特征难以获得,所以本文尝试仅仅使用交互矩阵,建立用户之间的相似度图,从而使用已有用户模拟新用户,来达到归纳式协同过滤模型。  论文链接:https://openreview.net/forum?id=xfNotLXwtQb¬eId=xfNotLXwtQb

论文链接:https://openreview.net/forum?id=xfNotLXwtQb¬eId=xfNotLXwtQb

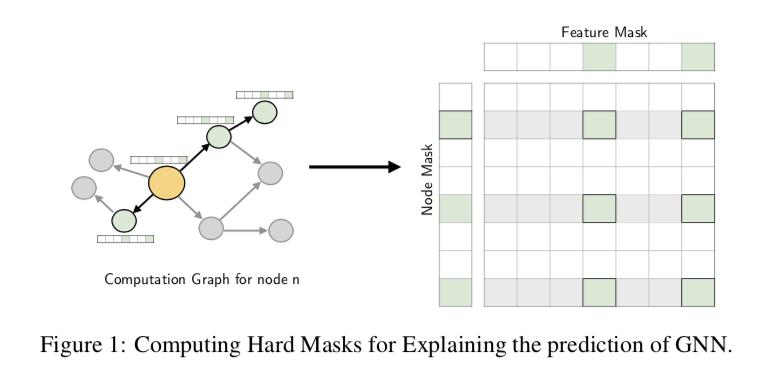

Hard Masking for Explaining Graph Neural

本文尝试从数据压缩的角度解释GNN模型是如何产生预测结果的,其在节点集和特征集上使用贪心的选择算法,找到对结果影响最小的集合作为噪声信息,并将稀疏的集合选择信息作为解释,能够在一定程度上找到GNN的计算过程机理。

论文链接:https://openreview.net/forum?id=uDN8pRAdsoC¬eId=uDN8pRAdsoC

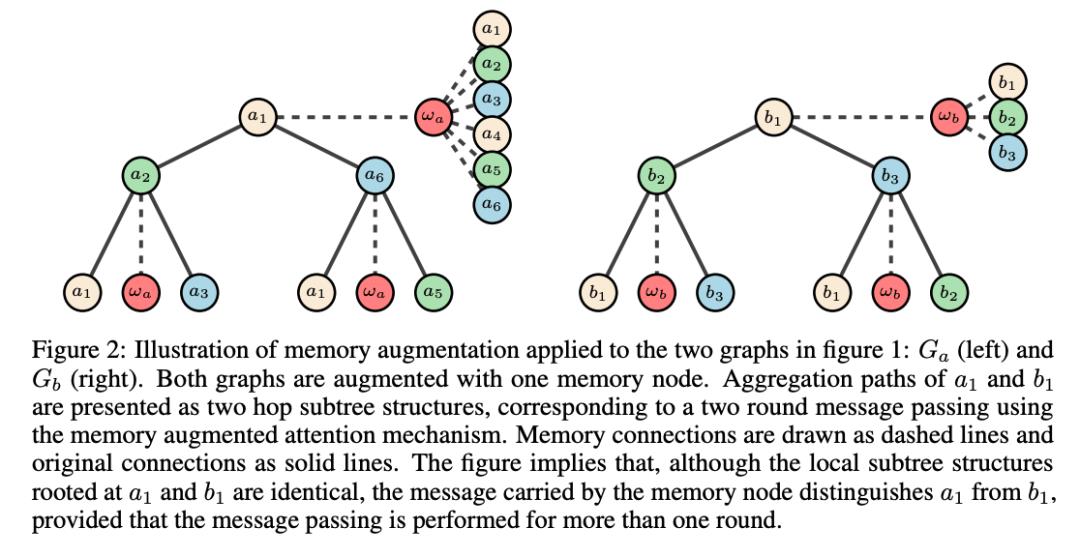

Memory Augmented Design of Graph Neural Networks

本文从节点分类的角度分析了本地无序消息传递(LUMP)对GNN表示能力的限制,并提出内存增强(Memory Augment)框架来使用全局信息增强GNN的表示能力。具体地,内存增强框架下的GNN允许原始图中的每个节点与一组内存节点(memory nodes)交互,每个节点可通过内存节点捕获图中所有其他节点的信息。  论文链接:https://openreview.net/forum?id=K6YbHUIWHOy¬eId=K6YbHUIWHOy

论文链接:https://openreview.net/forum?id=K6YbHUIWHOy¬eId=K6YbHUIWHOy

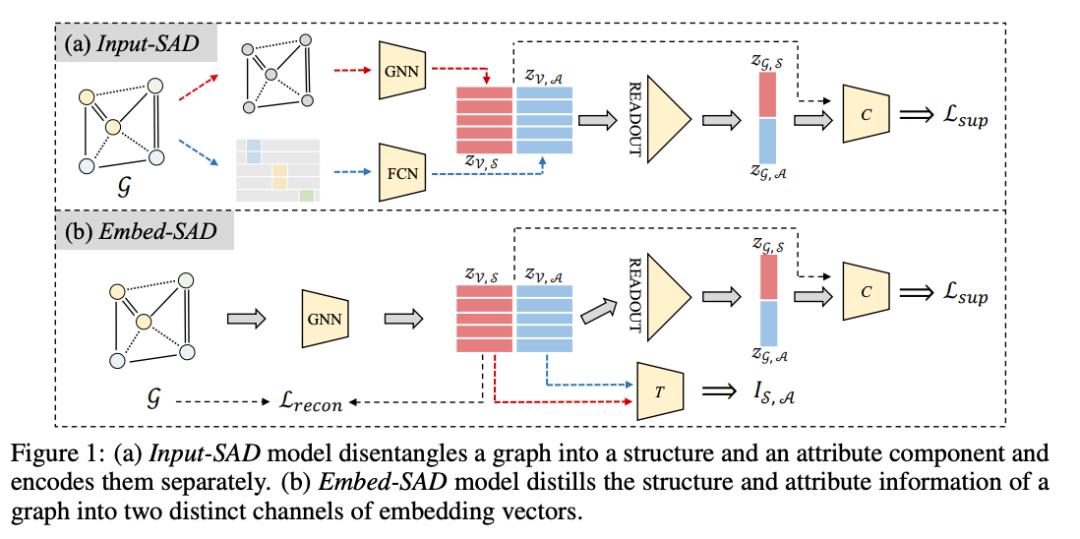

GraphSAD: Learning Graph Representations with Structure-Attribute Disentanglement

GNN通过聚合相邻节点的属性来学习得到混合了图结构和节点属性信息的单一节点/图表示,但这两种信息可能在语义上不一致,并可能对不同的任务有用。为此,本文提出GraphSAD来学习解耦了结构-属性信息的节点/图表示,这种解耦可以在输入空间或嵌入空间中完成。此外,本文还设计了一个度量标准来量化解耦程度。  论文链接:https://openreview.net/forum?id=ZS-9XoX20AV¬eId=ZS-9XoX20AV

论文链接:https://openreview.net/forum?id=ZS-9XoX20AV¬eId=ZS-9XoX20AV

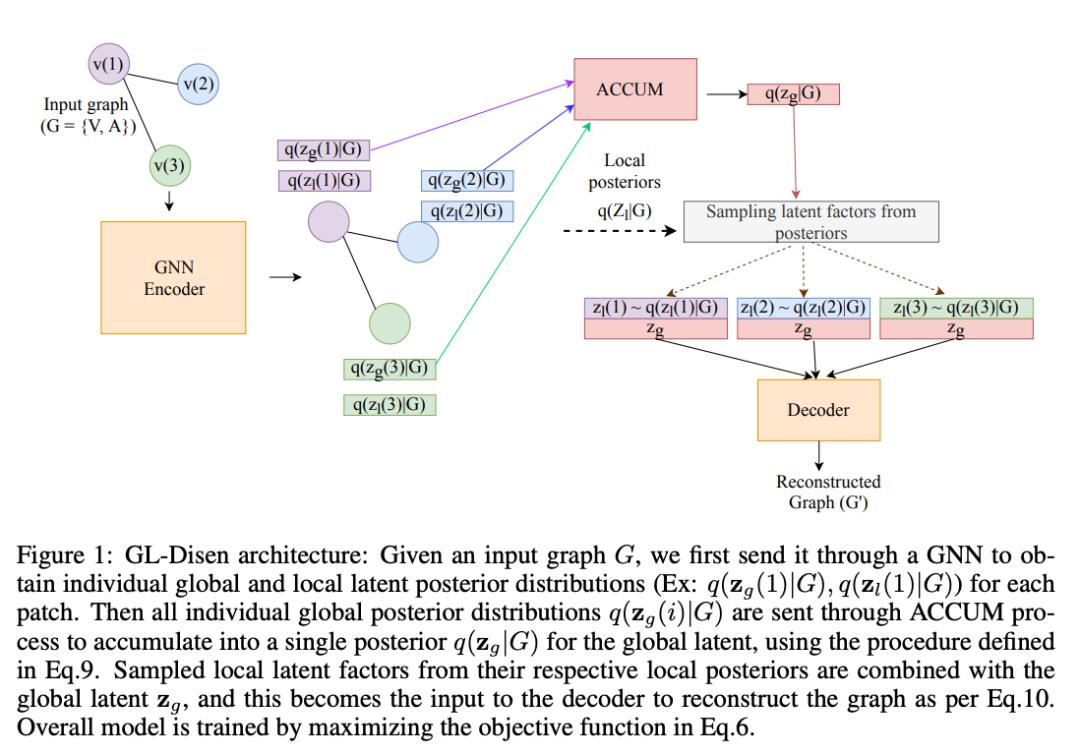

GL-Disen: Global-Local disentanglement for unsupervised learning of graph-level representations

现实世界中图(Graph)的形成是全局和本地因素共同作用的复杂过程,本文假设在学习图表示时解耦全局和本地的信息对下游任务是非常有益的,为此,本文提出一种基于VAE的无监督学习算法来解耦全局的graph-level信息和局部的patch-level信息,实验证明该方法在无监督图表示学习任务上取得了最先进的性能。

论文链接:https://openreview.net/forum?id=PmUGXmOY1wK¬eId=PmUGXmOY1wK

HyperSAGE: Generalizing Inductive Representation Learning on Hypergraphs

目前超图上的GNN模型大多数首先将超图结构转换为一般图,这种转换会导致信息丢失,不能很好地利用超图的表达能力。本文提出的HyperSAGE是一种用于超图表示学习的广义归纳性方法,它使用一个两级的信息传递策略,在不丢失任何信息的情况下充分利用超图的表达能力。

论文链接:https://openreview.net/forum?id=cKnKJcTPRcV¬eId=cKnKJcTPRcV

更多推荐

以上是关于近期必读 ICLR 2021 图神经网络相关论文的主要内容,如果未能解决你的问题,请参考以下文章

深度学习热度下降,图神经网络BERT崛起,ICLR 2020提交论文主题分析