趣味马克思主义基本原理——从神经网络看唯物论

Posted 生活在海大

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了趣味马克思主义基本原理——从神经网络看唯物论相关的知识,希望对你有一定的参考价值。

趣味马克思主义

基

本

原理

从神经网络看唯物论

专题简介

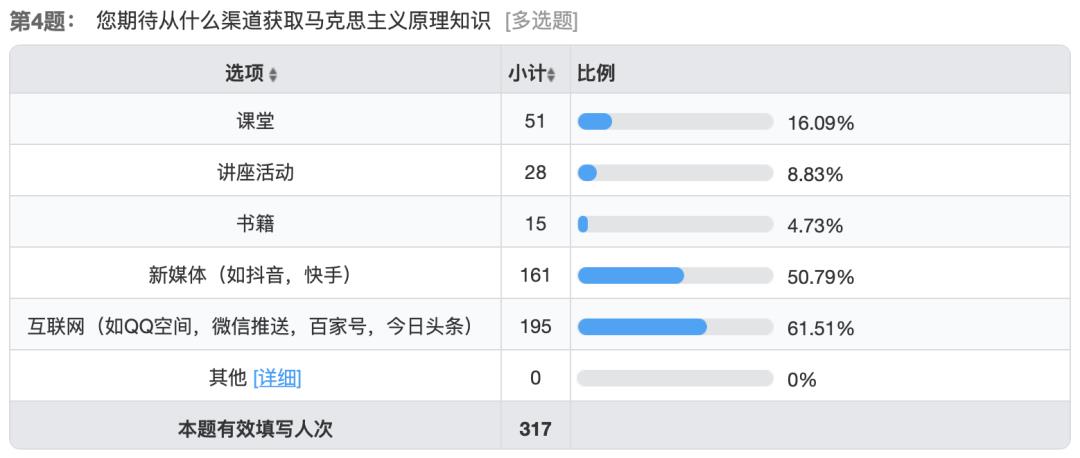

WHY

首先,来谈一谈本专栏的目的,在“对于马克思主义基本原理传播途径”的调查问卷中,在第四问传播途径上,排名第一的渠道就是互联网,而目前在互联网,特别是H5平台上,对于马克思主义基本原理的内容相当匮乏,我们将借此机会,创作更多传播马克思主义基本原理的内容,并且分析在不同平台上传播的特点,为往后马克思主义基本原理的传播提供帮助。

文章主题

MAIN

01

文章主题

本期的主题为高等教育出版社出版《马克思主义基本原理》第一章“世界的物质性及发展规律”中内容。

02

风格

本文结合工科领域的机器学习与神经网络(人工智能)相关内容。希望能增进同学们对唯物论的理解。

正文

ARTICLE

从神经网络看唯物论

唯物论,即唯物主义,认为世界的统一性在于它的物质性。物质决定意识,物质是第一性,意识是第二性。

如今,人工智能高速发展,渗透到了我们生活的方方面面。但若究其原理,人工智能为何能够完成只有人类才能做到的事情,比如与人类进行对话,对物体进行识别,甚至是人类都无法实现的事情,难道它们也拥有意识吗?难道意识能够脱离唯一的载体——人脑而存在吗?答案是否定的。

我们若是分析人工神经网络的原理,就可以发现,人工智能的存在恰恰进一步验证了唯物论。

这里以能够处理序列信息的循环神经网络(RNN)为例。

在传统的神经网络中,各个输入在算法内部是相对独立的,无法从先前的信息中进行推理,难以处理序列类型的数据。在BP算法提出之后,学者和研究员们又提出了具有短期记忆能力的循环神经网络。RNN能记住之前的输入值,即使后面有相同的输入,输出值也会不同。目前已被广泛应用在语音识别,语言模型以及自然语言生成等任务上。

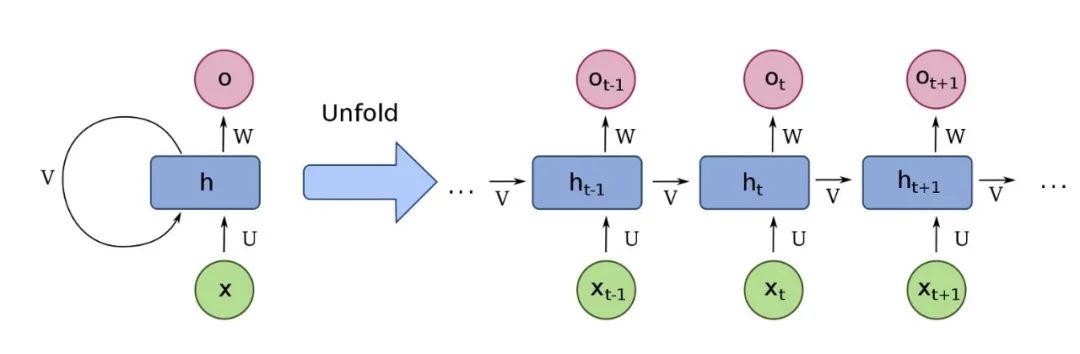

RNN的基本结构如下图所示,左侧是RNN网络,右侧是RNN网络按时序展开的形式。

在传统神经网络输入层——隐藏层——输出层的基础上增加了一个类似于延时器的单元,能够记录上一次的输出值,并带到下一次的输入当中,以此记录最近几次的活性值V,RNN也由此具备了短期记忆能力。

将RNN按时序展开就可以得到RNN的结构

- 代表t时刻的输入

- 代表t时刻隐藏层的状态

- 代表t时刻的输出

- 代表输入层到隐藏层的权重

- V代表隐藏状态到下一隐藏状态的权重

- W代表隐藏层到输出层的权重

U,V,W是该模型中的线性关系参数,它在整个网络中是共享的,体现出RNN模型“循环反馈”的思想。

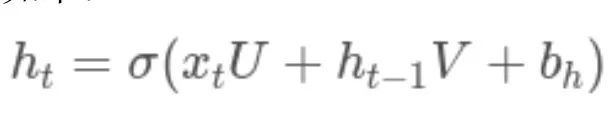

时刻t为参数进行循环。虽然每一时刻的输入不同,但其对应的结构不变,所以每一次循环就相当于在进行递归,递推公式如下:

其中为RNN的激活函数,一般为tanh。是该线性关系中的的偏置。

最终输出的表达式为:

激活函数一般是softmax。是该线性关系中的的偏置。

类似于传统神经网络,RNN神经网络的反向传播算法思路也是通过梯度下降法一轮轮的选代。由于是基于时间的反向传播,所以将RNN神经网络的反向传播命名为BPTT(back-propagation through time)。我们利用反向传播算法将输出层的误差加和,然后对各个权重的参数矩阵求梯度,再利用梯度下降法更新各个权重。

对于每一时刻t的RNN网络,网络的输出在每个时刻都会产生损失。那么总的损失为。我们的目标就是要求取对的偏导。

对于预测结果的任意损失函数,求取是最简单的,我们可以直接求取每个时刻的,由于它不存在和之前的依赖状态,可以直接求导取得,然后简单求和即可,算式如下:

然而,在计算t时刻损失产生的梯度时,必须回溯之前所有时刻的信息。但是我们会发现一个问题,即最后要对所有时刻的梯度进行累加。而每个时刻都是在后一个时刻的基础上进行累乘的结果。若累乘的次数过于庞大,每次都连续乘一个小于1的数字,就会导致最终结果趋近于0,即梯度消失。反之,当每次都连续乘一个大于1的数字,就会导致最终的结果趋近于无穷,即梯度爆炸。

为了克服梯度爆炸和梯度消失问题,最直观的想法就是使。梯度裁剪,通过把沿梯度下降方向的步长限制在一个范围内,解决了梯度爆炸的问题,但梯度消失的问题仍难以解决。1997年,Hochreiter和Schmidhuber首先提出了LSTM的网络结构,通过CEC(constant error carrousel)单元,控制其结果为0或接近于1,解决了传统RNN的这一缺陷。

通过对循环神经网络的推导,我们可以看出,人工智能的“智能”其实都是有据可循的,都是通过数据转换和数学计算得出的,完全符合唯物论的观点。

排版 | 罗盟之

封面 | 罗盟之

文字 | 柴昱

以上是关于趣味马克思主义基本原理——从神经网络看唯物论的主要内容,如果未能解决你的问题,请参考以下文章