图结构: 分析神经网络的新视角-2

Posted 壁仞科技研究院

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了图结构: 分析神经网络的新视角-2相关的知识,希望对你有一定的参考价值。

摘要

本文是对两位机器学习领军人物的新作Graph Structure of Neural Networks的解析。该论文从神经网络连接关系的视角重新定义了一种图结构来表达神经网络模型,并从图结构本身的属性来分析什么样的神经网络模型会具有好的预测性能。

本研究由相关领域的顶尖学者发起,并非传统意义的DNN新方法研究,而是探索了神经网络性能分析的新的方向。几位作者开创性的提出用图结构(graph structure)而非计算结构(computation structure)来分析神经网络的性能。这项工作可以说是开拓了一个新的研究方向,可能会对DNN的设计、结构优化与提升性能带来一些全新的思路。它对于DNN结构探索、自动DNN构建等工作也将会起到促进作用。

我们从这项研究本身的内容和所涉及的相关图理论背景进行了深入理解。因篇幅较长,将介绍分为两部分:(1)对文章内容的理解;(2)结合图理论背景知识进一步理解文章的主要概念及重要意义。上一期我们介绍了第一部分,本篇是第二部分。

通过探索不同网络结构及性能来得到最优的神经网络模型是目前机器学习的重要探索方向。主流的思路是用大算力暴力探索不同网络结构组合来达到目标。这对计算资源提出了巨大的挑战。与这种基于经验归纳的模式不同,推演模式以一定理论指导通过推导得到最优的模型设计,从而降低计算量的需求。比如,可以找到某种高性能神经网络模型共有的特性,进而根据该特性来设计DNN模型。

“Graph Structure of Neural Networks”[1]从神经网络图结构的角度研究了这一问题。这是ICML2020收录的一篇文章,由Kaiming He和Jure Leskovec等合作完成。作者提出了”关系图”(relational graph)的概念来表达层间组合神经元的互动,进而系统性研究了神经网络结构与性能的关系。如作者指出,文[1]最重要的贡献是转换研究思路,从神经网络图结构而不是计算架构来分析DNN。通过实验验证,他们认为对这一方法更广泛深入的探索将促进DNN发展。

我们之前已经对文[1]进行了初步解读。本篇尝试结合图理论的知识来深入理解文[1]的相关的概念及内容。

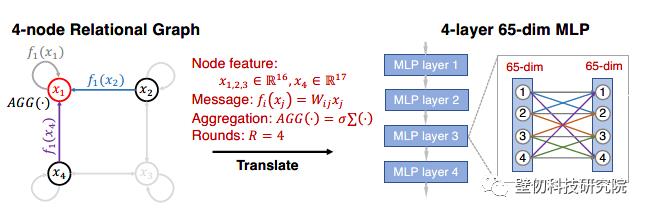

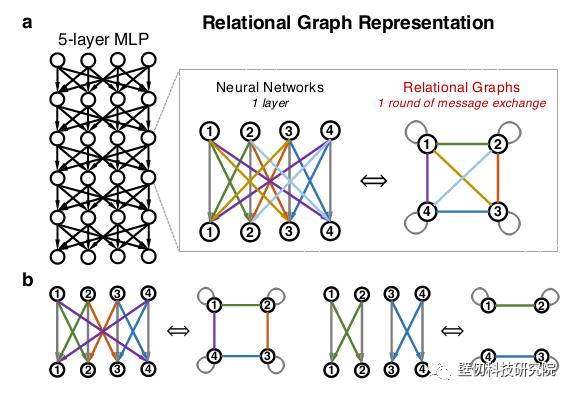

Graph Structure of Neural Networks一文定义了关系图(relational graph)来描述神经网络的图结构特征。为避免混淆,下文中我们一般用“图“来代表图网络,以区分神经”网络“。关系图中的每一个节点对应神经网络两层间的一对输入与输出通道/维度,多个节点代表多个通道,如图1所示。节点间的边表达了神经元对于其它对之间的数据输入输出双向关系:消息交换(message exchange)。

图1 关系图[1]

图1中关系图对应的DNN宽度固定,每层输入输出维度不变时,关系图所有节点均与其它节点连结,称之为完全关系图。

图节点与神经网络通道的一对多映射

需要注意的是关系图中的节点与神经元并非一一对应。比如图2的4节点关系图对应65维MLP。其中三个节点对应16维通道(神经元),另一节点对应剩余17维通道。作者采用了一个简单策略来划分神经网络层的节点。假定节点数为n,神经网络层的维度为m,对于m mod n个数的节点分配[m/n]+1维,其余节点分配[m/n]维。相信其它方案也适用于节点划分。

按照上述操作,即使多层神经网络的每层维度不同,关系图节点数也是固定的。关系图最大可选节点数由DNN模型最窄一层的维度来约束的。当然,由于一对多的映射,图节点数可以小于DNN的最窄的维度。

图2 多维神经网络层与关系图节点的对应[1]

关系图的一个核心是节点间的消息交换。这个也是“relational”的由来。因此作者将由消息交换为边特性的图结构定义为关系图。更具体的,消息交换有两个函数组成:message function和aggregation function。Message function的输入是节点特征,输出是message,而aggregation function的输入是一组messages,输出为更新的节点。很显然,这一概念与图神经网络(GNN)中的消息传递机制有类似之处。文[1]中,作者也认为可以把关系图看作GNN的输入。

一般地,message function是输入节点的权积,聚合函数为组合消息的非线性变换,二者合并为消息聚合函数。若第r轮节点特征为 ,对于第r+1轮的节点

,对于第r+1轮的节点 的特征有:

的特征有:

关系图Round与 神经网络layer的关系

关系图的一次消息交换操作代表了NN模型中两层之间的一次数据传递。因此,多层神经网络并不表达为多层图结构,而是由相同的一个关系图来表达,层与层之间的一次数据传递是关系图的一轮(round)消息传递。也就是说,多层神经网络由一个关系图,多轮信息交换来表达。需要注意的是,尽管关系图不变,但每个节点对应的维度及数量在不同的round是可以变化的。

神经网络对应的图节点消息函数

不同神经网络结构的消息函数不同。对于MLP,其消息函数为:

如果关系图的节点数目与DNN层的维度相同,则上述公式的xj为标量,所以消息函数与MLP单层更新公式一致。但是如果类似图2,一个节点代表多个维度,则公式中节点特征是一个代表多个神经元的向量。这种情况下,关系图消息函数与DNN网络层更新公式是有区别的。

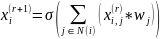

卷积网络与关系图

很显然,不同神经网络的消息与聚合函数的定义有所不同。文中表1列出了几种神经网络(多层感知器,Resnet等)的消息与聚合函数的定义。尽管原文没有直接给出,参照上述定义,我们也可以构造出卷积网络和关系图的对应关系。具体例子如下。

对于CNN,卷积层输入输出维度分别分组后,每组为一个节点。输入与上一层的输出形成关系图节点(r round节点)。其消息函数可以表达为:

其中,i,j分别代表输入(r轮)输出(r+1)轮节点的index。Wj是与输入输出对应的部分channel卷积核。

图3卷积网与关系图

以图3为例,卷积核w为4x6x3x3的tensor,input层维度为4,output层维度为6。对应的关系图有4个节点。节点0是输入tensor第0通道与输出tensor第0通道组成的消息对。图中节点0的邻域N是节点(1,2,3),即包括卷积网络所有输入通道,因此其权重对应的是卷积核第0输出通道,即w[0, :, : ,: ]。而对于节点4,其权重对应的是卷积核第4,5输出通道,w[4:5, :, :, :]。

作者在文[1]提出了产生满足一定图特性的神经网络模型的方法。其中涉及到两个图理论中的概念:图度量,图生成。

4.1 图度量

图度量用来描述一个图的特性。作者选取全局度量平均路径长度(average path length)和局域度量聚合系数(clustering efficient)作为关系图特性的度量。

两个节点间的路径长度是连通两节点的最少边数。Graph的平均路径长度是网络中任意节点间路径长度的平均值。这是一个全局特征度量。

网络聚合系数(C):

一个节点的聚合系数定义为其邻域节点间的实际边数与所有可能边数的比值。网络的聚合系数则是所有节点聚合系数的均值。它描述了图网络的局部特征。

为什么选取这两个度量?一方面作者其实也对比了很多其它的度量,最后在正文中选取了这两个度量。另一方面,本文所用到的图网络理论可以归类到复杂网络理论的一部分。而平均路径长度与网络聚合系数是复杂网络理论中用来描述图网络特性的常用度量。

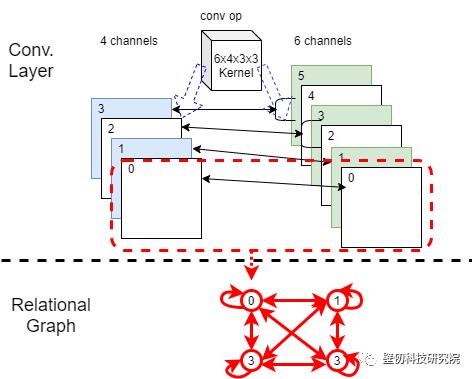

图4 几种神经网络结构及对应的关系图[1]

我们用图4所列出的几个简单例子来直观理解图度量。

图a的关系图是节点间完全连接,所有节点两两相连C=L=1。

图b左边的神经网络对应的关系图中, 每个节点的平均路径长度均为(1+1+2)/3=4/3,即整个网络的L=4/3。每个节点的聚合系数为2/3, 所以网络的平均聚合系数C为2/3。

图b右边的神经网络分为不连通的两部分,关系图表现为下对称两部分。每个节点聚合系数为1,而整个网络C=1。记不相连节点长度为0,则单个节点的平均路径长度为1/3,网络的平均路径长度为1/3。注意,如果将图b右侧关系图中的消息函数用CNN的函数代替,则对应的神经网络可以理解为类似group CNN的模型。

4.2 图的生成

文章测试了6种图生成器来产生满足度量条件的关系图,分别是ER,WS,BA, Haray,完全图,环状网格图。其中前四种模型均是图理论领域学者提出的。它们可以产生满足某类网络特性的图生成模型。

完全图是所有节点互联的网络,图1(a)的关系图即为一个完全图。环状网格图是Watts-Strogatz(WS)模型的基础,其结构类似图5左侧图。

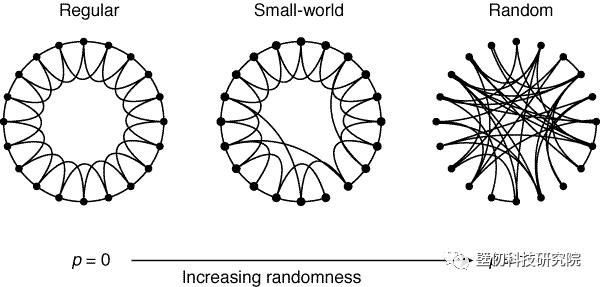

作者比较了这些生成器后,提出了改进的Watts-Strogatz(WS)-flex图生成器。Watts-Strogatz模型是心理学家 DuncanJ. Watts和他的导师 StevenStrogatz 1998年在Nature上发表的一篇文章上提出的[2]。在这篇文章中他们提出了小世界网络概念,用来解释著名的小世界现象,即六度分隔:世界上任意两个人从平均意义上都可以通过六个人联系起来。他们提出小世界网络是具有聚合系数高,而平均路径长度短的特点的一种复杂网络。他们同时提出了生成具有上述特点网络的模型,即Watts-Strogatz模型,如图5所示。

WS模型生成模型的大致步骤是:

1 构建给定节点数目的规则图。

2 以给定重连概率将节点的边随机连接到其它节点。

图5 环网格图与小世界网络[2]

文[1]提出的WS-flex模型则更进一步规定规则图中所有节点的degree相同。这样泛化了模型的生成能力,从而可以产生本文期望的关系网。如文[1]所述,WS-flex生成器有三个参数:节点数n,平均度数k,重连概率p,则要生成的网络的边数为e=[n*k/2]。生成器首先产生一个ring网络,其每个节点连接e/n个邻居节点。然后生成器随机选取e mod n 节点,并将每个选取的节点与最近的一个邻接节点连接。最后以概率p对产生的网络做随机重连。

用上述方法产生图,并计算其聚集系数C和最短路径L。作者发现WS-flex生成的关系图能够最大的覆盖C-L度量定义的空间。

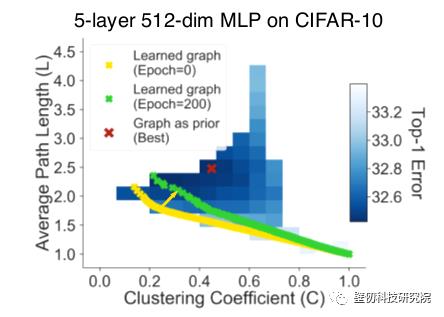

通过分析不同C-L组合的神经网络,文[1]得到一个有趣的结论:在关系图属性位于sweet spot (C[0.10,0.50], L[1.82,2.75])的DNN模型预测性能好。相对于实验设定的64节点网络设置,这类网络聚合系数较高,而平均路径长度短。从前述网络理论可知,这样的网络符合小世界网络的特征。

有意思的是,作者还对比了猫脑和猴脑皮层神经。无论是度量上还是呈现的图模式上,这些生物的神经结构都和基于关系图的最优神经网络类似 — 这再次验证了早期学者对神经网络在生物上的类比描述。

当然,sweet spot的结论仅适用于按照文中方式产生的DNN模型。作者实验发现,如果不施加图结构先验,而是直接通过模型剪枝等方式优化得到的DNN模型,其图结构与施加先验的模型并不一致。如图6所示。

图6 不同生成方式得到的最优神经网络模型([1])

此外,原文关系图以神经网络的单层为单位来构造整个DNN网络,要求每层都可以用相同的图结构表达。这限制了对一般神经网络更复杂结构的构建,比如具有hierarchical结构的深度神经网络。

拓展思考

文[1]是一个开创性的工作,在提出新的思路及方法框架时,也留给我们许多可以深入探讨的地方,比如:

作者尝试了多种图度量来表达关系图结构。如前文介绍,作者在正文中以平均路径长度和聚合系数为指标来指导关系图及神经网络性能,同时也列出了其它图度量下神经网路的性能变化。尽管大致趋势类似,但各度量下的神经网络性能分布还是有所不同。

平均路径长度和聚合系数是图理论中常用的两个度量。但这种经验性的选择是否适合神经网络的性能表达?是否存在更合适的图度量组合,甚至可以从理论上证明?这些相关问题或许是下一步研究可以探讨的地方。

另外一个相关的问题是图度量在图神经网络的拓展。可否借鉴文[1]思路来评价GNN网络中数据的质量、特性?我们知道GNN的输入数据表达为图结构,而其结构特点会影响到实现算法与运算硬件的执行性能。如果能够确定一组合适的度量来分析数据结构的内在特性,那么这样的度量对于确定GNN模型和优化无疑会起到指导作用。

本篇是对Graph Structure of Neural Networks一文介绍的第二部分,主要是对文章中涉及的图理论部分内容进行更进一步的理解。期望有助于和大家一起理解几位作者的思路和把握该项研究的进展,并促进在这个方向的开拓性工作。

本文希望能够起到抛砖引玉的作用,由于水平有限,文中存在不足的地方,请各位读者批评指正,也欢迎大家参与我们的讨论。

[1] Jiaxuan You, Jure Leskovec, Kaiming He and Saining Xie,Graph Structure of Neural Networks,ICML2020

[2] Collective dynamics of ‘small-world’ networks, Duncan J. Watts, StevenH. Strogatz , Nature volume 393, pages440–442(1998)

壁仞科技研究院作为壁仞科技的前沿研究部门,旨在研究新型智能计算系统的关键技术,重点关注新型架构,先进编译技术和设计方法学,并将逐渐拓展研究方向,探索未来智能系统的各种可能。壁仞科技研究院秉持开放的原则,将积极投入各类产学研合作并参与开源社区的建设,为相关领域的技术进步做出自己的贡献。

以上是关于图结构: 分析神经网络的新视角-2的主要内容,如果未能解决你的问题,请参考以下文章

[阿里DIEN] 深度兴趣进化网络源码分析 之 Keras版本

ICML 2022 重思考为图结构数据异常检测设计图神经网络 | 图数据异常节点检测 | 论文解读和代码复现