支持向量机——核函数与支持向量回归(附Python代码)

Posted 机器学习学习机器

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了支持向量机——核函数与支持向量回归(附Python代码)相关的知识,希望对你有一定的参考价值。

没错,支持向量机除了可以解决分类问题之外,还可以处理回归问题。

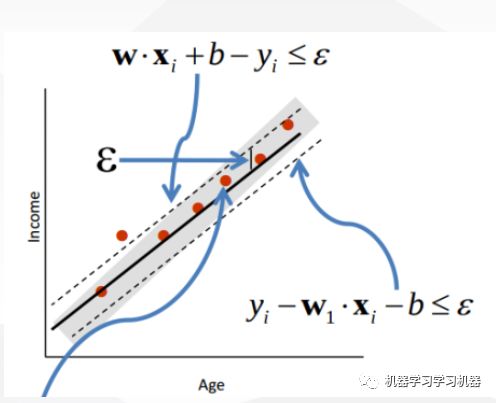

与一般回归不一样的是,支持向量回归会允许模型有一定的的偏差,在偏差范围之内的点,模型不认为他们有问题,而偏差范围之外的点就会计入损失。所以对于支持向量回归来说,支持向量以内的点都会影响模型,而支持向量之外的点用于计算损失。

优点:

有效性:解决高维特征的分类问题和回归问题很有效,在特征维度大于样本数时依然有很好的效果;

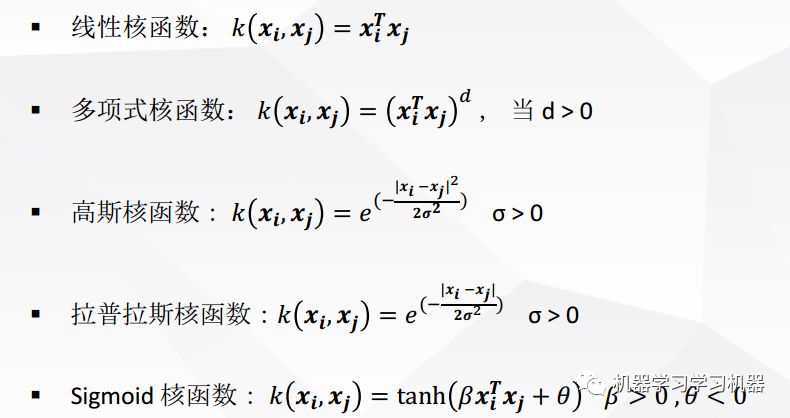

核函数可以很灵活的来解决各种非线性的分类回归问题

稀疏性:仅仅使用支持向量来做超平面的决定,无需使用全部数据。

样本量不是海量数据的时候,分类准确率高,泛化能力强

缺点:

SVM在样本量非常大,核函数映射维度非常高时,计算量过大,不太适合使用

SVM对缺失数据敏感

如果特征维度远远大于样本数,则SVM表现一般

Python实例(使用jupyter Notebook打开):

链接:https://pan.baidu.com/s/1TGEMIiqWvg1m3lJI1uWFxw 密码:cphe

每天一点点,生活大不同,欢迎你们活碰乱跳给我留言,也鼓励点赞转发。

以上是关于支持向量机——核函数与支持向量回归(附Python代码)的主要内容,如果未能解决你的问题,请参考以下文章