IDEA开发Spark应用实战(Scala)

Posted 程序员欣宸

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了IDEA开发Spark应用实战(Scala)相关的知识,希望对你有一定的参考价值。

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:原创文章分类汇总及配套源码,涉及Java、Docker、K8S、Devops等

Scala语言在函数式编程方面的优势适合Spark应用开发,IDEA是我们常用的IDE工具,今天就来实战IDEA开发Scala版的Spark应用;

版本信息

以下是开发环境:

-

操作系统:win10; -

JDK:1.8.0_191; -

IntelliJ IDEA:2018.2.4 (Ultimate Edition)

以下是运行环境:

-

Spark:2.3.3; -

Scala:2.11.12; -

Hadoop:2.7.7;

如果您想在几分钟之内搭建好Spark集群环境,请参考《》;

下载Spark安装包

-

去spark官网下载spark安装包,里面有开发时所需的库,如下图,地址是:http://spark.apache.org/downloads.html -

将下载好的文件解压,例如我这里解压后所在目录是:C:\software\spark-2.3.3-bin-hadoop2.7

IDEA安装scala插件

-

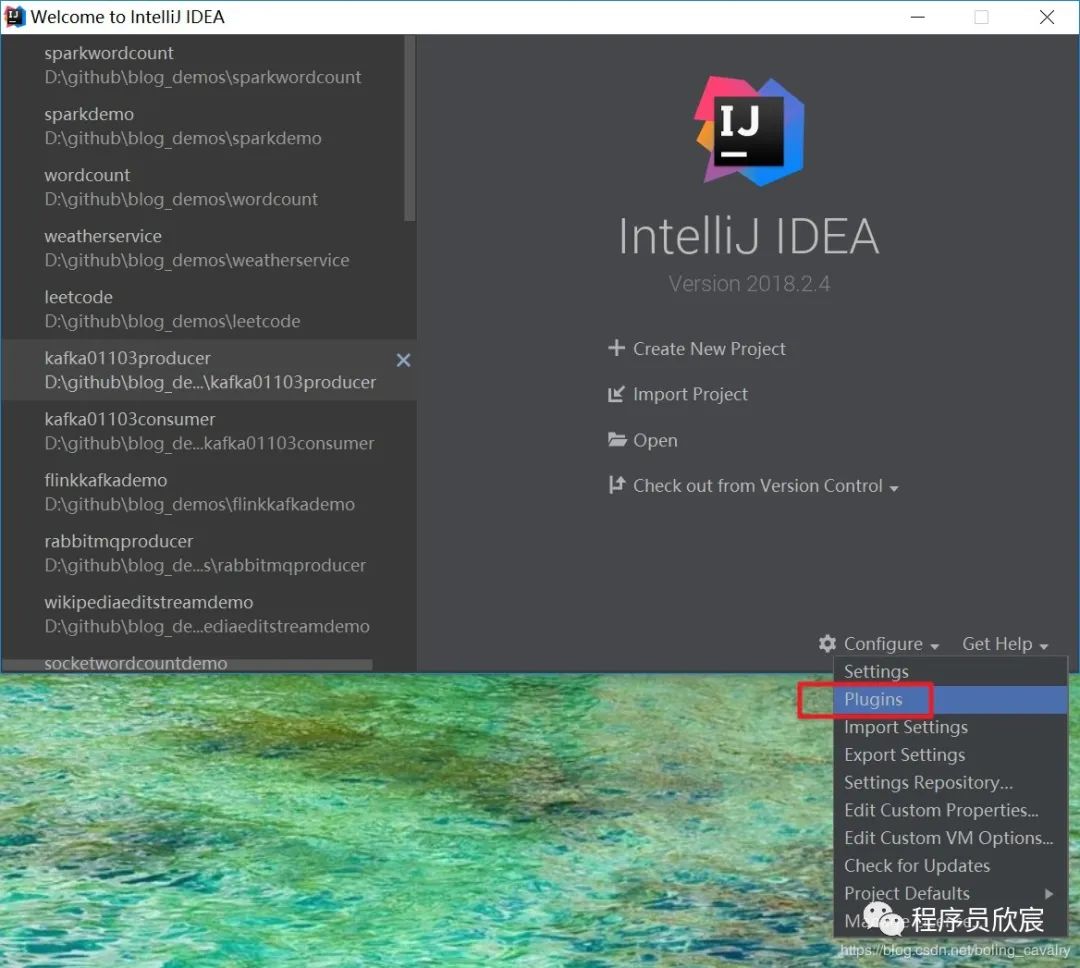

打开IDEA,选择"Configure"->"Plugins",如下图:

-

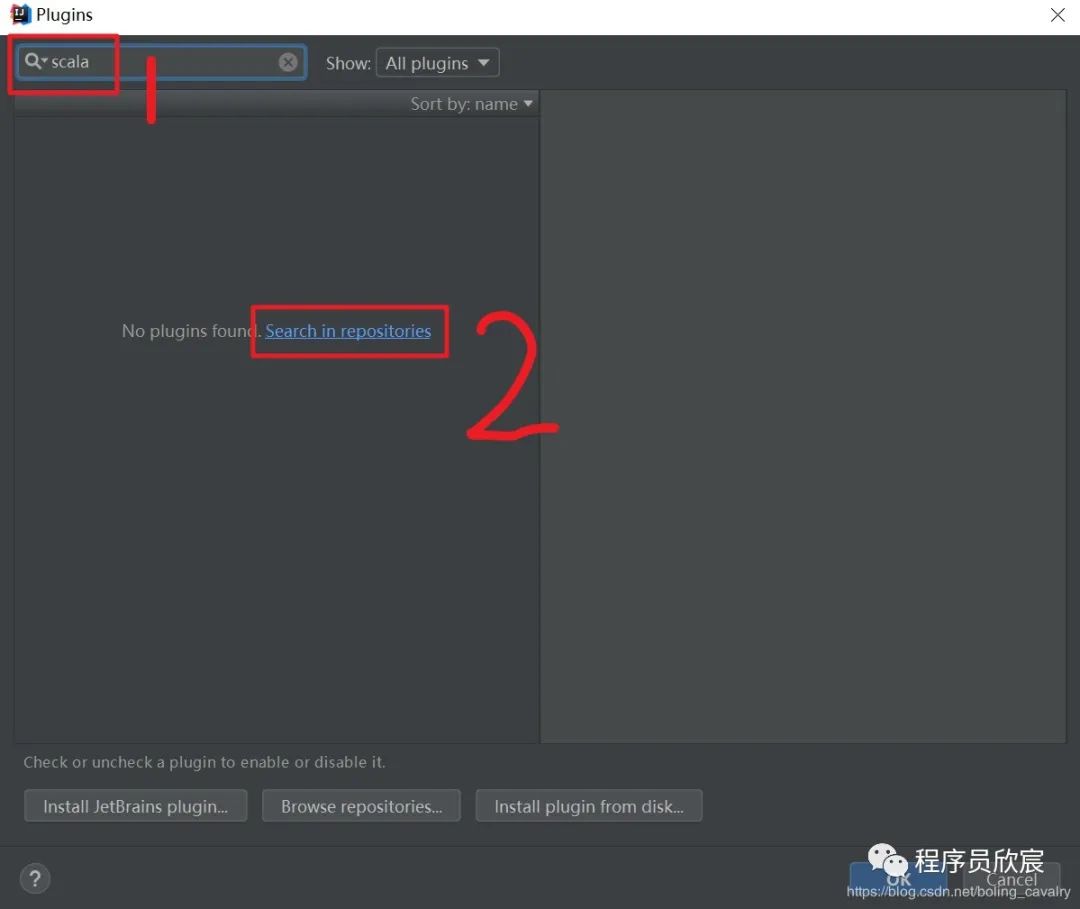

如下图,在红框1输入"scala",点击红框2,开始在中央仓库搜索:

-

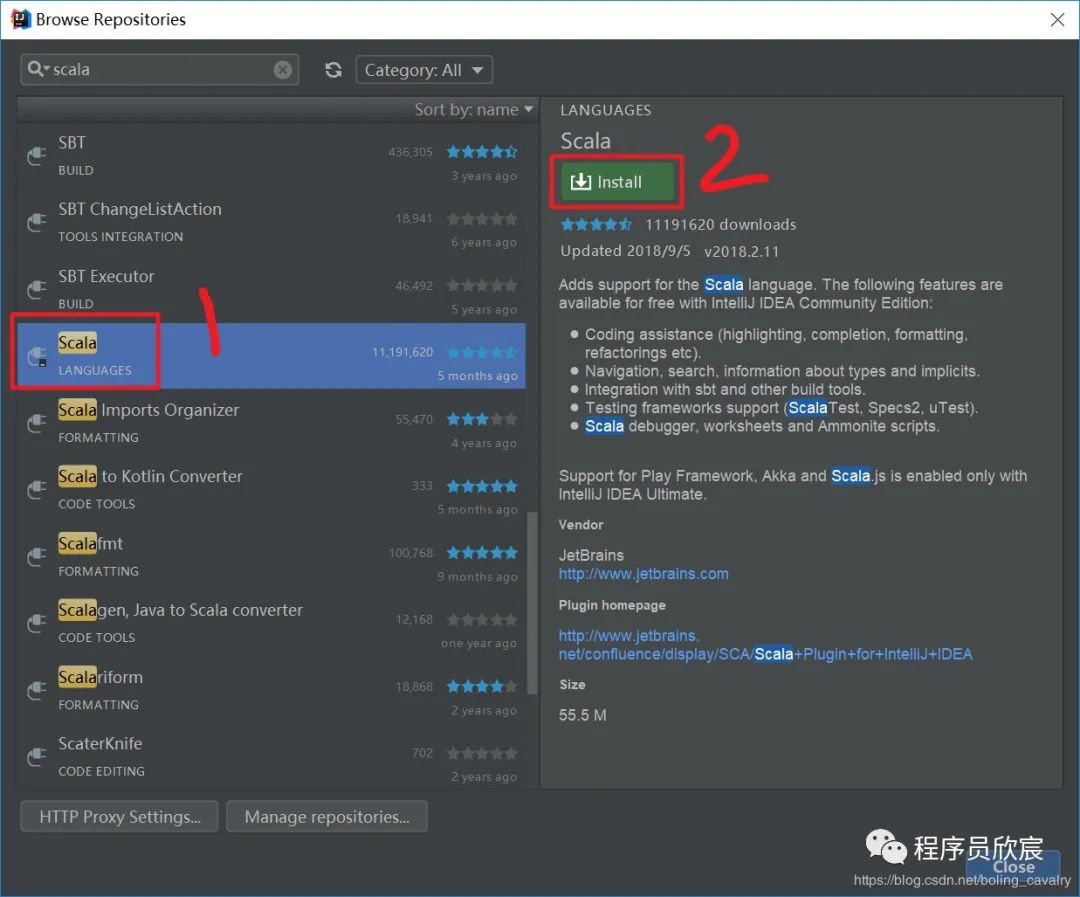

在搜索结果中选中"scala",再点击右侧的"Install",如下:

-

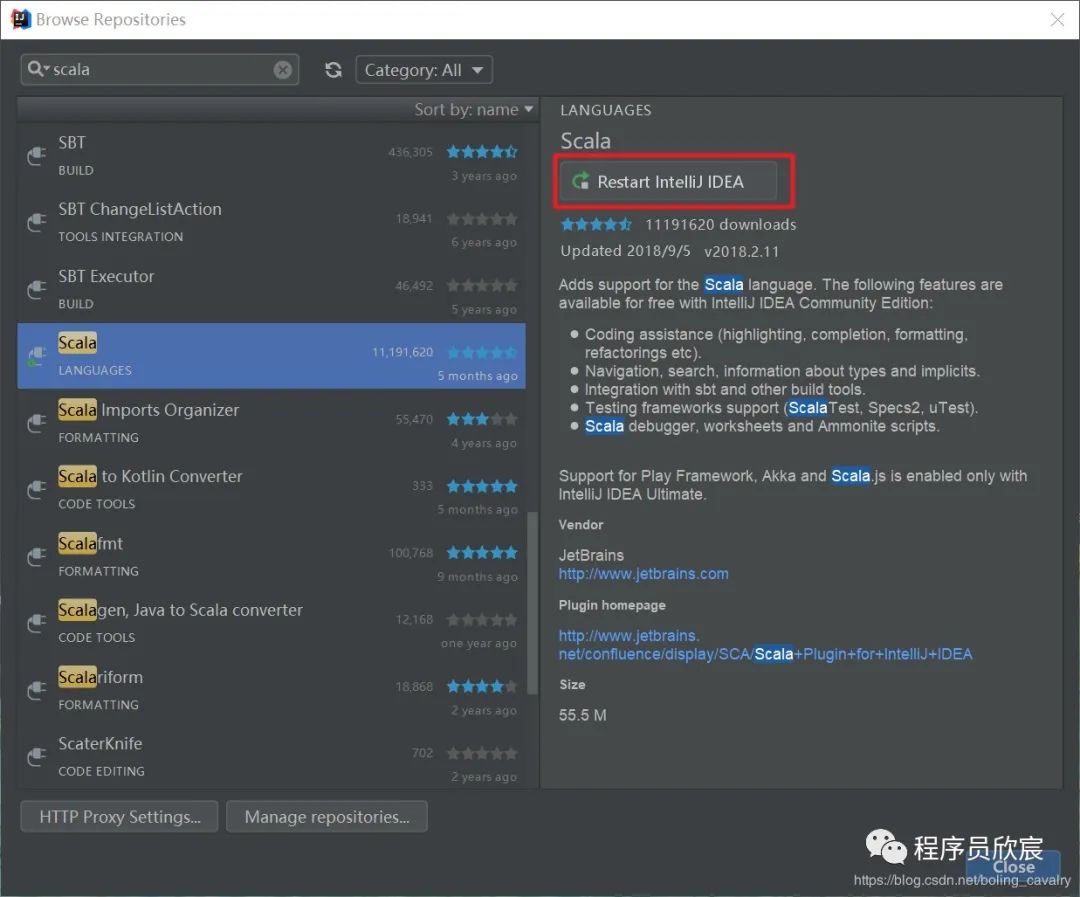

等待在线安装成功后,点击"Restart IntelliJ IDEA",如下:

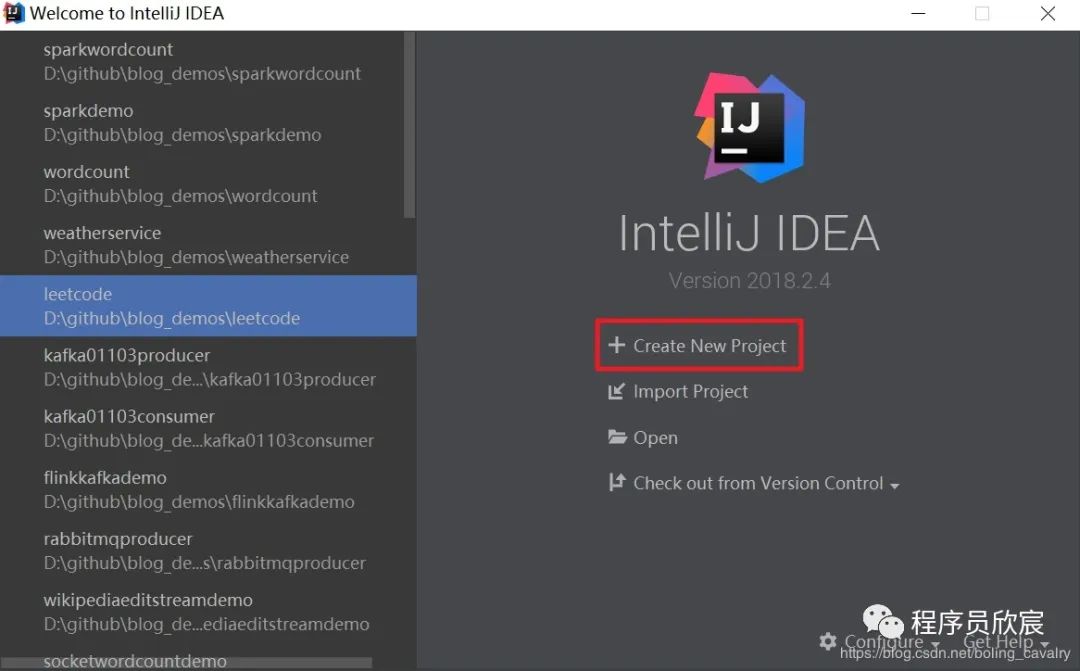

新建scala工程

-

点击下图红框,创建一个新工程:

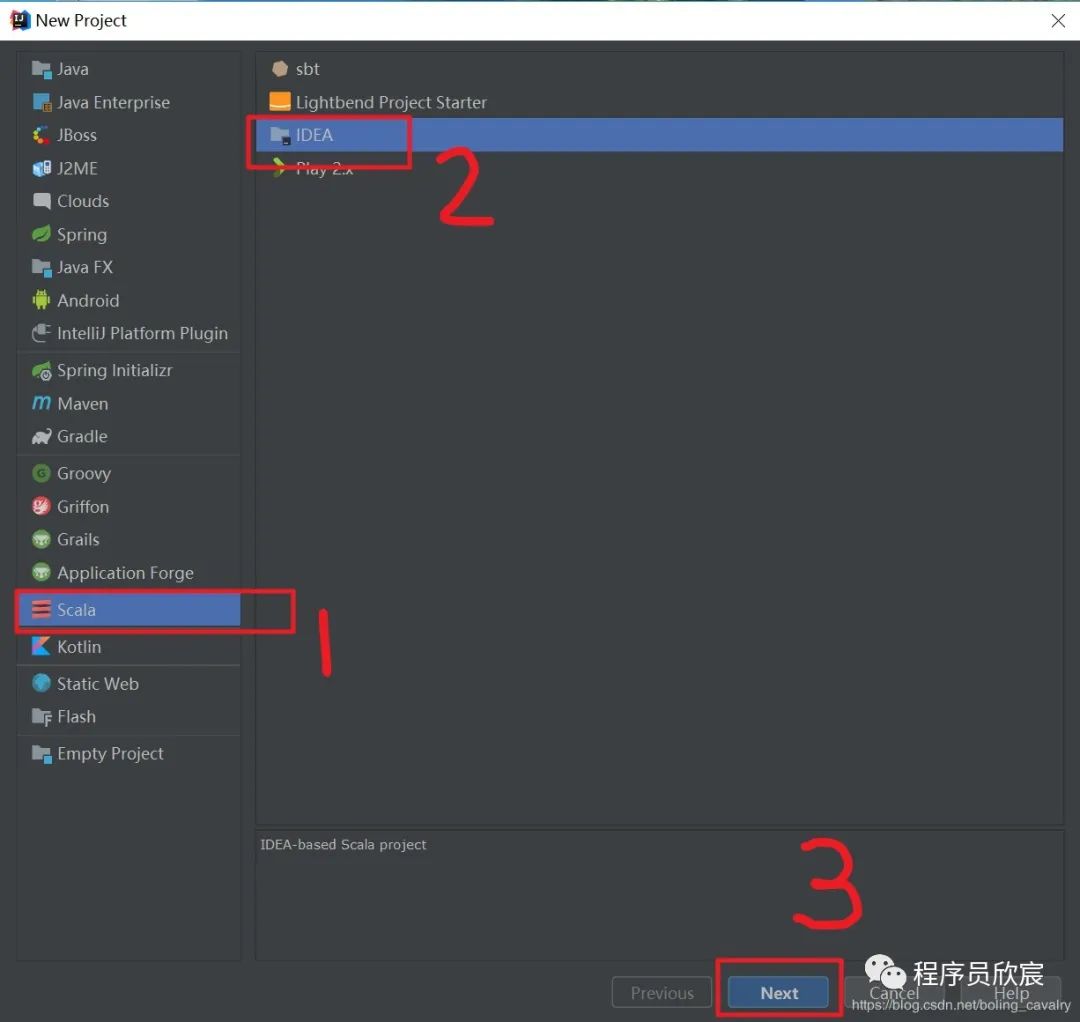

-

在弹出窗口中选择"Scala"->"IDEA",如下图:

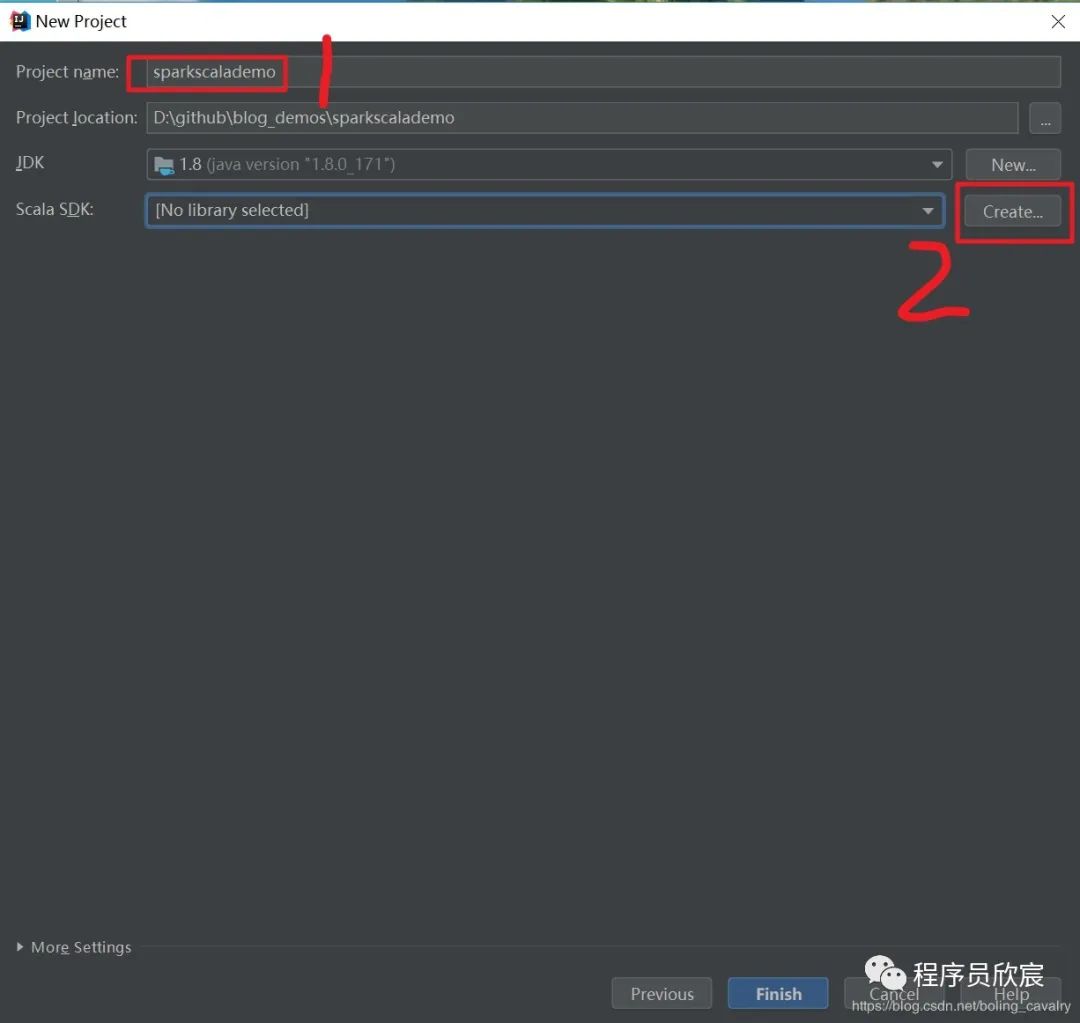

-

如下图,在红框1中输入项目名称,点击红框2,选择Scala SDK:

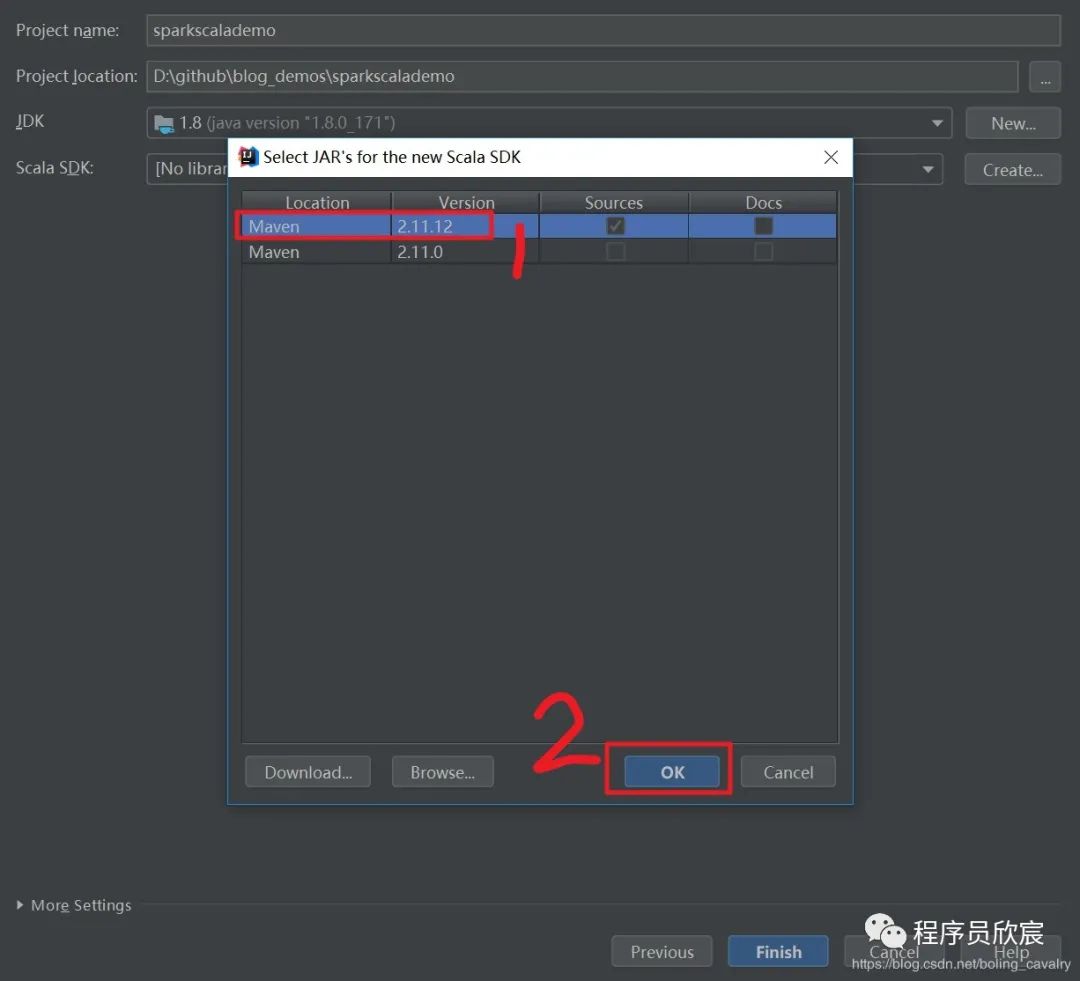

-

在弹出的窗口选择"2.11.12"版本,如下图:

-

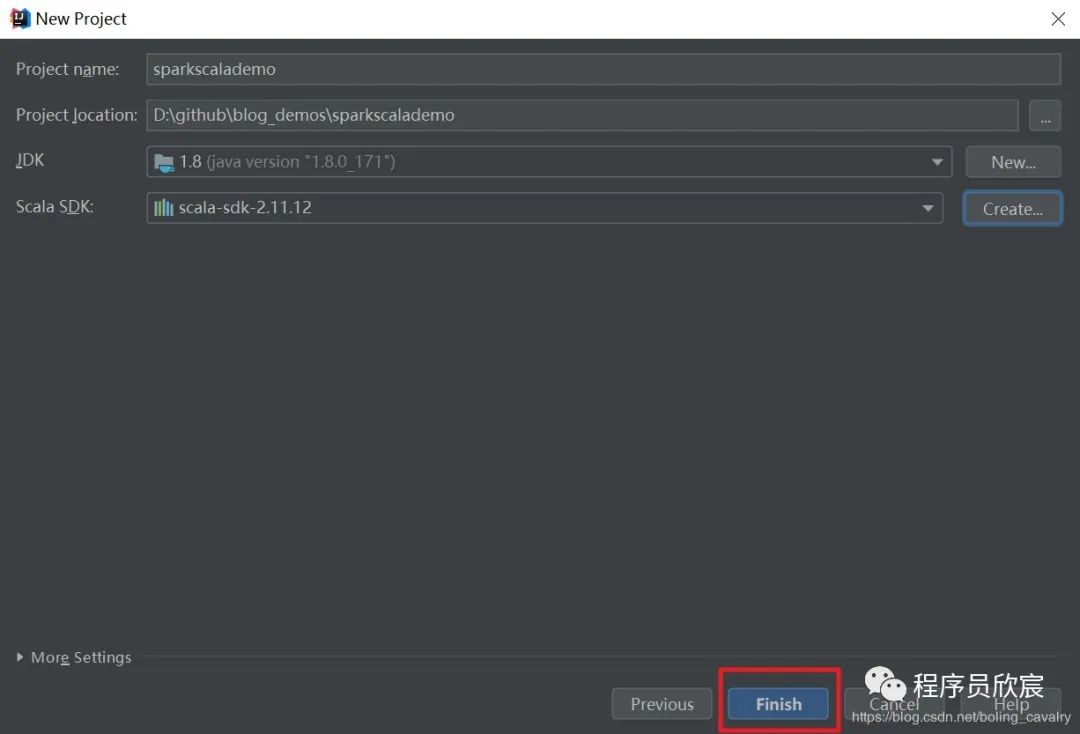

点击下图红中的"Finish",完成工程创建:

-

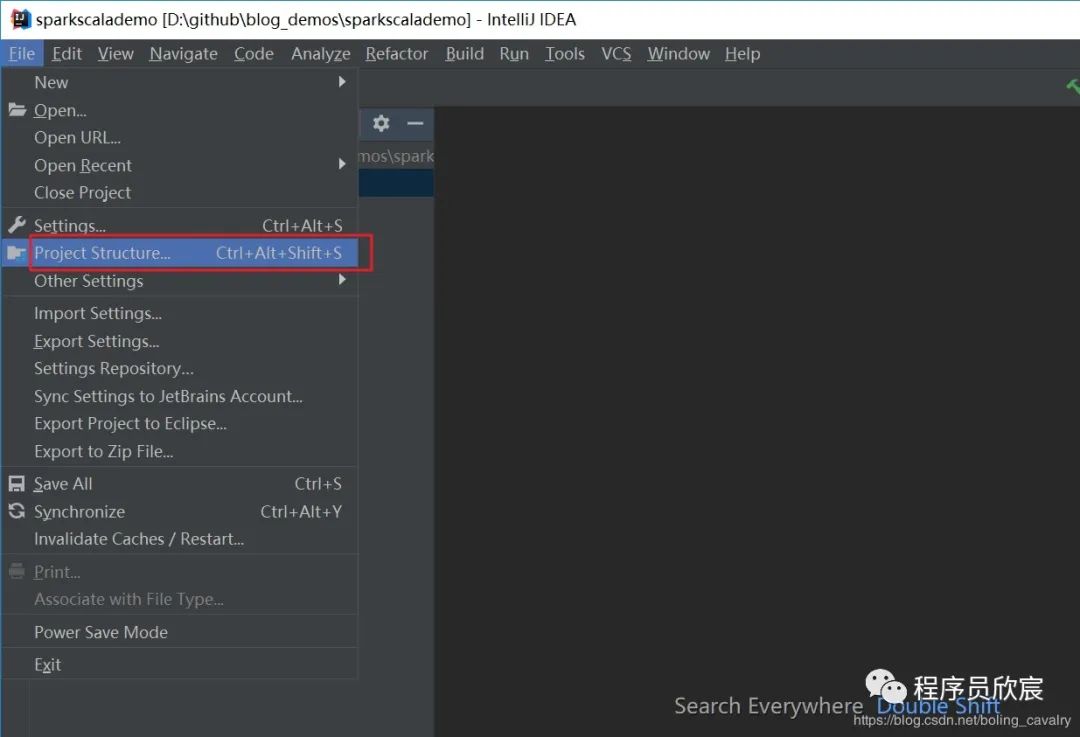

工程创建成功了,接下来是添加spark库,点击"File"->"Project Structure",如下图:

-

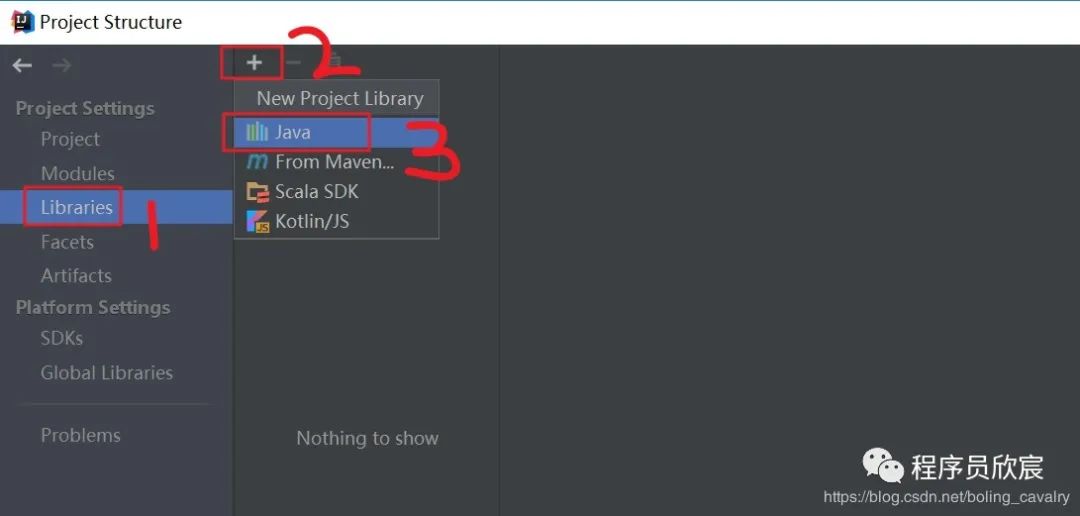

在弹出窗口选择新增一个jar库,如下图:

-

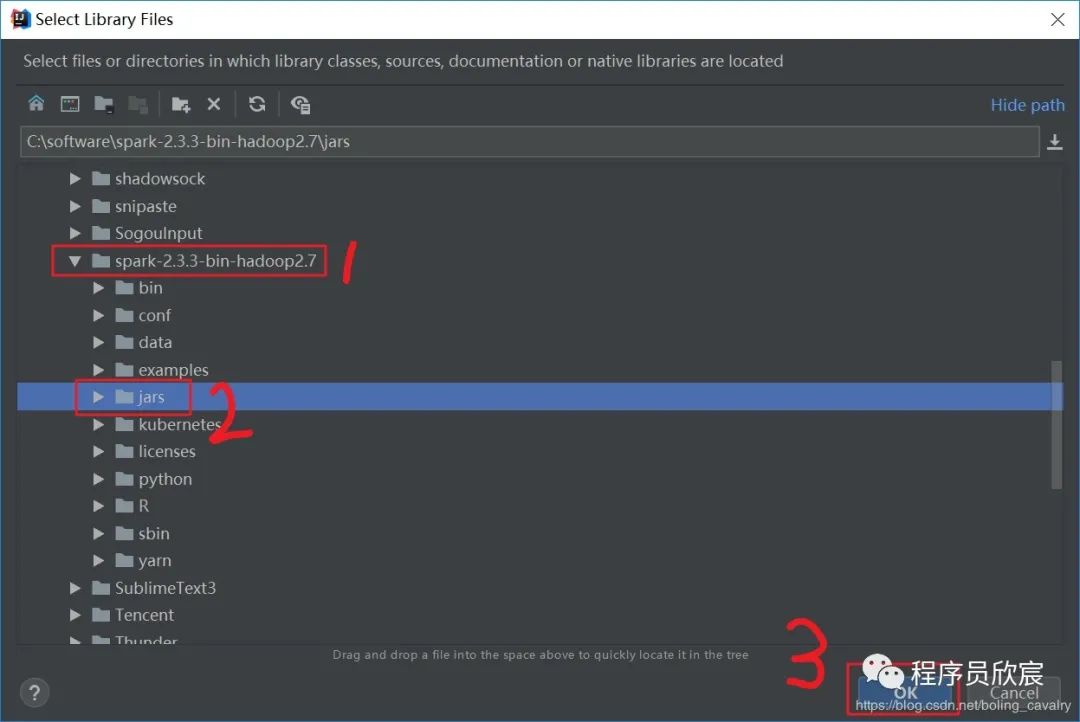

在弹出窗口选择前面安装的 spark-2.3.3-bin-hadoop2.7文件夹下面的jar文件夹,如下:

-

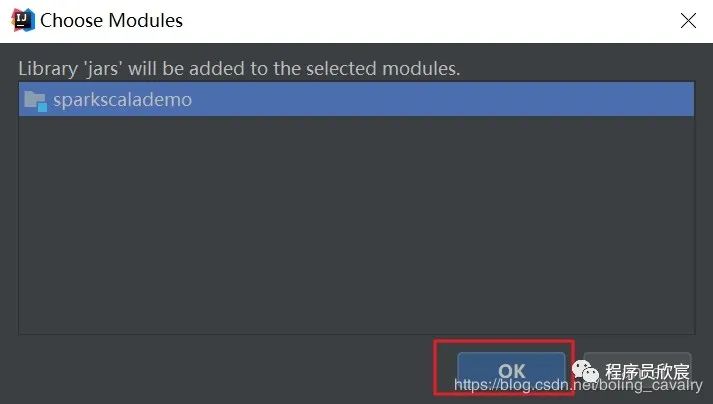

如下图,弹出的窗口用来选择模块,就选工程目录即可:

-

至此,整个spark开发环境已经设置好了,现在写一个demo试试,创建一个object,源码如下:

package com.bolingcavalry.sparkscalademo.appimport org.apache.spark.{SparkConf, SparkContext}/*** @Description: 第一个scala语言的spark应用* @author: willzhao E-mail: zq2599@gmail.com* @date: 2019/2/16 20:23*/object FirstDemo {def main(args: Array[String]): Unit={val conf = new SparkConf().setAppName("first spark app(scala)").setMaster("local[1]");new SparkContext(conf).parallelize(List(1,2,3,4,5,6)).map(x=>x*x).filter(_>10).collect().foreach(println);}}

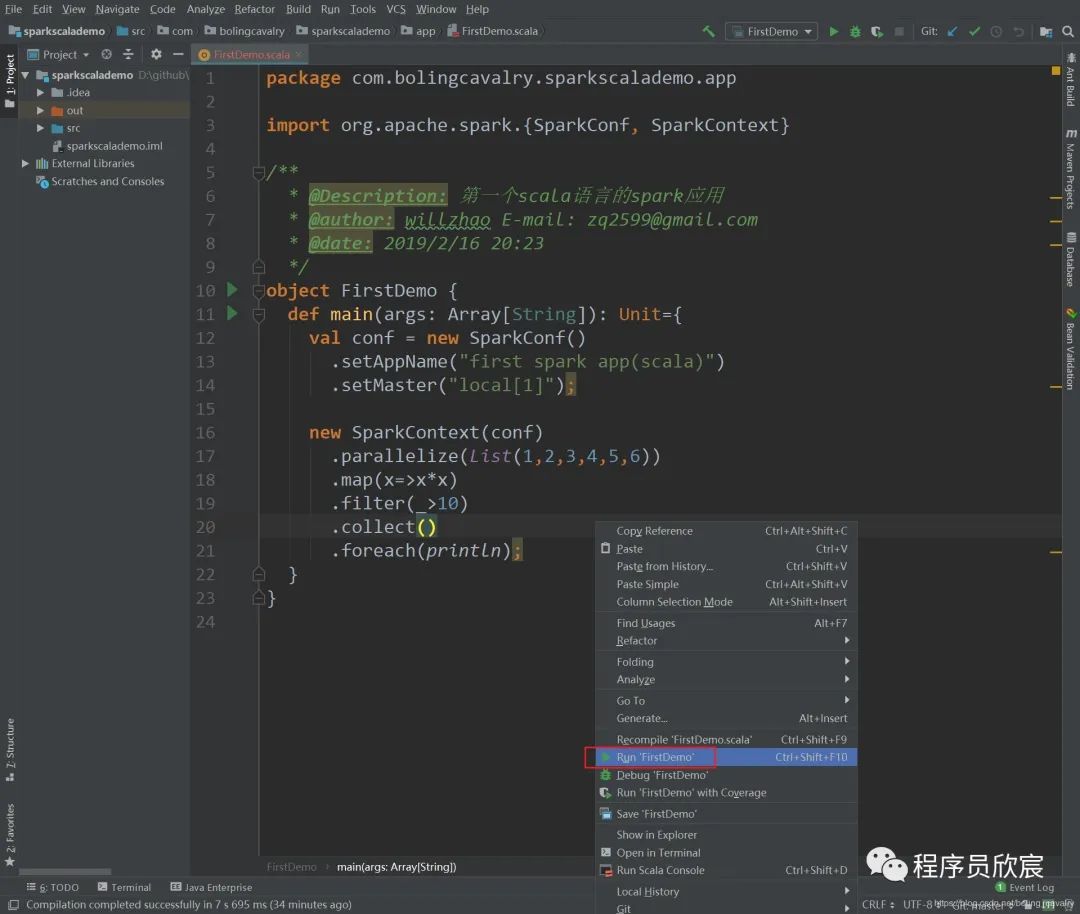

以上代码的功能很简单:创建用一个数组,将每个元素做平方运算,再丢弃小于10的元素,然后逐个打印出来;11. 代码完成后,点击右键选择"Run FirstDemo",即可立即在本机运行,如下图: 12. 由于windows环境并没有做hadoop相关配置,因此控制台上会有错误堆栈输出,但这些信息并不影响程序运行(本例没有用到hadoop),输出如下,可见结果已经被打印出来(16、25、36):

12. 由于windows环境并没有做hadoop相关配置,因此控制台上会有错误堆栈输出,但这些信息并不影响程序运行(本例没有用到hadoop),输出如下,可见结果已经被打印出来(16、25、36):

2019-02-17 09:04:21 INFO TaskSchedulerImpl:54 - Removed TaskSet 0.0, whose tasks have all completed, from pool2019-02-17 09:04:21 INFO DAGScheduler:54 - ResultStage 0 (collect at FirstDemo.scala:20) finished in 0.276 s2019-02-17 09:04:21 INFO DAGScheduler:54 - Job 0 finished: collect at FirstDemo.scala:20, took 0.328611 s1625362019-02-17 09:04:21 INFO SparkContext:54 - Invoking stop() from shutdown hook2019-02-17 09:04:21 INFO AbstractConnector:318 - Stopped Spark@452ba1db{HTTP/1.1,[http/1.1]}{0.0.0.0:4040}2019-02-17 09:04:21 INFO SparkUI:54 - Stopped Spark web UI at http://DESKTOP-82CCEBN:40402019-02-17 09:04:21 INFO MapOutputTrackerMasterEndpoint:54 - MapOutputTrackerMasterEndpoint stopped!2019-02-17 09:04:21 INFO MemoryStore:54 - MemoryStore cleared2019-02-17 09:04:21 INFO BlockManager:54 - BlockManager stopped2019-02-17 09:04:21 INFO BlockManagerMaster:54 - BlockManagerMaster stopped2019-02-17 09:04:21 INFO OutputCommitCoordinator$OutputCommitCoordinatorEndpoint:54 - OutputCommitCoordinator stopped!2019-02-17 09:04:21 INFO SparkContext:54 - Successfully stopped SparkContext2019-02-17 09:04:21 INFO ShutdownHookManager:54 - Shutdown hook called2019-02-17 09:04:21 INFO ShutdownHookManager:54 - Deleting directory C:\Users\12167\AppData\Local\Temp\spark-4bbb584a-c7c2-4dc8-9c7e-473de7f8c326Process finished with exit code 0

构建打包,提交到spark环境运行

-

生产环境下一般是将应用构建打包成jar,放到spark集群中运行,所以我们来操作构建打包; -

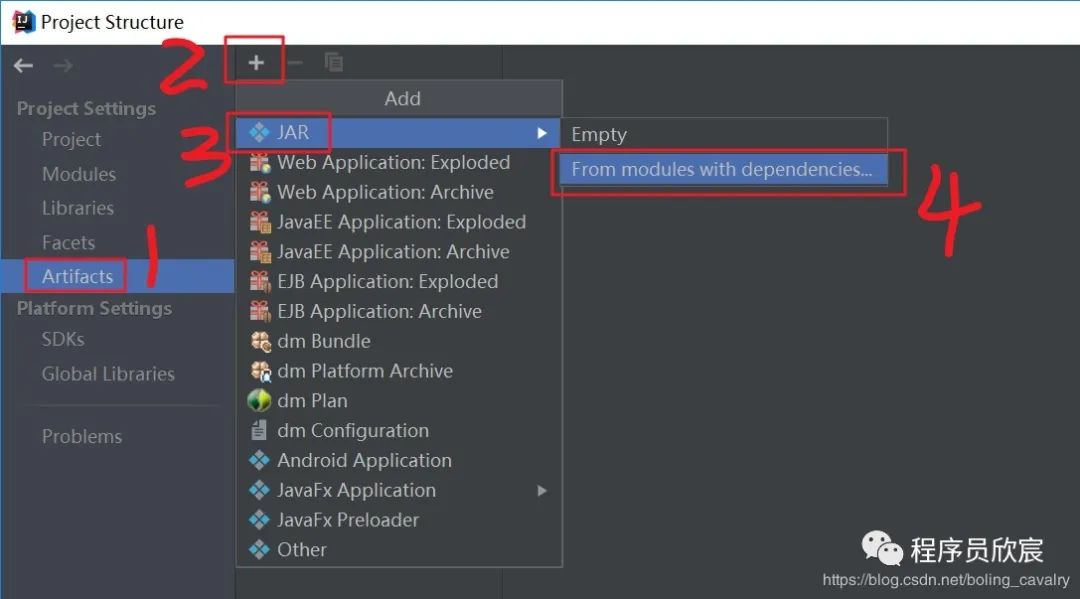

在菜单上选择"File"->"Project Structure",弹出窗口点击"Artifacts",选择新增jar,如下图:

-

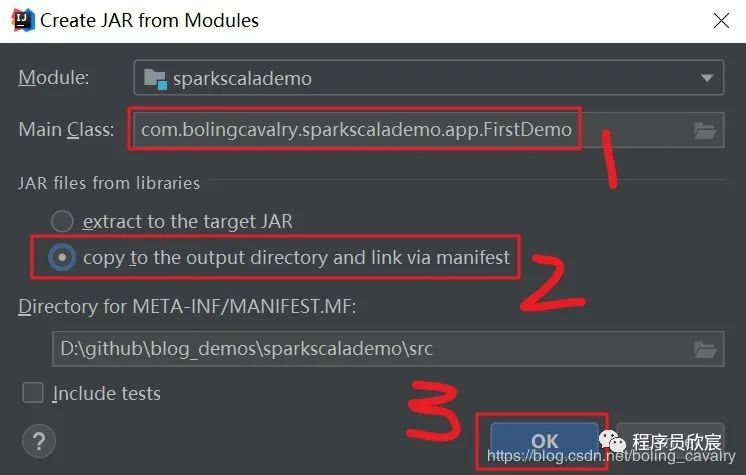

如下图,在弹出的窗口中,红框1位置输入要运行的class,红框2选择的是单选框的第二个"copy to the output ...":

-

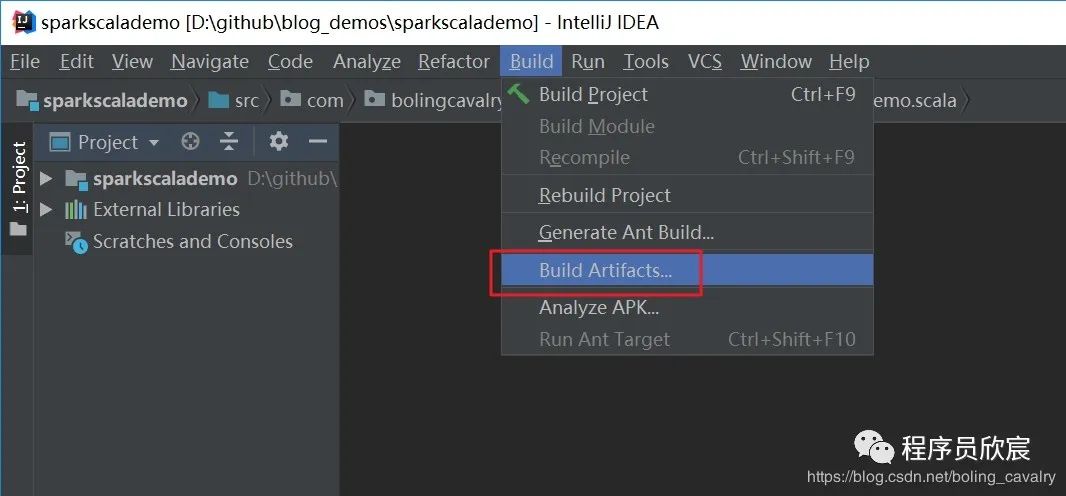

在菜单上选择"Build"->"Build Artifacts...",如下图:

-

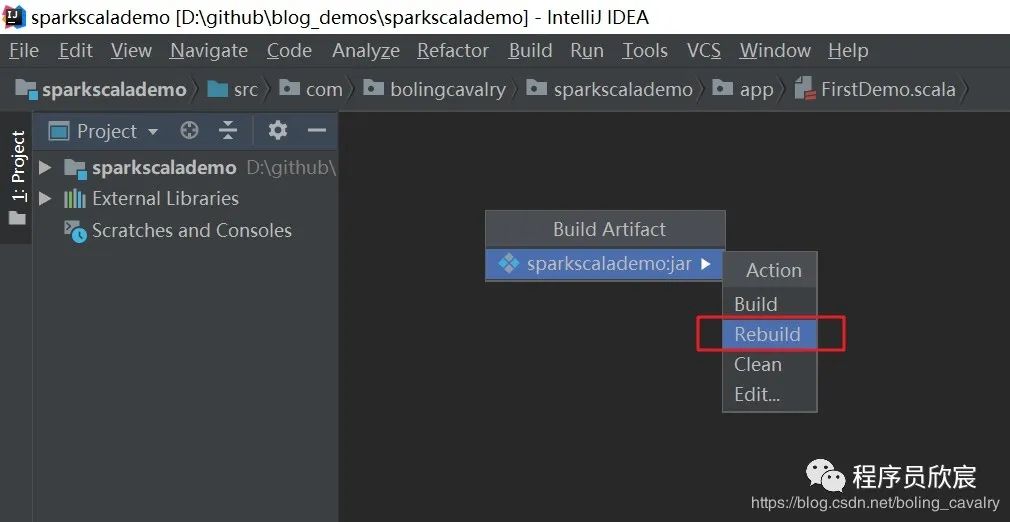

在弹出的菜单中选择"sparkscalademo:jar"->"Rebuild",如下:

-

如果编译成功,在项目的 out\artifacts目录下就会生成文件sparkscalademo.jar,如下: -

将文件上传到spark服务器上,执行提交命令:

spark-submit --class com.bolingcavalry.sparkscalademo.app.FirstDemo /root/jars/sparkscalademo.jar-

控制台会显示运行信息和结果,如下图: 至此,idea开发spark应用实战就完成了,希望在您配置开发环境的时候本文能够提供一些参考;

以上是关于IDEA开发Spark应用实战(Scala)的主要内容,如果未能解决你的问题,请参考以下文章