日志分析-Logstash

Posted 阿华code

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了日志分析-Logstash相关的知识,希望对你有一定的参考价值。

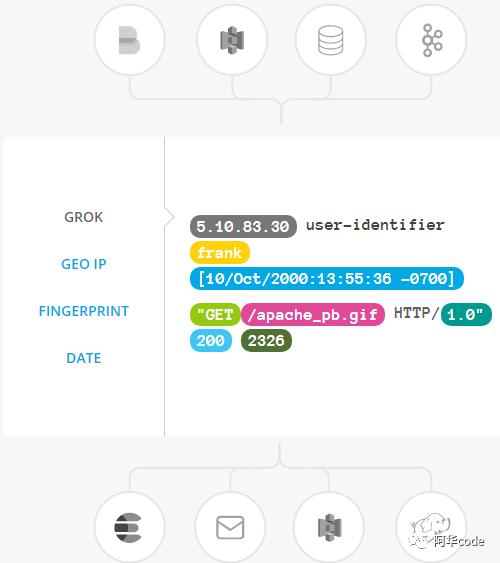

Logstash是一个开源数据收集引擎,具有实时管道功能。Logstash可以动态地将来自不同数据源的数据统一起来,并将数据标准化到你所选择的目的地。

Input:

数据往往以各种各样的形式,或分散或集中地存在于很多系统中。Logstash 支持各种输入选择 ,可以在同一时间从众多常用来源捕捉事件。能够以连续的流式传输方式,轻松地从您的日志、指标、Web 应用、数据存储以及各种 AWS 服务采集数据。

Filter:

Logstash 能够动态地转换和解析数据,不受格式或复杂度的影响:

利用 Grok 从非结构化数据中派生出结构

将 PII 数据匿名化,完全排除敏感字段

整体处理不受数据源、格式或架构的影响

Output:

管 Elasticsearch 是我们的首选输出方向,能够为我们的搜索和分析带来无限可能,但它并非唯一选择。

Logstash 提供众多输出选择,您可以将数据发送到您要指定的地方,并且能够灵活地解锁众多下游用例。

安装跟filebeat一样我下载的是最新版本,推荐官网下载。

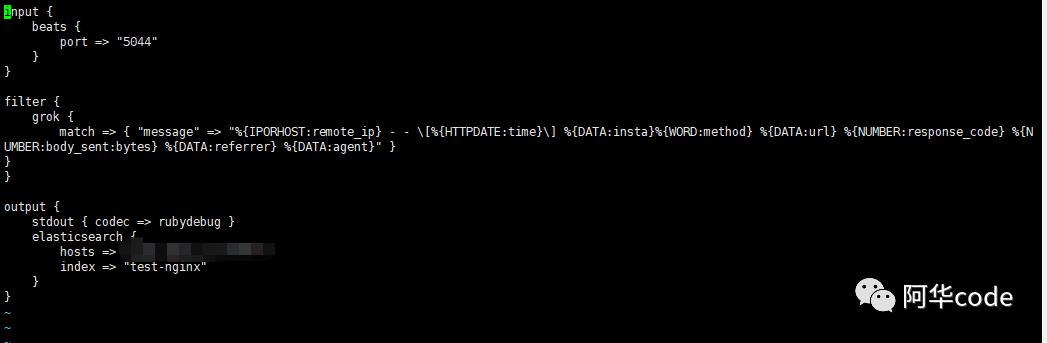

然后新建一个文件,***.conf

检测配置文件命令:

bin/logstash -f first-pipeline.conf --config.test_and_exit

启动:

bin/logstash -f first-pipeline.conf --config.reload.automatic

--config.reload.automatic选项的意思是启用自动配置加载,以至于每次你修改完配置文件以后无需停止然后重启Logstash

然后修改昨天filebeat.yml

以上。

以上是关于日志分析-Logstash的主要内容,如果未能解决你的问题,请参考以下文章