“幂律与临界”支配神经网络,深度学习技术要向大脑学习

Posted 集智俱乐部

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了“幂律与临界”支配神经网络,深度学习技术要向大脑学习相关的知识,希望对你有一定的参考价值。

近年来,怎样让深度学习的系统借鉴大脑的编码机制成为了一个热点问题。最近,研究人员从大脑的视觉神经网络中发现了令人惊讶的临界现象和幂律,这一发现对于深度学习系统的设计和稳定性分析都有重要的启发。

近期发表在quantamagazine上的《A Power Law Keeps the Brain’s Perceptions Balanced》上的一篇文章提出了大脑的认知平衡与幂律法则的关系。此文是针对这篇文章的编译,供读者参考。

大脑的认知平衡由幂律来守护!

我们可以用临界点来刻画人类的大脑活动:高活跃度还是低活跃度;密集网络还是稀疏网络;有序还是无序,这些不同状态之间的分界线就是临界点。现在,通过分析有史以来最大数目的神经元的放电模式,研究者发现了另外一个临界点——这个临界点表现在神经编码中——传入大脑的感觉信息和信息的脑神经表征之间的数学关系。他们的研究结果发表在了今年6月的《Nature》杂志上。

论文题目:

High-dimensional geometry of population responses in visual cortex

https://www.nature.com/articles/s41586-019-1346-5

研究表明,大脑在尽可能多地处理信息和灵活地降噪之间达成了某种平衡。这让人类的大脑可以优先处理刺激信号中最显著的部分,而不是没完没了地区分别细枝末节。人脑的这种工作方式,为人工智能系统的设计提供了新思路。

科学家们最初的工作并不是为了发现这种平衡行为。一开始,他们只是在研究一个简单的课题:视觉皮层到底是用不同的模式表示不同的刺激,还是重复使用相同的模式?研究者将后一种情况称之为低维度神经活动,在这种情况下,神经编码的相关词汇匮乏,但是也能应对细微的噪音传入。就好比一个一维的编码,接受到了一个刺激信号只能表示“好”还是“坏”。单个神经元的放电量可能会随着输入而变化,但多个神经元彼此之间是高度相关的,他们的放电模式总是一起增加或减少,即便存在个别误差,但刺激信号仍然可以被正确识别。

另一个极端情况则是高维度神经活动,此时,神经活动相互之间的相关性要低得多。因为信息可以由多个维度来刻画描述,而不是仅仅使用“好-坏”这一个轴,所以,神经系统可以编码更多的刺激信息。这样做的缺点就是系统缺乏冗余信息,大脑无法从单一的神经信息中推测出整体状态。这会使得系统更容易被淘汰。

在过去的几十年中,研究普遍显示,神经系统倾向于低维表示。尽管自然界包含着极为丰富的信息,但是我们的大脑却偏好于丢弃大量信息,并使用简单的神经信号描述信息。但是,后来的研究表明:这个结论是可以归结为实验本身的缺陷。被试动物只受到非常少量的、或者非常简单的刺激。而且,研究者一次也只能记录有限数量的神经元信息。

论文题目:

A theory of multineuronal dimensionality, dynamics and measurement

https://www.biorxiv.org/content/10.1101/214262v2

用伦敦大学学院的神经科学家 Kenneth Harris 的话说:“这种实验肯定会得出这样的结论,不然还能怎么样呢?”

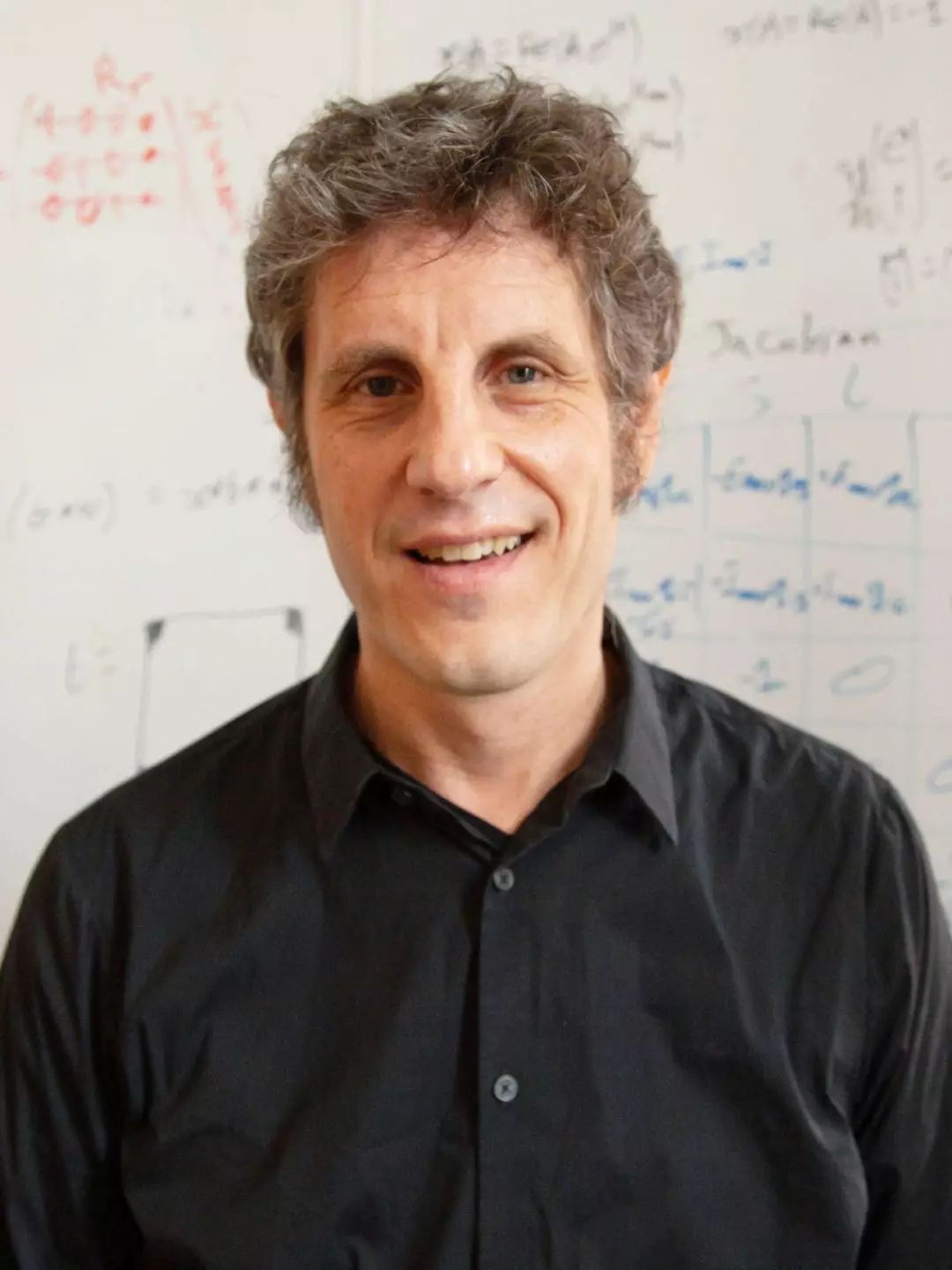

伦敦大学学院的神经科学家 Kenneth Harris 和他们同事们通过检测被试动物的 10,000 个神经元。以此来研究视觉刺激的高维度神经活动。

但研究者们也发现了一些与神经活动相关的谜团。神经元并没有对所有的维度都一视同仁:少数维度(或者说放电模式)已经涵盖了绝大多数刺激带来的视觉神经反应,增加其它的维度只是以越来越小的增量进一步提高预测能力。这种递减的模式服从幂律分布,慕尼黑技术大学的计算神经学家 Jakob Macke (并未参与此项研究)表示:“幂律分布非常普遍,只要你去找,几乎在任何地方都可以找到它。”

Harris 和他的同事们对这一现象背后的含义仍然感到困惑。尽管近期的研究对幂律法则的相关性以及普遍性提出了质疑。比如 Harris 就开玩笑说:“你会发现特朗普的推文的感叹号数目的分布也服从幂律分布。”这个规律还是比较特别的。幂律曲线有一个特定的斜率,这个斜率所代表的指数无法用外界刺激的数学规律来解释。

Harris说:“这种数据中的定量规律,不常出现在生物学科中……我们并不知道这意味着什么。”但是,这背后却似乎有什么含义。

为了解释这背后的含义,研究者借鉴了函数可微性方面的研究成果。他们发现,如果从输入到输出的幂律映射衰减变慢,那么输入上很小的变化,也会引起输出很大的波动。研究者把这种现象称之为平滑性崩溃——底层编码的输出结果并不总是连续的。

供职于霍华德休斯医学研究所的 Carsen Stringer 认为,大脑能处理的维度水平受到了限制,防止图像中的无关细节“压过”主要内容的“风头”。

用该研究的共同负责人 Carsen Stringer 和 Marius Pachitariu 的话来说:这就像是处在在分形的边缘。他们二人都曾在 Harris 的实验室工作,现在都是弗吉尼亚州霍华德休斯医学研究所Janelia 研究中心的研究员。 Stringer 说:“想象一下英国海岸线的分形。因为有锯齿状的边缘,即便你只是沿着海岸线走了一小步,你的状态也会快速的变化。”

用脑科学的话来说就是,两幅相似的图像背后是非常不同的神经活动,“这是有问题的”,Stringer 认为,“如果图像上只有一个像素点发生了变化,或者图像移动了一点,你不会希望大脑中的神经表征发生彻底的变化。”

相反,如果幂律衰减得很快,神经表征会变为低维。它们只能编码更少的信息——强调一些关键的维度,而忽略别的维度。

综上所述,这两个规律意味着,神经表征在保持平滑的前提下,尽可能做到细节丰富、增加维度。

按照 Harris 的说法,这一发现的一种解释就是,在衰减缓慢的情况下,那些不太重要的维度就会受到太多的关注(因为如果神经活动-维度之间的曲线变得平缓,就意味着该系统平等地对待所有的维度)。视觉刺激中的细节会掩盖更加重要的特征:视觉皮层总是对某些琐碎的细节过于敏感,而无法形成连贯的感知以及决策。同理,在衰减较快的情况下,那些较重要的特征将获得更多的权重,但这又可能会让那些更细节的关键特征完全被主要特征所淹没。

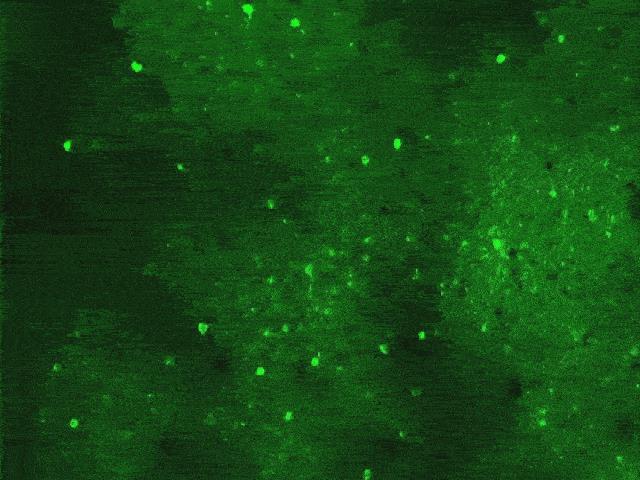

实验小鼠视觉皮层的细胞区域在接受到来自Harris的团队的图片刺激后, 神经元放电时会发出荧光。这种放电模式表明,大脑在表征各种图像时,幂律法则发挥了作用。大多数细胞对相同的刺激做出了反应,而额外的刺激只能激活依指数衰减的更少数量的细胞。

如果图像上只有一个像素点发生了变化,或者只是图像移动了一点,你不会希望大脑中的神经表征发生彻底的变化。——霍华德·休斯医学研究所 Carsen Stringer

现在,研究者想要确定这种幂律背后的生物学机制。他们还希望继续探索幂律法则在别的脑区、执行其他任务或行为、以及在疾病模型中所发挥的作用。

他们开始探索的一个领域就是众人瞩目的人工智能。深度学习系统在平滑性方面也面临着自己的问题:经过训练的机器学习模型能够识别出熊猫,但是即便是只改动了少量甚至人类无法分辨的像素,机器也有可能把它错误的标记为黑猩猩。Harris 说:“这就是人工智能神经网络的病理特征,它们总会对某些细节过度敏感。”

计算机科学家一直在试图确定这背后的原因,而 Harris 认为,他们团队的发现能为解决这一问题提供线索。深度学习网络的初步分析表明,人工神经网络中的某些层级也遵循幂律定律,但幂律的衰减比他们在小鼠实验中看到的要慢。Harris、Stringer 和他们的同事怀疑这种深度学习网络非常脆弱,因为这与大脑中的网络不同,这些网络所产生的表征并不完全连续。 Harris 认为,也许把他们研究幂律所得到的经验应用于深度学习网络,能让它更加稳定。只不过,依照Macke 的说法,这项研究仍然处于早期阶段,Macke 本人也在研究深度学习网络中幂律法则。

Shea-Brown 仍然认为这是一个不错的起点。他说:“连续且平滑的关系对于建立概括和比较不同情境的能力似乎非常重要。”科学家开始了解大脑是如何利用它完备的神经网络来编码和表征这个世界的。现在,有了这样一个“惊人且漂亮的结果”,科学家们再继续思考神经编码的问题时,就有了“新的目标……和有用的参照”。

Harris 指出,视觉皮层中出人意料的幂律法则“只不过是数据向我们呈现的东西”。现在,可以利用他们团队的技术,一次性地成像和分析成千上万个神经元来寻求解决其它的研究问题。“幂律相关的事实可能只是一个非常基础的发现”,还会有许多无法预料的洞见。“这一整套方法将改变我们对于事物的看法。”

原文地址: https://www.quantamagazine.org/a-power-law-keeps-the-brains-perceptions-balanced-20191022/ 翻译:Leo 审校:傅渥成、Frank Xu 编辑:张爽

推荐阅读

商务合作及投稿转载|swarma@swarma.org

◆ ◆ ◆

加入“没有围墙的研究所”

让苹果砸得更猛烈些吧!

以上是关于“幂律与临界”支配神经网络,深度学习技术要向大脑学习的主要内容,如果未能解决你的问题,请参考以下文章