深度学习-详解卷积神经网络下

Posted AI研习图书馆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度学习-详解卷积神经网络下相关的知识,希望对你有一定的参考价值。

AI研习图书馆,发现不一样的世界

详解卷积神经网络

【下】

近年来,基于深度学习的人工智能技术飞速发展,在图像识别、语音识别、目标检测等各种场景上取得了巨大的成功,例如:AlphaGo击败世界围棋冠军李世石,iPhone X内置了人脸识别解锁功能等,越来越多的人工智能产品在我们的日常生活中广泛应用。

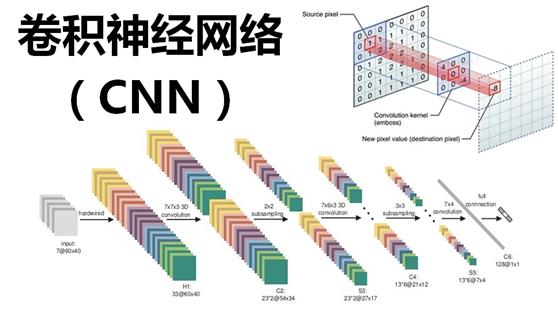

在这一场人工智能的技术革命中,深度学习发挥着无可替代的重要作用,相比于传统机器学习算法,基于深度学习的算法鲁棒性更强,算法性能更加璀璨夺目。而在深度学习技术中,卷积神经网络(Convolutional Neural Networks,CNN)则是推动这一场技术革命的中坚力量,在目前深度学习技术研究和发展中有着非常重要的地位。本文主要结合图解和案例,讲解一下卷积神经网络,作为科普知识,如有不当,敬请赐教~

接力上期,精彩继续,详解卷积神经网络下-激活函数

1. 激活函数

激活函数ReLU (Rectified Linear Units)

卷积神经网络中,常用的激活函数主要有sigmoid、tanh、relu等等,前两者sigmoid/tanh比较常用于全连接层,后者ReLU常用于卷积层。

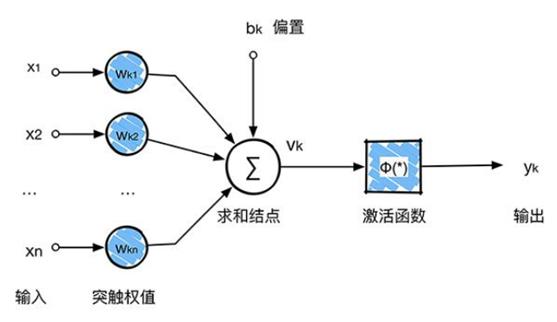

回顾一下前面讲的感知机,感知机在接收到各个输入,然后进行求和,再经过激活函数后输出。激活函数的作用是用来加入非线性因素,把卷积层输出结果做非线性映射。

在卷积神经网络中,激活函数一般使用ReLU(The Rectified Linear Unit,修正线性单元),它的特点是收敛快,求梯度简单。计算公式也很简单,max(0,T),即对于输入的负值,输出全为0,对于正值,则原样输出。

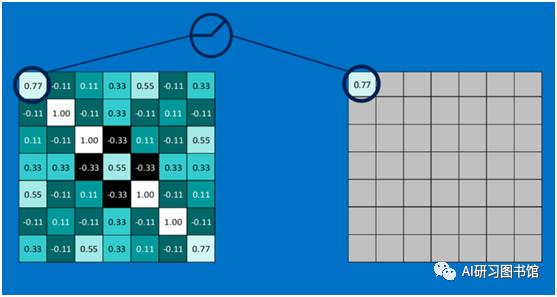

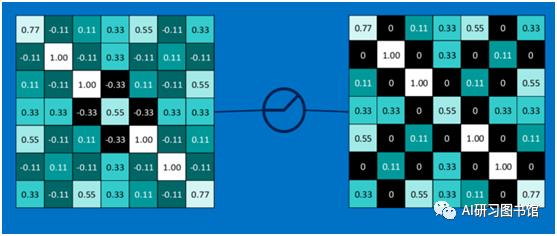

下面看一下本案例的ReLU激活函数操作过程:

第一个值,取max(0,0.77),结果为0.77,如下图所示:

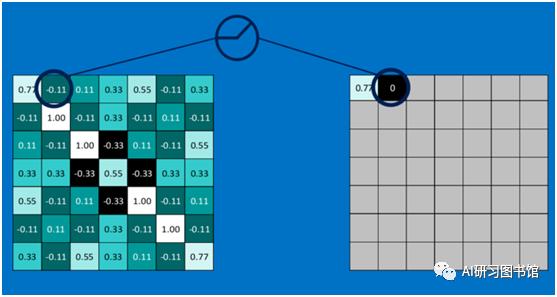

第二个值,取max(0,-0.11),结果为0,如下图:

......

以此类推,经过ReLU激活函数后,结果如下:

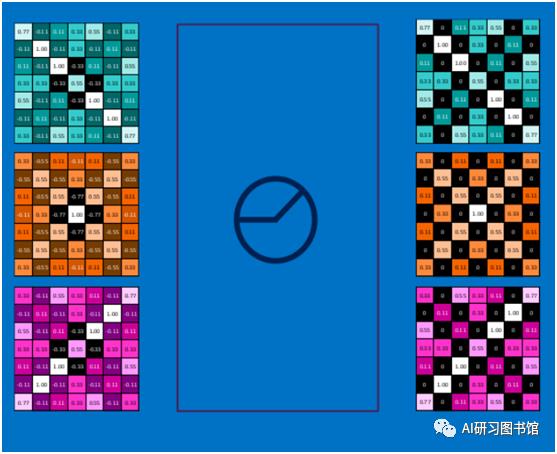

对所有的feature map执行ReLU激活函数操作,结果如下:

2. 深度神经网络

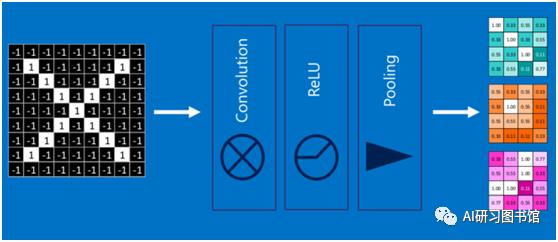

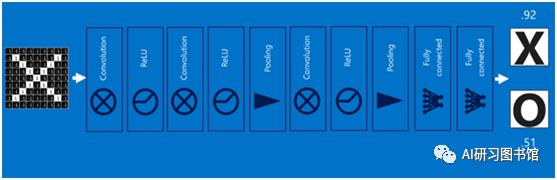

通过将上面所提到的卷积、激活函数、池化组合在一起,就变成下图:

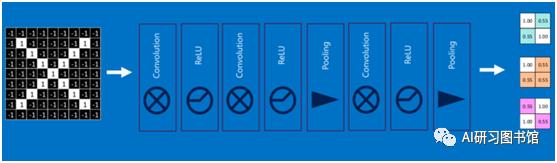

通过加大网络的深度,增加更多的层,就得到了深度神经网络,如下图:

3. 全连接层(Fully connected layers)

全连接层在整个卷积神经网络中起到“分类器”的作用,即通过卷积、激活函数、池化等深度网络后,再经过全连接层对结果进行识别分类。

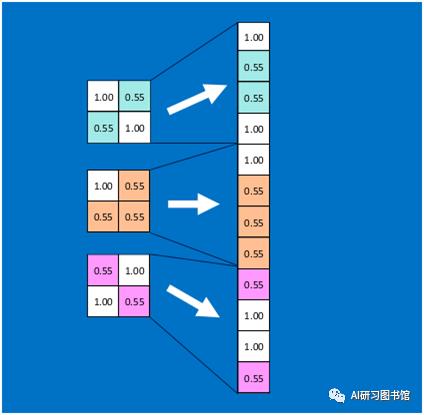

首先将经过卷积、激活函数、池化的深度网络后的结果串起来,如下图所示:

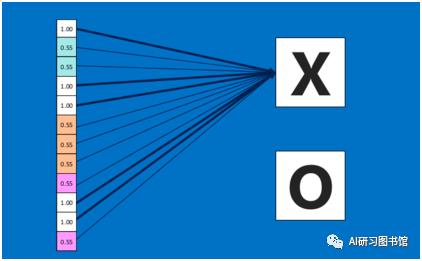

由于神经网络是属于监督学习,在模型训练时,根据训练样本对模型进行训练,从而得到全连接层的权重(如预测字母X的所有连接的权重)

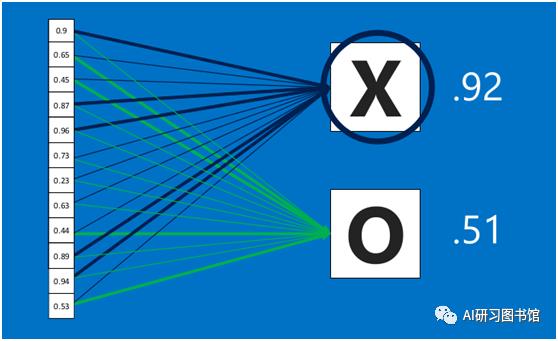

在利用该模型进行结果识别时,根据刚才提到的模型训练得出来的权重,以及经过前面的卷积、激活函数、池化等深度网络计算出来的结果,进行加权求和,得到各个结果的预测值,然后取值最大的作为识别的结果(如下图,最后计算出来字母X的识别值为0.92,字母O的识别值为0.51,则结果判定为X)

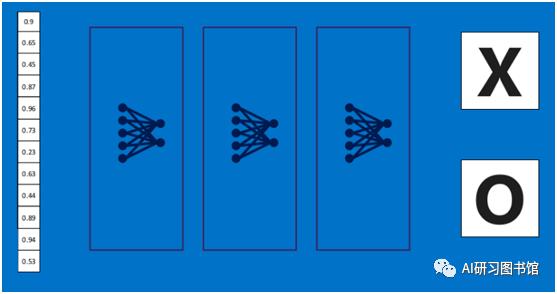

上述这个过程定义的操作为”全连接层“(Fully connected layers),全连接层也可以有多个,如下图:

4. 卷积神经网络(Convolutional Neural Networks)

将以上所有结果串起来后,就形成了一个“卷积神经网络”(CNN)结构,如下图所示:

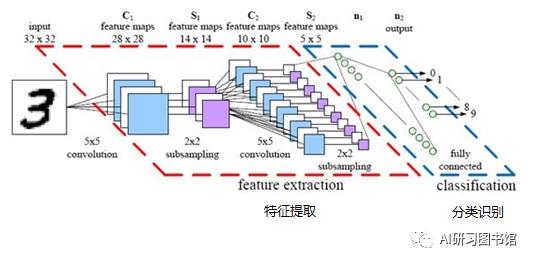

最后,再回顾总结一下,卷积神经网络主要由两部分组成,一部分是特征提取(卷积、激活函数、池化),另一部分是分类识别(全连接层),下图便是著名的手写文字识别卷积神经网络结构图:

深度学习基础入门系列,详解卷积神经网络部分总结完毕,专栏文章持续完善中,后期会更新系列算法解析文章,欢迎关注~

推荐阅读文章

[1]

[2]

[3]

[4]

[5]

[6]

[7]

[8]

[9]

[10]

[11]

[12]

[13]

[14]

[15]

[16]

......

关注AI研习图书馆,发现不一样的精彩世界

以上是关于深度学习-详解卷积神经网络下的主要内容,如果未能解决你的问题,请参考以下文章