厉害了!分布式存储+全闪存

Posted SSDFans

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了厉害了!分布式存储+全闪存相关的知识,希望对你有一定的参考价值。

1、 概述

1.1. 产品简介

随着闪存技术飞速发展,单块NVMe SSD的性能已达到百万级IOPS,固态硬盘SSD与机械硬盘HDD的性能有了天壤之别。传统存储专为HDD设计,其软硬件架构从根本上制约了闪存介质的生产力;基于控制器架构的全闪存阵列(AFA),虽然针对闪存介质进行了软硬件的优化,有较好的单机性能表现,然而其有限的扩展能力,使它难已匹配云计算时代的弹性业务场景。采用分布式架构的全闪存储系统成为企业用户新的选择。

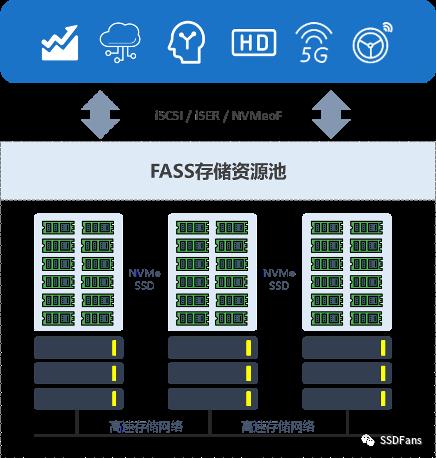

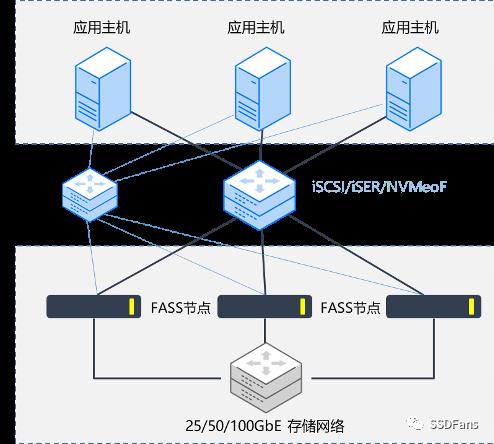

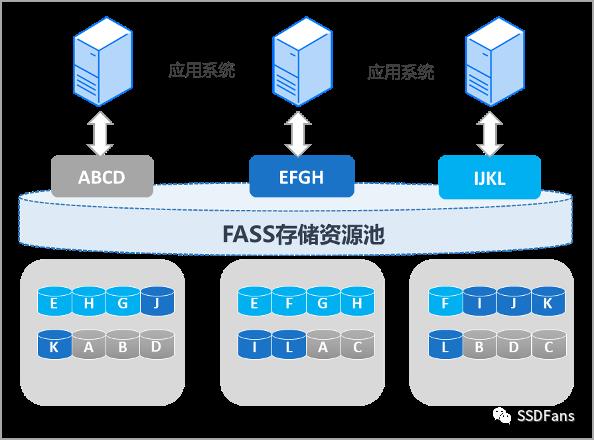

FASS是北京大道云行科技有限公司(简称TaoCloud)面向IO密集型应用场景,完全自主研发的分布式全闪存储系统。它采用高性能的全闪存硬件平台,针对NVMe闪存介质设计了高效的分布式存储软件栈,FASS可将多个节点的SSD资源通过高速以太网或Infiniband网络组成高性能、高可用、易扩展的块存储资源池,并通过iSCSI、iSER、NVMeoF存储接口对外提供超高性能的存储服务,可广泛应用于以下各类高性能需求场景。

图1:FASS主要应用场景

Ø 强大的性能:FASS采用标准服务器硬件(X86或国产CPU服务器平台)和全NVMe SSD配置,通过软件层的XPE引擎设计、微控制器技术、轻量元数据索引等机制,实现了三节点千万级IOPS和微秒级延迟。随着集群规模的扩大,FASS性能呈线性增长。

Ø 可靠的架构:FASS采用全对称分布式架构,数据分散存储于集群中的不同节点,通过多副本和纠删码等数据冗余机制,结合节点级服务高可用设计,消除了存储系统的单点故障,为业务应用提供持续的高可用存储服务。

Ø 大规模扩展:FASS单卷可达32PB容量,支持3到512 节点的Scale-out集群弹性扩展。可以通过增加集群节点实现容量与性能的按需扩展,动态满足业务飞速发展的需要。

图2:FASS产品概览

1.2. 设计哲学

1.2.1. 性能驱动

FASS定位为下一代全闪存储产品,其核心理念即性能驱动数据。对于全闪存储产品,数据可靠性是基石,而强大的性能才是改善和加速业务的关键,通过软件加速,释放出硬件的真正性能,即FASS带给用户的核心价值。

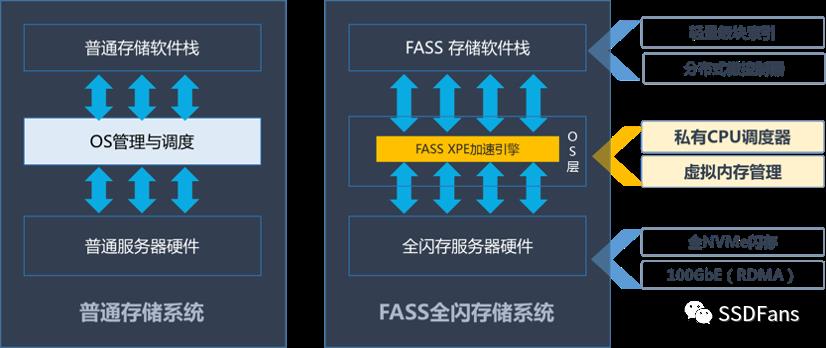

由于标准操作系统并非为高并发I/O处理而设计,其任务调度、内存管理、系统调用在高并发I/O场景下非常低效,也无法发挥出硬件的真正能力,因此成为全闪存储系统性能的最大瓶颈。FASS在设计之初已考虑到该问题,并基于OS_Bypass设计进行大量的优化与改进,设计了独有的XPE加速引擎以取代操作系统的低效调度,结合高效的分布式全闪存储软件栈,FASS在相对有限的硬件条件下,也能发挥出超高的I/O性能。

1.2.2. 软件定义

在众多AFA厂商都在追求高速硬件,甚至采用定制化芯片来尝试改善全闪存储I/O性能时,TaoCloud始终贯彻软件定义存储的理念,通过极致优化的分布式存储软件,搭载配置合理的商用服务器硬件,可以实现三节点千万级IOPS的惊人性能。当前主流服务器硬件的性能虽然看似普通,但存储软件还远未发挥出其性能的极限;另外软硬件解耦可以给各类数据中心带来更好的灵活性与经济性,有利于各类高性能云基础设施的建设。

1.2.3.分布式体系

FASS的数据与元数据管理都采用分布式模型设计,通过多个服务器节点组建集群,每个节点可以既用于数据存储,也可以承载相应的元数据服务,节点间通过高速网络实现相互协作与通信,可以实现极高的性能叠加。FASS分布式集群拥有极高的可靠性,硬盘、节点和网络都可以采用冗余配置,可以轻松应对各类故障,保障数据完整性和存储服务连续性。

2、 原理架构

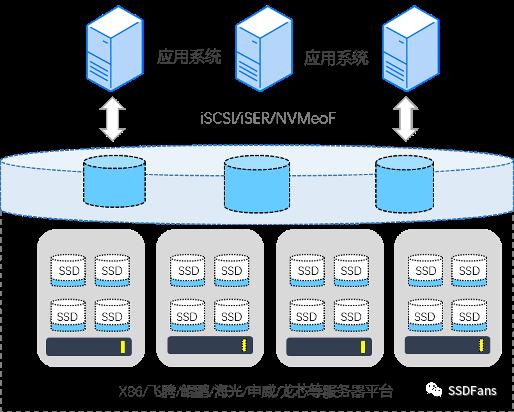

FASS基于标准服务器硬件实现了高性能的分布式块存储服务,各个节点通过高速网络互联形成存储集群,各个节点上的存储介质、CPU、内存等资源被抽象整合成块存储资源池,并通过iSCSI、iSER、NVMeoF块存储协议对外提供高性能存储服务。

图3:FASS分布式块存储服务

2.1. 逻辑架构

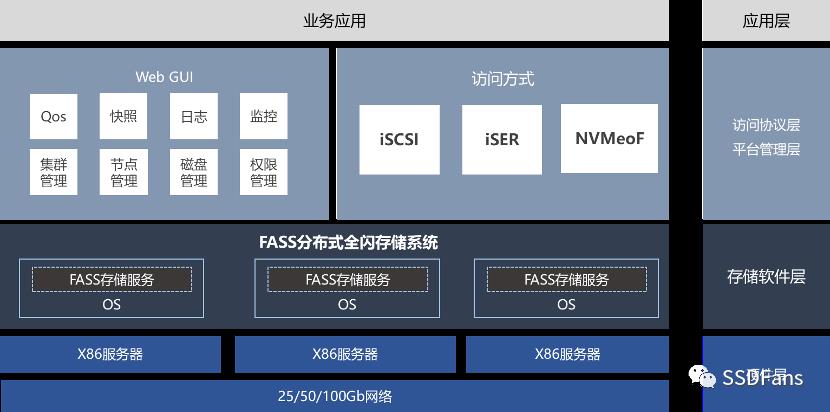

FASS可以部署于主流的Linux操作系统,如CentOS(推荐CentOS7_64bit)、Redhat、Ubuntu、SUSE,也已适配银河麒麟、深度等国产Linux操作系统。每个FASS节点都需要安装Suzaku软件服务以管理本节点资源并提供存储服务,Suzaku包含Suzakud主进程、元数据服务、I/O服务、管理工具等。

通过对各节点存储资源的管理与整合抽象,FASS以逻辑存储卷的方式为上层应用提供iSCSI、iSER、NVMeoF块存储服务和及统一管理控制。FASS软件栈运行于Linux操作系统的用户空间,独立的用户态进程与其他系统组件隔离,避免故障时相互影响,从而实现更高的系统可靠性,也有利于未来实现更简捷的协议与功能扩展。

FASS管理平台层支持CLI(命令行管理接口)和REST API,并提供Web GUI对整个存储集群进行资源配置、访问控制、数据保护、性能监控等多方面的管理。

图4:FASS逻辑架构

FASS通过ETCD模块实现集群高可用,ETCD主要用于共享配置和服务发现,如保存集群配置信息、部分元数据信息(参考后续章节)等。ETCD会选举出Master节点,由Master节点负责分配硬盘空间、管理集群、同步各节点信息。Master节点故障后,集群会被重新选举Master,保证集群高可用。Master节点负载很小,不会给集群带来性能瓶颈,可以由任意存储节点担任。

FASS软件除了支持X86服务器,还可部署于基于国产CPU(如飞腾、申威、海光、鲲鹏等)的服务器平台,各服务器节点推荐采用全NVMe SSD配置,以发挥出整个存储系统的最佳性能。FASS集群最低三节点起配,最大支持512存储节点。

FASS集群包含三层网络:存储网络、业务网络和管理网络。集群中所有节点通过高速网速(推荐100Gb/200Gb以太网或Infiniband)互联,以实现节点间的协作与数据同步与分发。业务网络主要为应用提供存储访问,业务主机通过该网络可访问到FASS存储集群提供的存储资源。为保证前端业务的性能,业务网络的带宽建议与存储网络带宽一致。管理网络主要负责管理监控、配置维护FASS集群,通信量相对较小,采用普通千兆网络即可满足要求。

图5:FASS集群组网参考(实际部署建议配置冗余网络)

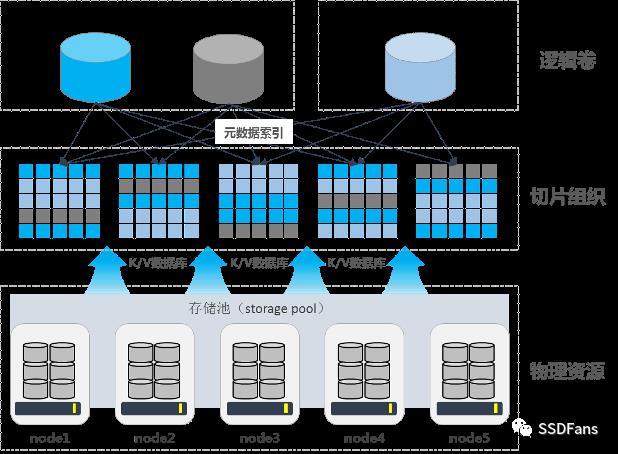

2.2. 数据布局

集群创建完成后,可以选择集群中多个节点或多块硬盘创建数据存储池,跨节点将物理上分散的存储资源进行抽象与池化,实现更高效的资源利用。FASS支持按存储介质类型创建存储池,如按NVMe SSD或按SATA SSD创建不同性能的存储池,以满足不同用户的性能需求。

存储卷隶属于某个存储池,是应用主机直接挂载使用的最小单位。存储池创建完成后,即可从存储池中划分空间并创建逻辑卷,存储卷通过iSCSI或NVMeoF协议以块设备的方式,通过IP或Infiniband网络映射给应用主机挂载使用。FASS支持创建自动精简配置卷,即可以创建容量大于存储池物理容量的逻辑卷,以满足复杂业务场景的容量规划需求。

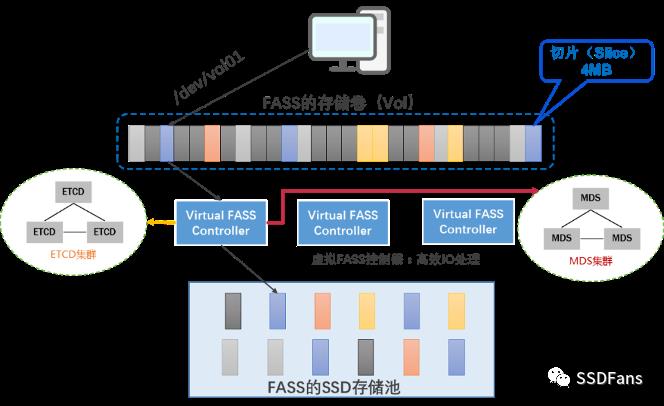

为了提高单个存储卷的扩展性,FASS每个存储卷分成多个子卷,每个子卷对应有子卷控制器(即RGctl,见后续章节介绍)。FASS在创建存储卷时会通过伪随机算法从集群中选择一个节点作为子卷控制器,由该节点承载存储子卷的元数据信息并管理维护数据的分布。

每块数据硬盘都会被分割成多个4MB空间,并通过Diskmap记录空间分配情况。数据在写入FASS存储系统时,会被切分成4MB大小的分片(Slice),然后根据既定的数据分布策略,将分片存储到多个节点,以实现更好的并发访问。数据切片机制还可以为数据保护、数据快速恢复提供良好的底层支持。数据的具体分布位置,主要由FASS存储集群的元数据服务记录和管理。

图6:FASS数据切片分布

2.3. 元数据管理

大部分分布式存储系统都依赖于各节点操作系统提供的本地文件系统,业务数据被打散写入到不同节点,由各节点的本地文件系统管理,上层再进行逻辑整合以实现统一管理。在本地文件系统基础上加入一层封装与索引管理,毫无疑问会加大了系统复杂度、降低系统的整体性能。如再进行块协议导出,则又多出一层块存储的映射索引,使整个系统运行效率低下。

为发挥出硬件的最大性能,FASS摒弃了各节点的本地文件系统,自主开发了轻量级的二级块索引服务,通过对裸盘的直接管理,以Slice切片为单位进行逻辑映射重组,实现远高于其他分布式存储系统的I/O性能。

FASS通过多层元数据索引进行数据切片高效定位与管理,主元数据服务管理数据到各个节点的映射关系,通过元数据查询可以迅速定位到数据的存储节点;同时每个节点上都维护有一份本地数据块索引,通过K/V数据库(Key-Value数据库)记录了本节点所有数据盘上Slice分布信息,并将其缓存在内存中;每个数据盘都由后端控制器(BActl)管理其具体读写操作;FASS每块硬盘都对应一份Diskmap信息,记录着该硬盘上的Slice分配情况,新建存储卷时,FASS的子卷控制器(RGctl)根据Diskmap信息与数据分布策略,为新存储卷申请分配相应的存储空间。

图7:FASS元数据管理

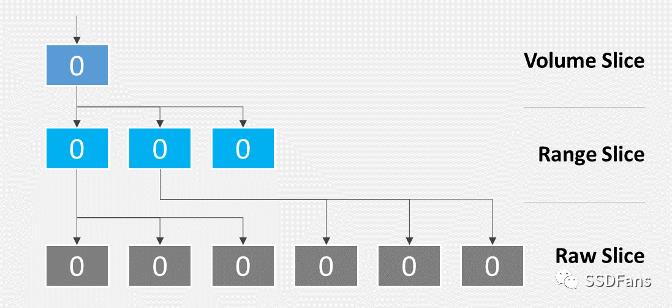

FASS存储系统的Slice分为Meta Slice和RAW Slice,Meta Slice即元数据分片,是元数据持久化写盘保存的基本单位,由元数据控制器(MDctl)直接管理,Meta Slice是元数据分片,默认采用三副本保护 (不可修改)。RAW Slice是业务数据分片,副本策略与位置由负载均衡策略决定。如无特殊说明,后文“Slice”均指RAW Slice。

FASS在每写入一个新Slice时,都会先访问子卷控制器(RGctl)以获得目标节点的位置再进行写入操作;读取数据时,子卷控制器(RGctl)会根据存储数据副本各节点状态,优先将延时最低的节点信息发送给前端控制器(FRctl),由前端控制器进行数据访问。

FASS存储系统的元数据主要包含集群配置信息、目录结构、卷属性(含扩展属性)、卷引导信息、副本位置信息等内容。FASS的子卷控制器均匀地分布在不同的节点上,从而实现各节点压力的均衡。每个Slice对应的元数据会被缓存在其所属的子卷控制器(RGctl)上。集群的元数据由元数据控制器(MDctl)统一管理,并通过后端控制器(BActl)以三副本冗余持久化写入硬盘。不同于其他采用哈希表的分布式存储系统,,在内置元数据的协助下,FASS可以更为受控地进行数据恢复、平衡等后台任务,从而使存储性能表现更稳定、大幅降低数据恢复、平衡等操作对前端业务的冲击和影响。

图8:FASS多层元数据模型

2.4. 负载均衡

为了保证数据在集群各个节点上的均衡分布,并平均分摊业务压力到整个集群,分布式存储需要设计合理的负载均衡策略,才能保证优秀的的整体性能。分布式存储集群的均衡性体现在多个层面,如:数据均衡、负载均衡等。数据均衡通过两个过程保证:首次分配过程和再平衡过程。

FASS的存储卷可以通过任意目标端控制器(TGctl)导出,存储卷会被划分为存储子卷,每个存储子卷负责管理该存储卷里的一部分数据,存储子卷通过哈希(Hash)过程均匀分布在不同节点的多个子卷控制器上;通过智能分配算法,FASS让数据和I/O负载都能平衡地分布在存储池内的所有节点和硬盘上,保证了存储池中每个SSD的磨损趋于一致。集群新增节点或节点故障导致数据不均衡时,FASS的后台任务调度器将按预定策略执行数据再平衡任务。

FASS的子卷控制器会定期检查存Slice数据分片的健康状态和分布情况、节点的空间使用情况,如果发现集群中节点间的容量差超过预先设定的比值,就会触发Slice重新分布,确保集群的容量均衡。

新节点在加入FASS集群时,首先向元数据控制器(MDctl)发送加入请求,元数据控制器(MDctl)会向该节点返回当前的集群结构并更新Diskmap,将集群的节点状态版本加1,并通知各节点更新集群的节点状态版本,以获得新加入的节点信息和当前有效的节点状态,随后进行少量的元数据和数据的迁移操作,完成集群的新节点添加操作。

FASS集群删除节点时,首先需要停止目标节点上的存储服务,随后集群会启动数据重建,将缺失的数据在其他节点上重新生成,确保数据的冗余与完整。数据重建完成后,如果启动待删除节点上的存储服务,会导致集群中出现多余数据副本。此时FASS会启用数据副本扫描与垃圾回收,删除集群中的多余数据,保留最新版本的数据副本。重建完成后如果停止待删除节点上的存储服务,该节点会变成可删除状态,执行删除后集群会清除该节点所有配置信息。

2.5. 数据一致性

对于分布式存储而言,由于数据读写分摊到多个节点处理,因此存在因各节点的信息不一致而导致数据不完整和读写出错的可能。数据一致性是分布式存储的关键设计,为保证数据一致性,提高故障后数据的恢复效率,FASS默认采用多副本机制保存数据,数据被切分成Slice后,会生成多份副本分散写入多个节点,提高数据的可用性,同时提升访问性能。

FASS采用自主开发的SuRa一致性算法(类似于Raft)来保障多个副本数据的一致性,在集群中根据节点的变更情况来判断数据的可用性,通过少数服从多数的选主(Leader)原则,保证存在唯一的Leader和完整可靠的数据版本。FASS集群中每个Slice都以多副本方式存储在集群中的各个节点,对于每个数据写入操作,都需确认所有副本完成落盘,才会返回成功信号给业务应用;如果写入操作有某份副本无法完成,则该副本会被设置为无效副本。应用读取FASS中的副本数据时,可以从任一有效数据副本读取,即每个Slice的数据副本都可提供对外存储服务,因此可提供更好的并发吞吐性能。

在数据读取操作时,FASS会检查各数据副本的逻辑时钟和状态,判定数据副本是否有效。一旦发现副本故障或缺失,集群会自动选择可用节点,在该节点上重建数据副本。对于采用N副本冗余的FASS集群(N=2/3/4),可以容忍N-1个数据副本发生故障。

FASS多个数据副本可以按故障域策略分布在不同的区域(如服务器节点、机柜等),从而大幅提高数据的可靠性,降低多个数据副本同时故障的概率。数据读取访问时,FASS可根据集群网络负载自动选择访问最适合的节点,保证最优的性能输出。

图9:FASS集群的多副本分布

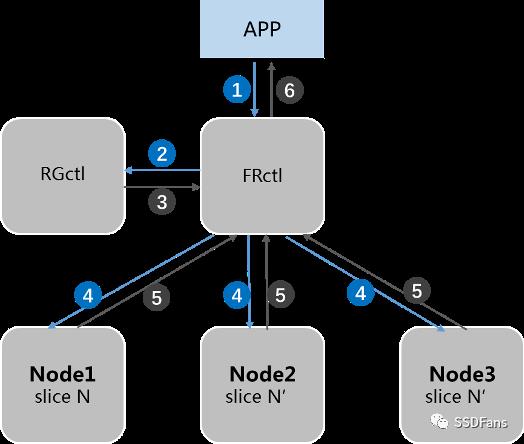

数据副本写入流程:

图10:数据副本写操作流程图

1. 应用主机发起写入操作,写入请求转发至前端控制器(FRctl);

2. 前端控制器访问子卷控制器(RGctl);

3. FRctl从RGctl获取目标卷的元数据,得到数据卷的位置信息;

4. FRctl同时向多个节点(按副本策略)发起写入操作;

5.各副本节点数据写入完成后,返回确认消息;

6.FRctl向前端返回写入完成信息,并更新相关Slice位置信息。

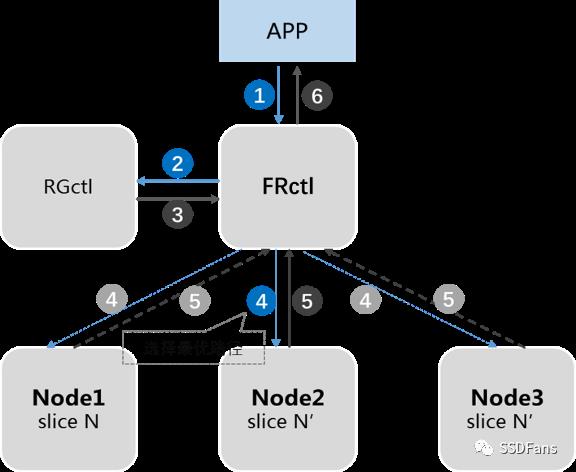

Ø 数据副本读取流程:

图11:数据副本读操作流程

1. 应用主机发起读取操作,读取请求被转发至前端控制器(FRctl);

2. 前端控制器访问子卷控制器(RGctl);

3. FRctl从RGctl获取目标卷的元数据信息,得到数据卷的位置信息;

4. FRctl根据所获得的位置信息,选择时延最优的副本节点发起读取请求;

5. FRctl从目标节点上获取数据;

6. FRctl将数据传回TGctl,由TGctl发送给应用主机。

2.6. 高可用性

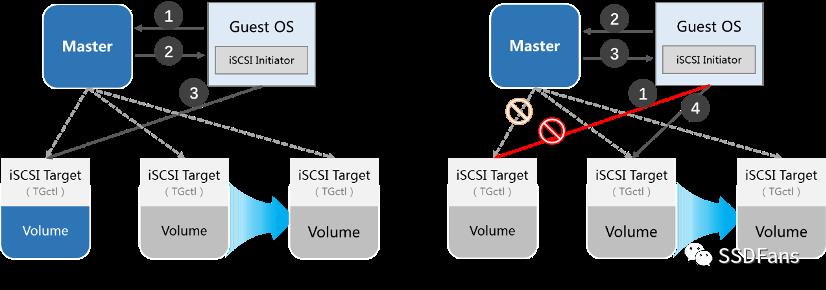

FASS集群使用虚拟IP(简称VIP)智能切换技术,在集群某节点出现故障时,自动将应用的iSCSI、iSER访问请求重定向到后端的可用节点,保证业务的连续性。

应用主机(iSCSI Initiator)登陆iSCSI Target并发起I/O读写后,一旦目标iSCSI Target服务所在的节点故障,VIP就会漂移到其他的可用TGctl节点,确保Discovery Portal与存储卷的iSCSI Target服务始终可用。当有新的iSCSI Initiator登陆请求时,存储集群会将访问重定向到提供iSCSI Target服务的健康节点。

图12:FASS存储集群的故障重定向登陆

当前连接的iSCSI Target服务失效时,FASS集群在启用新的iSCSI Target服务节点后,会通知应用主机重新发起iSCSI登陆,从而导向到提供iSCSI Target服务的新节点,数据访问在短暂中断后即可自动恢复正常。

FASS集群中Master的有效性通过ETCD来监控,一旦服务器节点角色出现异常,存储集群将会重新选出替代的Master,以确保存储集群的高可用。通过该机制,应用主机端的多路径功能无需开启也能保证链路冗余和高可用性。

2.7. 块存储服务

FASS存储集群支持标准的iSCSI、iSER、NVMeoF存储访问协议,可基于以太网或Infiniband网络,为业务应用场景提供高性能块存储服务。

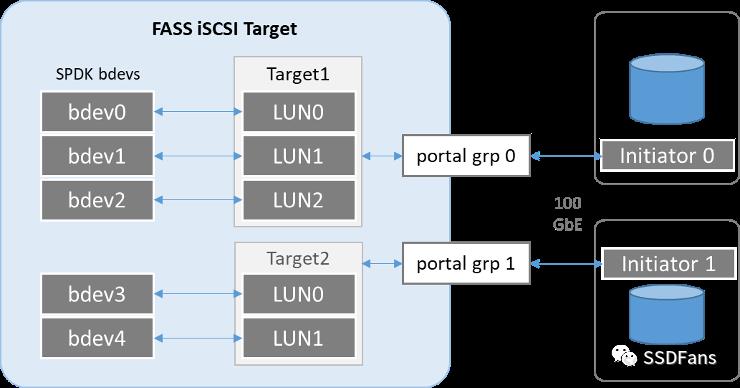

Ø iSCSI/iSER

FASS支持标准iSCSI块存储协议和高性能iSER访问,iSER以RDMA方式运行在Infiniband和高速以太网络上,可以实现远超普通iSCSI的存储访问性能。FASS目前采用RoCE协议来实现iSER访问。

图13: FASS iSCSI Structure

Ø NVMeoF

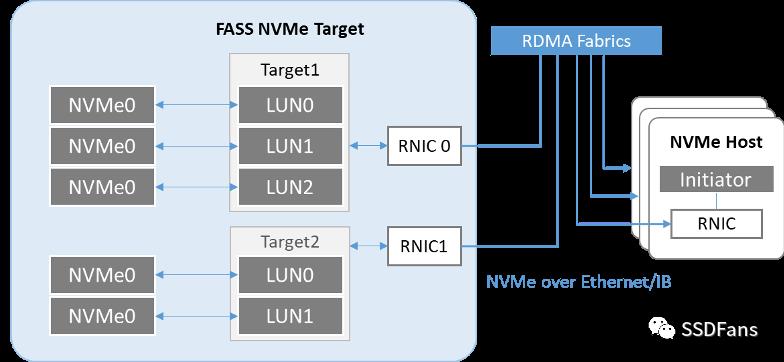

NVMeoF(NVMe over Fabric)可以实现NVMe协议在服务器外部网络上的扩展,通过把NVMe映射到高性能的Fabrics链路传输,消除传统存储协议和低速网络带来的巨大性能开销,从而更好的发挥全闪存储系统的超高性能。

FASS目前采用RDMA Transport(Infiniband或 RoCE v2)实现NVMeoF协议访问,NVMeoF访问链路分为Host(Initiator)端和Target端,Host端采用NVMe-CLI工具,Target端采用SPDK的NVMeoF Target组件,NVMeoF访问时,完成协议解析后会通过子卷控制器连接到目标存储卷。每个存储卷可以通过任一NVMeoF Target进行挂载,赋予全局唯一标识NQN。

图14:FASS NVMeoF Structure

3、 XPE加速引擎

FASS定位为下一代全闪存储产品,性能是其核心生命力,因而在提升性能方面做了很多的尝试与改进,如端到端NVMe协议,DPDK技术的应用等。除此之外,FASS还设计了独有的XPE加速引擎,通过操作系统级的改进,大幅提升全闪存储系统的性能。

3.1. XPE加速引擎

有鉴于此,FASS设计了高性能的引擎核心——XPE加速引擎。它通过私有CPU调度器与虚拟内存管理,基于微控制器实现高效的并发流水线作业,从而从根源上解决存储系统的性能问题。构建了软件定义的超高性能分布式全闪存储系统。

图15:FASS XPE加速引擎

为实现CPU多核心的高效分配与调度,解决NUMA体系中内存访问性能问题,FASS软件绕开了操作系统的CPU调度器,设计了FASS专属的CPU调度系统,通过智能灵活的计算资源分配,消除互斥锁设计,保证了存储I/O性能的最大化输出。

3.2. 分布式微控制器

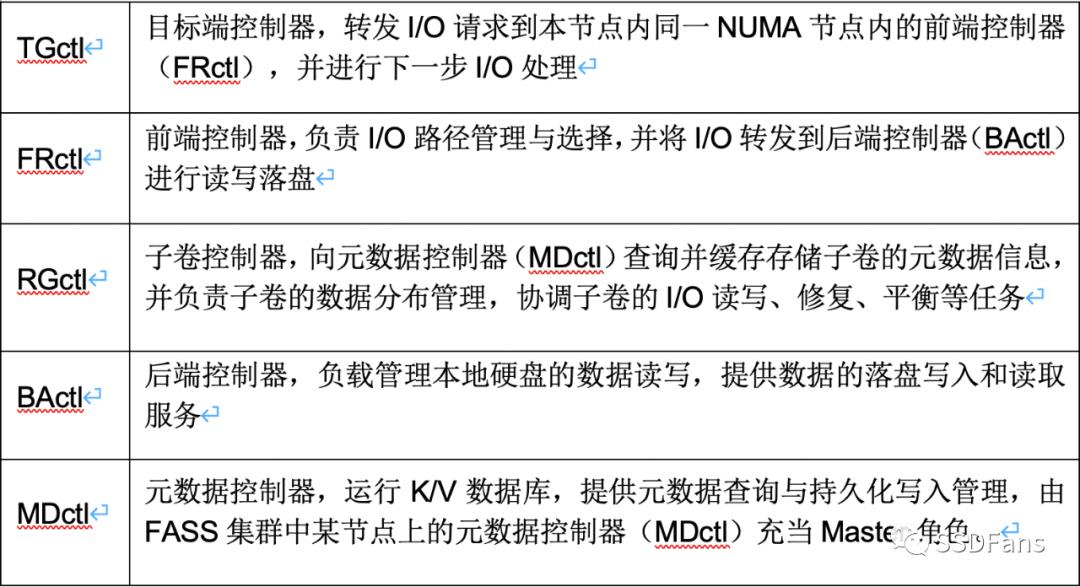

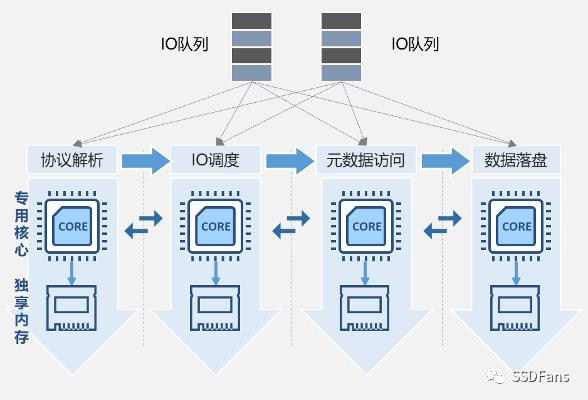

FASS将数据读写I/O分解为协议解析、I/O处理、元数据访问、落盘等阶段,每个阶段由不同的微控制器来专门处理。FASS主要有两类微控制器:I/O控制器和元数据控制器:I/O控制器包括TGctl、FRctl、RGctl、BActl等,元数据控制器有MDctl。

FASS集群中的每个节点上存在多种微控制器,每种微控制器数量也各不相同,各微控制器按最优配比关系分配CPU核心。随着I/O负载特性的变化,FASS系统会根据实际情况进行智能调整,灵活根据负载情况为微控制器分配合理的CPU核心与内存资源。FASS每类微控制器服务专注于特定的任务,独享充足的计算资源,完全避免了NUMA多核架构下内存跨核访问的性能问题。FASS各微控制器的功能见下表:

3.3. 并行流水线

在FASS存储集群中,每个节点的角色都是完全对等的,读写I/O从应用端流入后,被拆分成多个阶段,分别对应着各个微控制器进程。每个I/O被转发到本节点内的其他微控制器上进行下一步处理,逐步流水线推进直到数据最终落盘。各个微控制器间由于相对固定的资源锁定,几乎不存在CPU核心资源竞争与跨NUMA节点的访问,也不存在因为CPU上下文切换与分支预测错误带来的巨大延迟开销,多个读写I/O宏观上被均匀地分布在整个FASS集群,由各个节点的多个CPU核心进行高效的并行协作处理,从而实现了在分布式体系下微秒级的极低时延响应。

图16:FASS集群的并行流水线作业

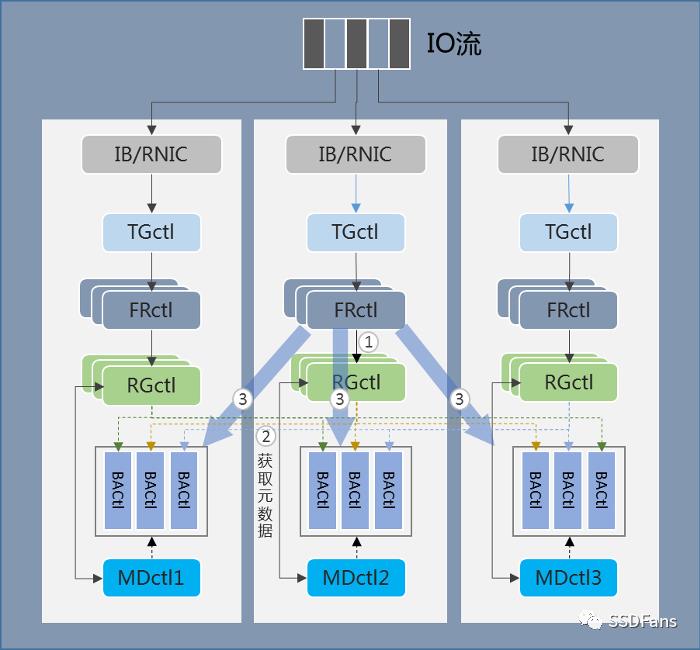

FASS的存储卷可通过任一目标端控制器(TGctl)导出,当应用向存储卷发起读写I/O访问请求时,导出该存储卷的iSCSI Target服务(即TGctl))将相关请求分发到多个前端控制器(FRctl)上执行。随后每个前端控制器会访问对应的子卷控制器,获取子卷控制器内存中的子卷元数据信息。前端控制器找到对应的后端控制器(BActl),下发读写I/O请求到各个BActl(分布在多个节点),最终由BActl完成数据落盘读写并返回完成信息。

元数据控制器(MDctl)负责集群所有元数据的持久化保存,它汇总所有节点的数据分布信息,并通过后端控制器将元数据以三副本的冗余形式写入数据硬盘。每个子卷控制器都需要从MDctl上获取对应存储子卷的元数据信息并加载到内存,以实现快速的集群数据定位访问。

由于每个I/O控制器(TGctl、FRctl、RGctl、BActl)和元数据控制器(MDctl)进程都可在每个服务器节点上并发启用,且每个控制器进程都可以指定专属的CPU核心,并支持智能动态调整CPU核心数量,因此可以实现硬件资源利用率的最大化。

图17:FASS微控制器工作流

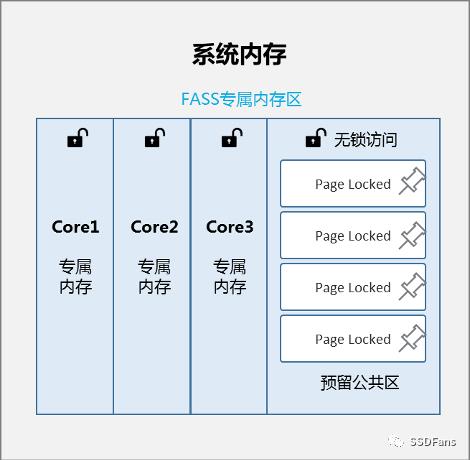

3.4. 虚拟内存管理

Linux操作系统提供的内存分配器,存在CPU亲和性、碎片化、同步等关键问题,会导致极大的访存开销。FASS采用HugePage虚拟内存管理机制,一次性从操作系统申请出所需内存,降低页表查询开销。同时将页面锁定到内存,避免发生页面交换。

图18:FASS虚拟内存管理

FASS为其每个CPU核心分配专属内存空间,实现真正的专核专用,避免内存锁带来的访问开销。同时针对每个微控制器服务(如FRctl、RGctl等),可自动根据I/O负载情况,灵活为不同微控制器分配不同数量的CPU核心,同时也保障了每个微控制器都拥有充足的专属内存空间。

为防止极端情况下出现内存资源不足的问题,FASS会预留足够的公共内存区,在内存资源不足时,各微控制器可以从公共区申请使用。FASS的虚拟内存管理器可以维护不同尺寸的页表粒度,实现灵活保证高效的内存资源分配,并避免Page交换的情况发生。

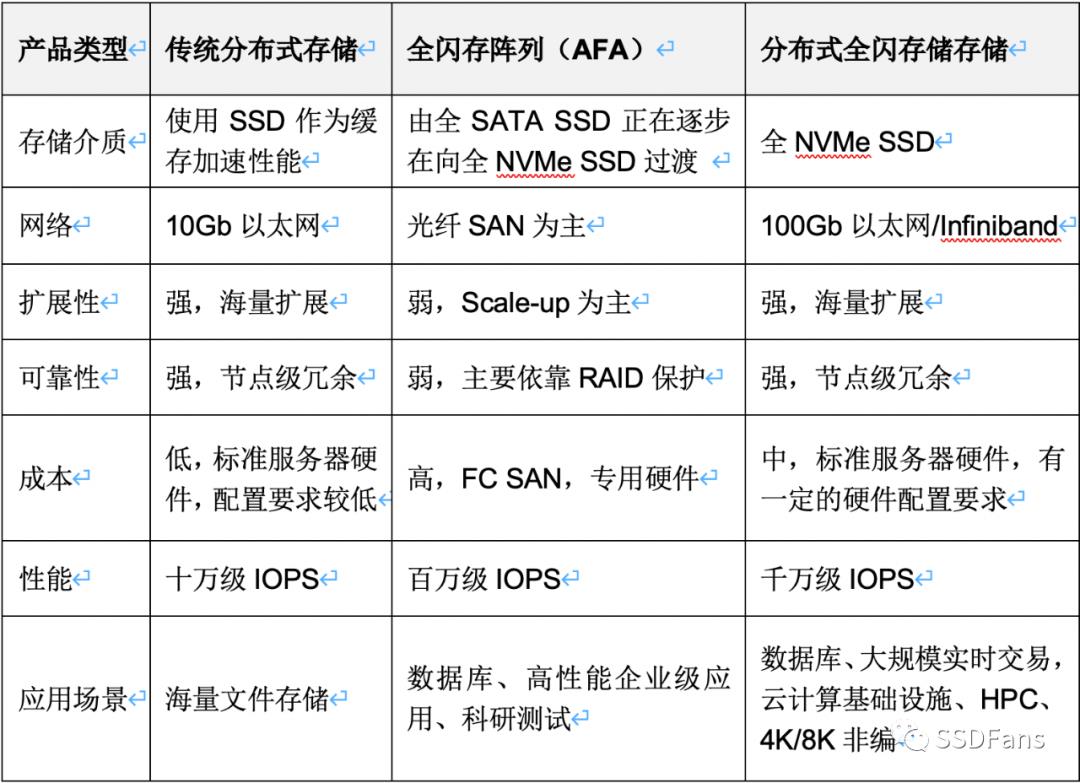

4、 定位与对比

4.1. 传统分布式存储

随着全闪存时代的逐渐来临,传统分布式存储产品也在逐渐转型,配置少量SSD用于缓存加速成为当前主流。但由于受限于底层架构的设计,很多分布式存储系统还无法支持NVMe、RDMA等协议与技术,也未能针对闪存介质特性进行真正的软件优化,因而即使采用全闪存硬盘配置,也无法发挥出SSD硬件的真正性能。

4.2. 全闪存阵列(AFA)

和采于HDD的传统磁盘阵列、分布式存储相比,全闪存阵仍然属于存储阵列范畴:采用控制器架构并集成存储固件(Firmware),以Scale-up为主要扩展方式。全闪存阵列针对全闪存设计,有效地优化了SSD的垃圾回收、颗粒寿命、协议支持等问题,可提供远高于传统磁盘阵列的性能。

但在云计算日益普及、软件定义数据中心的时代背景下,AFA仍存在成本高昂、灵活性差、扩展性低的不足。随着SSD单盘性能的飙升,少量NVMe SSD即可耗尽一个存储控制器的性能,如不考虑控制器的处理能力极限并进行有效扩展,将无法发挥SSD的高性能。

4.3. 分布式全闪存储

从技术发展趋势来看,全闪存储必然是未来几年存储系统的主要形态,而从存储架构的演变角度,软件定义的分布式存储系统替代传统控制器架构的磁盘阵列已是一种必然。采用分布式架构的全闪存存储系统能充分发挥闪存介质的性能,并构建具备云属性的弹性基础设施,是未来全闪存存储系统的发展方向。

随着高速网络、RDMA技术的成熟应用,微秒级的网络的延时使得跨节点扩展已经不再是分布式存储的瓶颈。分布式全闪存存储系统在标准服务器硬件基础上,通过优秀的分布式软件核心对硬件性能的极致利用,可以更高效、更低成本地构建全闪存存储系统。

几种类型存储产品的对比分析

5、 总结展望

以软件定义、超融合、全闪存为代表的创新存储领域呈现着明显高速增长的态势。IDC预测,未来5年中国企业级存储市场仍将保持近10%的年复合增长率,中国企业级存储整体市场已经呈现出了良好的发展势头,从而也将带动国产创新存储厂商的长远发展。

中国的企业级应用市场十分巨大,而全闪存存储的应用比例却始终落后于北美等国外市场。究其原因,除了全闪存阵列价格高昂之外,最大的原因在于传统Scale-out架构已经难已中国用户快速升级的存储需求。全闪存存储不只是SSD的堆叠,还需要提供云计算时代的诸多特性,如高性能、弹性扩展、标准硬件等。从控制器架构到分布式架构,从分布式磁盘存储到分布式全闪存储,可以看到一条很清晰的进化脉络,分布式全闪存储系统是未来较长一段时间内的主流方向,只有兼取全闪存和分布式的长处,才能从根本上应对云计算、大数据、人工智能等场景面临的存储新挑战。

NVMe作为一种性能和效率远超传统SCSI的新型存储协议,可预见将会快速扩大其应用范围、大幅提高企业的IT 基础设施性能并推动企业的业务发展。2020年全闪存储市场需求继续保持快速增长,企业的重要业务都在向全闪存转移。软件定义一切的时代,分布式全闪存储能更好地满足云计算、大数据、人工智能、IoT等新型负载的需求,实现新的业务价值。

|

高端微信群介绍 |

|

|

创业投资群 |

AI、IOT、芯片创始人、投资人、分析师、券商 |

|

闪存群 |

覆盖5000多位全球华人闪存、存储芯片精英 |

|

云计算群 |

全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

|

AI芯片群 |

讨论AI芯片和GPU、FPGA、CPU异构计算 |

|

5G群 |

物联网、5G芯片讨论 |

|

第三代半导体群 |

氮化镓、碳化硅等化合物半导体讨论 |

|

存储芯片群 |

DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

|

汽车电子群 |

MCU、电源、传感器等汽车电子讨论 |

|

光电器件群 |

光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

|

渠道群 |

存储和芯片产品报价、行情、渠道、供应链 |

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代

以上是关于厉害了!分布式存储+全闪存的主要内容,如果未能解决你的问题,请参考以下文章