如何使用MaxCompute Spark读写阿里云Hbase

Posted 阿里云云栖号

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何使用MaxCompute Spark读写阿里云Hbase相关的知识,希望对你有一定的参考价值。

背景

Hbase标准版

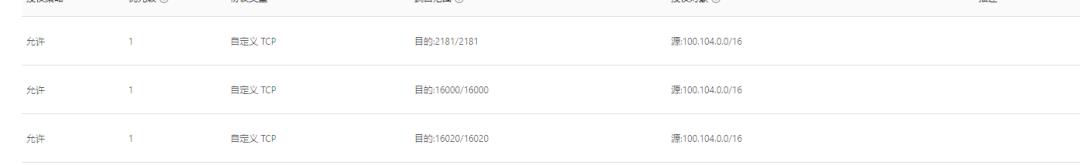

添加Hbase的白名单

100.104.0.0/16

create 'test','cf'

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-mapreduce</artifactId>

<version>2.0.2</version>

</dependency>

<dependency>

<groupId>com.aliyun.hbase</groupId>

<artifactId>alihbase-client</artifactId>

<version>2.0.5</version>

</dependency>

object App {

def main(args: Array[String]) {

val spark = SparkSession

.builder()

.appName("HbaseTest")

.config("spark.sql.catalogImplementation", "odps")

.config("spark.hadoop.odps.end.point","http://service.cn.maxcompute.aliyun.com/api")

.config("spark.hadoop.odps.runtime.end.point","http://service.cn.maxcompute.aliyun-inc.com/api")

.getOrCreate()

val sc = spark.sparkContext

val config = HBaseConfiguration.create()

val zkAddress = "hb-2zecxg2ltnpeg8me4-master*-***:2181,hb-2zecxg2ltnpeg8me4-master*-***:2181,hb-2zecxg2ltnpeg8me4-master*-***:2181"

config.set(HConstants.ZOOKEEPER_QUORUM, zkAddress);

val jobConf = new JobConf(config)

jobConf.setOutputFormat(classOf[TableOutputFormat])

jobConf.set(TableOutputFormat.OUTPUT_TABLE,"test")

try{

import spark._

spark.sql("select '7', 88 ").rdd.map(row => {

val name= row(0).asInstanceOf[String]

val id = row(1).asInstanceOf[Integer]

val put = new Put(Bytes.toBytes(id))

put.addColumn(Bytes.toBytes("cf"), Bytes.toBytes(id), Bytes.toBytes(name))

(new ImmutableBytesWritable, put)

}).saveAsHadoopDataset(jobConf)

} finally {

sc.stop()

}

}

}

add jar SparkHbase-1.0-SNAPSHOT -f;

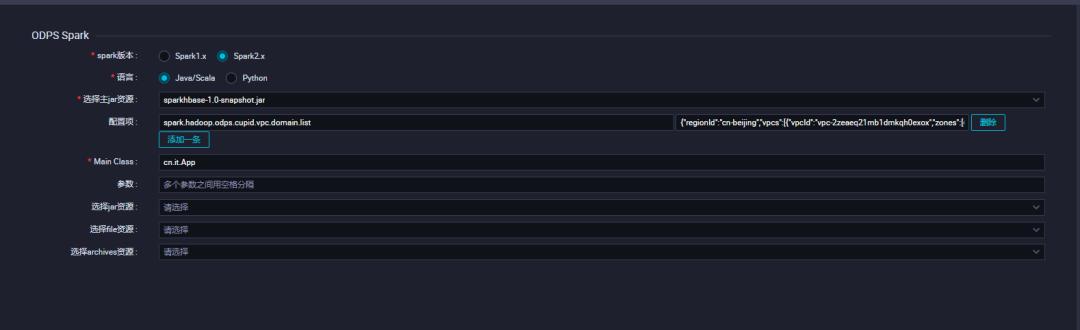

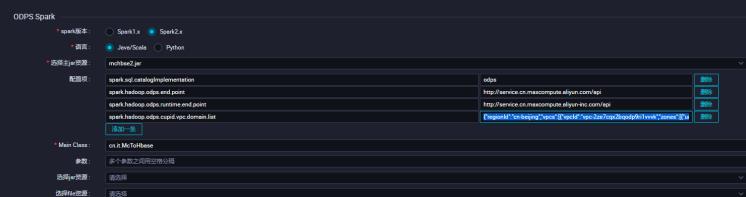

添加配置

需要配置spark.hadoop.odps.cupid.vpc.domain.list

这里的hbase域名需要hbase所有的机器,少一台可能会造成网络不通

{

"regionId":"cn-beijing",

"vpcs":[

{

"vpcId":"vpc-2zeaeq21mb1dmkqh0exox",

"zones":[

{

"urls":[

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":2181

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16000

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":2181

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16000

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":2181

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16000

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-cor*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-cor*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-cor*-***.hbase.rds.aliyuncs.com",

"port":16020

}

]

}

]

}

]

}

Hbase增强版

100.104.0.0/16

create 'test','cf'

<dependency>

<groupId>com.aliyun.hbase</groupId>

<artifactId>alihbase-client</artifactId>

<version>2.0.8</version>

</dependency>

object McToHbase {

def main(args: Array[String]) {

val spark = SparkSession

.builder()

.appName("spark_sql_ddl")

.config("spark.sql.catalogImplementation", "odps")

.config("spark.hadoop.odps.end.point","http://service.cn.maxcompute.aliyun.com/api")

.config("spark.hadoop.odps.runtime.end.point","http://service.cn.maxcompute.aliyun-inc.com/api")

.getOrCreate()

val sc = spark.sparkContext

try{

spark.sql("select '7', 'long'").rdd.foreachPartition { iter =>

val config = HBaseConfiguration.create()

// 集群的连接地址(VPC内网地址)在控制台页面的数据库连接界面获得

config.set("hbase.zookeeper.quorum", ":30020");

import spark._

// xml_template.comment.hbaseue.username_password.default

config.set("hbase.client.username", "");

config.set("hbase.client.password", "");

val tableName = TableName.valueOf( "test")

val conn = ConnectionFactory.createConnection(config)

val table = conn.getTable(tableName);

val puts = new util.ArrayList[Put]()

iter.foreach(

row => {

val id = row(0).asInstanceOf[String]

val name = row(1).asInstanceOf[String]

val put = new Put(Bytes.toBytes(id))

put.addColumn(Bytes.toBytes("cf"), Bytes.toBytes(id), Bytes.toBytes(name))

puts.add(put)

table.put(puts)

}

)

}

} finally {

sc.stop()

}

}

}

原因是spark会把序列化对象以将其发送给其他的worker

解决方案

- 使类可序列化

- 仅在map中传递的lambda函数中声明实例。

- 将NotSerializable对象设置为静态对象,并在每台计算机上创建一次。

- 调用rdd.forEachPartition并在其中创建

Serializable对象,如下所示:

rdd.forEachPartition(iter-> {NotSerializable notSerializable = new NotSerializable();<br />// ...现在处理iter});

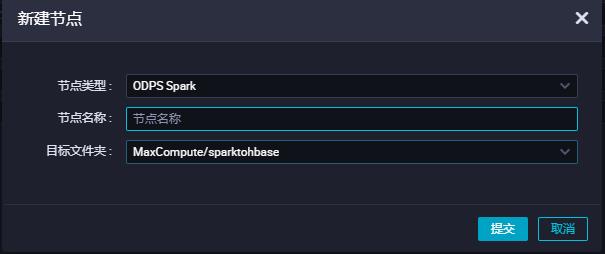

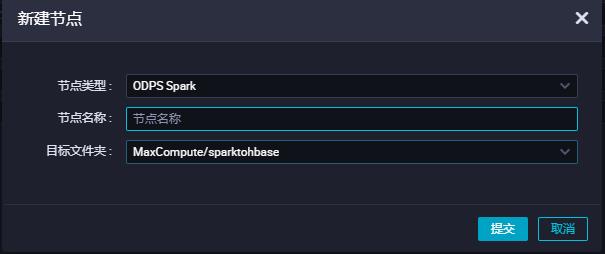

提交到DataWorks

add jar SparkHbase-1.0-SNAPSHOT -f;

添加配置

需要配置spark.hadoop.odps.cupid.vpc.domain.list

2.这里的hbase域名需要hbase所有的机器,少一台可能会造成网络不通

{

"regionId":"cn-beijing",

"vpcs":[

{

"vpcId":"vpc-2zeaeq21mb1dmkqh0exox",

"zones":[

{

"urls":[

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":30020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16000

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":30020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16000

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":30020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16000

},

{

"domain":"hb-2zecxg2ltnpeg8me4-master*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-cor*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-cor*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{

"domain":"hb-2zecxg2ltnpeg8me4-cor*-***.hbase.rds.aliyuncs.com",

"port":16020

},

{"domain":"172.16.0.10","port":16000}

]

}

]

}

]

}

以上是关于如何使用MaxCompute Spark读写阿里云Hbase的主要内容,如果未能解决你的问题,请参考以下文章