大数据学习|Hadoop安装

Posted 网舟科技

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据学习|Hadoop安装相关的知识,希望对你有一定的参考价值。

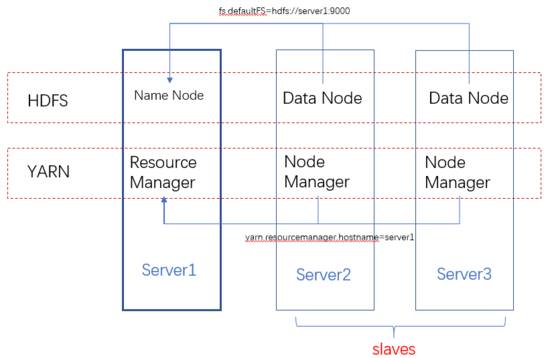

集群架构

hadoop的安装其实就是HDFS和YARN集群的配置,从下面的架构图可以看出,HDFS的每一个DataNode都需要配置NameNode的位置。同理YARN中的每一个NodeManager都需要配置ResourceManager的位置。

NameNode和ResourceManager的作用如此重要,在集群环境下,他们存在单点问题吗?在hadoop1.0中确实存在,不过在2.0中已经得到解决,具体参考:

https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-hdfs/HDFSHighAvailabilityWithNFS.html

https://www.ibm.com/developerworks/cn/opensource/os-cn-hadoop-name-node/index.html

配置

因为每台机器上的配置都是一样的,所以配置时一般是配置好一台服务器,然后复制到其他服务器上。

JAVA_HOME

在hadoop-env.sh文件中配置JAVA_HOME.

core-site.xml

配置hdfs文件系统,通过fs.defaultFS配置hdfs的NameNode节点。

fs.defaultFS

hdfs://{hdfs-name-node-server-host}:9000

通过hadoop.tmp.dir配置hadoop运行时产生文件的存储目录

hadoop.tmp.dir

/usr/local/hadoop-data/tmp

hdfs-site.xml

配置文件副本数量和 second namenode :

dfs.replication

1

dfs.secondary.http.address

{second-namenode-host}:50090

yarn-site.xml

配置YARN的ResourceManager:

yarn.resourcemanager.hostname

{resource-manager-host}

和reducer获取数据的方式:

yarn.nodemanager.aux-services

mapreduce_shuffle

最后记得把hadoop的bin和sbin目录添加到环境变量中:

export HADOOP_HOME=/user/local/hadoop-2.6.5

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

格式化namenode

hdfs namenode -format (hadoop namenode -format)

启动Hadoop

先启动HDFS的NameNode:

hadoop-daemon.sh start datanode

在集群的DataNode上启动DataNode:

hadoop-daemon.sh start datanode

查看启动结果

[root@server1 ~]# jps

2111 Jps

2077 NameNode

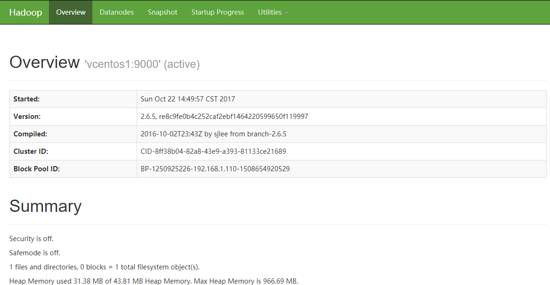

如果启动成功,通过http://server1:50070,可以看到类似下面的页面:

再启动YARN

[root@vcentos1 sbin]# start-yarn.sh

starting yarn daemons

starting resourcemanager, logging to /usr/local/hadoop-2.6.5/logs/yarn-root-resourcemanager-vcentos1.out

vcentos3: starting nodemanager, logging to /usr/local/hadoop-2.6.5/logs/yarn-root-nodemanager-vcentos3.out

vcentos2: starting nodemanager, logging to /usr/local/hadoop-2.6.5/logs/yarn-root-nodemanager-vcentos2.out

[root@server1 sbin]# jps

2450 ResourceManager

2516 Jps

2077 NameNode

hadoop下的sbin目录下的文件是用来管理hadoop服务的:

hadoop-dameon.sh:用来单独启动namenode或datanode;

start/stop-dfs.sh:配合/etc/hadoop/slaves,可以批量启动/关闭NameNode和集群中的其他DataNode;

start/stop-yarn.sh:配合/etc/hadoop/slaves,可以批量启动/关闭ResourceManager和集群中的其他NodeManager;

bin目录下的文件可以提供hdfs、yarn和mapreduce服务:

[root@server1 bin]# hadoop fs

Usage: hadoop fs [generic options]

[-appendToFile ... ]

[-cat [-ignoreCrc] ...]

[-checksum ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] [-l] ... ]

[-copyToLocal [-p] [-ignoreCrc] [-crc] ... ]

[-count [-q] [-h] ...]

[-cp [-f] [-p | -p[topax]] ... ]

[-createSnapshot []]

[-deleteSnapshot ]

[-df [-h] [ ...]]

[-du [-s] [-h] ...]

[-expunge]

[-get [-p] [-ignoreCrc] [-crc] ... ]

[-getfacl [-R] ]

[-getfattr [-R] {-n name | -d} [-e en] ]

[-getmerge [-nl] ]

[-help [cmd ...]]

[-ls [-d] [-h] [-R] [ ...]]

[-mkdir [-p] ...]

[-moveFromLocal ... ]

[-moveToLocal ]

[-mv ... ]

[-put [-f] [-p] [-l] ... ]

[-renameSnapshot ]

[-rm [-f] [-r|-R] [-skipTrash] ...]

[-rmdir [--ignore-fail-on-non-empty]

...]

[-setfacl [-R] [{-b|-k} {-m|-x } ]|[--set ]]

[-setfattr {-n name [-v value] | -x name} ]

[-setrep [-R] [-w] ...]

[-stat [format] ...]

[-tail [-f] ]

[-test -[defsz] ]

[-text [-ignoreCrc] ...]

[-touchz ...]

[-usage [cmd ...]]

来源:网络大数据

若涉及版权请告之我们,我们会在第一时间处理!我们对文中观点保持中立,仅供参考、交流目的。

长按上方二维码识别

【网舟科技】

网舟联合科技(北京)有限公司,成立于2004年,注册资金2000万元,目前拥有13年互联网大数据服务经验,公司长期专注于金融保险、通信、互联网、旅游酒店等行业的电子渠道大数据运营,为客户提供全球领先的电子渠道转型咨询、大数据挖掘和应用定制服务,助力客户互联网转型,提升数字化运营和数据营销能力。

网舟科技是Adobe数字营销的全球解决方案级合作伙伴,具备一流的数字营销一体化解决方案能力。

官方网站: www.eship.com.cn

官方微信: eship2004

以上是关于大数据学习|Hadoop安装的主要内容,如果未能解决你的问题,请参考以下文章