看量化派是如何设计基于HadoopSparkStorm的大数据风控架构?

Posted 人人征信

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了看量化派是如何设计基于HadoopSparkStorm的大数据风控架构?相关的知识,希望对你有一定的参考价值。

量化派是一家金融大数据公司,为金融机构提供数据服务和技术支持,也通过旗下产品“信用钱包”帮助个人用户展示经济财务等状况,撮合金融机构为用户提供最优质的贷款服务。金融的本质是风险和流动性,但是目前中国对于个人方面的征信行业发展落后于欧美国家,个人消费金融的需求没有得到很好的满足。按照央行最新数据,目前央行征信中心的数据覆盖人口达到8亿人[1],但其中有实际征信记录的只有3亿人左右,有5亿人在征信系统中只是一个身份证号码。此外,我国还有5亿人跟银行从来没有信贷交易关系,这5亿人对金融部门来说是陌生人。这样算下来,有征信记录的人只占到全国人口数的23.7%,远低于美国征信体系对人口的85%的覆盖率。如何在信用记录缺失的情况下,做好多个人用户的风险定价,是个棘手的难题。量化派通过基于机器学习和互联网化的风险定价,整合互联网及传统数据源,对个人在消费金融应用场景里的信用风险进行评估。这篇文章就主要介绍一下量化派的大数据平台,以及机器学习在量化派的应用。

一、互联网化的风控创新

量化派及“信用钱包”的核心任务是让用户可以凭借其良好的信用,而无需抵押或者担保就可以贷款。也就是说,用户仅凭信用即可开启财富之门。为了达到这个目的,信用钱包需要把用户个性化的需求与信贷产品信息精准匹配到一起。在帮助用户找到合适自己的信贷产品的同时,也帮助信贷产品公司找到了最合适的贷款用户,从而实现信贷消费者和信贷产品提供者的双赢。为了确保贷款的高成功率,为了更好的掌握用户需求以及对个人进行信用评级,我们需要大数据平台的支持。

目前,可以接入央行征信中心的金融机构仅仅只有银行、持牌照的第三方征信服务商以及部分地区的小贷公司,绝大多数的P2P平台还无法接入央行的征信数据,这无疑加大了P2P平台的风控难度。在征信思路上,传统征信是用昨天的信用记录来判断今天的信用价值,这未见得就是最合理的。在征信技术上,传统的方法是从线下采集信用数据,效率比较低。可以说,传统的线下征信技术限制了数据来源和信用评估思路,而互联网的技术、工具和思维则具备了改变这一切的可能性。回归到征信的本质,其实就在于解决两方面问题:信用能力和信用意愿,换而言之,即解决个人的还款能力和还款意愿,再追根溯源一点,即解决坏账和逾期两个问题[2]。量化派公司基于大数据的用户征信和传统征信殊途同归,所不同的是,传统征信中,数据依赖于银行信贷数据,而大数据征信的数据并不仅仅包括传统的信贷数据,同时也包括了与消费者还款能力、还款意愿相关的一些描述性风险特征,这些相关性描述风险特征的抽取与筛选是量化派的技术核心。相比于传统征信数据的强相关性,这些大数据征信的数据与消费者的信用状况相关性较弱,量化派就利用大数据技术,通过用户授权等方法搜集了更多的数据维度来加强这些弱相关数据的描述能力。这样就使大数据征信不依赖于传统信贷数据,就可以对传统征信无法服务的人群进行征信,实现对整个消费者人群的覆盖[3]。我们的数据来源如下图所示:

图一 量化派的数据来源

二、量化派的大数据平台架构

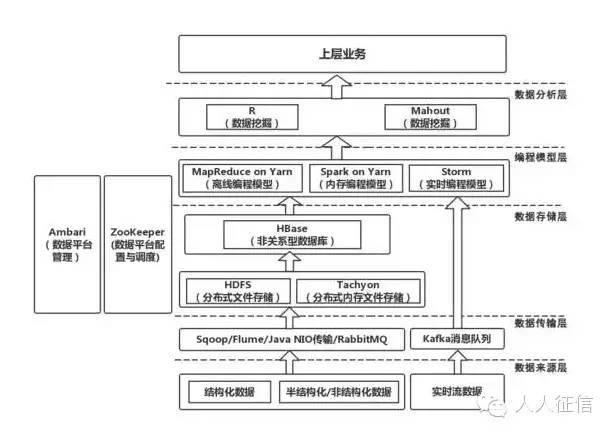

量化派的信用钱包每天都会获取大量的用户的注册信息等结构化数据以及爬虫抓取的非结构化数据,还有第三方的接入数据,系统运行产生的日志数据等等,数据的形式多种多样,如何保护好、利用好这些数据,是公司重中之重的任务。量化派的业务也决定了公司是数据驱动型的。为了更好的满足公司日益增长变化的业务,在大数据平台建设中全面拥抱开源的基础上,进行了不停迭代设计,对数据平台中采用的开源软件进行了深度应用开发,同时还开发了很多契合业务需求的工具软件,很好的支撑我们去实现普惠金融的理想。量化派公司的数据平台架构如图二所示。

图二 量化派的数据平台架构

相比我国的网民数量,信贷用户只占其中的一小部分,所以我司产品的用户基数并不是非常大,但是,为了给信贷用户更准确的信用评级,对于每个信贷用户我们都会从多个渠道获取大量的有效数据,这些数据聚合起来也是海量数据规模。公司发展伊始,几乎将所有的数据都存放在mysql关系数据库中,工程师使用标准SQL语句来存储或者调用数据资源。Mysql很快就遇到了性能瓶颈,虽然可以通过不停地优化整个Mysql集群以应对数据的快速增长,但是面对复杂的数据业务需求,Mysql显然无法提供最优的解决方案。所以我司最终决定将数据迁移到大数据平台上,Mysql仅用来存储需要经常变化的状态类数据。除了系统运行日志直接存放在HDFS之中,大量的数据利用HBase来进行管理。HBase中的数据按照不同的数据源存放在不同的表中,每张表按照业务和存储需求对rowkey进行精心设计,确保海量数据中查询所需数据毫秒级返回。

根据业务的不同特点,对于常规的数据ETL处理,我们使用MapReduce[4]框架来完成;BI和数据挖掘这些工作都放到了Spark[5]上。这样一来,依赖不同任务或不同计算框架间的数据共享情况在所难免,例如Spark的分属不同Stage的两个任务,或Spark与MapReduce框架的数据交互。在这种情况下,一般就需要通过磁盘来完成数据交换,而这通常是效率很低的。为了解决这个问题,我们引入了Tachyon[6]中间层,数据交换实际上在内存中进行了。而且,使用了Tachyon之后还解决了Spark任务进程崩溃后就要丢失进程中的所有数据的问题,因为此时数据都在Tachyon里面了,从而进一步提升了Spark的性能。Tachyon自身也具有较强的容错性,Tachyon集群的master通过ZooKeeper[7]来管理,down机时会自动选举出新的leader,并且worker会自动连接到新的leader上。

多维度的征信大数据可以使得量化派可以融合多源信息,采用了先进机器学习的预测模型和集成学习的策略,进行大数据挖掘。不完全依赖于传统的征信体系,即可对个人消费者从不同的角度进行描述和进一步深入地量化信用评估。公司开发了多个基于机器学习的分析模型,对每位信贷申请人的数千条数据信息进行分析,并得出数万个可对其行为做出测量的指标,这些都在数秒之内完成。

三、不同场景的机器学习方法

上部分说到量化派首先需要对用户进行信用风险的评估,为了让用户可以仅凭信用,而无需抵押和担保就可贷款成功。美国有着很完善的征信体系,以及成熟的信用评估系统。通过几十年的发展,美国的三大征信局[8]对85%的公民有着详细的信用记录:包括信用卡,房贷,以往的住址,工作等情况都有记录在案。而且在找工作,租房时候也会查询个人信用记录,如果有违约等不良行为也会反馈给征信局。Fair Issac公司的FICO评分是业界应用最为广泛的评分,是建立在详细的个人征信记录上的预测系统。FICO从最开始的用图表画出的评分,到后来演化为logistic regression类的回归算法,用来预测用户在未来一段时间内违约的可能性。近年来,在predictive analytics 方面的发展,deep learning 在supervised learning里面得到了广泛应用。

量化派对用户的信息整合也包括了用户的社交信息,不光包含了用户的画像 (性别、职业、爱好等等),也包含了用户之间的关系。如果说每个人是图中的一个节点,那么人与环境所形成的关系就是两点间的线。当把“点和线”综合起来分析时,我们对个人的性格特征、信用状况、财富属性都会有更深层、更全面的理解。Google 的 PageRank 算法考虑到了web页面的相关性来提高页面的质量,例如权重高的页面指向链接的页面对应的权重相对来说会比较高。类似来说,信贷风险低的用户的常用联系人的小圈子,个人资质的也应该是比较好的。

另一个方面,“信用钱包”需要把用户个性化的需求与信贷产品信息精准匹配到一起。帮助用户找到合适自己的信贷产品,实现信贷消费者和信贷产品提供者的双赢。我们对信贷产品向用户做了基于协同过滤的和基于产品信息匹配的推荐。在对用户做了较为准确的信用评价之后,我们的分发平台(如图三所示)会根据贷款用户的贷款需求来分派给相应的贷款产品,这样就出现了一个客户面对多款信贷产品的情况。我们会根据批贷额度、贷款利率、承诺放款速度等因素在多个信贷产品中选出最适合用户的产品。

图三 分单平台系统

四、美国的风控系统案例

打造一流的风控系统不是光靠数据分析师团队能够做到的,整个风控是需要在公司的DNA里面。美国的Capital One是最早利用大数据分析来判断个人借款还款概率的公司,本文的作者都曾经在Capital One 工作过,并在金融危机发生的时候也在那边,目睹了他是如何发展壮大成第五大银行的。在危机开始的时候,非常果断的把有潜在问题的GreenPoint Mortgage整体出售,并在危机发生的时候,谨慎挑战风险政策来控制风险,并在危机发生的时候以非常低廉的价格收购华盛顿地区的Chevy Chase 银行, ING Direct, HSBC Card北美分部。并完善其Local Banking, Global Lending的策略。

Capital One的风控系统是通过多年的积累和演变而形成的。Capital One 的 Analytics 部门里面分为几个种类,Data Analyst, Business Analyst, Statistician/Modeler. 不仅仅是分析师专注的做模型,做风控来对模型进行大数据分析。所有的决策者,包括商务的总监,运营副总等,所有的决策都会有大量的数据分析,模型策略做支撑。

Capital One在各个业务部门都有很多的决策引擎和模型来支撑。在获取用户时,根据不同的业务线prime, subprime, 汽车金融等,有专门的 customer model,risk model等。在用户关系管理方面,有cross-sell model, customer contact model等。除此还有专门的反欺诈模型,包含identify-fraud model, payment fraud model等等。不同的业务线有着这么多种类的模型,对于这些模型的监管也都是有一套系统的流程的。对于每个模型,模型开发人员会对模型开发写出详细的文档,有着一套类似于code review, unit test的检验机制。公司层面,部门设有专门的中高级别scoring officer (模型官), 负责定期对模型进行监管和监测。除了对于整体模型的效果的监管,整体评分的分布的稳定性;还包括在变量层面的监管,监测模型的重要变量的稳定性。 Capital One 用到的大量征信局的数据和在自身平台上沉淀的用户数据,根据以往的用户的个人行为和违约记录,建立的用户风险决策模型对用户进行评估,模型的效果会比FICO分数高40%以上。

面向个人消费的风控体系的搭建是一个长期的,系统的工程。在中国目前的市场情况,缺失的个人信用风险和高速发展的互联网金融,以及未被满足的普惠金融需求是十分矛盾的。移动互联网时代的到来,对个人风险评估带来了崭新的视角。大数据平台和机器学习的结合能够带来多样化的创新,量化派的使命就是通过这两者的结合来服务互联网金融机构,降低全行业的风险。

人人征信(renrenzhengxin)

我们长期关注于第三方征信业发展与研究,传递征信行业最新动态,提供企业征信牌照与个人征信牌照申请咨询业务。

合作与交流

邮箱:66171709@qq.com

转载文章请注明出处:人人征信

以上是关于看量化派是如何设计基于HadoopSparkStorm的大数据风控架构?的主要内容,如果未能解决你的问题,请参考以下文章