语义赋能的AI推理模型--基于连词加强网络和强化学习的自然语言推理模型

Posted 浙江大学CADCG国家重点实验室

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了语义赋能的AI推理模型--基于连词加强网络和强化学习的自然语言推理模型相关的知识,希望对你有一定的参考价值。

ACL 2018

Discourse Marker Augmented Network with Reinforcement Learning for Natural Language Inference

Boyuan Pan1 Yazheng Yang2 Zhou Zhao2

Yueting Zhuang2 Deng Cai1 3 4 Xiaofei He1 4

1State Key Lab of CAD&CG, Zhejiang University

2College of Computer Science, Zhejiang University

3 Alibaba-Zhejiang University Joint Research Institute of Frontier Technologies

4Fabu Inc.

摘 要

一直以来,自然语言推理问题都是自然语言处理中最为热门和棘手的问题之一。在目前最热门的任务中,都是给定两个句子(前提,猜想),我们需要去判断这两个句子的逻辑关系是蕴涵(Entailment)、中立(Neutral)或矛盾(Contradiction)。一个高效的自然语言推理模型可以在以语义理解为基础的众多领域得到广泛应用,如对话机器人,问答系统和文本生成系统等。但是,现有的自然语言推理模型主要在改进网络模型,对于文本的语义理解或者逻辑推断并没有足够的深入。

浙江大学CAD&CG国家重点实验室与阿里巴巴集团合作,提出并设计了提供了一种自然语言推理方法——基于连词标记和强化学习的自然语言推理方法。给定一个前提句,一个假设句,我们的方法可以推断出这两个句子的逻辑关系是(蕴涵,中立,矛盾)中的一种。我们首先在连词预测任务中训练一个编码器,然后将这个编码器嵌入一个自然语言推理模型中来提高模型的性能。此外,由于用于训练的大规模数据集的标签都是由很多人来标注的,所以每个句子对可能有多个标签(虽然最终会被整合成为一个)。考虑到最终整合的不同标签的置信度显然是不同的,我们设计了一个奖励函数来用强化学习优化模型。我们在斯坦福自然语言推理数据集(SNLI)和多类别自然语言推理数据集(MultiNLI)这两个数据集上进行了对比实验,并取得了当前最好的效果。

正 文

近日,浙江大学CAD&CG国家重点实验室和阿里巴巴-浙大前沿技术联合研究院的博士生潘博远和蔡登教授以及浙江大学计算机学院的何晓飞教授、赵洲教授、庄越挺教授和硕士生杨雅正与共同合作,设计了基于连词加强网络的自然语言推理方法,并在此基础上应用了强化学习来整合不同样本的标注意见不统一的情况,从而提升模型的稳定性。

该成果已发表于自然语言处理领域国际顶级会议ACL 2018。我们对两个大规模数据集进行了大量的实验,证明我们的方法比其他先进的解决方案取得了更好的结果。

1

亮点一 连词加强网络

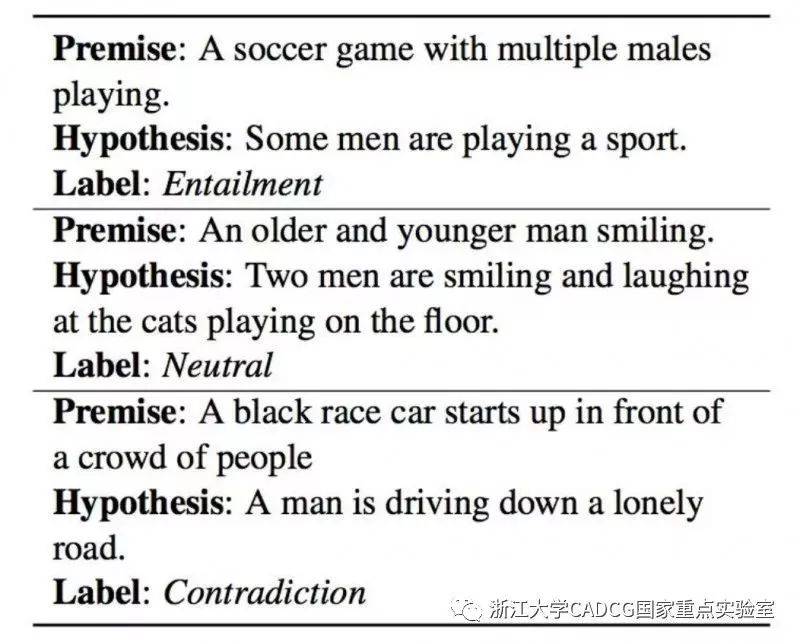

近年来,随着一些高质量的大规模基准数据集的公开,如斯坦福自然语言推理数据集(SNLI)和多类别自然语言推理数据集(MultiNLI)等,自然语言推理模型的性能得到了显着提升。图1显示了SNLI数据集的一些例子。大多数先进的模型集中在前提句和假设句之间的交互架构上,很少关注句子之间的连接转折关系,而这是自然语言理解的核心问题。

图 1:三个在斯坦福自然语言推理数据集中的样例,分别代表着蕴涵关系,中立关系和矛盾关系。

人们通常用一些特定的词汇来表达两句话之间的关联关系,如“但是”或“并且”,表示为连词。这些连词与两句话的内在联系有着深刻的联系,并且直观地与自然语言推理的意图相对应,例如“但是”到“矛盾”,“所以”到“蕴涵”等。

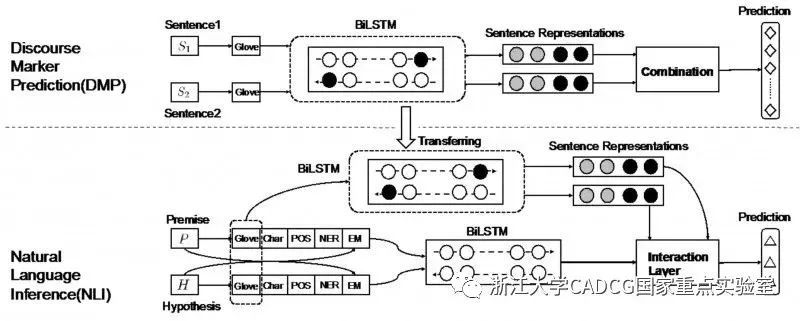

我们提出了一个用于自然语言推理的话语标记增强网络,我们将知识从现有的监督任务:连词标记预测(DMP)迁移到的自然语言推理模型中集成。我们首先提出一个句子编码器模型,它可以从DMP任务中学习句子的表示,然后将编码器注入自然语言推理网络。

图 2:连词加强网络概念图。

如图2所示,上半部分是连词标记预测(DMP)模型,下半部分是自然语言推理(NLI)模型。我们首先预训练DMP模型,再将训练好的以双向长短时记忆网络(BiLSTM)为核心的编码器迁移到一个新的NLI模型中来作为另一个编码器的初始化,使得自然语言推理的过程中含有通过连词所蕴含的语义信息从而形成整个连词加强网络。

2

亮点二 使用强化学习充分利用人工标注信息

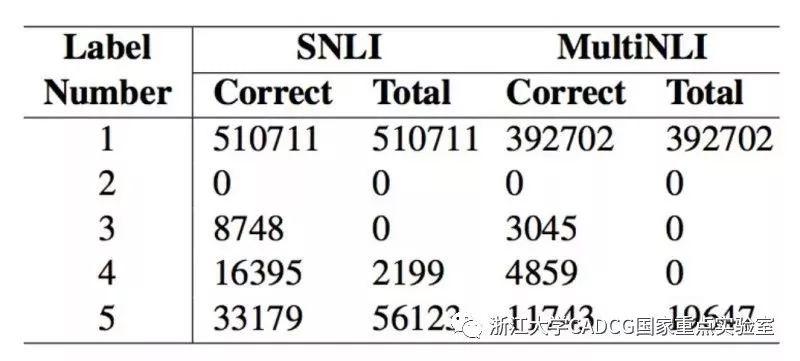

图 3:SNLI和MultiNLI数据集的统计表。

如图3所示,我们的数据集中的很多示例都被几个人标注,注释者的选择并不总是一致的。例如,当SNLI中的标签号为3时,"total = 0"表示没有示例具有3个标注者; "correct = 8748"意味着有8748个例子,其正确标签的数量是3(注释者的数量可能是4或5,但有些提供了错误的标签)。尽管每个示例的所有标签都将统一为最终(正确)标签,但单个示例的标签多样性表明结果的置信度较低。因此,仅使用最终标签优化模型并不理想。

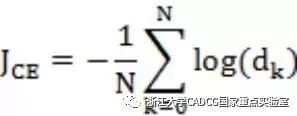

直接使用最终的标签训练模型可能在一些情况下不太适用,有些样本存在歧义,并且标注者的标注的标签不一致。比如,考虑如下从SNLI数据集中选取的一个样例:"前提:A smiling costumed woman is holding an umbrella. ","假设:A happy woman in a fairy costume holds an umbrella. "最终的标签是中立,但是原始的五个标注者给出的标签是:中立、中立、蕴涵、矛盾、中立,在这个例子中"smiling"和"happy"可能导致不同的理解。最终标签的可信度低于那些所有标注者给出的标签都是一样的样本。为了更加接近的模拟人类的思考,我们提出了一个新的目标函数,它结合了正确标签的对数概率和由强化学习数据集属性定义的奖励。大部分自然语言推理方法的目标函数都是最小化负的交叉熵:

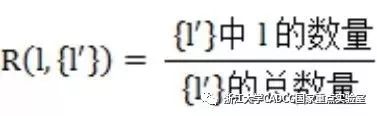

其中dk是第k个样本,N为数据集中总样本数。除此之外,我们的方法还根据数据集的特点增添了对每个样本的所有其他标签的考虑。在我们的训练集中,每个样本(句子对和其逻辑关系)中的标签(逻辑关系)都是由一个至多个人工标注的,所以有很多样本的标签是不统一的。虽然最终数据集会对每个样本赋予一个唯一的标签,但这些人工的思考结果也是值得借鉴的信息。我们使用强化学习来优化一个我们设定的奖励函数的期望:

![]()

其中![]() 为给定前提和假设后得到的预测结果为

为给定前提和假设后得到的预测结果为 的概率,奖励函数是:

的概率,奖励函数是:

这表示我们预测的标签在每个样本的所有标签中的比例。哪怕不等于最终总结的唯一标签,也不一定等于零。我们将两种损失函数用一个线性函数结合起来。

3

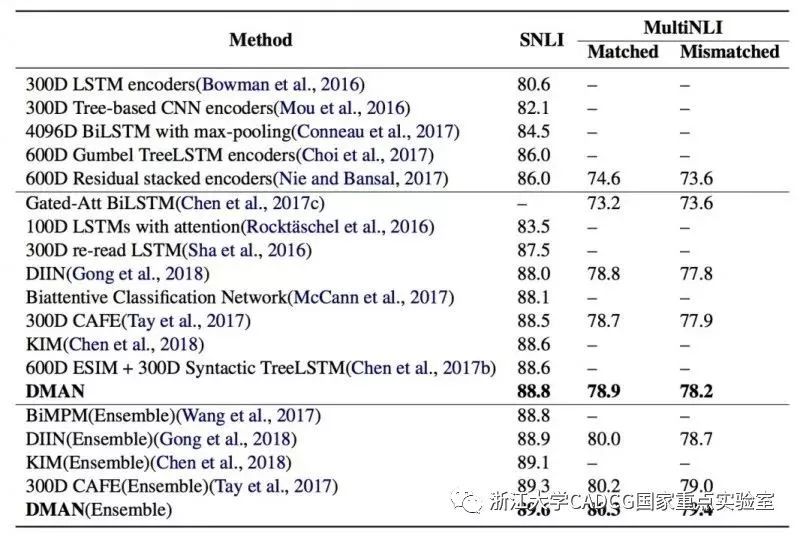

亮点三 本方法在大型数据集上取得了当前最高准确率,证明其有效性

本方法的有效性在斯坦福自然语言推理数据集(SNLI)和多类别自然语言推理数据集(MultiNLI)这两个数据集上进行了对比实验。斯坦福自然语言推理数据集是斯坦福大学公开的自然语言推理数据集,包括了训练集和测试集中的57万个句子对;多类别自然语言推理数据集是纽约大学公开的自然语言推理数据集,包含了43万个句子对。这两个数据集是当前自然语言推理任务最为流行的高质量大规模数据集。同时,我们使用BookCorpus作为预训练编码器所用的数据集。

图 4:本方法(DMAN)在SNLI和MultiNLI数据集上均取得了当前最高分。

本实验在测试集上与当前效果最好的已发表方法都进行了比较。从图4看出,总体来说我们的方法(DMAN)相比于其他方法具有更高的准确率,并且在所有的数据集上都达到了目前的最好效果。

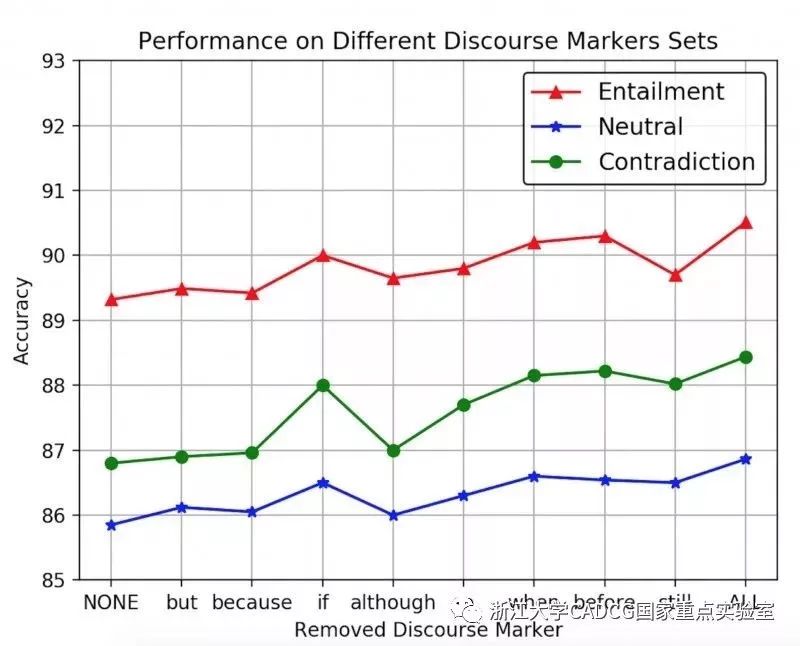

我们还展示了不同连词对于不同类型逻辑关系标签的影响,如下图:

图 5:在不同连词组成的数据集上预训练的结果。"NONE"指模型不用任何连词信息;"ALL"指模型使用了所有连词作为预训练数据集。

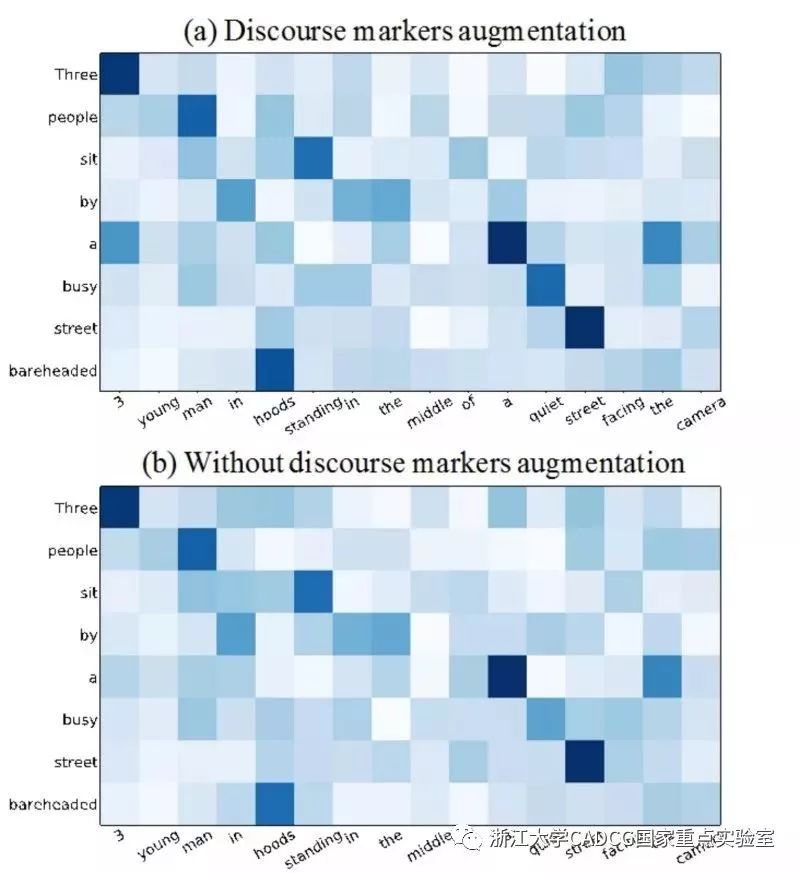

如图6,我们还提供了在相似度矩阵的可视化分析来对比使用连词标记前后的效果。我们选择一个句子对,其前提句是" 3 young man in hoods standing in the middle of a quiet streetfacing the camera. ", 假设句是" Three people sit by a busystreet bareheaded. " 。我们观察到,在诸如" people " 与" man ", " three "与" 3 "等同义词之间,这些值高度相关。然而,如果没有连词标记加强,那些可能具有" hoods "与" bareheaded ", " quiet "与" busy "的矛盾意义的句子会变得更糟。

图 6:相似度矩阵的二维可视化图。

(a)为使用连词加强后的模型,(b)为没有使用连词信息的模型。

长按二维码,送你清凉一夏

以上是关于语义赋能的AI推理模型--基于连词加强网络和强化学习的自然语言推理模型的主要内容,如果未能解决你的问题,请参考以下文章