预训练在自然语言处理的发展: 从Word Embedding到BERT模型

Posted AINLP

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了预训练在自然语言处理的发展: 从Word Embedding到BERT模型相关的知识,希望对你有一定的参考价值。

以下是新浪微博机器学习部AI Lab的资深算法专家张俊林博士11月7日关于BERT的PPT分享,已取得授权转载到这里。节选微博上两段相关的信息:

@张俊林say: BERT这种具备NLP里程碑意义的模型你要是不搞明白就别说自己是搞自然语言处理的了

@微博机器学习

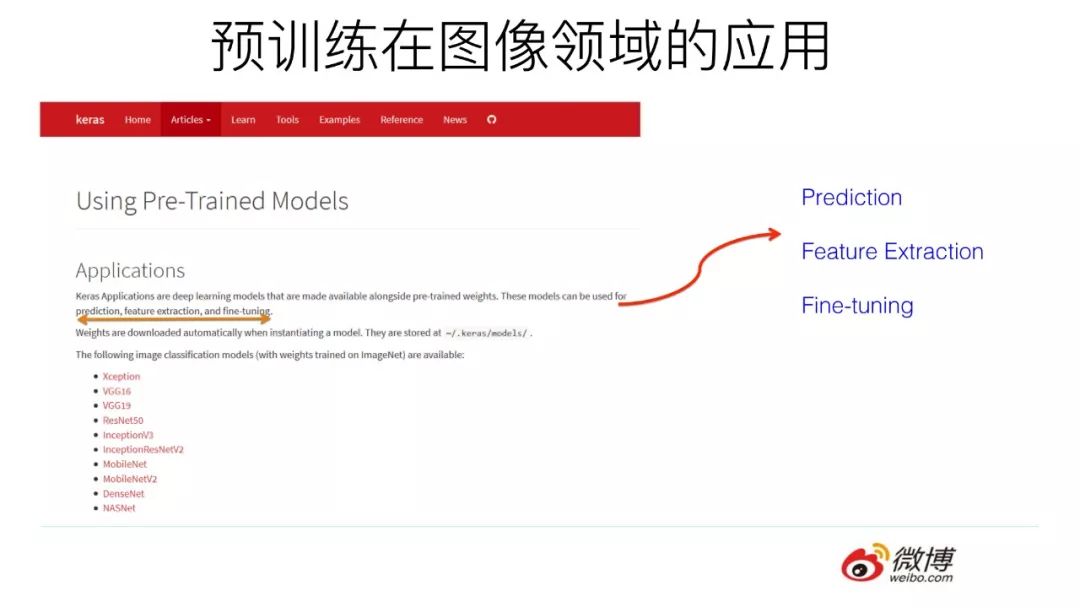

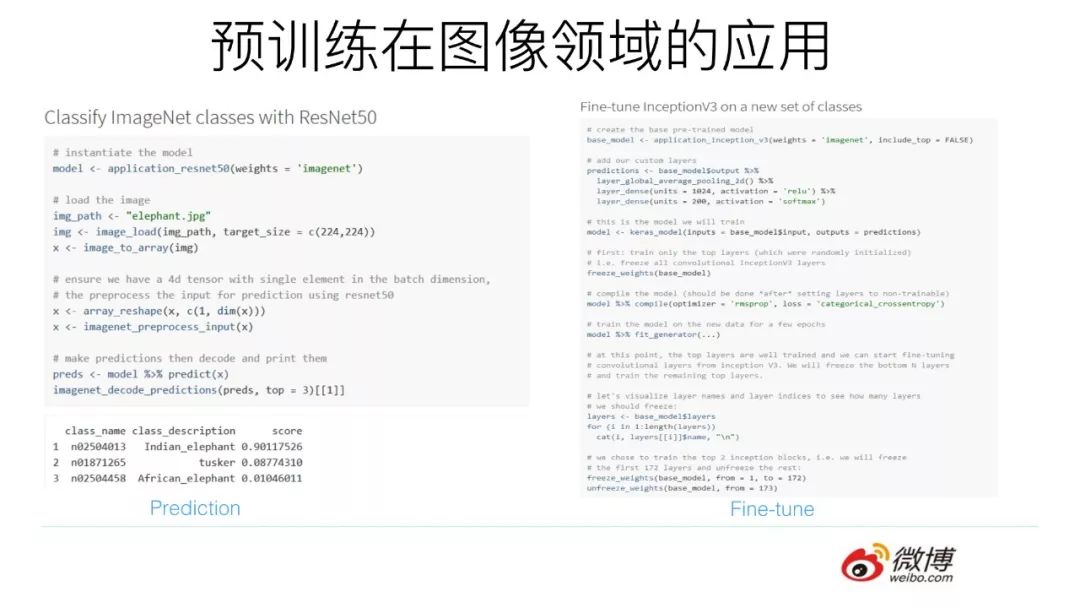

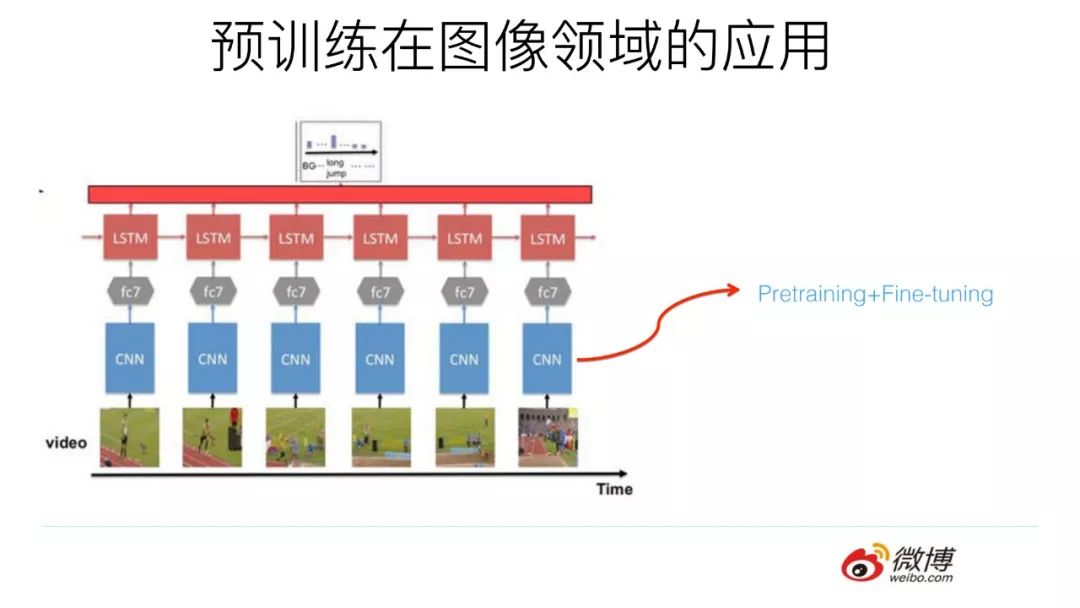

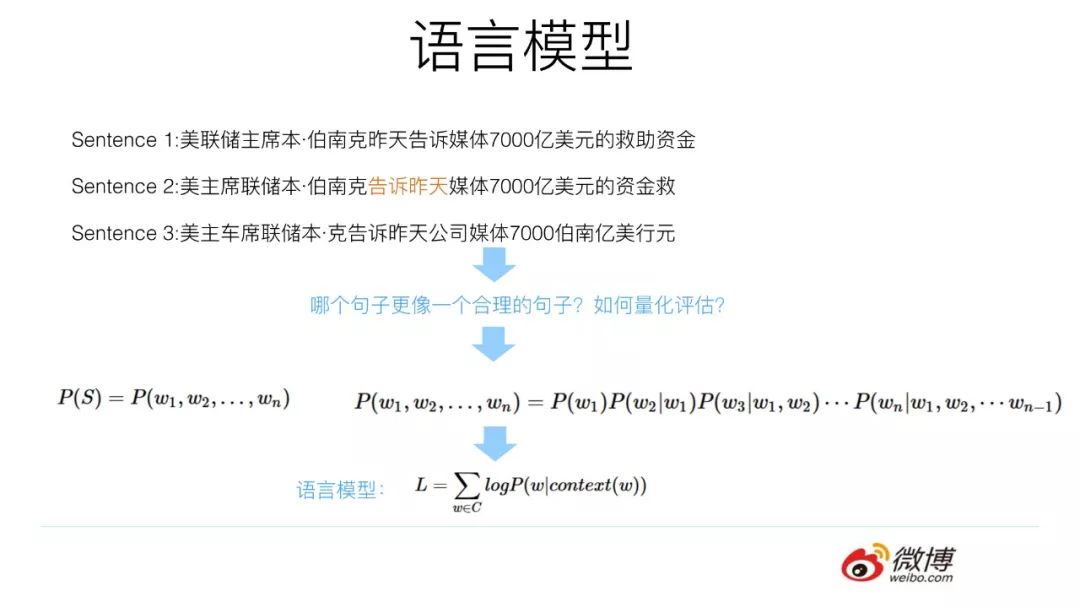

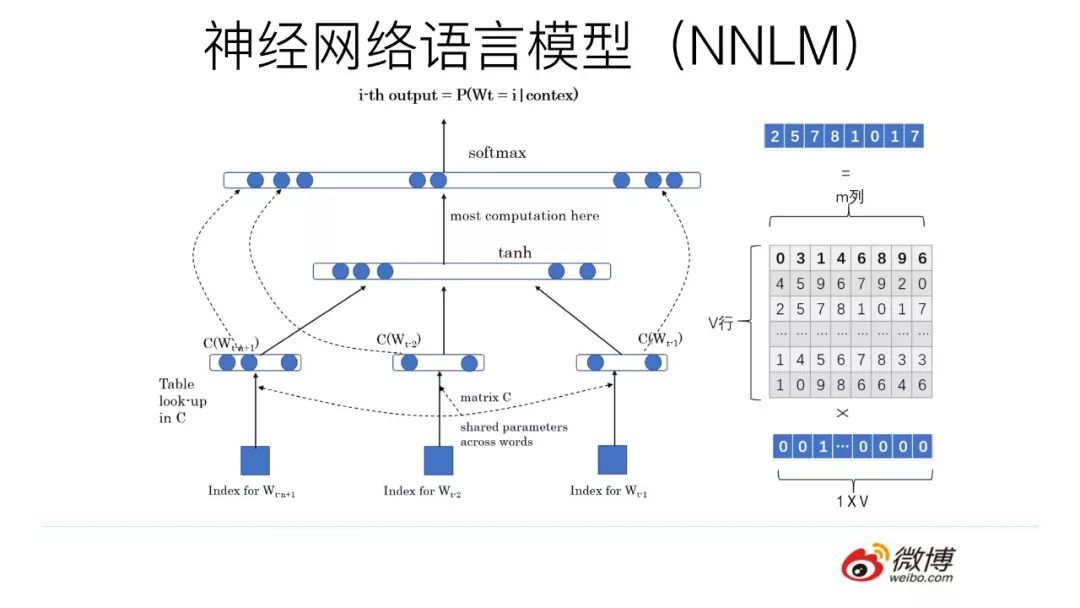

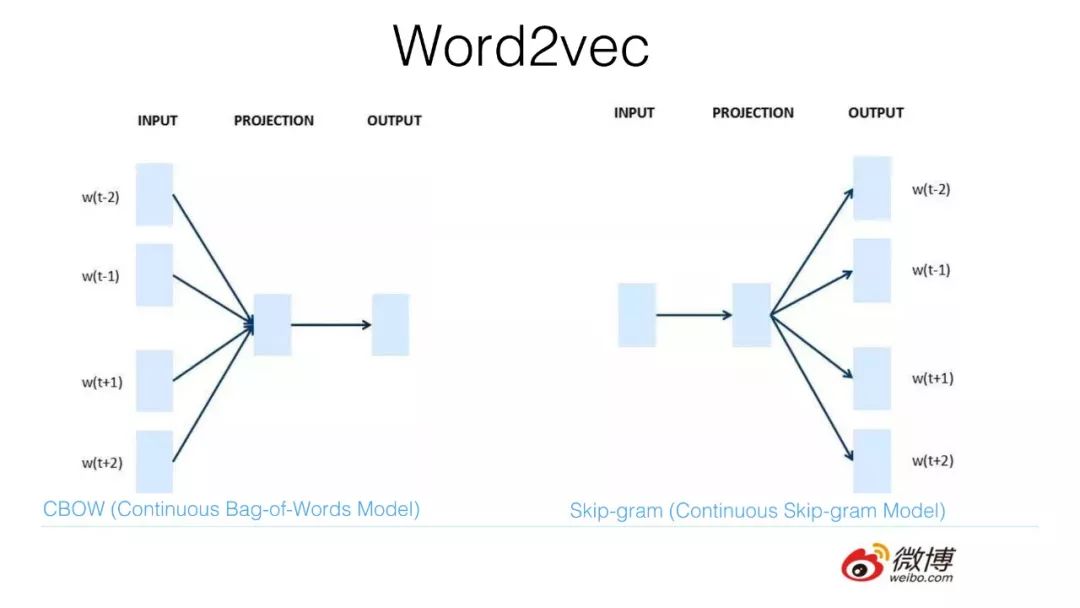

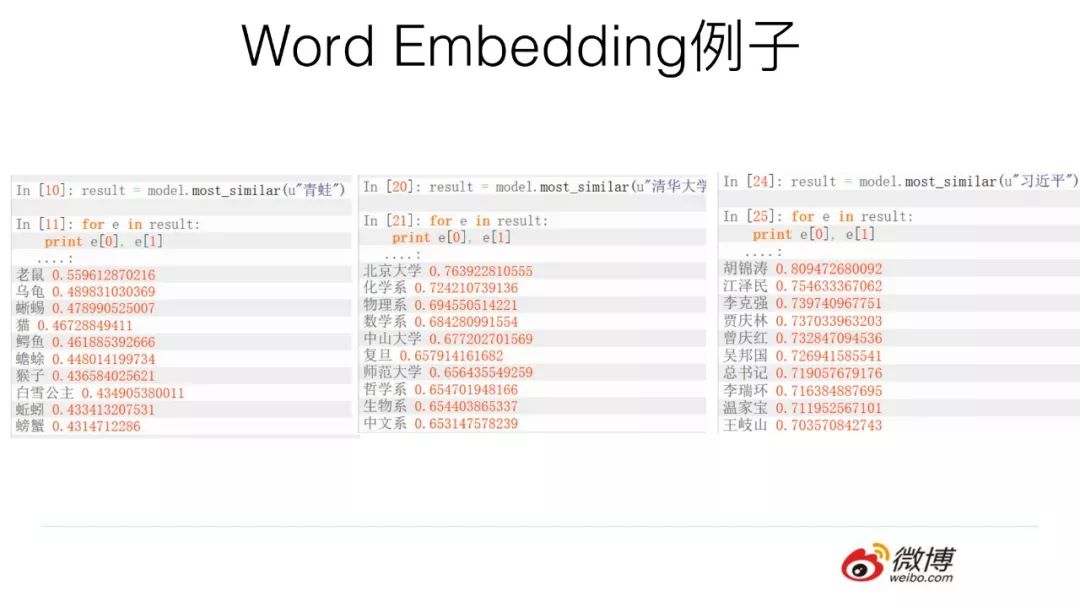

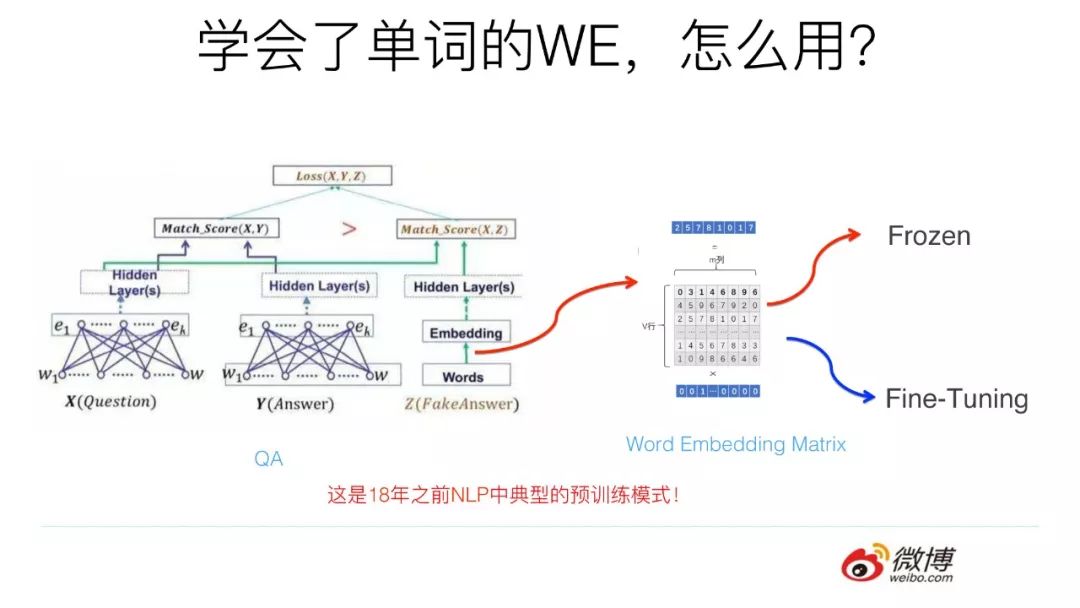

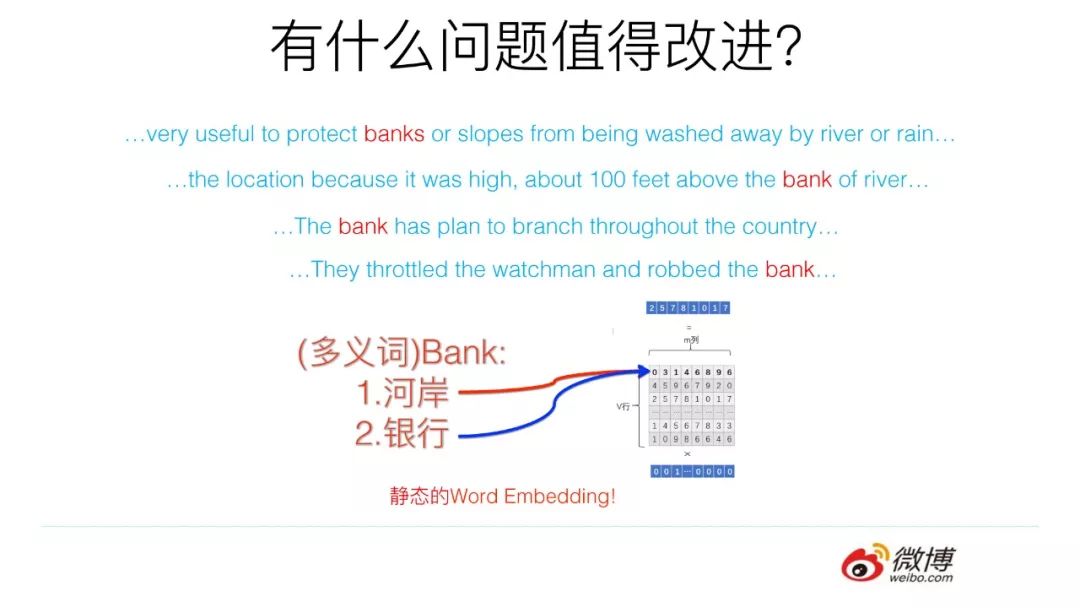

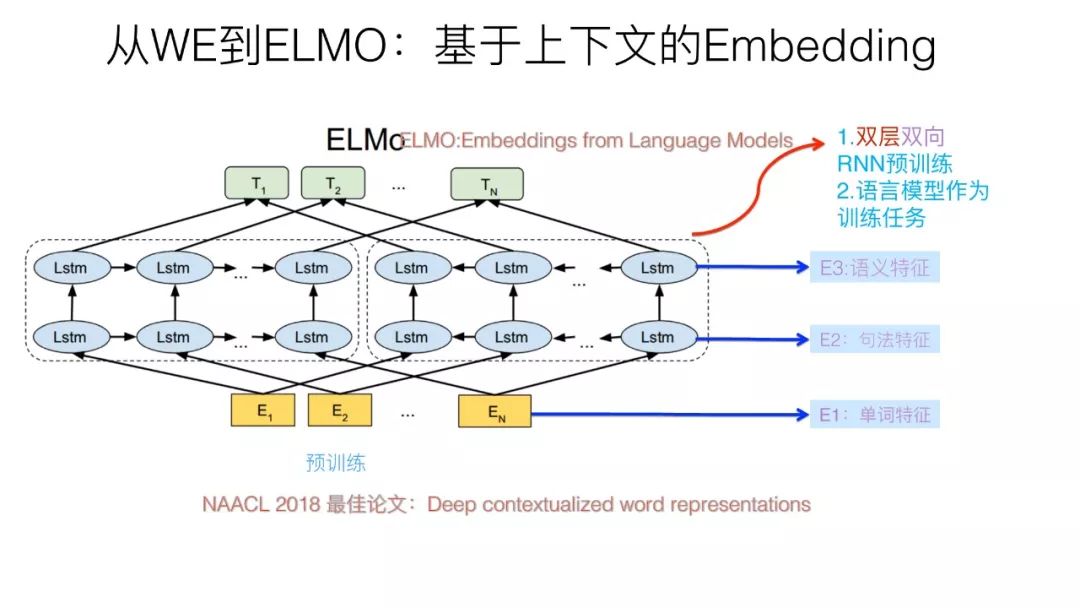

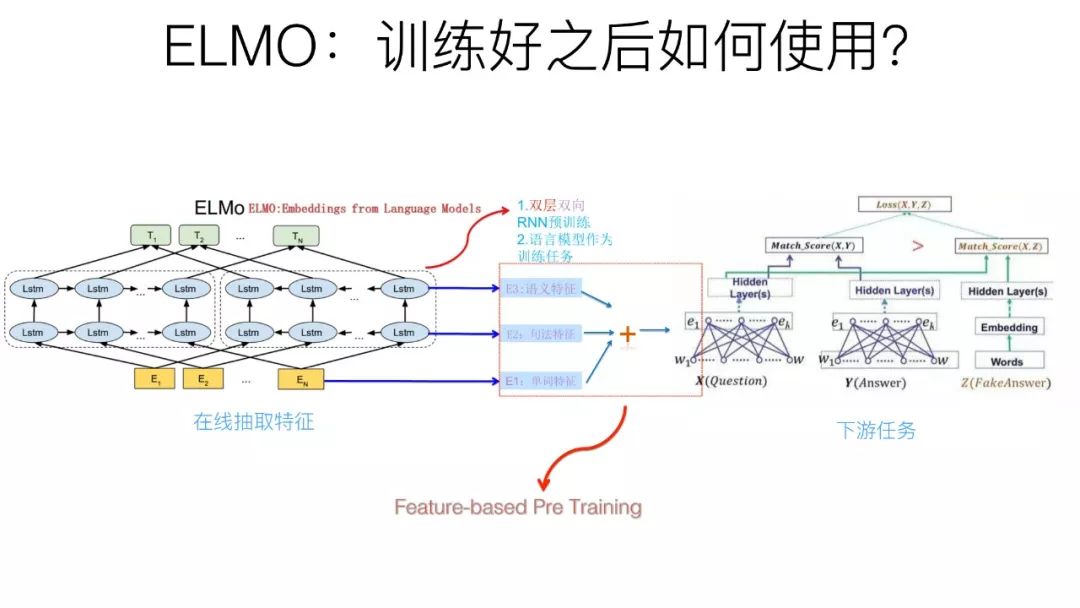

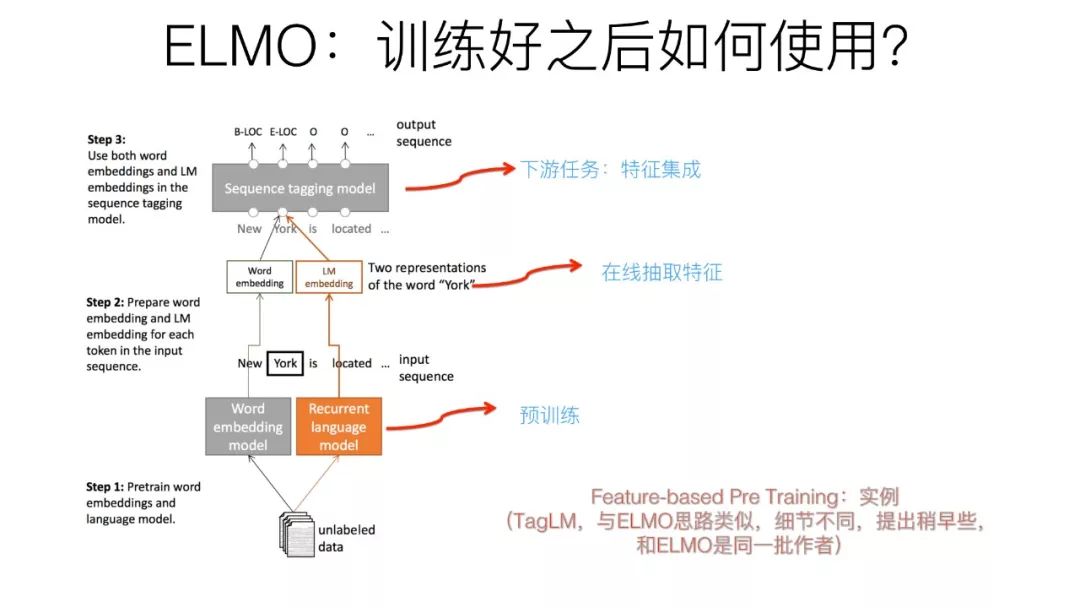

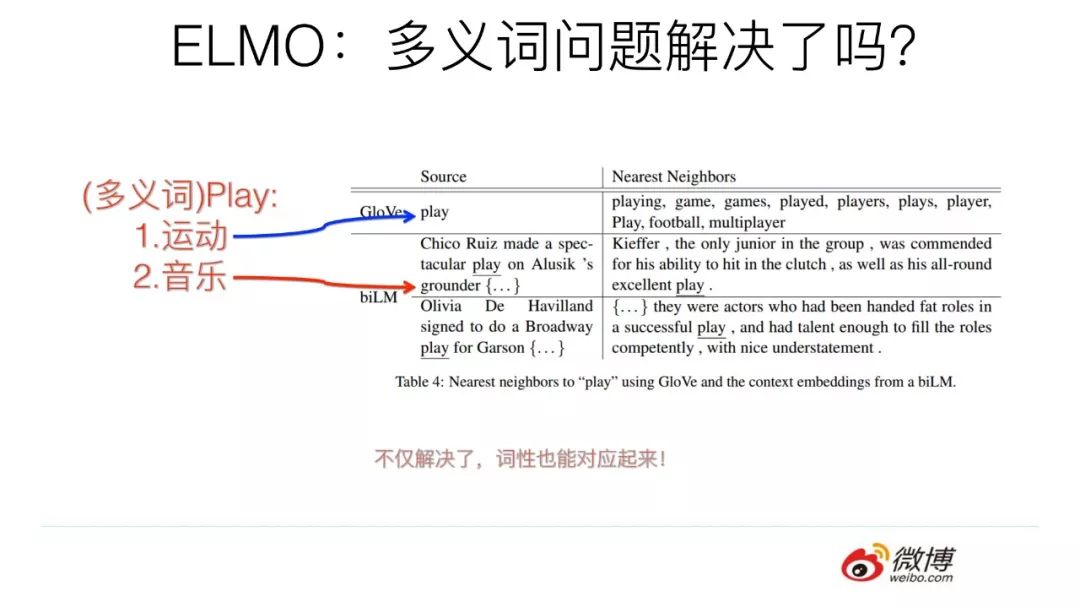

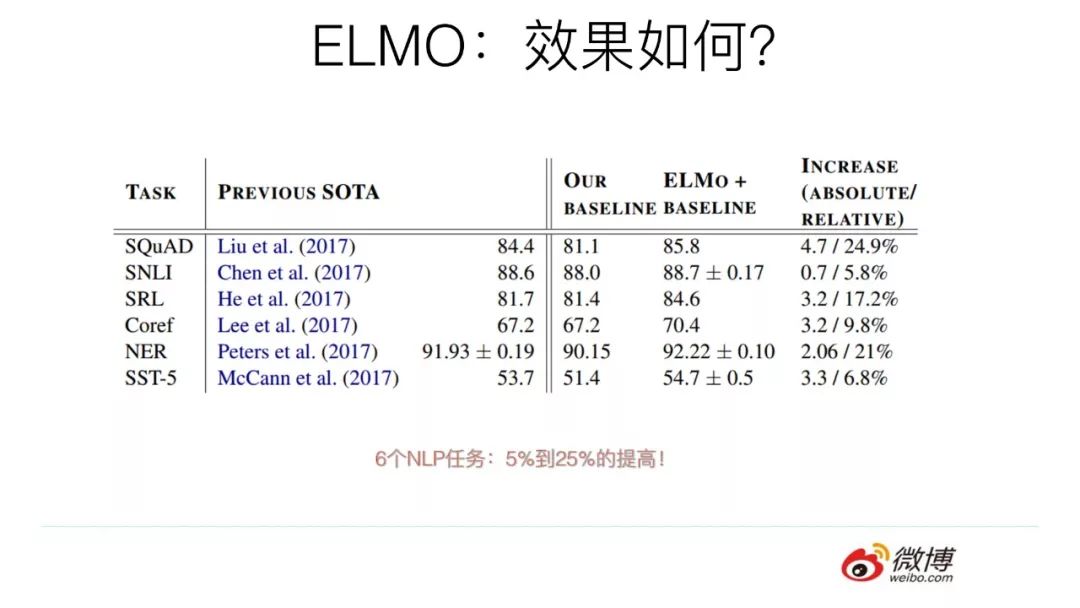

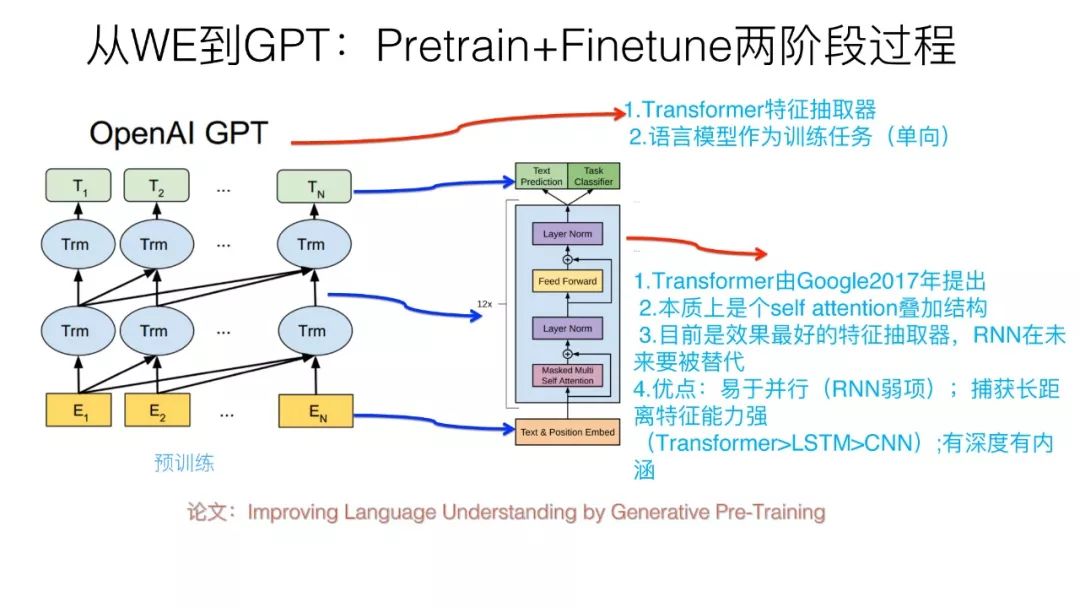

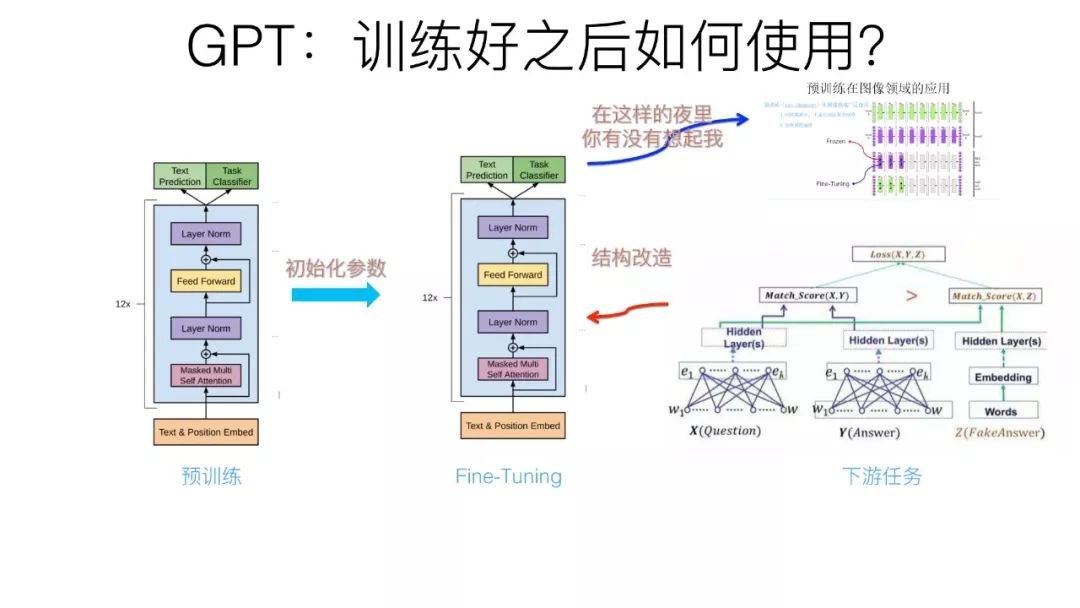

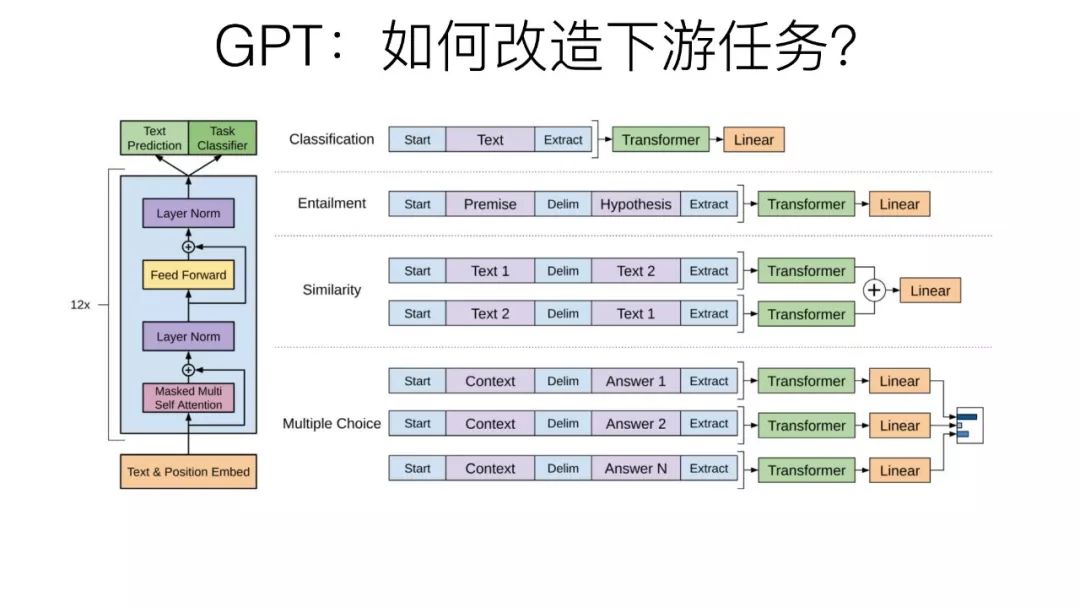

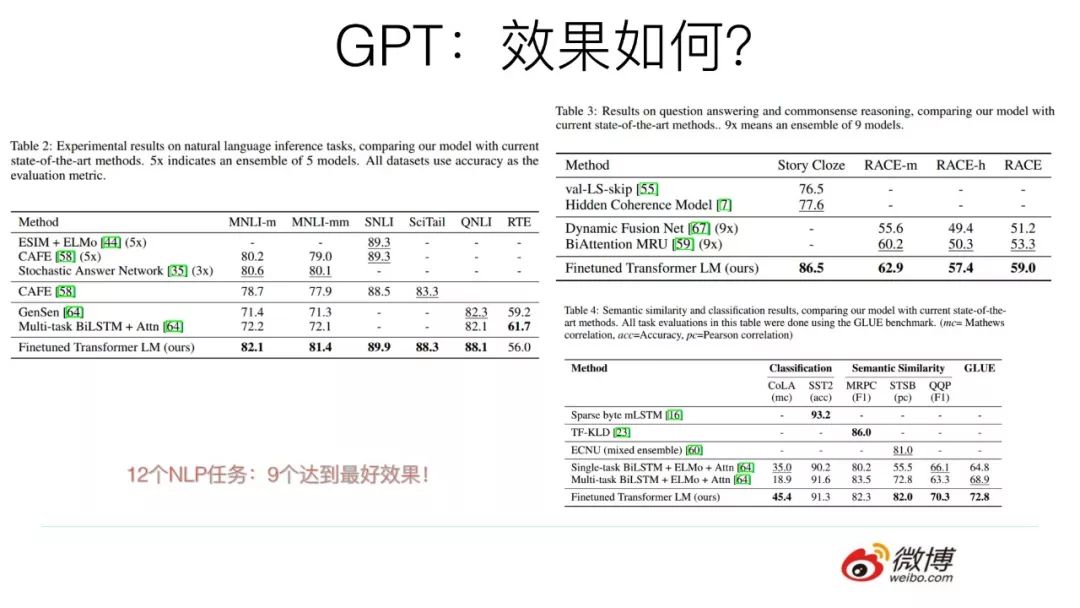

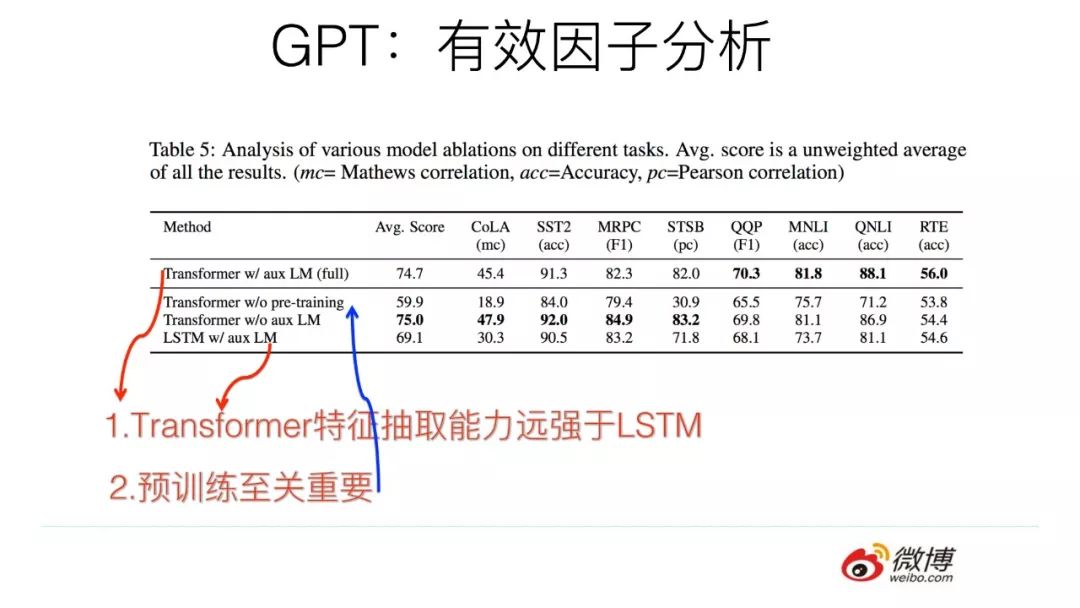

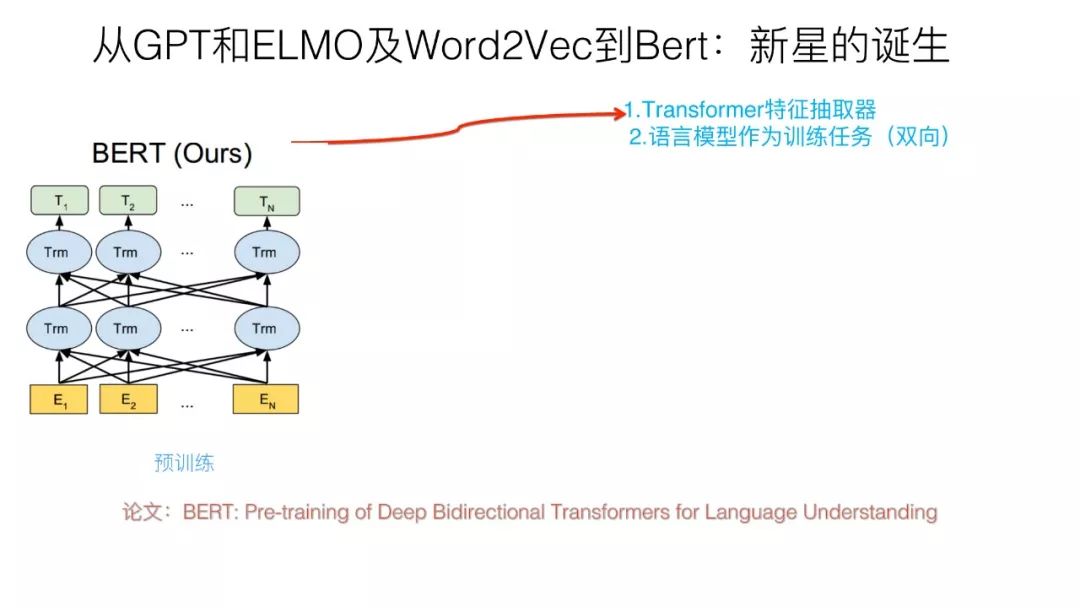

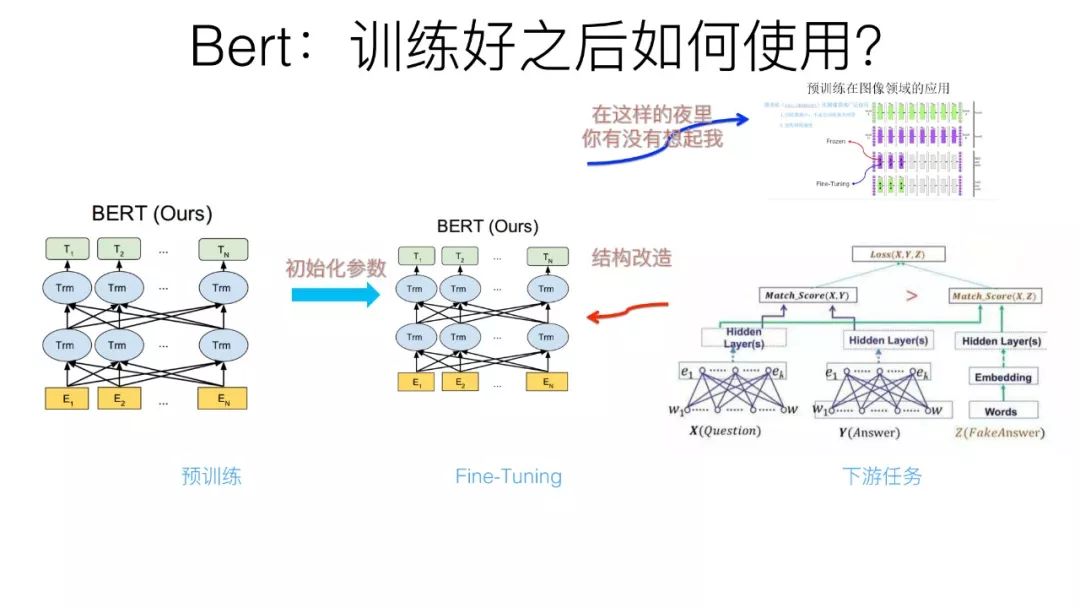

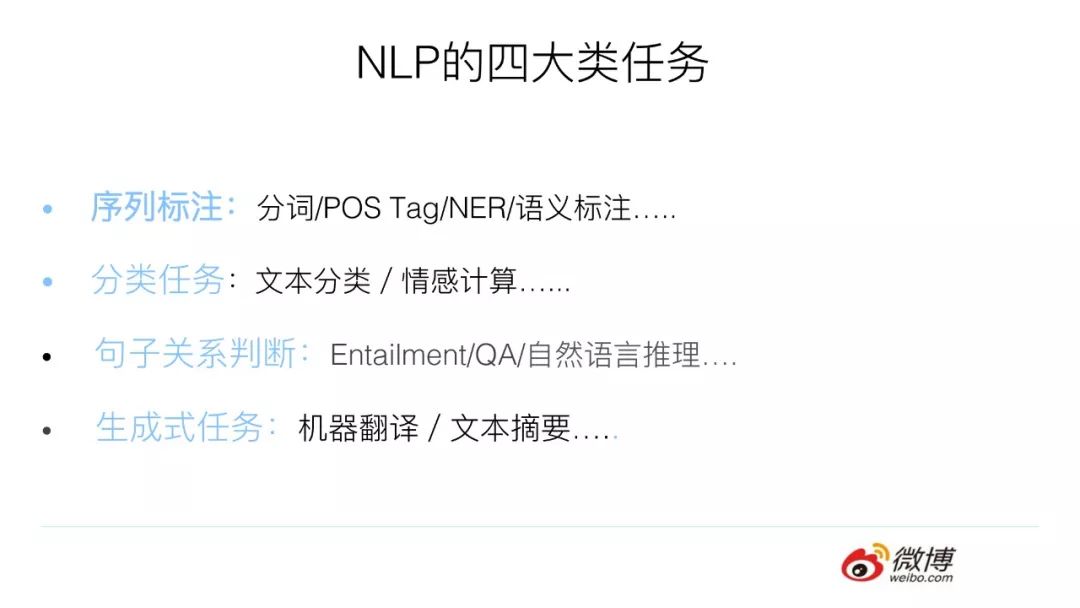

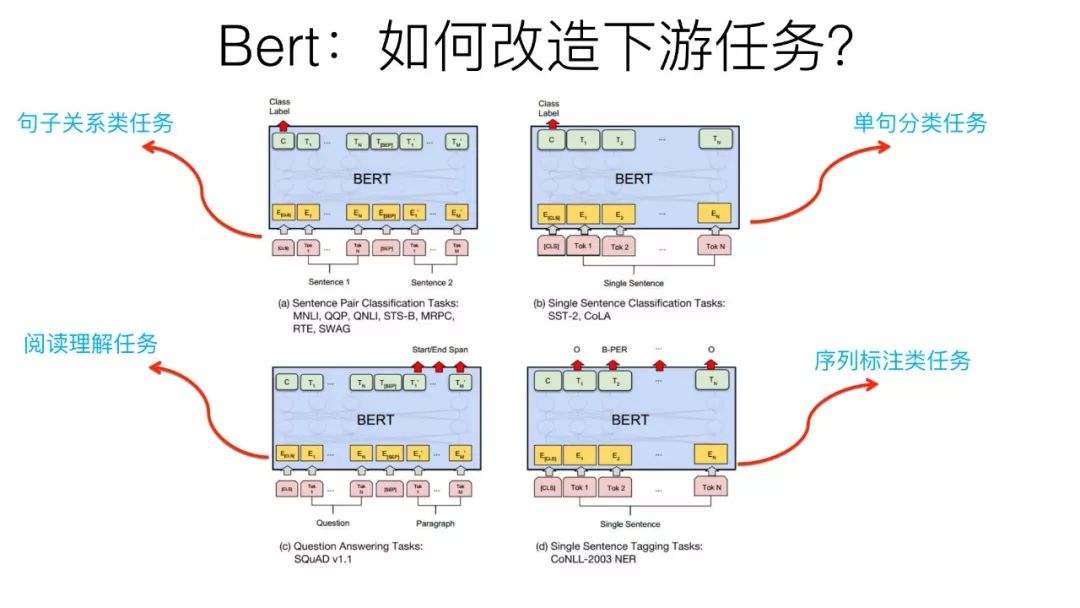

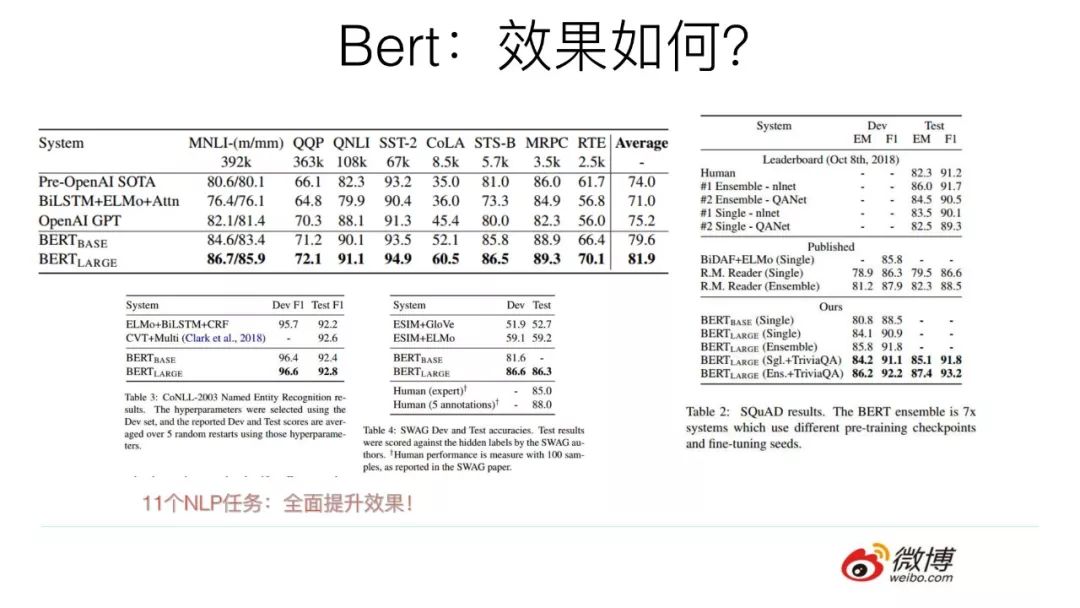

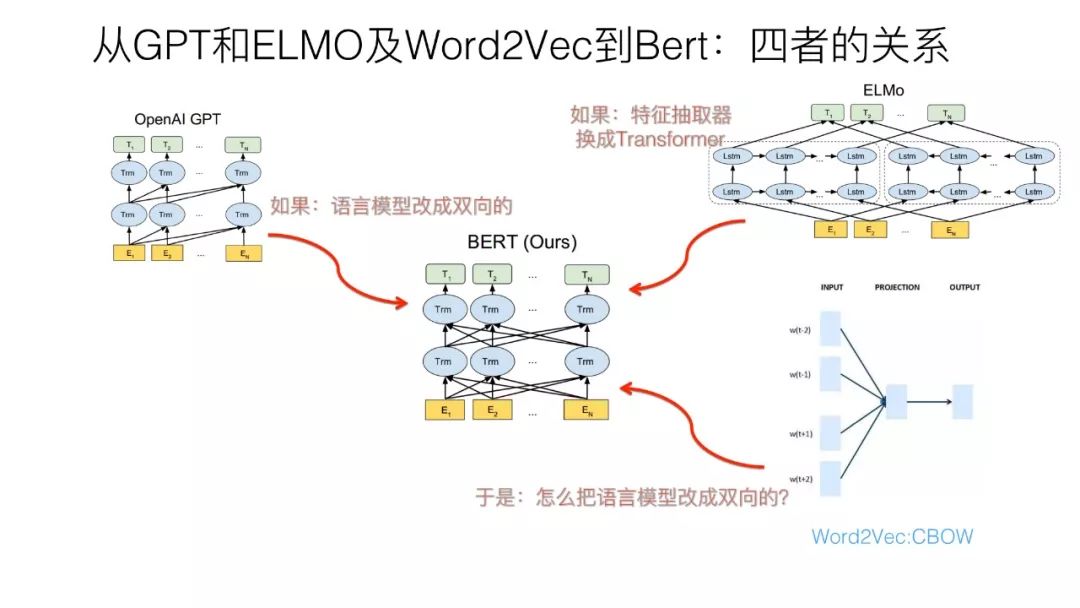

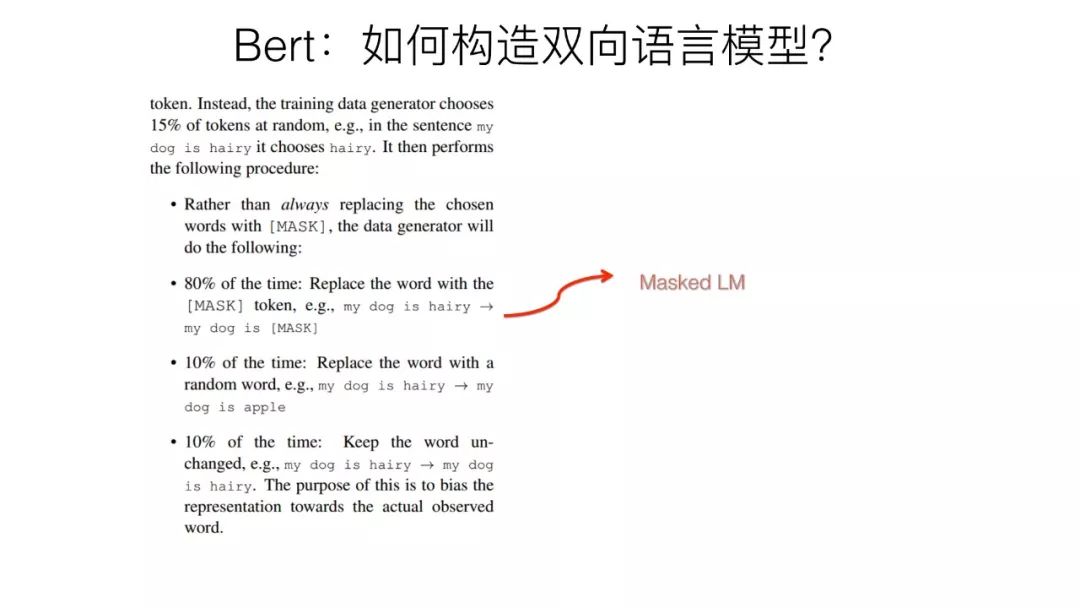

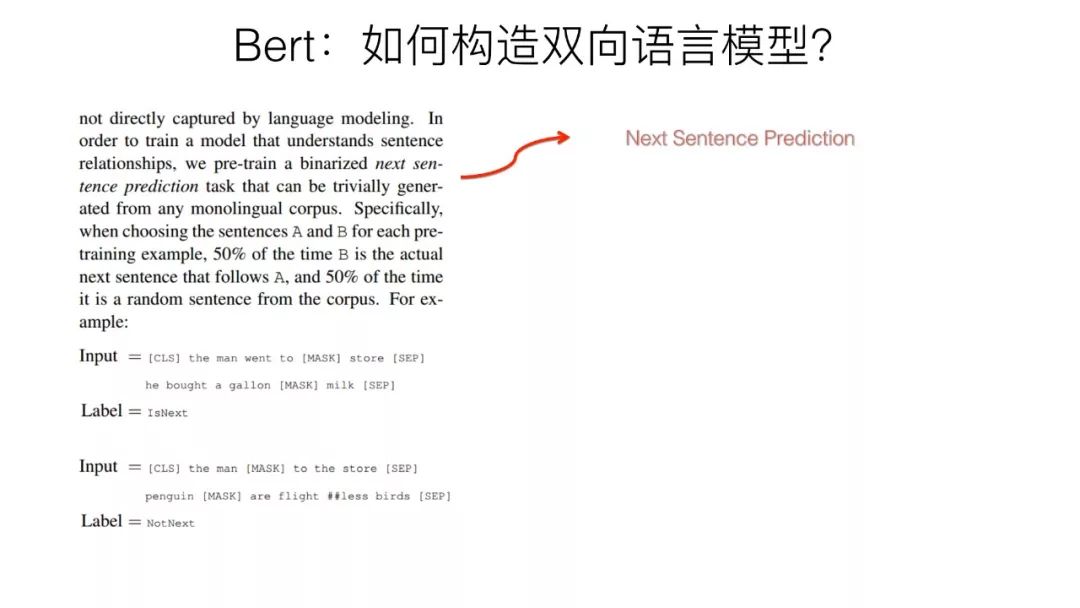

大家期待的PPT来啦![[中国赞] 预训练在自然语言处理的发展: 从Word Embedding到BERT模型](https://image.cha138.com/20210412/3320de6dbd2f4f6ba81bb7946ff18ad9.jpg) 《 预训练在自然语言处理的发展: 从Word Embedding到BERT模型 》。在这次分享中,@张俊林say 博士循序渐进,分别介绍了Word Embedding, Facebook的ELMO模型,OpenAI的GPT模型,和NLP领域最新的重大突破:刷新11项纪录的 Google的BERT模型。

《 预训练在自然语言处理的发展: 从Word Embedding到BERT模型 》。在这次分享中,@张俊林say 博士循序渐进,分别介绍了Word Embedding, Facebook的ELMO模型,OpenAI的GPT模型,和NLP领域最新的重大突破:刷新11项纪录的 Google的BERT模型。

整个PPT全是干货,感兴趣的同学点击链接即可下载。

百度网盘链接:https://pan.baidu.com/s/1o4SBdsx6dY4W4bnuBmU38Q 或 点击文末 “阅读原文”直达。

以上是关于预训练在自然语言处理的发展: 从Word Embedding到BERT模型的主要内容,如果未能解决你的问题,请参考以下文章

从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史