资源下载北大孙栩老师:自然语言处理中的注意力机制

Posted 机器学习算法与自然语言处理

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了资源下载北大孙栩老师:自然语言处理中的注意力机制相关的知识,希望对你有一定的参考价值。

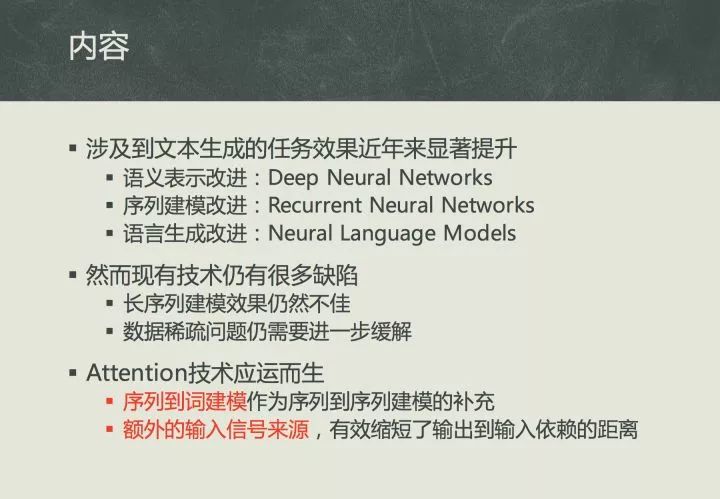

注意力机制即Attention mechanism在序列学习任务上具有巨大的提升作用,在编解码器框架内,通过在编码段加入Attention模型,对源数据序列进行数据加权变换,或者在解码端引入Attention模型,对目标数据进行加权变化,可以有效提高序列对序列的自然方式下的系统表现。

本文是北大孙栩老师做的自然语言处理中的注意力机制报告,部分slides:

slides下载

孙栩老师《自然语言处理的attention机制》已经打包好,获取步骤如下:

后台回复关键词:Attention1230

注:此次建议复制,不然容易打错

以上是关于资源下载北大孙栩老师:自然语言处理中的注意力机制的主要内容,如果未能解决你的问题,请参考以下文章