面向自然语言处理的深度学习对抗样本综述

Posted 专知

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了面向自然语言处理的深度学习对抗样本综述相关的知识,希望对你有一定的参考价值。

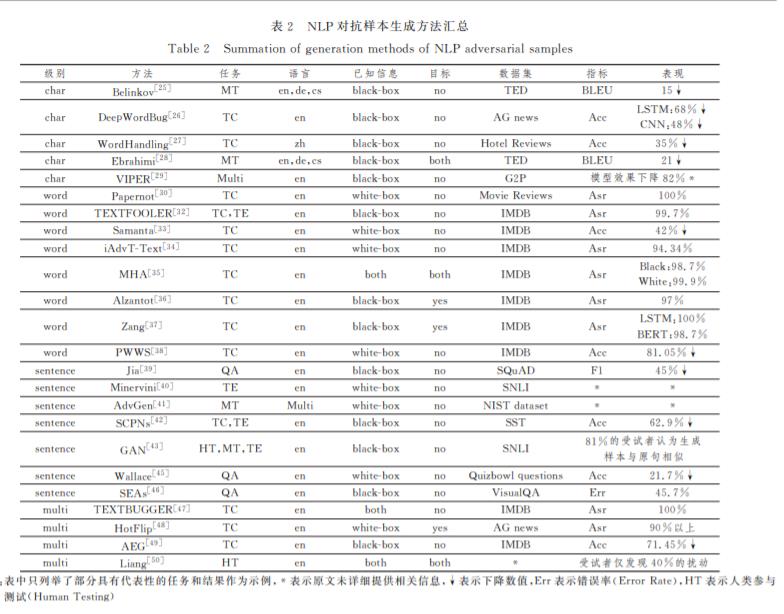

深度学习模型被证明存在脆弱性并容易遭到对抗样本的攻击,但目前对于对抗样本的研究主要集中在计算机视觉领域而忽略了自然语言处理模型的安全问题.针对自然语言处理领域同样面临对抗样本的风险,在阐明对抗样本相关概念的基础上,文中首先对基于深度学习的自然语言处理模型的复杂结构、难以探知的训练过程和朴素的基本原理等脆弱性成因进行分析,进一步阐述了文本对抗样本的特点、分类和评价指标,并对该领域对抗技术涉及到的典型任务和数据集进行了阐述;然后按照扰动级别对主流的字、词、句和多级扰动组合的文本对抗样本生成技术进行了梳理,并对相关防御方法进行了归纳总结;最后对目前自然语言处理对抗样本领域攻防双方存在的痛点问题进行了进一步的讨论和展望.

http://www.jsjkx.com/CN/10.11896/jsjkx.200500078

引言

自然语言处理(NaturalLanguageProcessing,NLP)技术 在深度学习的推动下正蓬勃发展,并在机器翻译、文本分类等 方面超越了基于统计机器学习的方法.一方面,LSTM [1]等 循环神经网络模型通过与 Word2vec [2],Glove [3]等词嵌入模 型相互配合,能够挖掘到文本时序层次的信息,避免了传统机 器学习模型的特征损失;另一方面,以 BERT [4],XLNet [5]为代表的预训练语言模型通过使用海量的数据集和无监督的训 练方法,具备深层网络结构且规模更大,进一步解决了一词多 义等难题,并在多个 NLP任务中拥有媲美人类的表现,成为 NLP领域中新的里程碑。

遗憾的是,神经网络算法自身固有的局部线性以及数据 的高维度等特点导致基于深度学习的 NLP模型的安全性受 限[6],容易受到对抗和欺骗.自 Szegedy等[7]首次发现对图 像添加微小扰动可误导神经网络做出错误分类后,大批研究者针对计算机视觉模型开展对抗样本及其防御方法的研究, 并提出了一系列经典的对抗样本生成方法[8].但是,目前针 对 NLP领域的对抗方法的探索却寥寥无几,Wang等[6]的统 计分析表明:2014年出现了对抗样本的研究,2016年出现第 一篇文本领域的对抗样本研究,到2019年对抗样本研究文献 总计696篇,文本领域研究21篇.无论从绝对数还是该领域 的增长率来看,文本对抗样本的研究尚处于萌芽阶段.

基于深度学习的 NLP技术已经在日常生产、生活的各个 方面得到越来越广泛的应用,其鲁棒性和安全性问题更不可 忽视.因此,为了使研究者能够全面了解文本对抗研究领域 的现状, 本文主要从对抗样本的概念、NLP模型脆弱性的成 因、文本对抗样本的评估指标、常用公开数据集、生成及防御 方法等方面进行综述,讨论了目前该领域面临的挑战,并对文 本对抗样本的未来发展进行了预测和展望.

专知便捷查看

后台回复“NLPAS” 可以获取《面向自然语言处理的深度学习对抗样本综述》专知下载链接索引

以上是关于面向自然语言处理的深度学习对抗样本综述的主要内容,如果未能解决你的问题,请参考以下文章