用于图像识别的深度残差学习!

Posted IT168文库

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了用于图像识别的深度残差学习!相关的知识,希望对你有一定的参考价值。

论文摘要:神经网络的训练因其层次加深而变得愈加困难。我们所提出的残差学习框架可以更轻松的对比前人所提深很多的网络进行训练。相对于之前网络所学习的是无参考的函数,我们显著改进的网络结构可根据网络的输入对其残差函数进行学习。我们提供的详实经验证据表明对这样的残差网络进行寻优更加容易,并且随网络层次的显著加深可以获得更好的准确率。我们利用ImageNet数据集验证了深达152层残差网络——尽管这个网络的深度是VGG网络[41]的8倍,然而复杂度却相对较低。该残差网络对ImageNet测试集的错误率为3.57%,这个结果取得了2015年ILSVRC分类任务的第一名。此外,我们分析了分别用100层和1000层网络对CIFAR-10数据集的处理。

今天的论文为卷积网络提供了一种新的体系结构。在我们开始之前,我会提醒你:这篇论文很古老。它发表于2015年底的深度学习的黑暗时代,它的原始格式还是纸莎草纸,还好,有人对它进行了扫描,以便后代可以读取它。它提出的架构已经被一次又一次地使用,包括我们以前读过的一些论文:Deep Networks with Stochastic Depth「具有随机深度的深度网络」。

(https://arxiv.org/abs/1603.09382)

首先要注意看似矛盾的情况:非常深的网络比中等深度的网络执行得更差,也就是说,虽然向网络添加图层通常可以提高性能,但在某些时候新图层会开始阻碍网络。他们将这种影响称为网络退化。

随着网络变得越来越深,像消失渐变这样的训练问题变得越来越糟糕,所以您会希望更多层在某个点之后使网络变得更糟。但作者预计这种推理和陈述,其他几种深度学习方法,如批量标准化,本质上已经解决了这些训练问题,随着深度的增加,网络仍然表现得越来越差。例如,他们比较20层和56层网络,发现56层网络的性能要差得多,这是在论文中看到的图片。

比较CIFAR-10上的20层和56层网络。请注意,56层网络在训练和测试中表现较差。

然后,作者们开展了一个思维实验(或者如果你是像我这样的恢复物理学家的实验室)来证明更深层次的网络应该始终表现更好。他们的论点如下:

从一个性能良好的网络开始;

添加被强制作为身份识别功能的附加图层,也就是说,他们只需传递无需更改的任何信息;

这个网络更深,但是由于新层不做任何事情,所以必须具有与原始网络相同的性能;

网络中的层可以学习标识功能,所以如果它是最优的,他们应该能够精确地复制这个深层网络的性能。

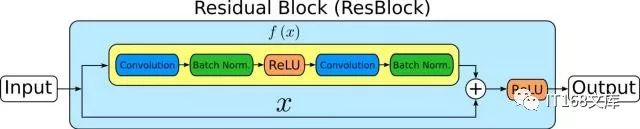

这个思想实验导致他们提出他们深度残差学习架构。他们构建了他们称之为剩余构建块的网络。下图显示了一个这样的块。这些块已被称为ResBlocks。

ResBlock,在顶部学习残差函数f(x),并且信息沿底部传递不变。这是由Huang等人的Stochastic Depth论文修改的图像。

ResBlock由与整流线性单元(ReLU)连接的正常网络层构成,并在下面通过来自前一层的信息不变地馈送。 ResBlock的网络部分可以包含任意数量的层,但最简单的是两层。

要深入了解ResBlock背后的数学知识:让我们假设一组图层在学习到特定函数h(x)时表现最好。作者注意到残差f(x)= h(x)?x可以被学习,并与原始输入结合起来,使得我们恢复h(x)如下:h(x)= f x)+ x。这可以通过向网络添加一个+ x组件来完成,回想我们的思想实验,这只是身份函数。作者希望将这种“传递”添加到他们的层面将有助于训练。与大多数深度学习一样,只有这种直觉支持该方法,而不是更深入的理解。然而,正如作者们所表明的那样,它是有效的,并且这是我们许多从业者关心的唯一事情。

论文还探讨了对ResBlock的一些修改。首先中间层使用较少的输入和输出来收集信息流。第二个是测试不同类型的传递连接,包括学习一个完整的投影矩阵。尽管更复杂的传递效果会更好,但它们会稍微花费一些时间,而且以训练时间为代价。

论文的其余部分将测试网络的性能。作者发现,他们的网络比没有传递的相同网络表现更好。他们还发现,他们可以训练更深层次的网络,并且仍然表现出更高的性能,最终训练了152层ResNet,其性能优于更浅的网络。他们甚至还训练了一个1202层的网络来证明它是可行的,但发现它的性能比本文所研究的其他网络差。

比较两个网络的性能:左侧的网络不使用ResBlocks,而右侧的网络则使用ResBlocks。请注意,34层网络的性能优于18层网络,但仅限于使用ResBlocks时。

他们还提出了一个由思想实验驱动的新架构,并希望它能比以前更好地工作。他们构建了几个网络,包括一些非常深的网络,并发现他们的新架构确实提高了网络的性能。虽然我们没有深入了解深度学习的基本原理,但我们确实得到了一种使我们的网络更好地发挥作用的新方法,并且最终可能已经足够好了。

Alexander Gude目前是Lab41的一名数据科学家,负责调查推荐系统算法。他拥有加州大学伯克利分校的物理学学士学位以及明尼苏达大学双城分校的基础粒子物理学博士学位。

Lab41是一个“挑战实验室”,美国情报界与学术界、工业界和In-Q-Tel的同行一起处理大数据。它使来自不同背景的参与者能够获得想法、才能和技术,以探索数据分析中什么可行,什么不可行。 Lab41是一个开放式的协作环境,培养参与者之间的宝贵关系。

投稿邮箱:qinli@it168.com

合作微信:zhaoyuyingycq

IT168文库APP

最专业的IT技术交流分享平台!扫码安装,与众多技术同好交流!

IT168文库|中国最专业的IT文档分享平台,拥有百万活跃的IT技术精英!我们致力于有效帮助IT人士提升职业素养。

以上是关于用于图像识别的深度残差学习!的主要内容,如果未能解决你的问题,请参考以下文章