python图像识别---------图片相似度计算

Posted Python爬虫scrapy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了python图像识别---------图片相似度计算相关的知识,希望对你有一定的参考价值。

1.背景

要识别两张图片是否相似,首先我们可能会区分这两张图是人物照,还是风景照等......对应的风景照是蓝天还是大海......做一系列的分类。

从机器学习的的角度来说,首先要提取图片的特征,将这些特征进行分类处理,训练并建立模型,然后在进行识别。

但是让计算机去区分这些图片分别是哪一类是很不容易的,不过计算机可以知道图像的像素值的,因此,在图像识别过程中,通过颜色特征来识别是相似图片是我们常用的(当然还有其特征还有纹理特征、形状特征和空间关系特征等,这些有分为直方图,颜色集,颜色局,聚合向量,相关图等来计算颜色特征),

为了得到两张相似的图片,在这里通过以下几种简单的计算方式来计算图片的相似度:

直方图计算图片的相似度

通过哈希值,汉明距离计算

通过图片的余弦距离计算

通过图片结构度量计算

一、直方图计算图片的相似度

上三张图片,分别是img1.png, img2.jpg,img.png:

可以看出上面这三张图是挺相似的,在颜色上是差不多的,最相似的是哪两张大家可以猜猜看,看和我们计算的是否一样。

在python中利用opencv中的calcHist()方法获取其直方图数据,返回的结果是一个列表:

# 计算图img1的直方图H1 = cv2.calcHist([img1], [1], None, [256], [0, 256])H1 = cv2.normalize(H1, H1, 0, 1, cv2.NORM_MINMAX, -1) # 对图片进行归一化处理

先计算img1的直方图,在对其归一化,最后在分别对img2,img3计算,做归一化,然后在利用python自带的compareHist()进行相似度的比较:

利用compareHist()进行比较相似度similarity1 = cv2.compareHist(H1, H2, 0)

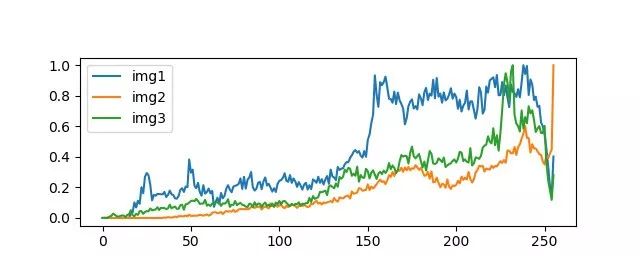

最后得到三张图片的直方图如下:

图像的x轴是指的图片的0~255之间的像素变化,y轴指的是在这0~255像素所占的比列。

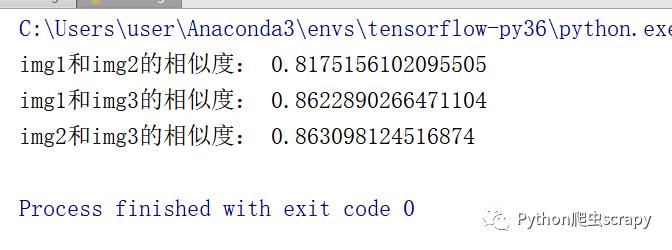

我们可以明显的看出img2与img3的直方图的变化趋势是相符的有重合态的,运行结果如下:

通过运行结果知道img2和img3是值是最为相似的(代码calcImage.py)

上面的是直接调用opencv中的方法来实现的,下面还有自己写的方法:

首先是将图片转化为RGB格式,在这里是用的pillow中的Image来对图片做处理的:

# 将图片转化为RGBdef make_regalur_image(img, size=(64, 64)):gray_image = img.resize(size).convert('RGB')return gray_image

在计算两图片的直方图:

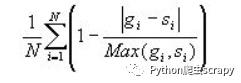

# 计算直方图def hist_similar(lh, rh):assert len(lh) == len(rh)hist = sum(1 - (0 if l == r else float(abs(l - r)) / max(l, r)) for l, r in zip(lh, rh)) / len(lh)return hist

在计算其相似度:

# 计算相似度def calc_similar(li, ri):calc_sim = hist_similar(li.histogram(), ri.histogram())return calc_sim

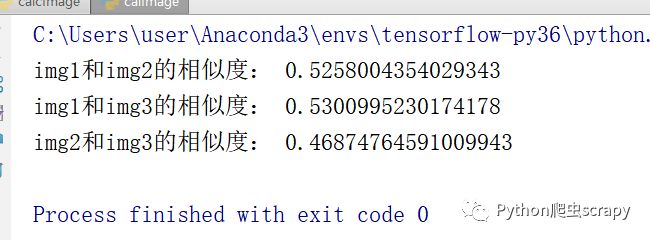

得到最终的运行结果:

两种方法的的结果还是有点差距的,可以看到img1和img3的结果相似度高些。

不过两者的相似度计算方法如下:

gi和si分别指的是两条曲线的第i个点。

总结:

利用直方图计算图片的相似度时,是按照颜色的全局分布情况来看待的,无法对局部的色彩进行分析,同一张图片如果转化成为灰度图时,在计算其直方图时差距就更大了。

为了解决这个问题,可以将图片进行等分,然后在计算图片的相似度。不过在这里我就不叙述了,大家自行探讨!!!

二、哈希算法计算图片的相似度

在计算之前我们先了解一下图像指纹和汉明距离:

图像指纹:

图像指纹和人的指纹一样,是身份的象征,而图像指纹简单点来讲,就是将图像按照一定的哈希算法,经过运算后得出的一组二进制数字。

汉明距离:

假如一组二进制数据为101,另外一组为111,那么显然把第一组的第二位数据0改成1就可以变成第二组数据111,所以两组数据的汉明距离就为1。简单点说,汉明距离就是一组二进制数据变成另一组数据所需的步骤数,显然,这个数值可以衡量两张图片的差异,汉明距离越小,则代表相似度越高。汉明距离为0,即代表两张图片完全一样。

感知哈希算法是一类算法的总称,包括aHash、pHash、dHash。顾名思义,感知哈希不是以严格的方式计算Hash值,而是以更加相对的方式计算哈希值,因为“相似”与否,就是一种相对的判定。

几种hash值的比较:

aHash:平均值哈希。速度比较快,但是常常不太精确。

pHash:感知哈希。精确度比较高,但是速度方面较差一些。

dHash:差异值哈希。精确度较高,且速度也非常快

1. 平均哈希算法(aHash):

该算法是基于比较灰度图每个像素与平均值来实现。

aHash的hanming距离步骤:

先将图片压缩成8*8的小图

将图片转化为灰度图

计算图片的Hash值,这里的hash值是64位,或者是32位01字符串

将上面的hash值转换为16位的

通过hash值来计算汉明距离

def ahash(image):# 将图片缩放为8*8的image = cv2.resize(image, (8, 8), interpolation=cv2.INTER_CUBIC)gray = cv2.cvtColor(image, cv2.COLOR_RGB2GRAY)s = 0for i in range(8):for j in range(8):s = s + gray[i, j]avg = s / 64ahash_str = ''for i in range(8):for j in range(8):if gray[i, j] > avg:ahash_str = ahash_str + '1'else:ahash_str = ahash_str + '0'result = ''for i in range(0, 64, 4):result += ''.join('%x' % int(ahash_str[i: i + 4], 2))return result

2.感知哈希算法(pHash):

均值哈希虽然简单,但是受均值影响大。如果对图像进行伽马校正或者进行直方图均值化都会影响均值,从而影响哈希值的计算。所以就有人提出更健壮的方法,通过离散余弦(DCT)进行低频提取。

离散余弦变换(DCT)是种图像压缩算法,它将图像从像素域变换到频率域。然后一般图像都存在很多冗余和相关性的,所以转换到频率域之后,只有很少的一部分频率分量的系数才不为0,大部分系数都为0(或者说接近于0)。

pHash的计算步骤:

缩小图片:32 * 32是一个较好的大小,这样方便DCT计算转化为灰度图

计算DCT:利用Opencv中提供的dct()方法,注意输入的图像必须是32位浮点型,所以先利用numpy中的float32进行转换

缩小DCT:DCT计算后的矩阵是32 * 32,保留左上角的8 * 8,这些代表的图片的最低频率

计算平均值:计算缩小DCT后的所有像素点的平均值。

进一步减小DCT:大于平均值记录为1,反之记录为0.

得到信息指纹:组合64个信息位,顺序随意保持一致性。

最后比对两张图片的指纹,获得汉明距离即可。

# phashdef phash(path):# 加载并调整图片为32*32的灰度图片img = cv2.imread(path)img1 = cv2.resize(img, (32, 32),cv2.COLOR_RGB2GRAY)# 创建二维列表h, w = img.shape[:2]vis0 = np.zeros((h, w), np.float32)vis0[:h, :w] = img1# DCT二维变换# 离散余弦变换,得到dct系数矩阵img_dct = cv2.dct(cv2.dct(vis0))img_dct.resize(8,8)# 把list变成一维listimg_list = np.array().flatten(img_dct.tolist())# 计算均值img_mean = cv2.mean(img_list)avg_list = ['0' if i<img_mean else '1' for i in img_list]return ''.join(['%x' % int(''.join(avg_list[x:x+4]),2) for x in range(0,64,4)])

3. 差异值哈希算法(dHash):

相比pHash,dHash的速度要快的多,相比aHash,dHash在效率几乎相同的情况下的效果要更好,它是基于渐变实现的。

dHash的hanming距离步骤:

先将图片压缩成9*8的小图,有72个像素点

将图片转化为灰度图

计算差异值:dHash算法工作在相邻像素之间,这样每行9个像素之间产生了8个不同的差异,一共8行,则产生了64个差异值,或者是32位01字符串。

获得指纹:如果左边的像素比右边的更亮,则记录为1,否则为0.

通过hash值来计算汉明距离

def dhash(image):# 将图片转化为8*8image = cv2.resize(image, (9, 8), interpolation=cv2.INTER_CUBIC)gray = cv2.cvtColor(image, cv2.COLOR_RGB2GRAY)dhash_str = ''for i in range(8):for j in range(8):if gray[i, j] > gray[i, j + 1]:dhash_str = dhash_str + '1'else:dhash_str = dhash_str + '0'result = ''for i in range(0, 64, 4):result += ''.join('%x' % int(dhash_str[i: i + 4], 2))return result

4. 计算哈希值差异

def campHash(hash1, hash2):n = 0if len(hash1) != len(hash2):return -1for i in range(len(hash1)):if hash1[i] != hash2[i]:n = n + 1return n

最终的运行结果:

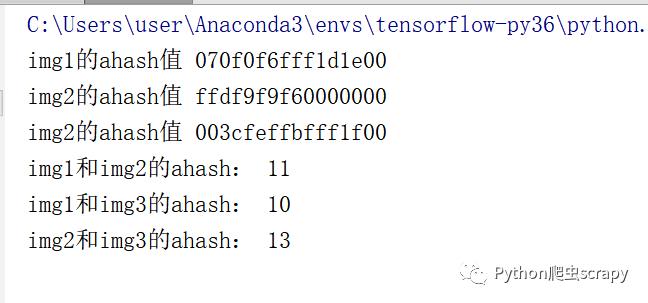

aHash:

dhash:

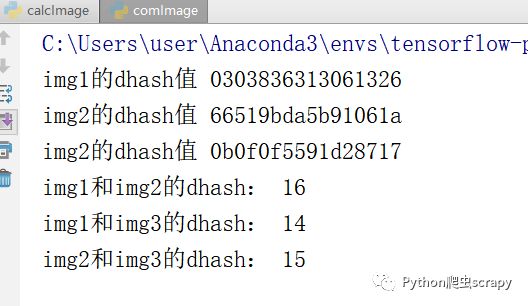

p_hsah:

通过上面运行的结果可以看出来,img1和img3的相似度高一些。

三、余弦相似度(cosin)

把图片表示成一个向量,通过计算向量之间的余弦距离来表征两张图片的相似度。

1. 对图片进行归一化处理

# 对图片进行统一化处理def get_thum(image, size=(64, 64), greyscale=False):# 利用image对图像大小重新设置, Image.ANTIALIAS为高质量的image = image.resize(size, Image.ANTIALIAS)if greyscale:# 将图片转换为L模式,其为灰度图,其每个像素用8个bit表示image = image.convert('L')return image

2. 计算余弦距离

# 计算图片的余弦距离def image_similarity_vectors_via_numpy(image1, image2):image1 = get_thum(image1)image2 = get_thum(image2)images = [image1, image2]vectors = []norms = []for image in images:vector = []for pixel_tuple in image.getdata():vector.append(average(pixel_tuple))vectors.append(vector)# linalg=linear(线性)+algebra(代数),norm则表示范数# 求图片的范数??2))b = vectorsb_norm = norms# dot返回的是点积,对二维数组(矩阵)进行计算res = dot(a / a_norm, b / b_norm)return res

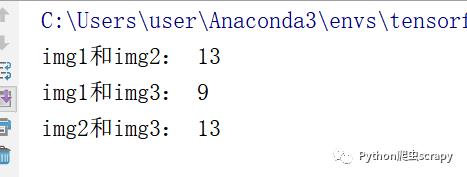

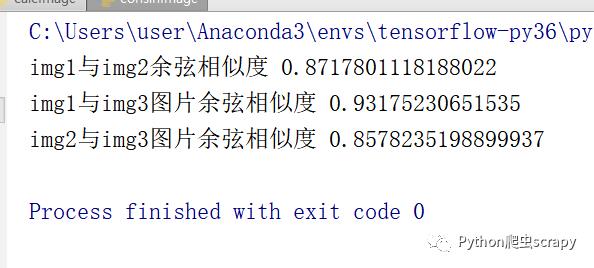

最终运行结果:

结果显示img1和img3的相似度高一些,和计算hash值的汉明距离得到的结果是相一致的。

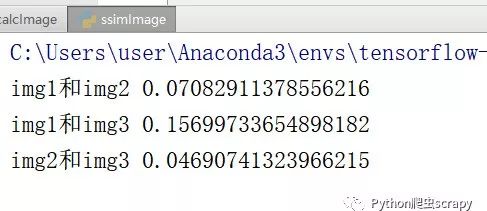

四、图片SSIM(结构相似度量)

SSIM是一种全参考的图像质量评价指标,分别从亮度、对比度、结构三个方面度量图像相似性。SSIM取值范围[0, 1],值越大,表示图像失真越小。在实际应用中,可以利用滑动窗将图像分块,令分块总数为N,考虑到窗口形状对分块的影响,采用高斯加权计算每一窗口的均值、方差以及协方差,然后计算对应块的结构相似度SSIM,最后将平均值作为两图像的结构相似性度量,即平均结构相似性SSIM。

ssim1 = compare_ssim(img1, img2, multichannel=True)这个是scikit-image库自带的一种计算方法

运行结果:

可以看到img1和img3的相似度高。

好了,以上就是到目前为止我接触到的图片相似度的计算方法,肯定还有许多我没有接触到的计算方法,大家有需要的可以参考一下,有其他方法的大家可以留言一起探讨!!!

注意:微信扫一扫下方二维码,后台回复“图片相似度”即可获取代码^_^

整理不易,希望大家可以多多点击在看哦~谢谢大家了!!!

以上是关于python图像识别---------图片相似度计算的主要内容,如果未能解决你的问题,请参考以下文章