打破常规!巧用对抗性样本改进图像识别性能

Posted 图灵TOPIA

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了打破常规!巧用对抗性样本改进图像识别性能相关的知识,希望对你有一定的参考价值。

图灵TOPIA

编译:安然

图灵联邦编辑部出品

近日,谷歌大脑的创始成员和 AutoML 的缔造者之一Quoc Le再推新研究论文,在题为“对抗性样本改善图像识别”一文中提出一种增强的对抗训练将对抗性样本AdvProp。

他认为AdvProp是一种使用对抗性样本来减少过度拟合的奇特技巧,其关键在于使用Two BatchNorms ,一个用于普通样本,一个用于对抗性样本。

使用AdvProp样本作为其他样本,以防止过度拟合。当模型更大时,该研究证明AdvProp改进了各种模型,在各种图像识别任务上表现更好。

对抗性样本通常被认为是对ConvNets的威胁。在这里,研究者提出了一个相反的观点:如果使用正确的方法,对抗性样本可以用来改进图像识别模型。

AdvProp是一个增强的对抗训练方案,将对抗性样本子作为附加的样本来处理,以防止过度拟合。

方法的关键是使用独立的辅助批处理规范来处理对抗性样本,因为它们与普通样本具有不同的底层分布。

实验结果表明,AdvProp模型在不同的图像识别任务上有较大的改进,且模型越大,识别效果越好。

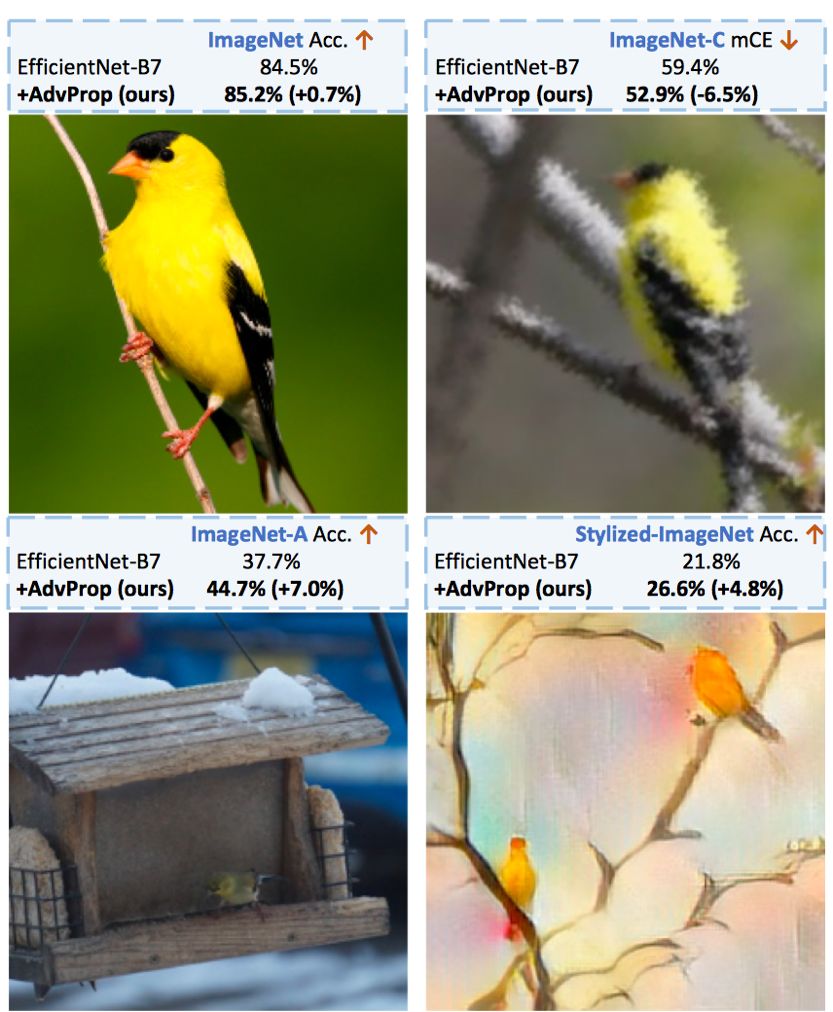

例如,通过应用AdvProp使用ImageNet上的最新EfficientNet-B7,实现ImageNet的显着改善(+ 0.7%),ImageNet-C(+6.5%),ImageNet-A(+7.0%),StylizedImageNet(+ 4.8%)。

AdvProp模型通过对抗性样本获得ImageNet top-1精度85.5%(无额外数据)。这一结果甚至超过了《Exploring the limits of weakly supervised pretraining. In ECCV, 2018》中使用3.5B Instagram图像(比ImageNet多约3000倍)和多约9.4倍参数训练的最佳模型。

GutHub:

https://github.com/tensorflow/tpu/tree/master/models/official/efficiencynet

通过在图像上添加不可察觉的扰动而产生的对抗性样本可能导致卷积神经网络(ConvNets)做出错误的预测。

对抗性样本的存在不仅揭示了ConvNets的泛化能力有限,而且还对这些模型的实际部署构成了安全威胁。自从首次发现ConvNets遭受广告攻击的以来,已经做了许多努力来提高网络的稳健性。

在这篇文章中,研究者并没有把重点放在对抗性样本上,而是将注意力转移到利用对抗性样本来提高准确性。

以前的研究表明,使用反例训练可以提高模型的泛化能力,但仅限于某些特定的情况——只有在全监督设置下的小数据集(如MNIST)或在半监督设置下的大数据集上才能观察到这种改善。

与此同时,最近的研究也表明,在大型数据集(如ImageNet)上使用反例进行训练,在监督学习的情况下,会导致普通样本的性能下降。总之,如何有效地使用对抗性样本来帮助视觉模型仍然是一个有待解决的问题。

图1. AdvProp改善了图像识别。AdvProp通过在ImageNet上训练模型,帮助EfficientNet-B7在ImageNet 上达到85.2%的精度,在ImageNet-C上达到52.9%的mCE(均值误差,越低越好),在ImageNet-C上达到44.7%的精度。

研究者观察到,以前的方法都可以共同训练清晰的图像和对抗性样本,假设在以前的工作中,普通样本和对抗性样本之间的分布不匹配是导致性能下降的一个关键因素。

Two BatchNorms 可以在归一化层上正确分解这两个分布,以便进行准确的统计估计。这种分布分解是至关重要的,它使研究者能够通过对抗性样本成功地改进而不是降低模型性能。

研究者的工作第一次表明了,在大规模数据集的全监督设置下,对抗性样本可以提高模型的性能。

例如,使用AdvProp训练的EfficientNet-B7在ImageNet上的准确率达到了85.2% (top-1),超过了vanilla的0.8%。在对模型进行畸变图像测试时,AdvProp的改善效果更为显著。

如图1所示,AdvProp帮助EfficientNet-B7对ImageNet-C、ImageNet-A、Stylized-ImageNet分别获得9.0%、7.0%、5.0%的绝对提升。

由于AdvProp有效地防止了较大网络的过拟合和更好执行,研究者开发了一个更大的网络,命名为EfficientNet-B8,它遵循了类似于《Mingxing Tan and Quoc Le. Efficientnet: Rethinking model scaling for convolutional neural networks. In ICML, 2019》中的复合缩放规则。

通过研究者提出的建议,在没有任何额外数据的情况下,EfficientNet-B8在ImageNet上实现了最先进的85.5%的top-1精度。

该结果甚至超过了《Exploring the limits of weakly supervised pretraining. In ECCV, 2018.》中报告的最佳模型,该模型在3.5B额外的Instagram图像上进行了预训练(比ImageNet多3000倍),需要比EfficientNet-B8多9.4倍的参数。

论文链接:

https://arxiv.org/pdf/1911.09665.pdf

视频点击预测大赛火热进行中

3万元奖金、证书、实习、就业机会已准备就位,快叫上小伙伴一起来组队参赛吧。

赛题:希望参赛者通过已有的用户信息、视频信息以及他们是否观看过某些视频,来预测我们推荐给这些用户的视频对方是否会观看。

个人、高等院校、科研单位、互联网企业、创业团队、学生社团等人员均可报名。

报名及组队时间:即日起至2020年2月1日

报名入口:

以上是关于打破常规!巧用对抗性样本改进图像识别性能的主要内容,如果未能解决你的问题,请参考以下文章