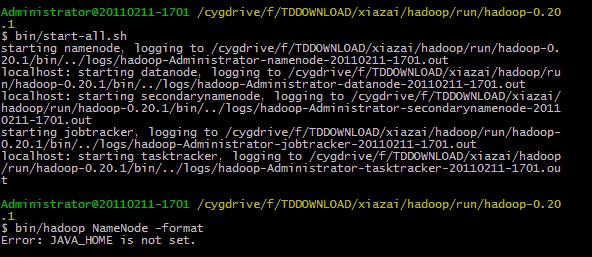

windows下安装hadoop总是出错 JAVA_HOME is not set.

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了windows下安装hadoop总是出错 JAVA_HOME is not set.相关的知识,希望对你有一定的参考价值。

上面hadoop算是成功启动了吗?下面那个JAVA_HOME is not set又该如何让解决呢?求人来帮帮我这只菜鸟啊~~~~

我的hadoop-env.sh里有写export JAVA_HOME=/usr/lib/jdk1.7.0_45了,然后环境变量里JAVA_HOME的路径也直线了jdk的bin目录和jre,为什么还是说JAVA_HOME is not set?

追答/usr/lib/jdk1.7.0_45 你的JDK是安装在windows下的 这个路径明显就不对呀

参考技术A 设置一个JAVA_HOME环境变量,如 export JAVA_HOME=/pathexport PATH=$PATH:$JAVA_HOME/bin追问

我的hadoop-env.sh里有写export JAVA_HOME=/usr/lib/jdk1.7.0_45了,然后环境变量里JAVA_HOME的路径也直线了jdk的bin目录和jre,为什么还是说JAVA_HOME is not set?

追答系统环境变量,就是在 ~/.bash_profile 这个隐藏文件中设置,之后再 source ~/.bash_profile 就行了

追问可以私信教下我吗?

追答可以的,QQ:371720876

参考技术B 你在hadoop里面配置java环境变量没有?追问我的hadoop-env.sh里有写export JAVA_HOME=/usr/lib/jdk1.7.0_45了,然后环境变量里JAVA_HOME的路径也直线了jdk的bin目录和jre,为什么还是说JAVA_HOME is not set?

追答我是在linux下面配置的,要简单得多,你在命令行里面试试能不能查到java版本,具体命令你百度下,然后最好装1.6的java环境,好像不支持1.7的

Windows下搭建Spark+Hadoop开发环境

只需要确保您的电脑已装好Java环境,那么就可以开始了。

一. 准备工作

1. 下载Hadoop2.7.1版本(写Spark和Hadoop主要是用到了Yarn,因此Hadoop必须安装)

下载地址:http://apache.fayea.com/hadoop/common/hadoop-2.7.1/

下载其中的hadoop-2.7.1.tar.gz并解压到一个固定目录作为Hadoop安装目录。

2. 下载支持插件

下载地址:https://github.com/ShixiangWan/winutils,其中有很多个Hadoop版本,这里我们以其中的Hadoop2.7.1稳定版为例。

下载后将Hadoop2.7.1的bin中的文件覆盖拷贝至上述的安装目录的bin下。

3. 覆盖hadoop.dll

将插件bin目录下的hadoop.dll复制到C:\Window\System32下。

二. 环境变量配置

1. 增加环境变量HADOOP_HOME,指向Hadoop安装根目录;

2. 在Path变量中添加%HADOOP_HOME%\bin;

3. 重启Eclipse或Intellij,直接运行Spark或Hadoop的Maven项目即可。

参考资料:

http://blog.csdn.net/shenshendeai/article/details/57962167

以上是关于windows下安装hadoop总是出错 JAVA_HOME is not set.的主要内容,如果未能解决你的问题,请参考以下文章

redis在windows下总是报错,就是下面的错误,这是哪里出错了

在运行JAVA程序时出错,大家帮看一下是怎么回事,最好懂hadoop编程~~

在Windows下MyEclipse运行JAVA程序连接HBASE读取数据出错